Современные решения, построенные на микросервисной архитектуре, напоминают сложный организм: сотни взаимосвязанных компонентов, распределенные базы данных, облачные сервисы. Без продуманного наблюдения даже мелкая ошибка в одном узле может спровоцировать цепную реакцию — например, падение конверсии из-за «зависшего» платежного шлюза или потерю данных из-за перегруженной очереди сообщений.

Грамотная стратегия мониторинга решает три ключевые проблемы:

-

Сбои: предсказывает и локализует инциденты до того, как они ударят по бизнесу.

-

Ошибки: выявляет аномалии в логике работы сервисов — от некорректных ответов API до утечек памяти.

-

Простои: снижает downtime за счет автоматизации реакций (например, перезапуск подов в Kubernetes при превышении лимитов CPU).

Мы внедряем DevOps-практики так, чтобы ваша инфраструктура не просто «работала», а давала вам конкурентное преимущество. И делаем это без лишнего шума: наши решения интегрируются в ваши процессы, а не ломают их.

Почему мониторинг инфраструктуры не справляется с микросервисами и облаками?

Современные системы — это уже не монолиты, а сложные экосистемы из микросервисов, облачных сервисов и распределенных баз данных. Классический мониторинг, который фокусируется только на инфраструктурных метриках (CPU, RAM, дисковое пространство), не успевает за этими изменениями. Вот основные проблемы:

-

Слепота к бизнес-логике: вы знаете, что сервер «живой», но не видите, почему падает конверсия платежей или тормозит API.

-

Неспособность найти корень проблемы: при сбое в цепочке из 10 микросервисов метрики CPU не скажут, где именно произошла ошибка.

-

Ручная работа: настройка алертов для каждого сервиса отдельно — это часы рутинных задач.

Решение — переход к observability (наблюдаемости). Это подход, где метрики, логи и трейсы анализируются вместе, чтобы система «рассказывала» о своем состоянии сама.

Чтобы показать, как это работает на практике, добавим мониторинг ключевого параметра — количества запросов к API.

Вот несколько решений для этого:

На первый взгляд кажется, что мониторинг API — сложная задача. Но отслеживание корректных показателей — это важная часть работы для всех, кто занимается разработкой программных интерфейсов.

Мы используем гибридный подход:

-

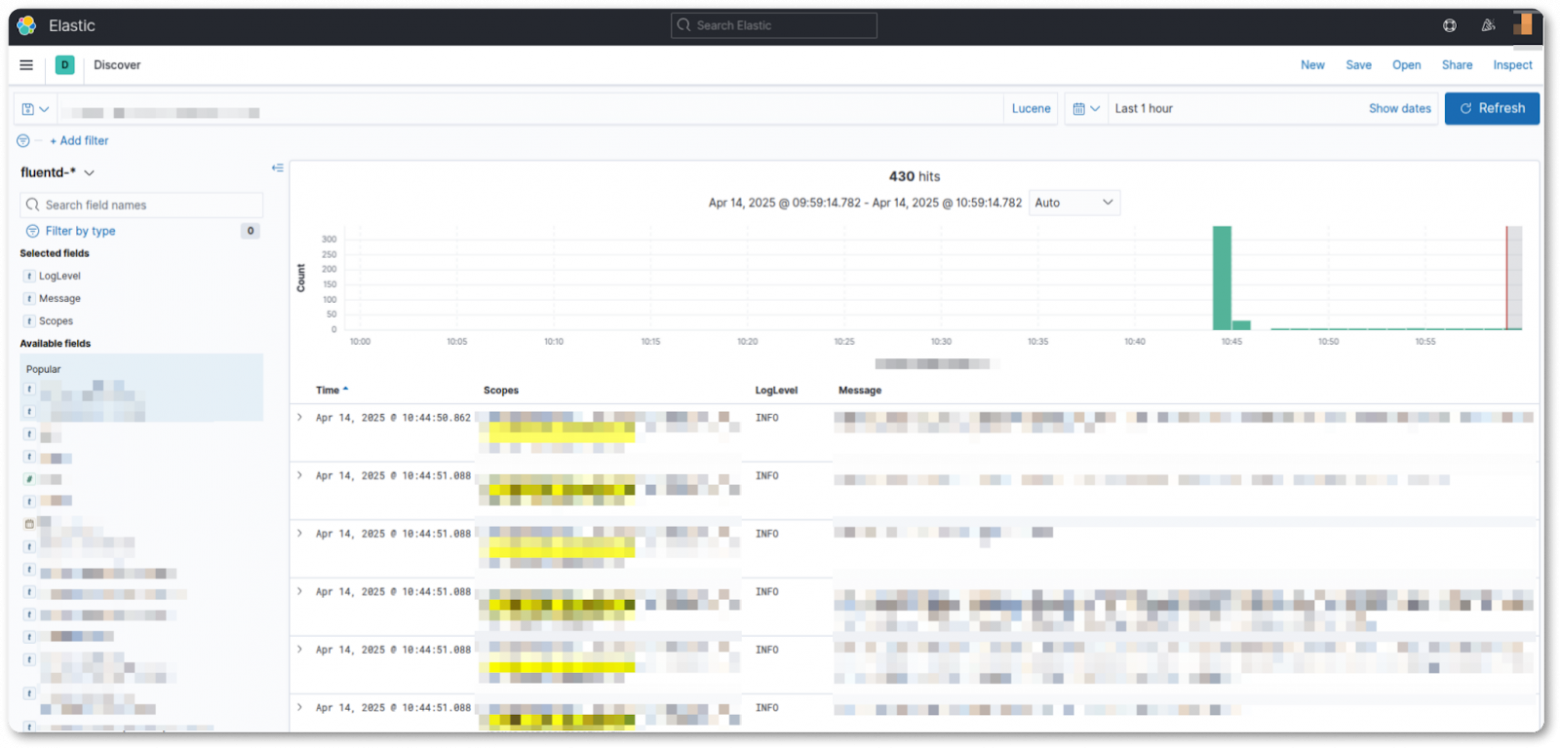

Инфраструктурные метрики (Prometheus) + трейсы (Jaeger) + логи (EFK: Elastic + Fluentd + Kibana).

-

Связываем данные через OpenTelemetry: например, находим все запросы с ошибками 500 и сразу смотрим связанные трейсы.

Какие метрики критичны для успешного мониторинга?

Эффективный мониторинг — это всегда баланс между инфраструктурой, бизнес-логикой и пользовательским опытом. Разберем ключевые категории метрик, которые нельзя игнорировать.

Инфраструктурные метрики

Базовые показатели: CPU, память, дисковое пространство, сетевой траффик.

Особенности для микросервисов:

-

балансировка нагрузки (например, процент ошибок в Istio или Nginx);

-

статус подов в Kubernetes (количество рестартов, фейлов по readiness/liveness проб);

-

трассировка запросов между сервисами (Jaeger): время выполнения каждого этапа.

Для Kubernetes используйте метрику kube_pod_status_ready в Prometheus — это помогает быстро находить «битые» поды без ручного проверки логов.

Бизнес-метрики

Финансовые показатели:

-

количество транзакций в минуту;

-

конверсия на ключевых этапах (например, от корзины к оплате).

Производительность процессов:

-

время обработки заказов;

-

успешность выполнения фоновых задач (например, отправка уведомлений).

// Отслеживание конверсии платежей

using App.Metrics;

public class PaymentService

{

private readonly IMetrics _metrics;

public PaymentService(IMetrics metrics) => _metrics = metrics;

public void ProcessPayment()

{

try

{

// Логика обработки платежа...

_metrics.Measure.Counter.Increment(MetricsRegistry.PaymentSuccessCounter);

}

catch

{

_metrics.Measure.Counter.Increment(MetricsRegistry.PaymentFailedCounter);

}

}

} Инструменты: Рекомендуем App.Metrics для .NET-проектов — библиотека гибко интегрируется с мониторингом на базе Grafana.

Метрики пользовательского опыта

Скорость работы:

-

время отклика API (p95, p99);

-

скорость загрузки страниц (LCP — Largest Contentful Paint, время отрисовки самого крупного элемента; FCP — First Contentful Paint, время появления первого контента).

Надежность:

-

частота ошибок 5xx/4xx;

-

отслеживание исключений в реальном времени (Sentry): например, JS-ошибки на фронтенде или исключения в бэкенде на C#.

Интеграции:

-

данные из Google Analytics (количество сессий, отказы);

-

Hotjar-сессии для анализа проблем UI/UX.

Для анализа пользовательского опыта недостаточно отслеживать только ошибки 5xx. Важно структурировать логи в JSON с контекстом позволяющим упростить поиск ошибки:

{

"timestamp": "2023-10-05T12:34:56Z",

"level": "ERROR",

"service": "payment",

"userId": "a1b2c3",

"operation": "process_payment",

"message": "Failed to charge card: insufficient funds"

} Теги вроде userId или operation позволяют быстро найти все логи, связанные с конкретным пользователем или транзакцией.

Чек-лист: как настроить мониторинг, который не подведет

Грамотный мониторинг — это не просто сбор данных, а продуманная система быстрого реагирования. Мы выстраиваем процессы так, чтобы клиенты спали спокойно даже в пиковые нагрузки.

Выявите все критичные узлы и их зависимости

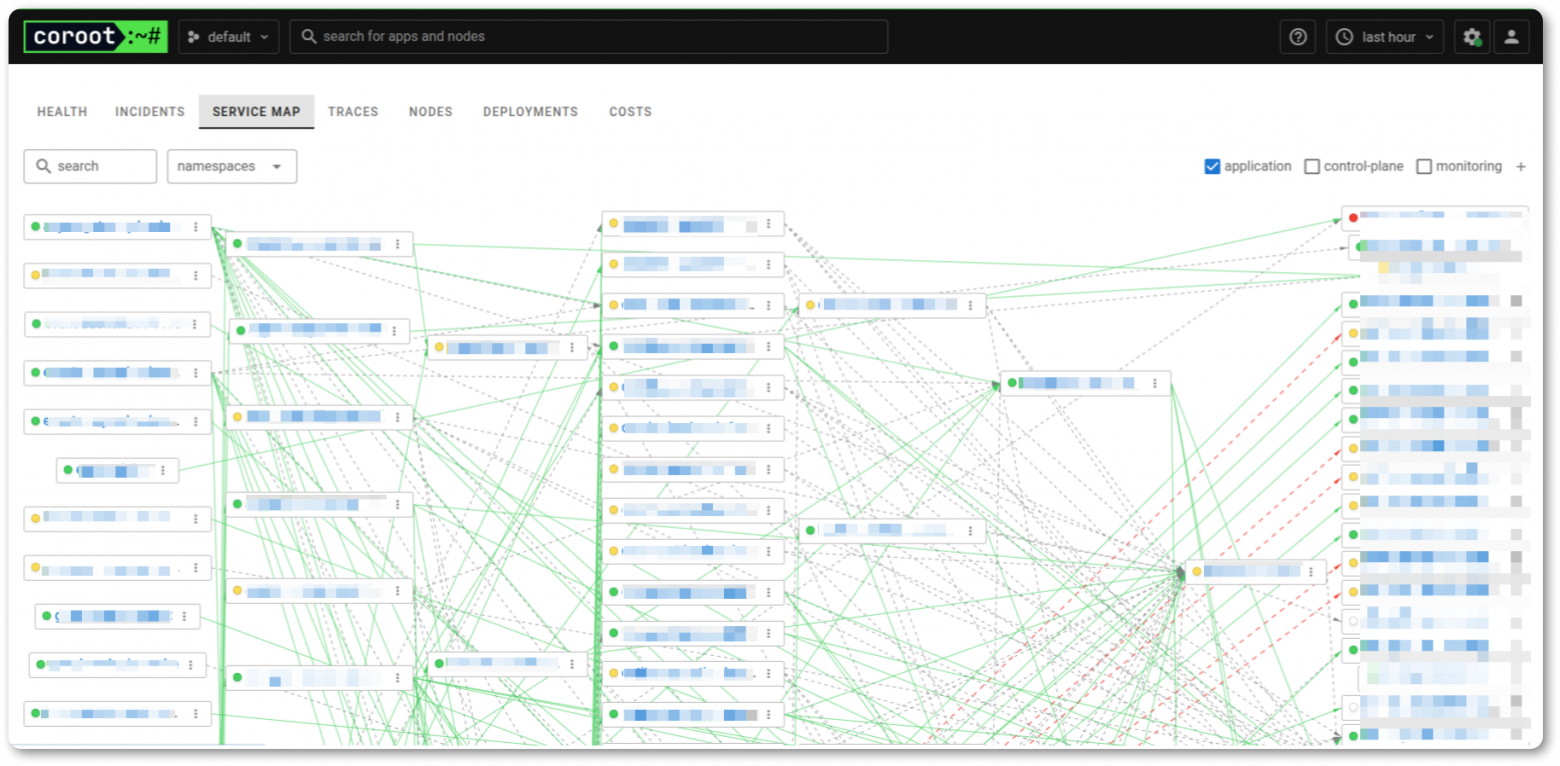

Шаг 1: Составьте карту сервисов.

Включите в нее все компоненты: ваши микросервисы, базы данных, очереди (Kafka, RabbitMQ), сторонние API (платежки, SMS-шлюзы).

Шаг 2: Определите зависимости.

Какие сервисы влияют на работу друг друга? Например, падение Redis может «уронить» кэширование и увеличить нагрузку на БД.

Симптомы проблем: разделите срочное и важное

Для каждого узла из шага 1 определите срочные симптомы и те, которые требуют анализа.

Первые, которые требуют реакции сейчас. Например:

-

База данных: connections > 90% лимита, replica lag > 10 сек.

-

Платежный шлюз: 5xx errors > 1% за 5 минут, latency p99 > 3 сек.

-

Kubernetes: pod restarts > 5 за час, node CPU > 95%.

Решить их можно через настройку алертов в Grafana OnCall или PagerDuty. Для этого в сообщении нужно указать что случилось, где искать логи и краткий гайд по решению.

Примеры вторых, которые требуют анализа:

-

Постепенный рост ошибок 4xx в API (> 5% за сутки).

-

Увеличение времени ответа на 20% за неделю.

-

Снижение количества успешных сессий в Google Analytics.

Их можно решить через отправку таких алертов в Slack/Email — они не требуют мгновенной реакции, но помогают предотвратить кризис.

Автоматизируйте рутину

Сбор логов: Используйте стек EFK (Elastic + Fluentd + Kibana) для агрегации и анализа логов.

Настройка Kubernetes

Liveness/Readiness пробы:

-

если liveness-проба падает — Kubernetes автоматически перезапускает под.

-

если readiness-проба недоступна — трафик перестает направляться на проблемный под.

Работа с Redis: настройте политики очистки кэша в конфигурации Redis.

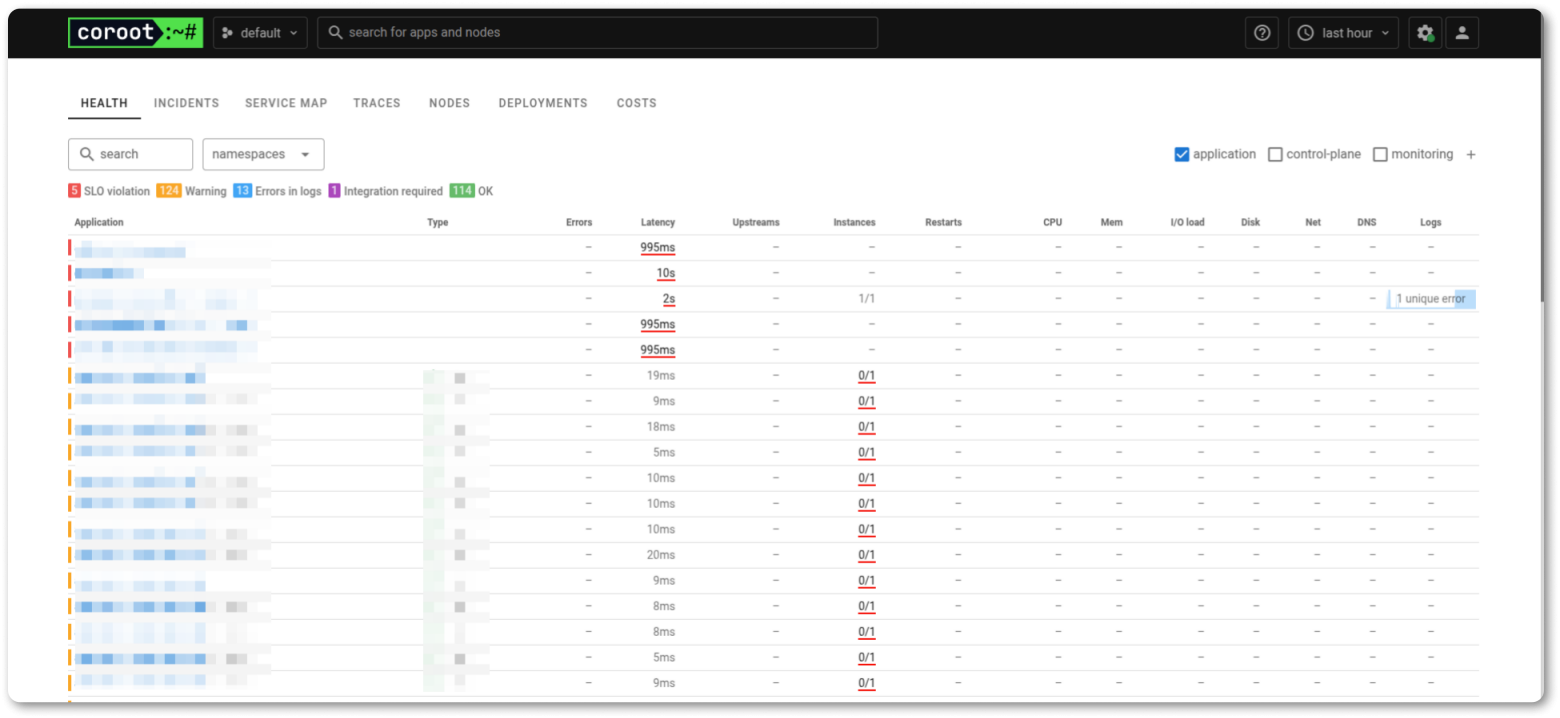

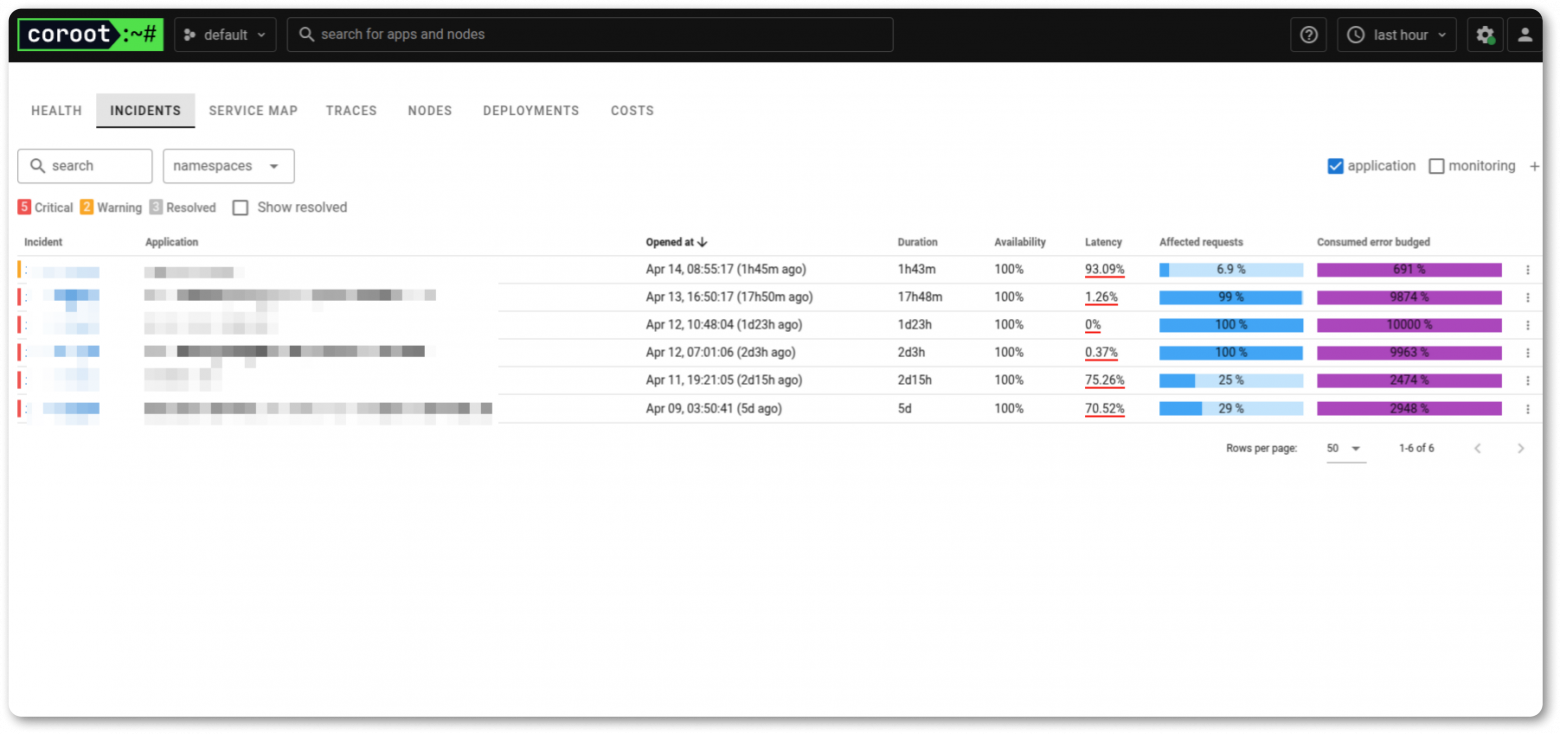

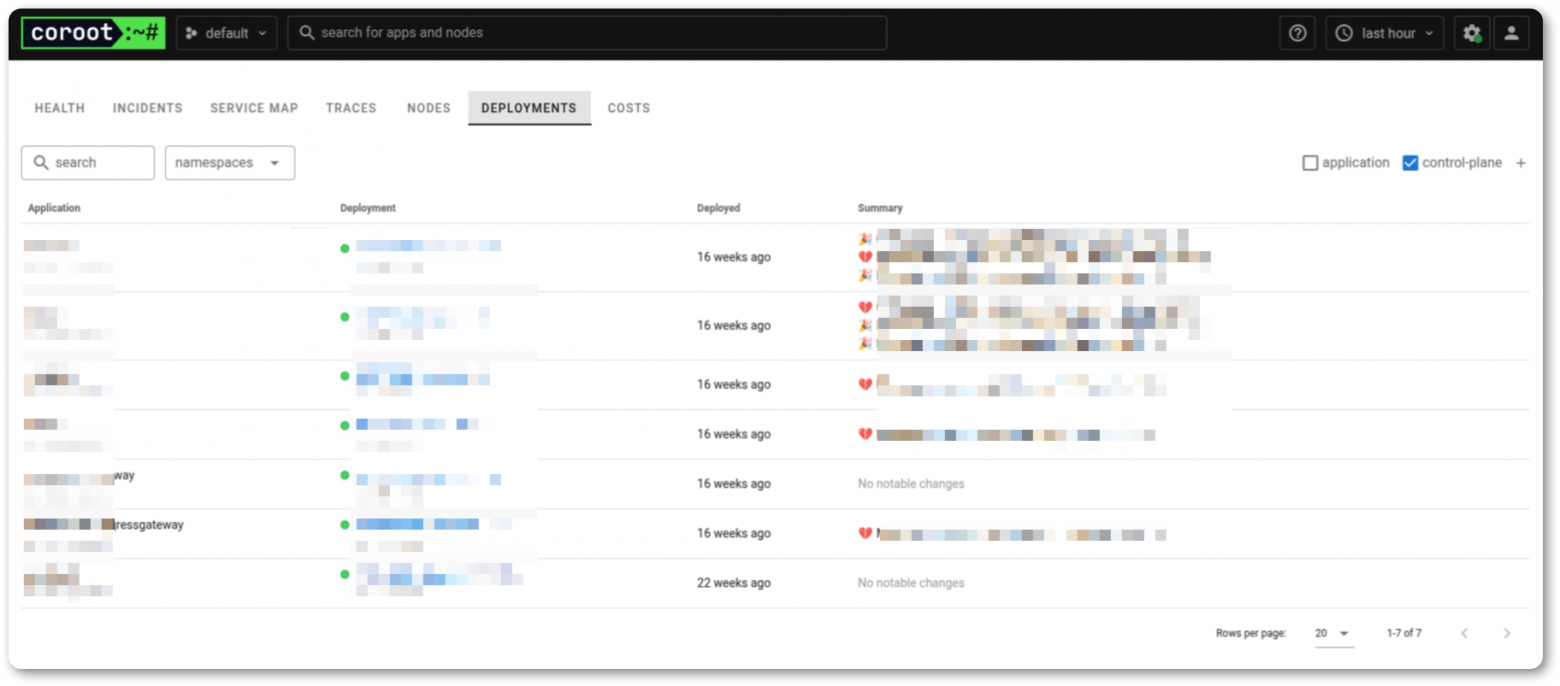

Инструменты для ленивых: если времени на интеграцию Prometheus/Jaeger нет, начните с Coroot. Он автоматически обнаружит сервисы, построит карту зависимостей и предложит базовые алерты.

Тестируйте устойчивость системы

Chaos Engineering: Раз в месяц устраивайте «стресс-тесты»:

-

Отключайте случайные ноды в кластере.

-

Эмулируйте нагрузку в 10 раз выше обычной (например, с помощью Locust).

Мониторинг должен не только сообщать о проблемах, но и подсказывать, что делать. Мы настраиваем его так, чтобы ваша команда тратила время на развитие, а не на тушение пожаров.

Observability: как предсказывать сбои до их возникновения

Observability — это не просто «продвинутый мониторинг», а способность системы отвечать на вопросы, которые вы даже не успели задать. Если мониторинг говорит: «Сервер упал», то observability объясняет: «Сервер упал из-за исчерпания памяти в поде Kubernetes, который обрабатывал очередь сообщений с задержкой в 5 секунд из-за проблем с сетью в облаке».

Представьте, что ваш микросервисный API внезапно начинает тормозить. Мониторинг покажет высокую загрузку CPU, но только observability раскроет полную картину: например, что проблема вызвана каскадными таймаутами из-за медленного ответа геолокационного сервиса, который, в свою очередь, упирается в неоптимальные запросы к PostgreSQL. Такой уровень детализации достигается за счет трех ключевых компонентов: метрик, собираемых Prometheus, логов из Loki/ELK/EFK, и трейсов, которые настраивают через Jaeger и OpenTelemetry.

Вот как это работает на практике. Допустим, вы видите в Grafana рост времени ответа API. Вместо ручного поиска причин, observability-стек позволяет мгновенно перейти к связанным трейсам в Jaeger и обнаружить, что 70% задержки возникают в сервисе кэширования. Анализ логов покажет, что ошибки «Connection timeout» начались после обновления версии Redis.

Для настройки трейсинга можно использовать OpenTelemetry — это универсальный стандарт, который применяется даже в сложных .NET-средах. Например, следующий код интегрирует Jaeger в микросервис, чтобы каждый запрос оставлял «след» для анализа:

// Настройка трейсинга для микросервиса

using OpenTelemetry.Trace;

var tracerProvider = Sdk.CreateTracerProviderBuilder()

.AddSource("AvantIT.Monitoring")

.AddJaegerExporter(opts =>

{

opts.AgentHost = "jaeger.avantit.local";

opts.AgentPort = 6831;

})

.Build();Но observability — это не только инструменты, а культура работы с данными.

Главный секрет в том, чтобы превратить данные в действия. Когда вы видите, что p95 времени ответа API растет на 3% ежедневно, то необходимо оптимизировать код или добавить ресурсы.

Observability не устраняет проблемы — она делает их предсказуемыми. И это именно то, что превращает вашу инфраструктуру из расходов в конкурентное преимущество.

Интеграция мониторинга в процессы разработки и управления

Мониторинг перестает быть задачей только для DevOps-инженеров, когда становится частью DNA вашей команды.Мы строим процессы так, чтобы метрики и трейсы влияли на каждое решение — от написания кода до управления релизами.

DevOps: где разработчики и админы говорят на одном языке

Observability-метрики (время ответа API, ошибки) встраиваются в код с первого дня. Например, если новая фича увеличивает задержку на 20%, это видно еще до код-ревью. Для админов связь метрик Prometheus с трейсами Jagger упрощает поиск «узких горлышек»: не нужно копать логи вручную, когда система сама показывает, где тормозит геолокационный сервис или блокируются запросы к PostgreSQL.

CI/CD: автомат для безопасных релизов

Хороший пайплайн не просто деплоит код, а прогнозирует риски. Вот как это работает:

-

Перед деплоем: Запускайте нагрузочные тесты (например, через Locust). Проверяйте ключевые метрики: уровень ошибок, задержки API, доступность зависимостей.

-

После деплоя: Инструменты вроде Flagger автоматически сравнивают метрики до и после обновления. Если ошибки растут или latency выходит за рамки — откат происходит без человека.

Блокировка из-за загрузки CPU часто приводит к ложным срабатываниям. Гораздо эффективнее анализировать метрики, которые напрямую влияют на пользователей: ошибки, время ответа, бизнес-показатели.

Управление проектами: метрики вместо догадок

Прогнозирование сроков: Рост метрики deployment failure rate сигнализирует, что команде нужен рефакторинг или дополнительные ресурсы.

Оценка рисков: Трейсы Jaeger показывают сервисы с низкой отказоустойчивостью — их можно доработать до перехода в прод.

Заключение

Современные IT-системы больше не позволяют себе роскоши работать вслепую. Сбои, ошибки и простои — это не просто технические неполадки, а прямые угрозы бизнесу, особенно в эпоху микросервисов и распределенных облачных сред. Но хорошая новость в том, что сегодня у нас есть все инструменты, чтобы не просто реагировать на проблемы, а предупреждать их.

Автор: QTU100