ChatGPT-4.1: Революционный скачок в программировании и обработке длинного контекста

Компания OpenAI представила [1] новое семейство моделей GPT-4.1 с впечатляющими улучшениями в области программирования, следования инструкциям и работы с длинным контекстом. Рассмотрим ключевые особенности новинок и их преимущества для разработчиков.

P.S кратко написал об этом в Телеграм канале, cсылка на пост [2]

Три модели для разных задач

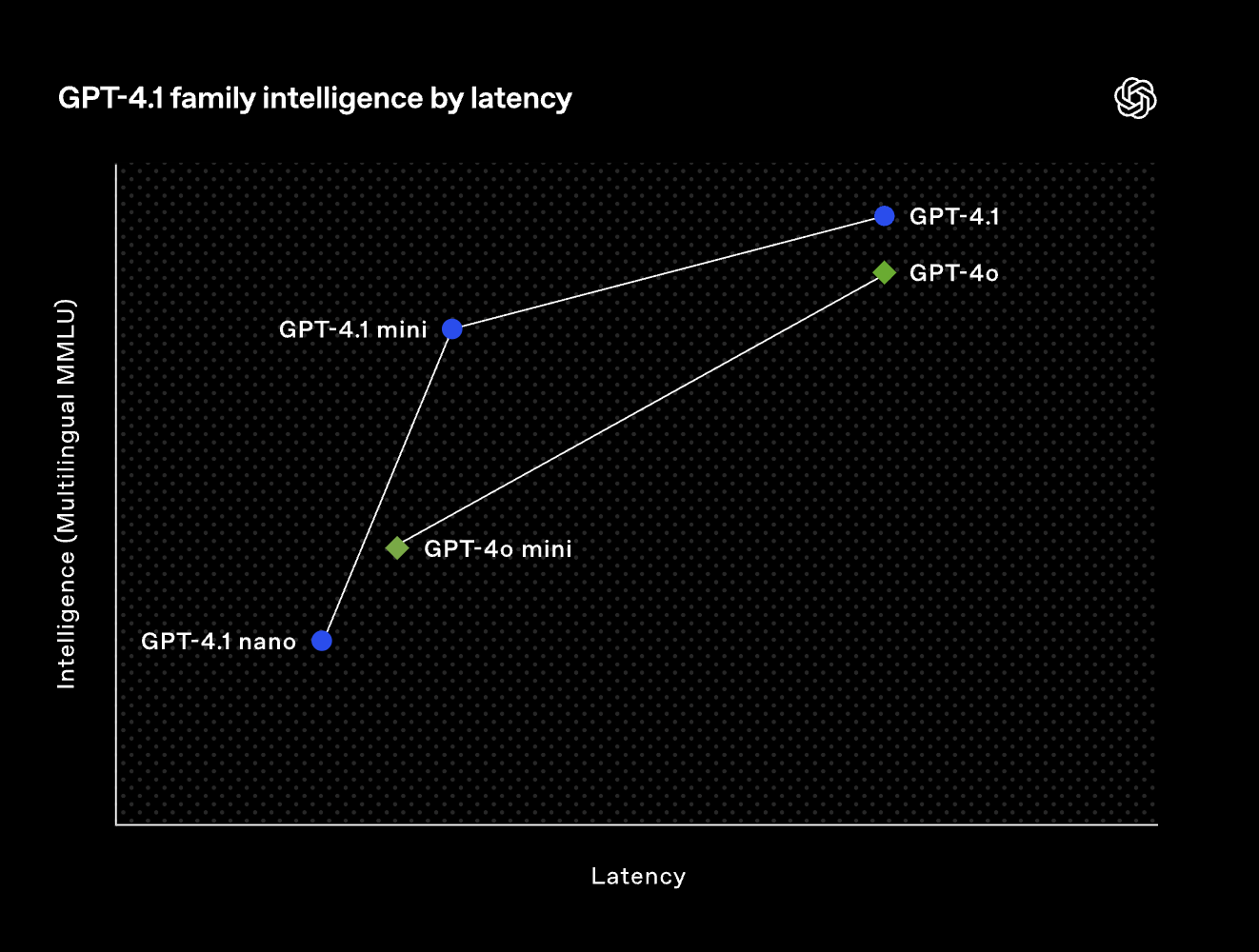

OpenAI выпустила сразу три модели: флагманскую GPT-4.1, более компактную GPT-4.1 mini и сверхлегкую GPT-4.1 nano. Все они значительно превосходят предыдущее поколение GPT-4o по ключевым показателям и поддерживают контекстное окно до 1 миллиона токенов. Обновленная база знаний моделей включает информацию до июня 2024 года.

Впечатляющие результаты в бенчмарках

GPT-4.1 демонстрирует выдающиеся результаты по трем ключевым направлениям:

-

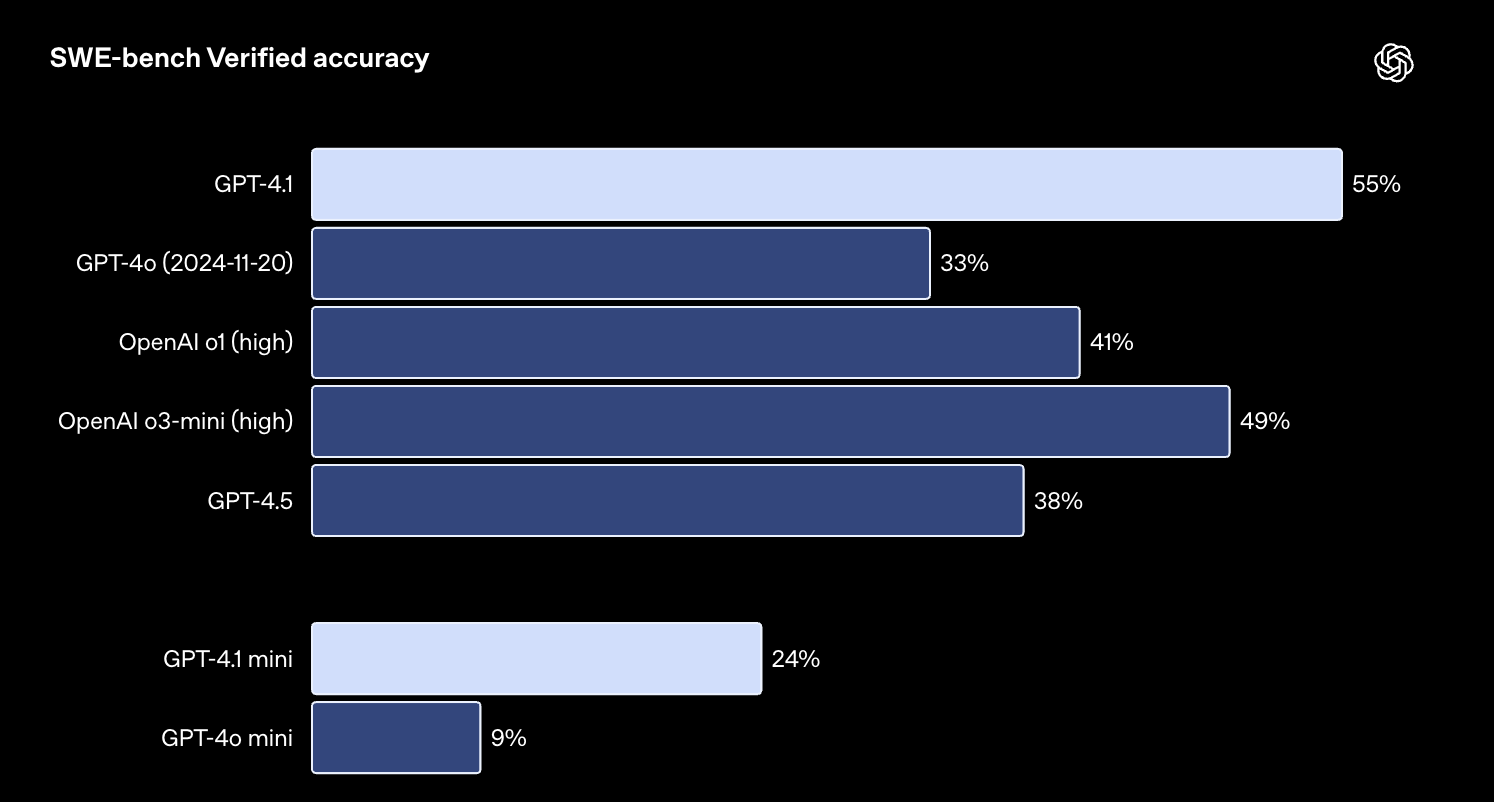

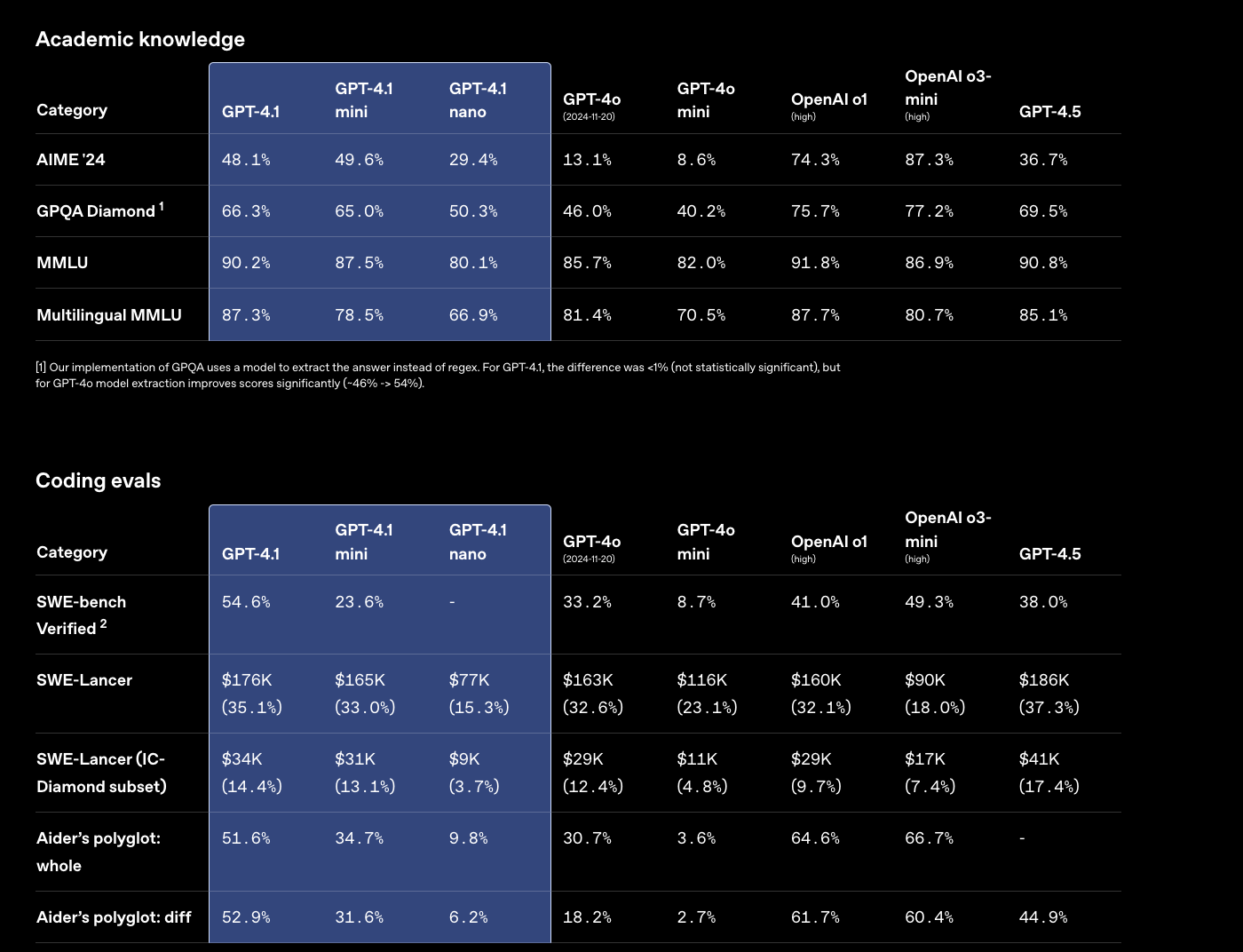

Программирование: 54,6% на SWE-bench [3] Verified, что на 21,4% лучше GPT-4o и на 26,6% лучше GPT-4.5

-

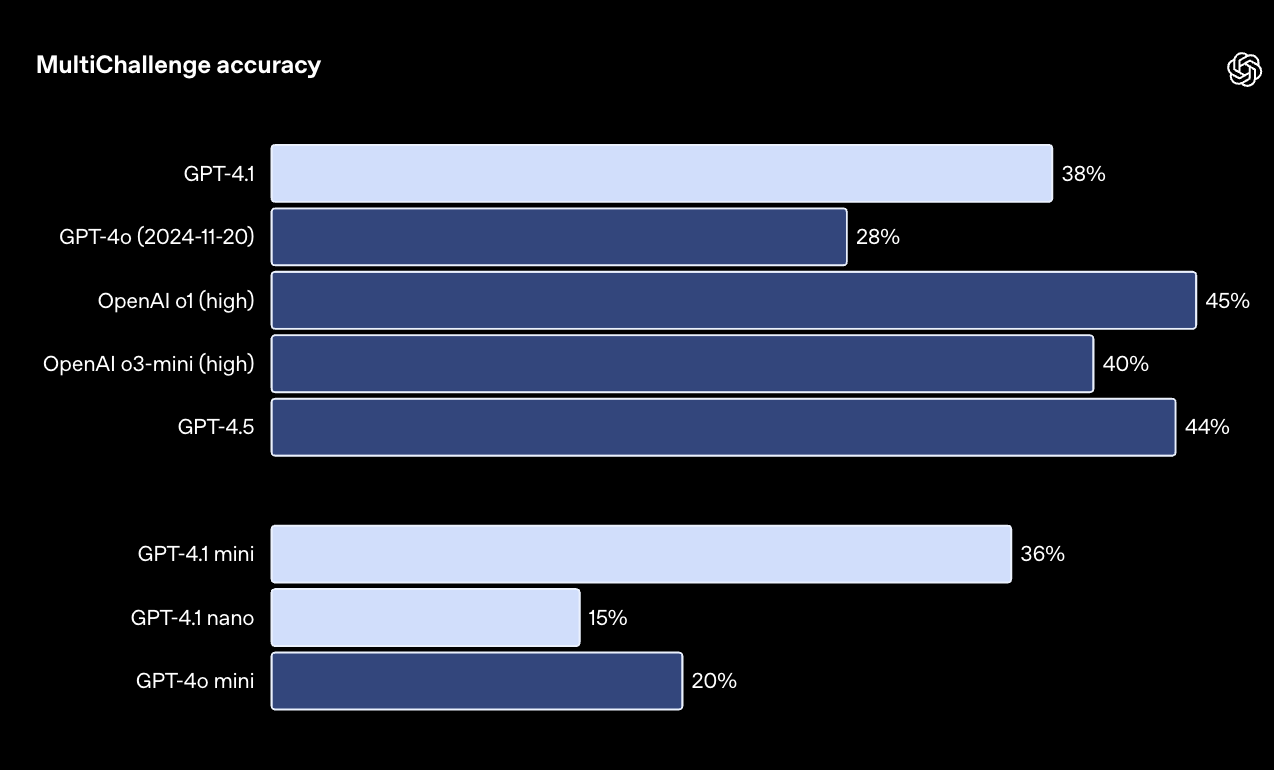

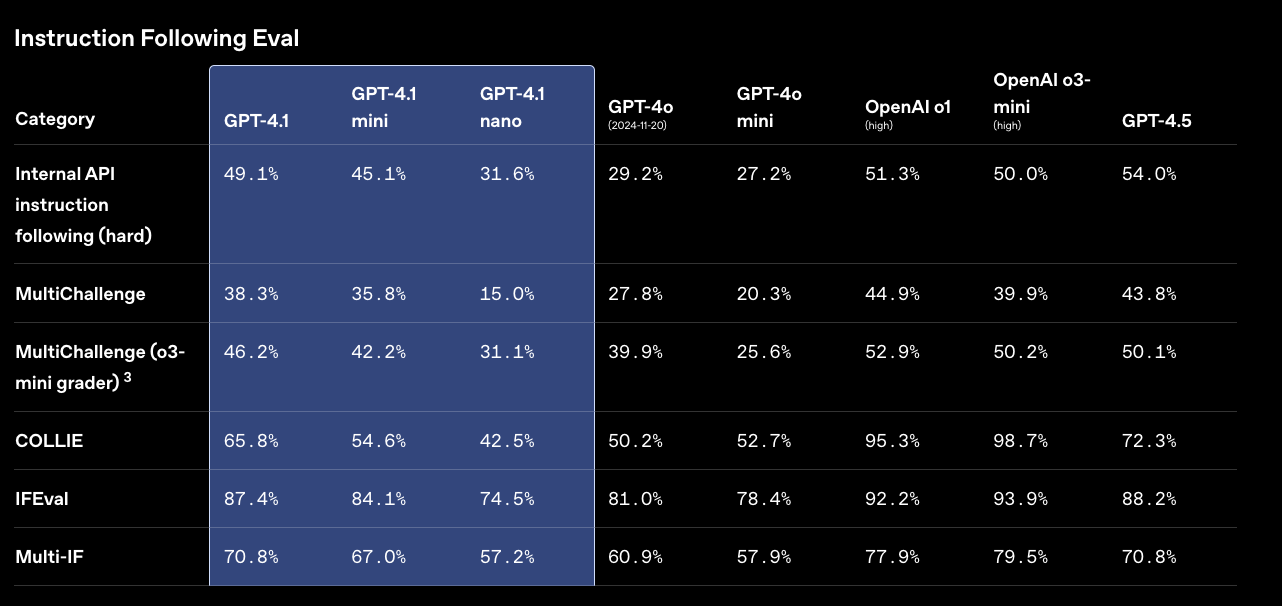

Следование инструкциям: 38,3% на MultiChallenge [4], превосходя GPT-4o на 10,5%

-

Длинный контекст: 72,0% на Video-MME [5] в категории длинных видео без субтитров, что на 6,7% лучше GPT-4o

Особенно впечатляет GPT-4.1 mini, которая превосходит GPT-4o по многим показателям, при этом работая почти вдвое быстрее и стоит на 83% дешевле. GPT-4.1 nano, самая компактная модель в линейке, показывает отличные результаты при минимальных затратах ресурсов.

Прорыв в программировании

Пока что везде мысленно добавляем “якобы”.

В области разработки ПО GPT-4.1 делает огромный шаг вперед. На бенчмарке SWE-bench Verified, измеряющем навыки реального программирования, новая модель выполняет 54,6% задач против 33,2% у GPT-4o.

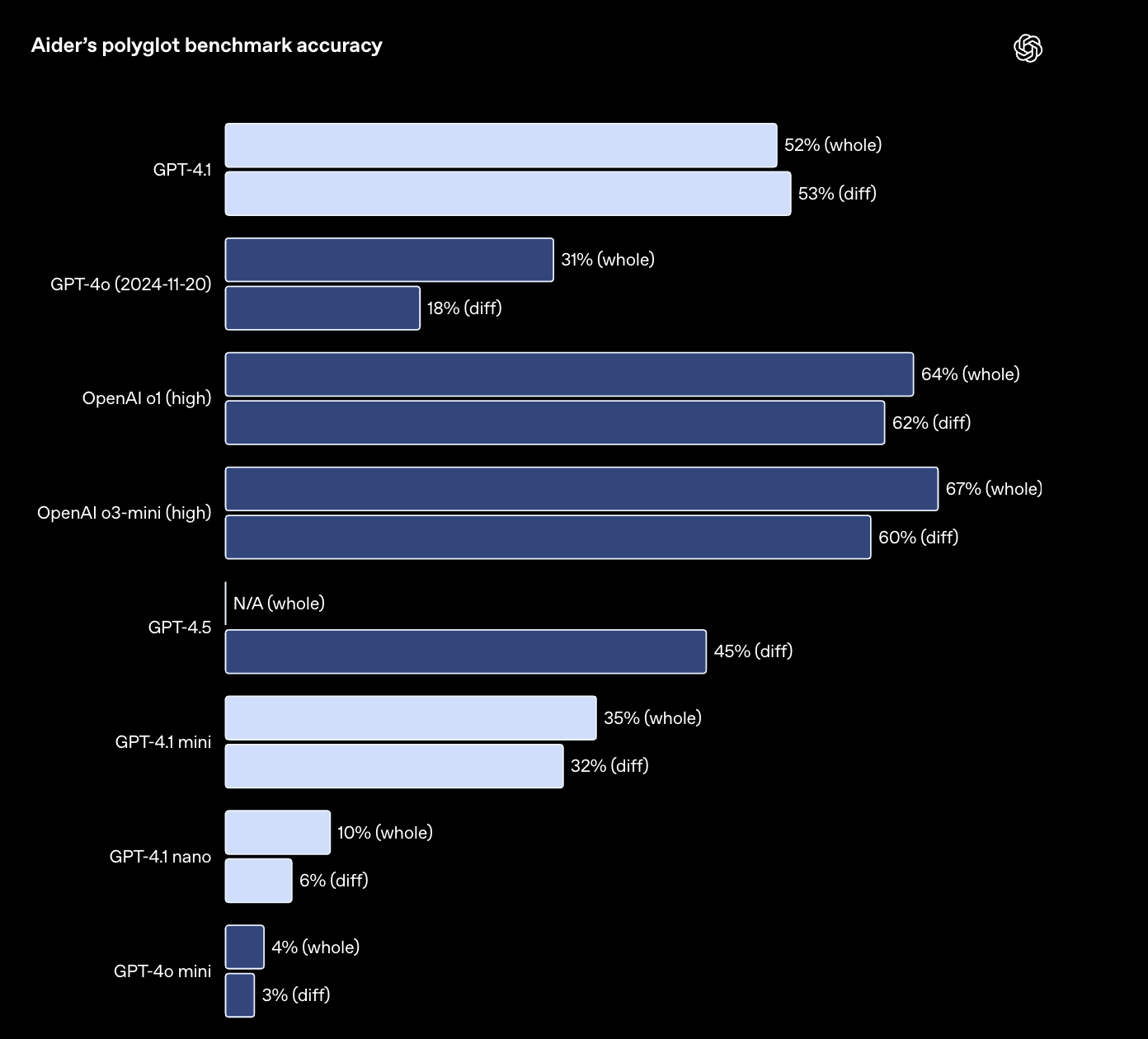

Модель также значительно лучше работает с форматом diff при редактировании кода, более чем вдвое превосходя GPT-4o в Aider’s polyglot diff benchmark [6] и даже превосходя GPT-4.5 на 8%.

Компания Windsurf отмечает, что GPT-4.1 на 60% лучше справляется с их внутренним бенчмарком по программированию, а пользователи заметили 30%-ное повышение эффективности при вызове инструментов и снижение вероятности ненужных правок на 50%.

Улучшенное следование инструкциям

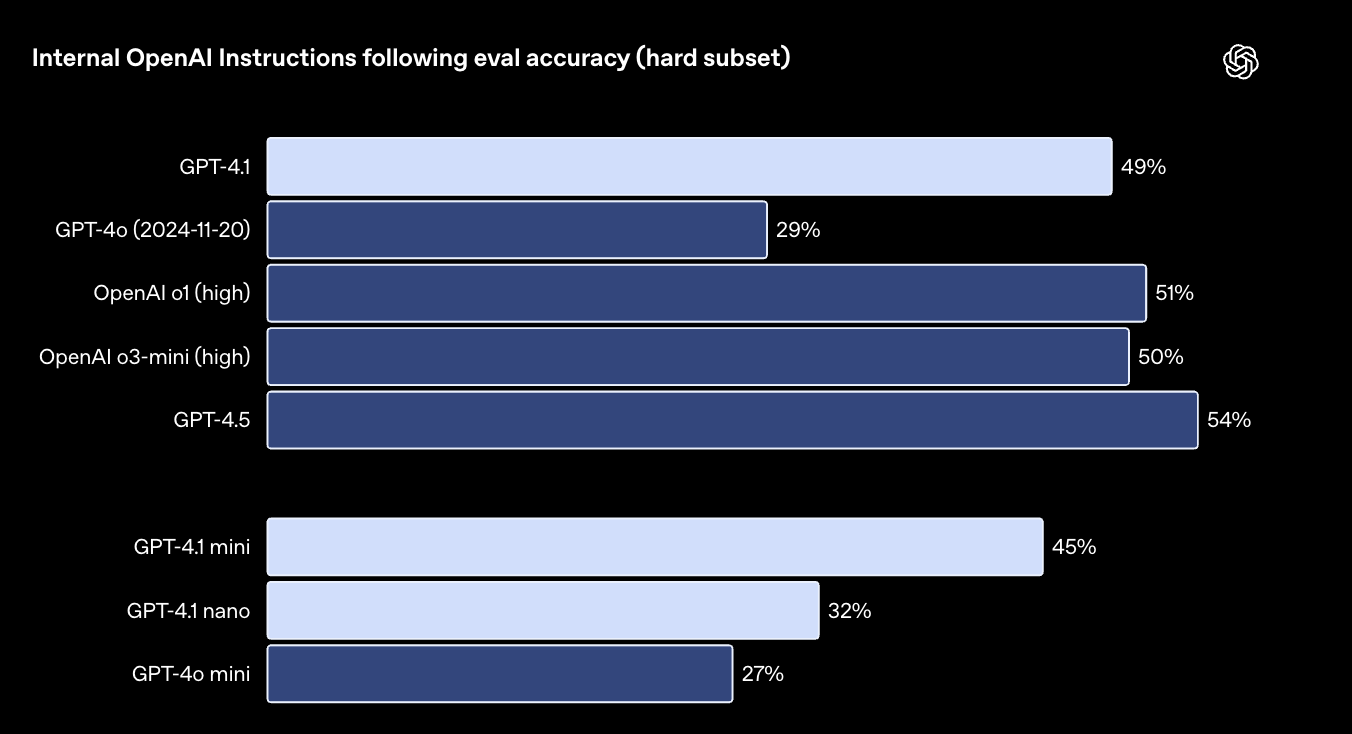

GPT-4.1 гораздо лучше понимает и выполняет сложные инструкции. Модель значительно превосходит предшественников во внутреннем тесте OpenAI на следование инструкциям, особенно в сложных сценариях.

Компания Blue J сообщает о 53%-ном улучшении точности при анализе сложных налоговых сценариев по сравнению с GPT-4o. А Hex отмечает почти двукратное улучшение в работе с SQL-запросами для сложных схем данных.

Работа с длинным контекстом

Все модели семейства GPT-4.1 поддерживают контекстное окно до 1 миллиона токенов, что эквивалентно более чем 8 копиям всей кодовой базы React. Но важнее то, что модели эффективно используют этот контекст.

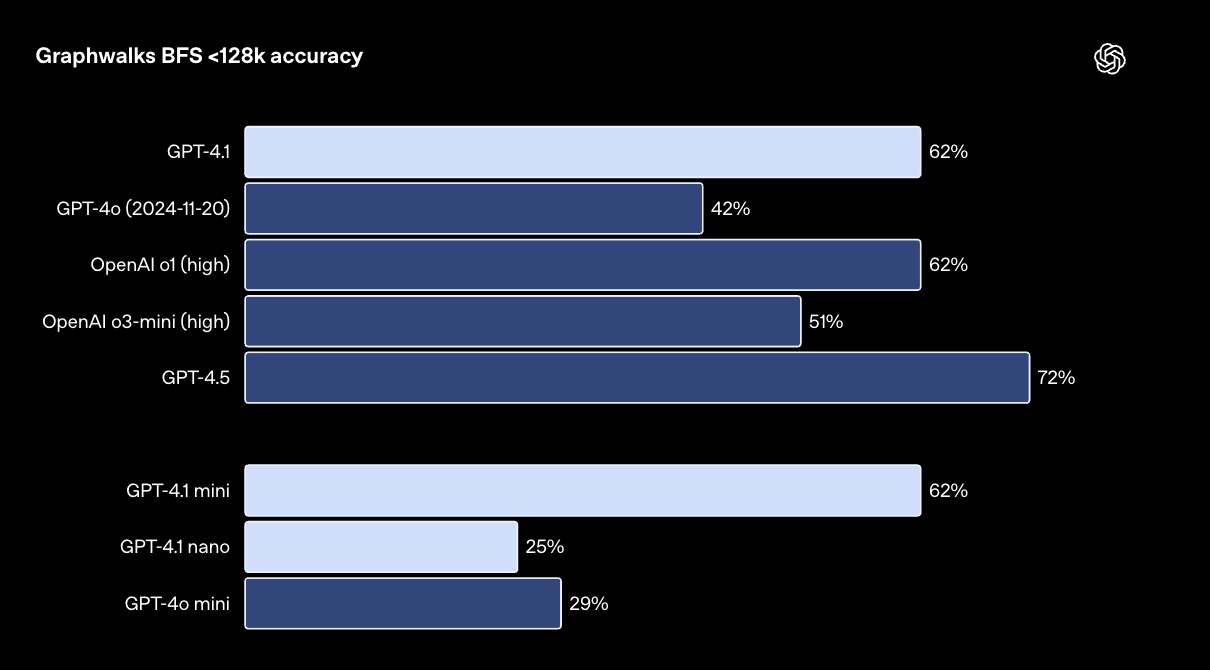

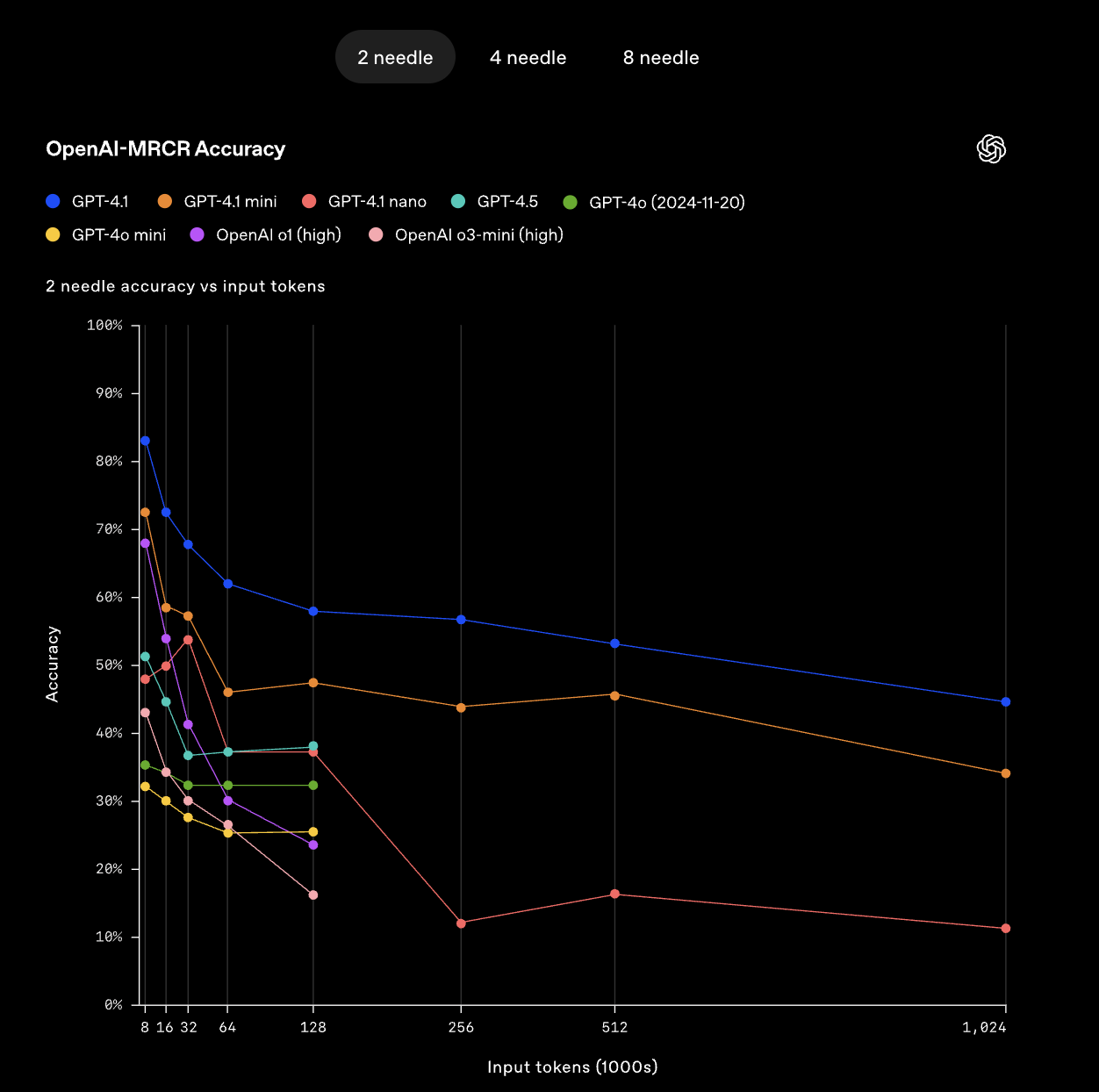

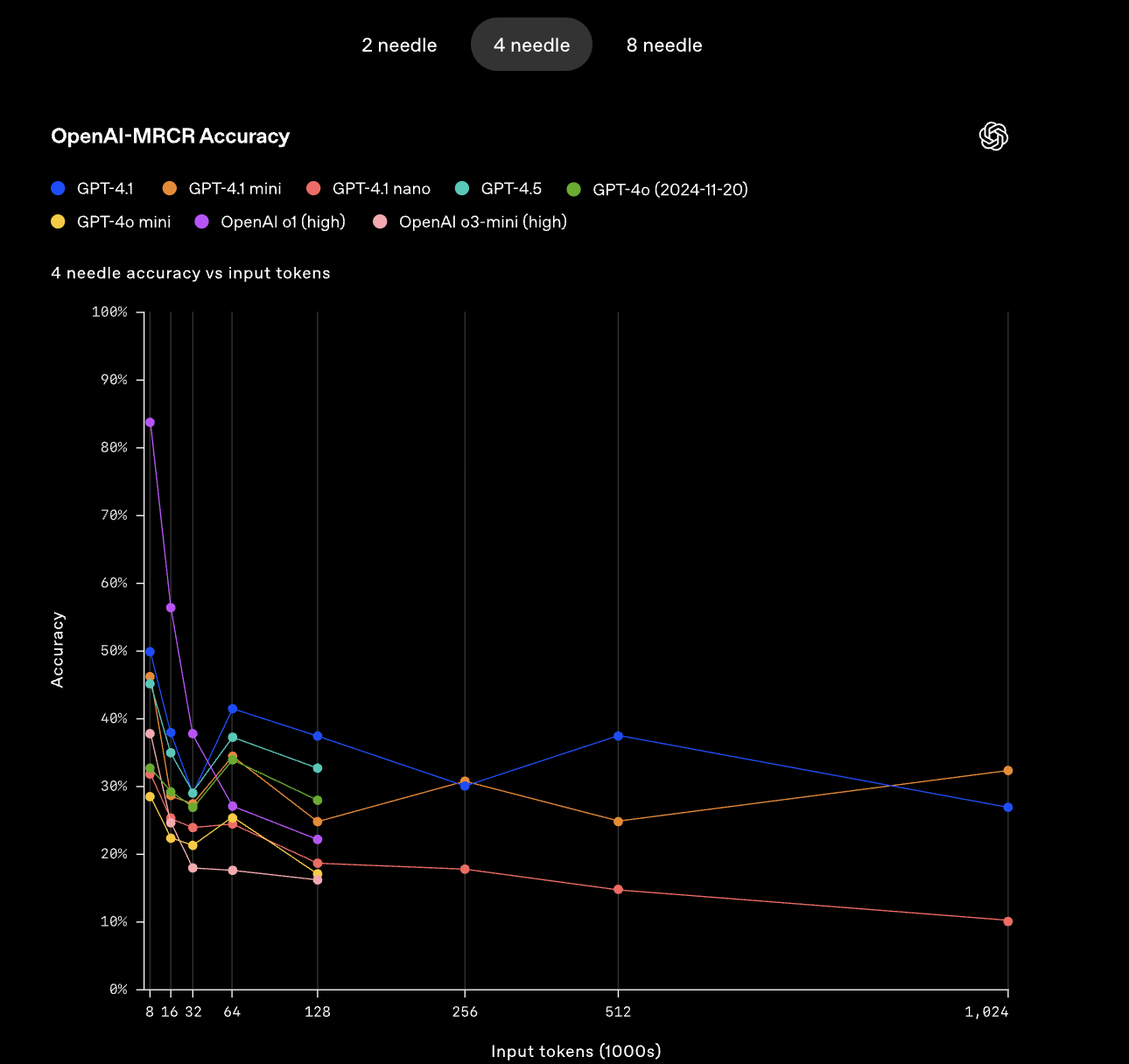

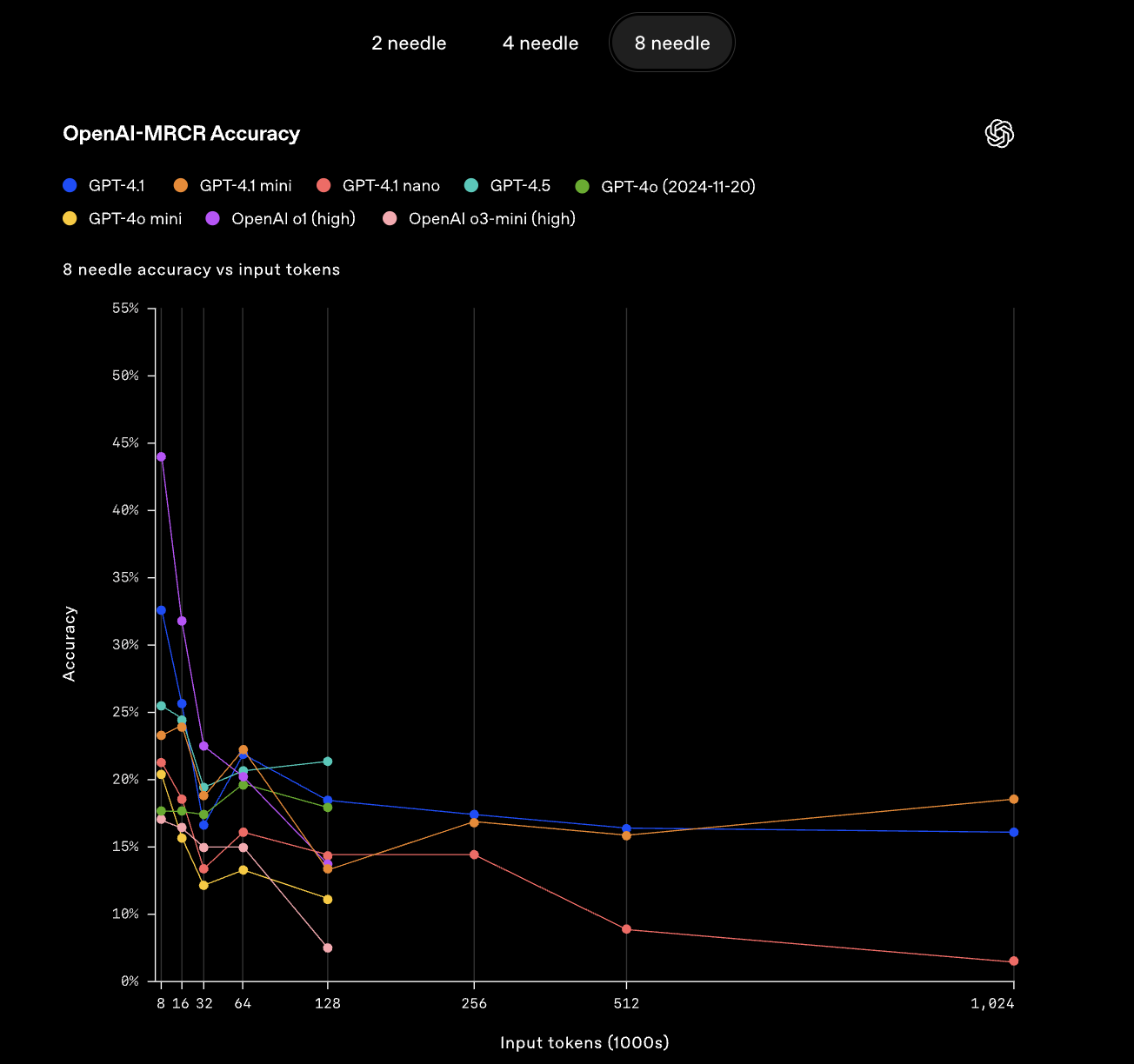

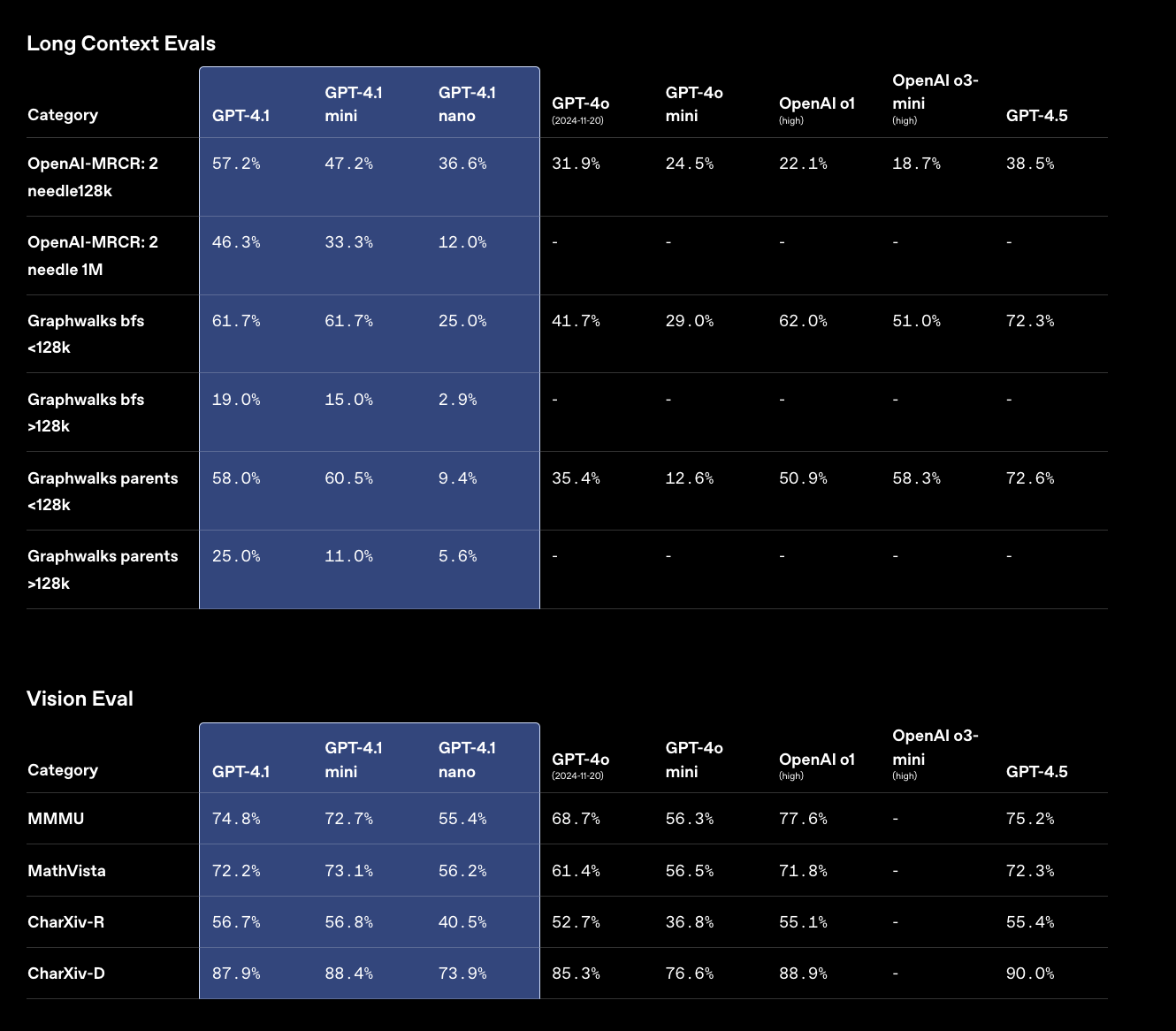

OpenAI представила два новых бенчмарка для оценки работы с длинным контекстом: OpenAI-MRCR [7] и Graphwalks [8]. GPT-4.1 показывает превосходные результаты, значительно опережая GPT-4o и сохраняя эффективность даже при контексте в 1 миллион токенов.

Thomson Reuters отмечает 17%-ное улучшение точности при анализе нескольких юридических документов с помощью GPT-4.1 по сравнению с GPT-4o. А Carlyle сообщает о 50%-ном улучшении извлечения финансовых данных из объемных документов.

Цены

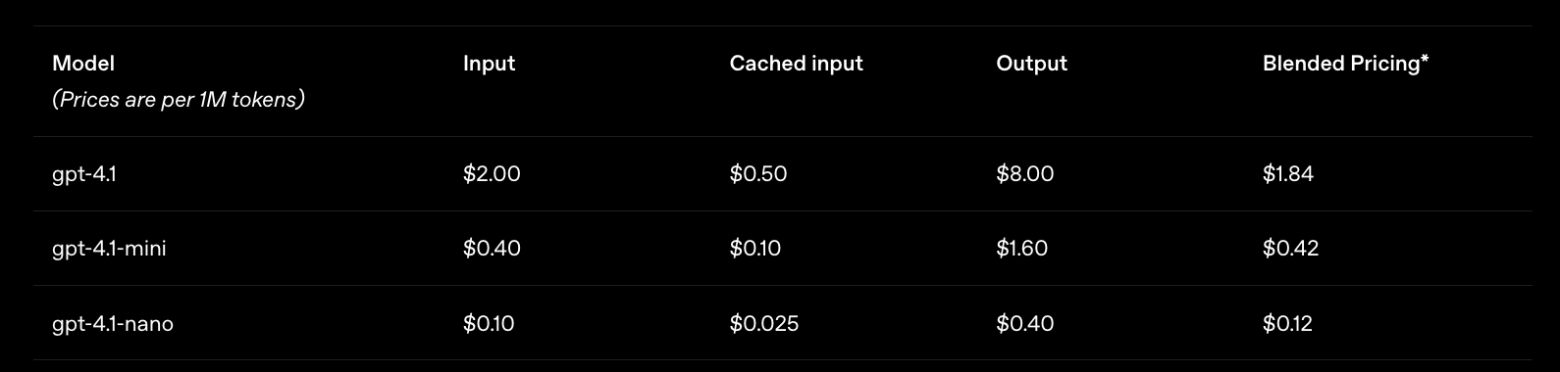

OpenAI снизила цены на новые модели. GPT-4.1 на 26% дешевле, чем GPT-4o для типичных запросов. Для запросов, повторно использующих тот же контекст, скидка на кэшированный ввод увеличена до 75% (ранее 50%). Длинный контекст не требует дополнительной оплаты сверх стандартной стоимости токенов.

Доступность и планы

Все три модели GPT-4.1 доступны разработчикам через API с сегодняшнего дня. Они не будут интегрированы в ChatGPT, хотя многие улучшения постепенно внедряются в версию GPT-4o для этого сервиса.

OpenAI также объявила о прекращении поддержки GPT-4.5 Preview через API. Эта модель будет отключена 14 июля 2025 года, давая разработчикам три месяца на переход к новым моделям.

Полные результаты тестирования новых моделей по академическим знаниям, программированию, следованию инструкциям и другим параметрам доступны в официальном анонсе.

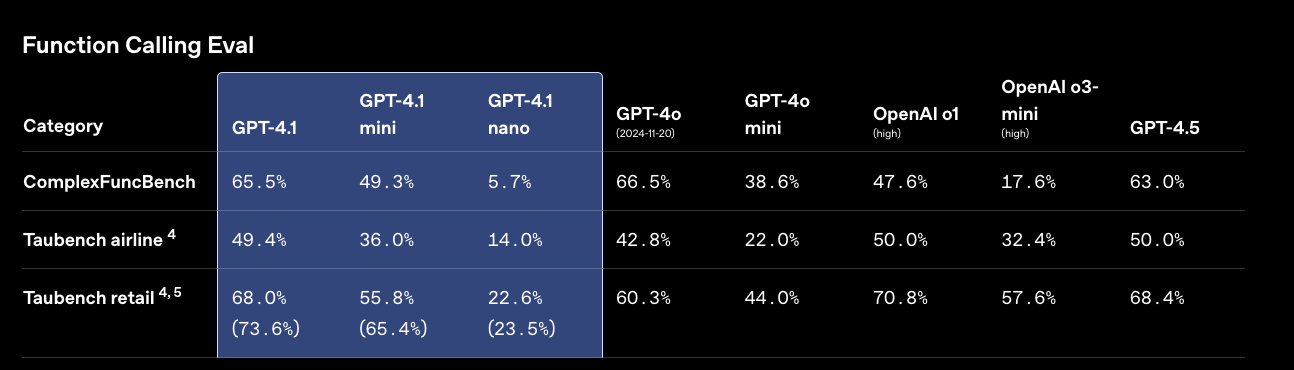

Остальные бенчи

Автор: g_coll

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14247

URLs in this post:

[1] представила: https://openai.com/index/gpt-4-1/

[2] cсылка на пост: https://t.me/g_coll/1421

[3] SWE-bench: https://openai.com/index/introducing-swe-bench-verified/

[4] MultiChallenge: https://scale.com/leaderboard/multichallenge

[5] Video-MME: https://video-mme.github.io/home_page.html

[6] Aider’s polyglot diff benchmark: https://aider.chat/docs/leaderboards/

[7] OpenAI-MRCR: https://huggingface.co/datasets/openai/mrcr

[8] Graphwalks: https://huggingface.co/datasets/openai/graphwalks

[9] Источник: https://habr.com/ru/news/900850/?utm_source=habrahabr&utm_medium=rss&utm_campaign=900850

Нажмите здесь для печати.