Все началось с анонса модели OpenAI o1 в сентябре 2024 года, но настоящий рывок произошел с выпуском DeepSeek R1 в январе 2025 года. Теперь, похоже, большинство основных поставщиков и тренеров моделей AI включились в новую гонку, чтобы предоставить лучшие, быстрые и дешевые модели языка «рассуждений» AI — то есть такие, которые, возможно, потребуют немного больше времени для ответа пользователю-человеку, но в идеале будут давать лучшие, более полные, более «аргументированные» ответы, которые эти классы моделей получают, выполняя «цепочку мыслей», размышляя над собственными выводами и проверяя их на достоверность перед ответом.

ByteDance, китайский интернет-гигант, родитель TikTok, присоединился к вечеринке, объявив и опубликовав техническую статью по Seed-Thinking-v1.5 — будущей большой языковой модели (LLM), предназначенной для повышения эффективности рассуждений в областях науки, техники, математики и инженерии (STEM), а также в областях общего назначения.

Модель пока недоступна для загрузки или использования, и неясно, какими будут условия лицензирования — будет ли она проприетарной/с закрытым исходным кодом, с открытым исходным кодом/бесплатной для всех, чтобы использовать и изменять по желанию, или где-то посередине. Тем не менее, технический документ содержит некоторые примечательные детали, которые стоит рассмотреть сейчас и заранее, когда они станут доступны.

Как и новая Llama 4 от Meta и предыдущая Mixtral от Mistral, Seed-Thinking-v1.5 построен с использованием архитектуры Mixture-of-Experts (MoE). Эта архитектура разработана для повышения эффективности моделей. По сути, она объединяет возможности нескольких моделей в одну, каждая из которых специализируется в своей области.

В этом случае архитектура MoE означает, что Seed-Thinking-v1.5 использует только 20 миллиардов из 200 миллиардов параметров одновременно. ByteDance в своей технической статье, опубликованной на GitHub, сообщает, что Seed-Thinking-v1.5 отдает приоритет структурированному рассуждению и генерации продуманных ответов.

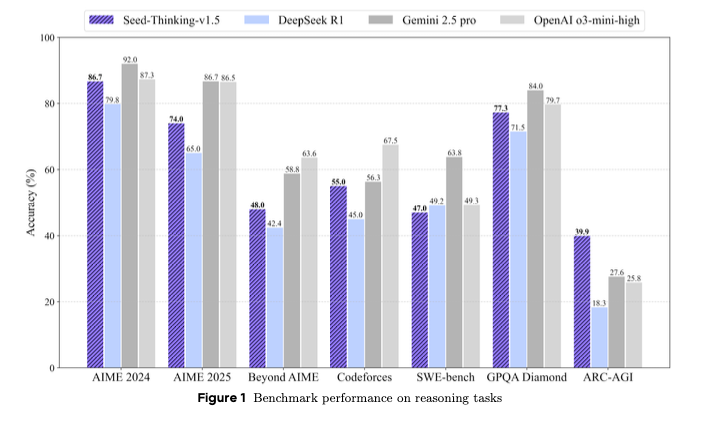

Результаты почти говорят сами за себя: Seed-Thinking-v1.5 превосходит DeepSeek R1 и приближается к недавно выпущенному Google Gemini 2.5 Pro и o3-mini-high reasoner от OpenAI по многим сторонним оценкам. Он даже превосходит эти два в случае с бенчмарком ARC -AGI, который измеряет прогресс в направлении искусственного интеллекта в целом, рассматриваемого как цель AI. Эта модель превосходит людей по большинству экономически значимых задач, согласно определению OpenAI.

Позиционируемый как компактная, но способная альтернатива более крупным современным моделям, Seed-Thinking-v1.5 достигает конкурентоспособных результатов бенчмарков. Он представляет инновации в области обучения с подкреплением (RL), курирование данных для обучения и инфраструктуру AI.

Seed-Thinking-v1.5 демонстрирует высокую производительность в наборе сложных задач, набрав 86,7% на AIME 2024, 55,0% pass@8 на Codeforces и 77,3% на научном бенчмарке GPQA. Эти результаты приближают его или ставят в один ряд с такими моделями, как o3-mini-high от OpenAI и Gemini 2.5 Pro от Google по определенным метрикам рассуждения.

При выполнении задач, не требующих рассуждений, модель оценивалась путем сравнения с предпочтениями человека и показала на 8,0% более высокий процент побед по сравнению с DeepSeek R1, что говорит о том, что ее сильные стороны выходят за рамки задач на логику или сложные математические задачи.

Чтобы справиться с перенасыщением в стандартных бенчмарках, таких как AIME, ByteDance представил BeyondAIME, новый, более сложный математический бенчмарк с кураторскими задачами, разработанными для сопротивления запоминанию и лучшей дискриминации производительности модели. Ожидается, что этот набор и набор оценок Codeforces будут опубликованы для поддержки будущих исследований.

Автор: dilnaz_04