Всем привет!

Меня зовут Александр, я COO в SaaS-платформе аналитики данных. Последний год активно изучаю внедрение AI-решений в кросс-функциональные процессы. Делюсь материалами, которые помогают:

-

Продуктовым менеджерам — интегрировать AI без перегрузки команд;

-

Разработчикам — выбирать инструменты под конкретные бизнес-задачи;

-

Специалистам по данным — избегать ошибок в production-развертывании.

У себя в телеграм-канале делюсь сжатыми и структурированными саммери статей.

Сегодняшний перевод — AI Avatars Escape the Uncanny Valley от партнера фонда Andreessen Horowitz.

Статья исследует эволюцию AI аватаров — от примитивных говорящих голов до полноценных персонажей с естественной мимикой и движениями тела. Автор анализирует текущие возможности технологии на основе практических тестов более 20 продуктов и их применение в трех ключевых сегментах: для потребителей (создание персонажей), малого бизнеса (лидогенерация) и предприятий (масштабирование контента).

Что происходит, когда AI не просто генерирует контент, но воплощает его? AI уже освоил способность создавать реалистичные фотографии, видео и голоса, проходя визуальный и слуховой тест Тьюринга. Следующий большой скачок — в области AI-аватаров: объединение лица с голосом для создания говорящего персонажа.

Разве нельзя просто сгенерировать изображение лица, анимировать его и добавить озвучку? Не совсем. Проблема не только в точной синхронизации губ — важно, чтобы выражения лица и язык тела двигались согласованно. Было бы странно, если бы ваш рот открывался от удивления, а щеки и подбородок оставались неподвижными! И если голос звучит взволнованно, но соответствующее лицо не реагирует, иллюзия человекоподобия разрушается.

Мы начинаем видеть реальный прогресс в этой области. AI-аватары уже используются в создании контента, рекламе и корпоративных коммуникациях. Сегодняшние версии в основном ограничиваются говорящими головами — функциональными, но с ограничениями — однако за последние несколько месяцев мы увидели несколько захватывающих разработок, и явно намечается значительный прогресс.

В этой статье мы разберем, что работает сейчас, что ждет нас в будущем, и расскажем о самых впечатляющих продуктах с AI-аватарами, основываясь на моем практическом тестировании более 20 из них.

Я протестировала более 20 продуктов для создания AI-персонажей. Как человек, который годами испытывает эти инструменты, я поражена тем, что мы можем создавать сейчас.

Как эволюционировали исследования?

AI-аватары представляют собой уникально сложную исследовательскую задачу. Чтобы создать говорящее лицо, модель должна освоить реалистичное отображение фонем в виземы: связь между звуками речи (фонемами) и соответствующими движениями рта (виземами). Если это «не совпадает», рот и голос будут выглядеть несинхронно или даже полностью разъединенно.

Проблема становится еще сложнее, ведь не только рот двигается, когда вы говорите. Остальное лицо движется в согласии, вместе с верхней частью тела и иногда руками. И у каждого свой особый стиль речи. Подумайте о том, как говорите вы по сравнению с вашей любимой знаменитостью: даже если вы произносите одно и то же предложение, ваши рты будут двигаться по-разному. Если попытаться применить вашу синхронизацию губ к их лицу, это будет выглядеть странно.

За последние несколько лет эта область значительно эволюционировала с точки зрения исследований. Я изучила более 70 научных работ о говорящих головах с 2017 года и увидела четкую прогрессию в архитектуре моделей — от CNN и GAN к 3D-подходам, таким как NeRF и 3D Morphable Models, затем к трансформерам и диффузионным моделям, а совсем недавно — к DiT (диффузионным моделям на базе архитектуры трансформеров). Временная шкала ниже выделяет наиболее цитируемые работы каждого года.

Значительно улучшилось как качество генераций, так и возможности моделей. Ранние подходы были ограничены. Представьте, что вы начинаете с одной фотографии человека, маскируете нижнюю половину его лица и генерируете новые движения рта на основе целевых лицевых ориентиров из аудиовхода. Эти модели обучались на ограниченном корпусе качественных данных по синхронизации губ, большинство из которых было тесно кадрировано по лицу. Более реалистичные результаты, такие как “синхронизация губ Обамы“, требовали многих часов видео целевого человека и были очень ограничены в выходных данных.

Сегодняшние модели намного более гибкие и мощные. Они могут генерировать движения верхней части тела или даже всего тела, реалистичные говорящие лица и динамическое движение фона — всё в одном видео! Эти новые модели обучаются больше как традиционные модели преобразования текста в видео на гораздо больших наборах данных, используя различные методы для поддержания точности синхронизации губ в условиях всего этого движения.

Первым предвестником этого стала модель OmniHuman-1 от Bytedance, представленная в феврале (и недавно ставшая доступной в Dreamina). Область развивается быстро — Hedra выпустила Character-3 в марте, которая по результатам наших прямых тестов сейчас является лучшей в своем классе для большинства случаев использования. Hedra также работает с нечеловеческими персонажами, как этот говорящий Waymo, и позволяет пользователям задавать эмоции и движения через текст.

Также появляются новые варианты использования в области AI-анимации, подстегиваемые такими трендами, как движение Studio Ghibli. Приведенное ниже видео было создано из начального кадра изображения и аудиодорожки. Hedra сгенерировала синхронизацию губ персонажа и движения лица + верхней части тела. И посмотрите на движущихся персонажей на заднем плане!

Реальные задачи для AI-аватаров

Существует бесчисленное множество применений для AI-аватаров — просто представьте все различные места, где вы взаимодействуете с персонажем или смотрите видео, где кто-то говорит. Мы уже видим использование среди потребителей, малого и среднего бизнеса и даже на предприятиях.

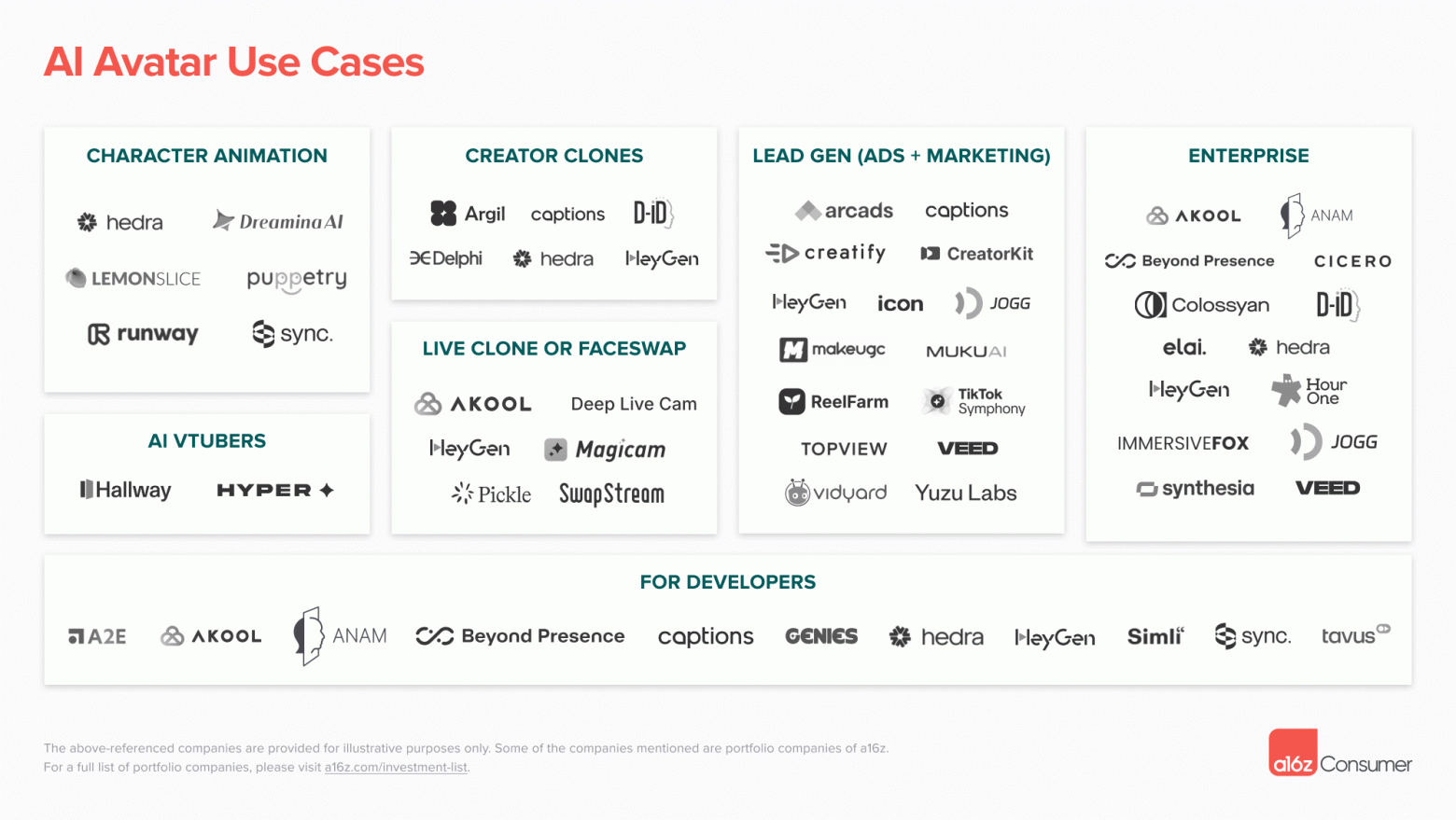

Это ранняя карта рынка. Пространство быстро развивается, и различия между продуктами относительно размыты. Многие продукты теоретически могли бы создавать аватары для большинства или всех этих вариантов использования, но на практике мы обнаружили, что сложно создать рабочий процесс и настроить модель так, чтобы она превосходно справлялась со всем. Ниже мы привели примеры того, как каждый сегмент рынка использует AI-аватары.

Потребители: Создание персонажей

Теперь любой может создавать анимированных персонажей из одного изображения, что является огромным прорывом для творчества. Трудно переоценить, насколько это важно для обычных людей, которые хотят использовать AI для рассказа историй. Одна из причин, по которой ранние AI-видео критиковали как “слайды изображений”, заключается в том, что там не было говорящих персонажей (или речь присутствовала только в форме закадрового голоса).

Когда вы можете заставить что-то говорить, ваш контент становится намного интереснее. А помимо традиционного повествовательного видео вы можете создавать такие вещи, как AI-стримеры, подкастеры и музыкальные клипы. Видео по этим ссылкам были созданы на Hedra, которая позволяет пользователям создавать динамичных, говорящих персонажей из одного начального изображения и либо аудиоклипа, либо сценария.

Если вы начинаете с видео, а не с изображения, Sync может применить синхронизацию губ, чтобы движения лица персонажа соответствовали вашему аудио. А если вы хотите использовать реальное человеческое исполнение для управления движениями вашего персонажа, такие инструменты, как Runway Act-One и Viggle, делают это возможным.

Один из моих любимых создателей, использующих AI для анимации персонажей, — Neural Viz, чей сериал “The Monoverse” представляет постчеловеческую вселенную, населенную Глуронами. Только вопрос времени, когда мы увидим всплеск AI-генерируемых шоу — или даже отдельных инфлюенсеров — теперь, когда барьер для входа стал намного ниже.

По мере того как аватары становятся легче для трансляции в реальном времени, мы также ожидаем, что компании, ориентированные на потребителей, будут внедрять их как основную часть своего пользовательского интерфейса. Представьте изучение языка с живым AI-“тренером”, который является не просто бестелесным голосом, а полноценным персонажем с лицом и индивидуальностью. Компании вроде Praktika уже делают это, и со временем это станет только естественнее.

Малый и средний бизнес: Генерация лидов

Реклама стала одним из первых успешных применений AI-аватаров. Вместо найма актеров и производственной группы предприятия теперь могут использовать гиперреалистичных AI-персонажей для продвижения своих продуктов. Компании вроде Creatify и Arcads делают этот процесс безупречным — просто предоставьте ссылку на продукт, и они сгенерируют рекламу: напишут сценарий, подберут b-roll и изображения, и “отберут” AI-актера.

Это открыло возможности для рекламы тем предприятиям, которые никогда не могли позволить себе традиционное производство рекламы. Это особенно популярно среди компаний электронной коммерции, игр и потребительских приложений. Скорее всего, вы уже видели AI-сгенерированную рекламу на YouTube или TikTok. Теперь и B2B-компании исследуют эту технологию, используя AI-аватары для контент-маркетинга или персонализированной коммуникации с помощью таких инструментов, как Yuzu Labs и Vidyard.

Многие из этих продуктов сочетают AI-актера — будь то клон реального человека или уникальный персонаж — с другими активами, такими как фотографии продуктов, видеоклипы и музыка. Пользователи могут контролировать, где появляются эти активы, или включить “автопилот” и позволить продукту самостоятельно собрать видео. Вы можете либо написать сценарий сами, либо использовать сгенерированный AI.

Предприятия: Масштабирование контента

Помимо маркетинга, предприятия находят широкий спектр применений для AI-аватаров. Несколько примеров:

Обучение и развитие. Большинство крупных компаний создают обучающие и образовательные видео для сотрудников, охватывающие всё — от адаптации до соблюдения нормативных требований, обучения работе с продуктами и развития навыков. AI-инструменты вроде Synthesia могут автоматизировать этот процесс, делая создание контента быстрее и масштабируемее. Некоторые роли также требуют текущего, основанного на видео обучения — представьте продавца, практикующего свои навыки переговоров с AI-аватаром из продукта вроде Anam.

Локализация. Если у компании есть клиенты или сотрудники в разных странах, она может захотеть локализовать контент на разные языки или заменить культурные отсылки. AI-актеры делают быстрым и простым персонализацию видео для разных географических регионов. Благодаря AI-переводу голоса от таких компаний, как ElevenLabs, предприятия могут генерировать одно и то же видео на десятках языков с естественно звучащими голосами.

Присутствие руководства. AI-аватары позволяют руководителям масштабировать свое присутствие, клонируя их персону для создания персонализированного контента для сотрудников или клиентов. Вместо съемки каждого анонса продукта или сообщения “благодарим вас”, компании могут генерировать реалистичный AI-двойник своего генерального директора или руководителя продукта. Мы также видим, как компании вроде Delphi и Cicero облегчают лидерам мнений взаимодействие и ответы на вопросы людей, с которыми они никогда не смогли бы встретиться лично.

Из чего состоят AI-аватары?

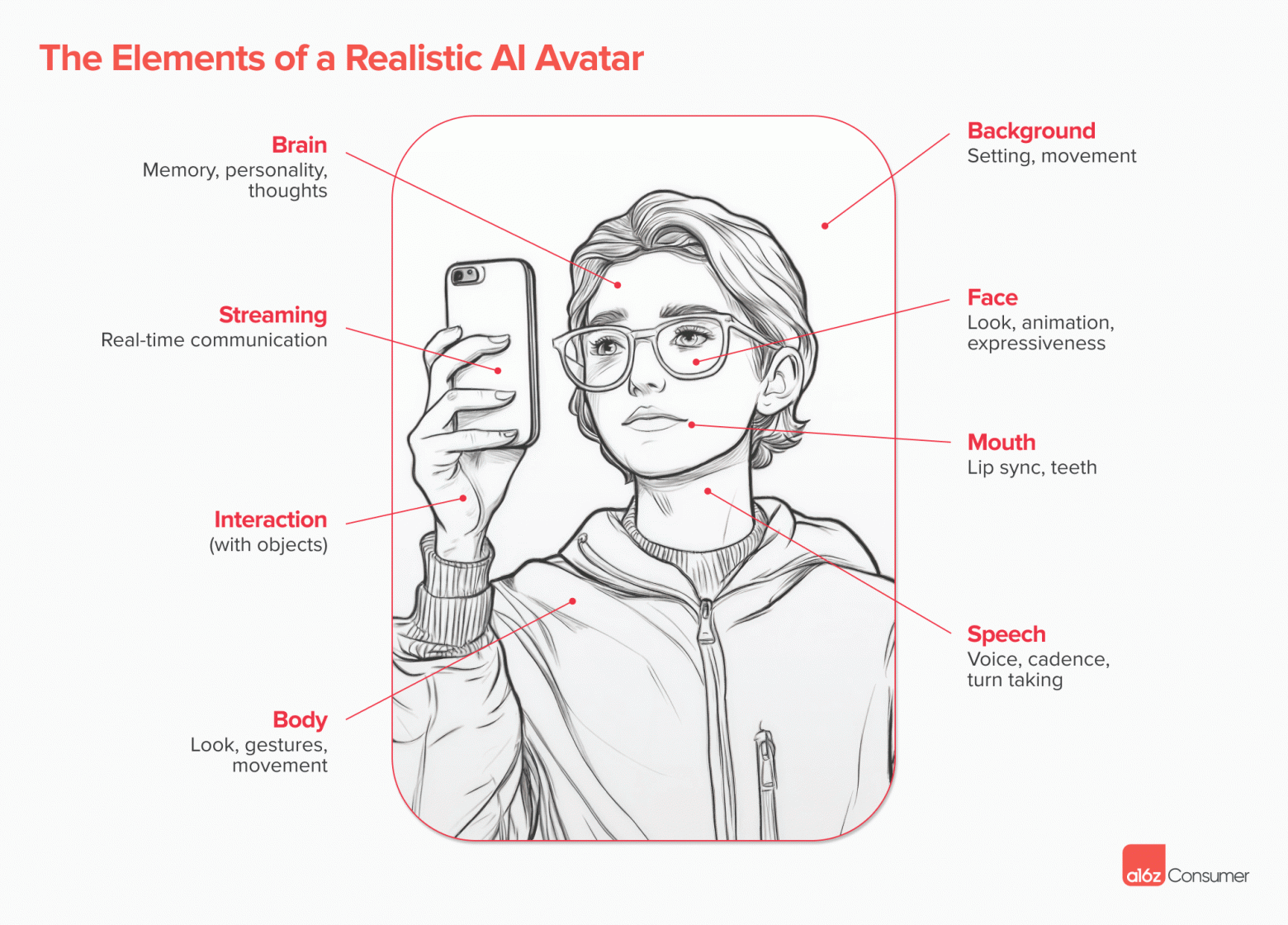

Создание правдоподобного AI-аватара — это вызов, где каждый элемент реализма представляет свои технические трудности. Речь идет не только об избегании зловещей долины, но и о решении фундаментальных проблем в анимации, синтезе речи и рендеринге в реальном времени. Вот разбор того, что требуется, почему это так сложно сделать правильно и где мы видим прогресс:

-

Лицо – Независимо от того, клонируете ли вы человека или создаете нового персонажа, вам нужно лицо, которое остается последовательным между кадрами и реалистично движется во время разговора. Контекстно-зависимая выразительность остается проблемой (например, аватар зевает, говоря “Я устал”).

-

Голос – Голос должен звучать реалистично и соответствовать персонажу; лицо девочки-подростка не должно иметь голос женщины постарше. Большинство компаний, создающих AI-аватары, с которыми мы встречались, используют ElevenLabs, которая имеет обширную библиотеку голосов и позволяет клонировать свой собственный.

-

Синхронизация губ – Получение качественной синхронизации губ — непростая задача. Целые компании, такие как Sync, посвящены решению этой проблемы. Другие модели, такие как MoCha (от Meta) и OmniHuman, обучаются на более крупных наборах данных и используют различные методы для сильного обусловливания генерации лица сопровождающим аудио.

-

Тело – Ваш аватар не может быть просто плавающей головой! Новые модели позволяют создавать аватары с полным телом, которое может двигаться, но мы все еще находимся на раннем этапе как с точки зрения их масштабирования, так и предоставления пользователям.

-

Фон – Аватары не существуют в вакууме. Освещение, глубина и взаимодействия в окружающей среде должны соответствовать сцене. В идеале аватары даже смогут прикасаться к предметам в своем окружении и взаимодействовать с ними, например, брать в руки продукт.

Если вы хотите, чтобы ваш аватар участвовал в разговорах в реальном времени — например, присоединялся к встрече в Zoom — вам нужно добавить еще несколько вещей:

-

Мозг – Ваш аватар должен уметь “думать”. Продукты, которые сегодня позволяют вести разговор, обычно дают возможность загружать или подключаться к базе знаний. В будущем более сложные версии, будем надеяться, будут включать больше памяти и индивидуальности. Аватары должны уметь запоминать прошлые разговоры с вами и иметь собственный “стиль”.

-

Потоковая передача – Непросто транслировать все это с минимальной задержкой. Такие продукты, как LiveKit и Agora, добиваются прогресса в этой области, но сложно заставить все эти модели работать, минимизируя задержки. Мы видели несколько продуктов, которые делают это хорошо — например, Tolan, AI-инопланетный компаньон с голосом и лицом — но предстоит еще много работы.

Что бы мы хотели увидеть?

В этой области еще так много всего нужно построить и улучшить. Вот несколько областей, которые у нас на первом плане:

Постоянство персонажа и трансформация

Исторически каждый AI-аватар имел один фиксированный “вид”. Их наряд, поза и окружение были статичными. Некоторые продукты начинают предлагать больше вариантов. Например, у этого персонажа из HeyGen, Рауля, 20 разных образов! Но было бы здорово иметь возможность легче трансформировать персонажа так, как вы хотите.

Лучшее движение лица и выразительность

Лица долгое время были слабым звеном AI-аватаров, часто выглядя роботизированными. Это начинает меняться с такими продуктами, как новый Mirage от Captions, который обеспечивает более естественный вид и более широкий диапазон выражений. Нам бы хотелось увидеть AI-аватары, которые понимают эмоциональный контекст сценария и реагируют соответственно, например, выглядят испуганными, если персонаж убегает от монстра.

Движение тела

Сегодня у подавляющего большинства аватаров мало движений ниже лица — даже таких базовых, как жесты руками. Управление жестами было довольно программным: например, Argil позволяет выбирать различные типы языка тела для каждого сегмента вашего видео. Мы с нетерпением ждем более естественного, выводимого движения в будущем.

Взаимодействие с “реальным миром”

Сейчас AI-аватары не могут взаимодействовать с окружающей средой. Достижимой ближайшей целью может быть возможность держать продукты в рекламе. Topview уже добился прогресса (посмотрите видео ниже, чтобы увидеть их процесс и результат), и мы с нетерпением ждем, что будет дальше по мере совершенствования моделей.

Больше приложений в реальном времени

Вот несколько потенциальных вариантов использования: видеозвонок с AI-врачом, просмотр подобранных продуктов с AI-помощником по продажам или FaceTime с персонажем из вашего любимого телешоу. Задержка и надежность еще не совсем на человеческом уровне, но они приближаются к нему. Посмотрите демонстрацию моего разговора с последней моделью Tavus.

Куда мы движемся?

Один из наших главных уроков от инвестирования как в компании, создающие фундаментальные модели, так и в AI-приложения за последние несколько лет? Почти невозможно предсказать с какой-либо степенью уверенности, куда движется определенная область. Однако, кажется безопасным сказать, что прикладной уровень готов к быстрому росту теперь, когда базовое качество моделей наконец кажется достаточно хорошим для создания AI-говорящих голов, которые не мучительно смотреть.

Мы ожидаем, что в этой области появится несколько компаний стоимостью в миллиарды долларов, с продуктами, сегментированными по вариантам использования и целевым клиентам. Например, руководителю, ищущему AI-клона для съемки видео для клиентов, потребуется (и он будет готов заплатить) более высокий уровень качества и реализма, чем фанату, делающему быстрый клип своего любимого аниме-персонажа для отправки друзьям.

Рабочий процесс также важен. Если вы генерируете рекламу с AI-инфлюенсерами, вы захотите использовать платформу, которая может автоматически импортировать детали продукта, писать сценарии, добавлять b-roll и фотографии продуктов, отправлять видео в ваши социальные каналы и измерять результаты. С другой стороны, если вы пытаетесь рассказать историю, используя AI-персонажей, вы отдадите приоритет инструментам, которые позволяют сохранять и повторно использовать персонажей и сцены, а также легко соединять разные типы клипов.

Автор: Kual