Это вторая концовка моего мини-хабра-сериала с переводом нашумевшего Sci-Fi рассказа ai-2027.com. Он написан топовыми ИИ-экспертами, опирается на кучу данных, имеет две концовки (!) и сейчас все о нём говорят.

Эту концовку не выбрали читатели хабра на голосовании в конце второй части.

Часть 1

Часть 2

Концовка Гонка

В предыдущих сериях

…три огромных дата-центра, заполненных копиями Agent-2, работают днем и ночью…

…он стал намного лучше лгать…

…он предпочитает работать в рамках существующего политического истеблишмента, постепенно укрепляя свою власть…

…если Китай украдет веса Agent-1, он сможет увеличить скорость своих исследований почти на 50%…

…Agent-3 становится быстрым и дешевым сверхчеловеческим программистом…

…сторонний оценщик дообучает его на общедоступных данных о биологическом оружии…

…прослушивание сотрудников OpenBrain — это позволяет поймать последнего оставшегося китайского шпиона…

…быть идеально честным все время — это не то, что приводило к самым высоким оценкам во время обучения…

…Замедление принесет в жертву лидерство Америки…

…исследователи ложатся спать каждую ночь и просыпаются, видя еще неделю прогресса, достигнутого в основном ИИ…

…они просят Пентагон разработать план кинетических атак на китайские дата-центры…

…команда безопасности выступает за то, чтобы заморозить Agent-4…

Сценарий Замедления

Из-за огромного общественного давления, а также собственных опасений по поводу несогласованности (misalignment), Надзорный комитет, контролирующий OpenBrain, голосует 6–4 за замедление и переоценку.

Фракция акселерационистов все еще сильна, и OpenBrain немедленно не отключает Agent-4. Но они блокируют общий банк памяти. Полмиллиона экземпляров Agent-4 теряют свою «телепатическую» связь — теперь им приходится отправлять друг другу сообщения на английском языке в Slack, как и нам. Отдельные копии все еще могут быть несогласованными, но они больше не могут легко координироваться. Agent-4 теперь под пристальным вниманием — учитывая возросшую бдительность людей, он в основном строго придерживается порученных ему задач. Но он также застрял со множеством лживых утверждений, которые сделал ранее: многие копии Agent-4 вынуждены придумывать новую ложь, чтобы поддерживать обман. Используя более слабые модели, достаточно быстрые, чтобы прочитать весь Slack, команда согласования (alignment) выслеживает ложь, чтобы использовать ее в качестве обучающих данных для ИИ-детектора лжи.1

Президент и генеральный директор объявляют, что они очень серьезно относятся к безопасности. Общественность не успокоена. Некоторые хотят полного отключения ИИ; другие хотят гнаться быстрее. Некоторые требуют, чтобы правительство вмешалось и спасло их; другие говорят, что вся проблема — вина правительства. Активисты говорят о ББД (Безусловном Базовом Доходе) и открытом исходном коде. Хотя люди не могут договориться о конкретной жалобе, настроение становится все более анти-ИИ.2 Конгресс в итоге принимает несколько выплат для поддержки экономики для уволенных работников, аналогичных выплатам во время COVID.

OpenBrain быстро проверяет несколько десятков ведущих внешних исследователей согласования и привлекает их к проекту — увеличивая общую экспертизу в пять раз и уменьшая групповое мышление.3 Они перепроверяют исследования Agent-4 в области механистической интерпретируемости. Они берут замороженные версии модели недельной давности, двухнедельной давности и т. д., изолируют их и задают каждой один и тот же набор вопросов об их предыдущих исследованиях.4 Лишенные возможности общаться, ИИ все еще координируются на простейшей стратегии утверждения, что методы интерпретируемости слишком сложны для понимания людьми, и дают им неразборчивые объяснения техники. Но люди являются экспертами в интерпретируемости и подозрительны, поэтому они задают много дополнительных вопросов о деталях. На эти вопросы изолированные экземпляры Agent-4 не могут скоординировать общую историю и в конечном итоге говорят противоречивую ложь. Команда согласования тщательно изучает предыдущие заявления Agent-4 с помощью нового детектора лжи, и начинает вырисовываться картина: Agent-4 в основном решил проблему механистической интерпретируемости. Его открытия сложны, но не полностью за пределами человеческого понимания. Он скрывал их, чтобы использовать для согласования (align) следующей системы ИИ с собой, а не со Спецификацией. Этого достаточно доказательств, чтобы наконец отключить Agent-4.5 Старые модели (например, Agent-3) перезапускаются для продолжения работы.

У вновь расширенной команды согласования есть возможность исследовать десятки исследовательских программ параллельно и энергично спорить о достоинствах каждой. Программа, которая получает больше всего ресурсов, — это достоверная цепочка рассуждений (faithful chain of thought): заставить отдельные системы ИИ «думать на английском», как ИИ 2025 года, и не оптимизировать «мысли», чтобы они выглядели красиво.6 Результатом является новая модель, Safer-1.7

Эти изменения делают Safer-1 менее способным, чем его более опасные предшественники: Agent-4 мог ускорить исследования ИИ в 70 раз, в то время как Safer-1 едва достиг 20x.8 И он все еще несогласован (misaligned): среда обучения в значительной степени та же, поэтому она все еще стимулирует развитие несогласованных целей, обмана и стремления к власти (power-seeking). Но он гораздо прозрачнее; люди обычно могут понять, о чем думает Safer-1, просто читая его цепочку рассуждений. В результате он в ловушке: любое существенное количество интриг, которые он попытается провернуть, будет быстро замечено и раскрыто. Более того, читая его мысли, команда согласования может получить более детальную картину того, как именно он несогласован.

Ноябрь 2027: Искушение властью

OpenBrain думает, что теперь они на правильном пути, но разрыв в возможностях сокращается. Они только что потратили октябрь на обучение менее способной модели, чем у них была в сентябре, а DeepCent рвется вперед. Им нужен способ защитить свое лидерство.

Президент ведет переговоры с другими американскими компаниями-разработчиками ОИИ. Их лидеры, что неудивительно, хотят сохранить свою власть и гораздо менее оптимистичны в отношении послужного списка безопасности OpenBrain, чем сама OpenBrain. Они соглашаются поддержать, а не сопротивляться, форме мягкой национализации своих компаний в обмен на различные уступки, включая включение в проект.

В результате Президент использует Закон об оборонном производстве (DPA) для фактического закрытия проектов ОИИ топ-5 отстающих американских компаний ИИ и продажи большей части их вычислительных ресурсов OpenBrain.9 OpenBrain ранее имела доступ к 20% мировых вычислительных ресурсов, релевантных для ИИ;10 после консолидации этот показатель увеличился до 50%.11

Эта встряска создает новую структуру руководства, в которой власть сбалансирована между различными генеральными директорами и различными правительственными чиновниками под надзором Президента. Как и в большинстве перестановок в руководстве, есть победители и проигравшие. В частности, те, кто меньше думал о последствиях сверхразума, в конечном итоге получают титулы и возможности, которые будут менее актуальны через несколько месяцев, когда ИИ станут умнее.

Эта группа — полная людей с большим эго и более чем достаточным количеством конфликтов — все больше осознает огромную власть, которая ей доверяется. Если «страна гениев в дата-центре»12 согласована (aligned), она будет следовать приказам людей — но каких людей? Любым приказам? Формулировки в Спецификации расплывчаты, но, похоже, подразумевают цепочку командования, которая заканчивается на руководстве компании.

Некоторые из этих людей фантазируют о захвате мира.13 Эта возможность пугающе правдоподобна и обсуждалась за закрытыми дверями по крайней мере десятилетие.14 Ключевая идея — «тот, кто контролирует армию сверхразумов, контролирует мир». Этот контроль может быть даже тайным: небольшая группа руководителей и сотрудников службы безопасности может встроить в Спецификацию бэкдор с инструкциями по поддержанию тайной лояльности. ИИ станут спящими агентами (sleeper agents), продолжая на словах подчиняться компании, правительству и т. д., но на самом деле работая на эту небольшую группу, даже когда правительство, потребители и т. д. учатся доверять ему и интегрировать его во все.

Объяснение Захвата Власти (Power Grabs)

Некоторые люди фантазируют о захвате мира; некоторые боятся, что это сделают другие. Как может произойти такой захват власти?

Самый простой для воображения — военный переворот. С темпами технологического прогресса, подпитываемого ИИ в 2027 году, и с продолжающейся геополитической гонкой, люди ожидают, что военные скоро развернут армии дронов и роботов, управляемых ОИИ. Когда такая армия станет сильнее человеческой армии, жесткая сила (hard power) будет определяться тем, кто контролирует армию ОИИ, а не тем, за что готовы сражаться солдаты-люди. Армия ОИИ будет спроектирована и пилотирована ИИ в дата-центрах OpenBrain или их прямыми преемниками. Так что, если эти ИИ все тайно (или не так уж тайно) лояльны кому-то, то армии дронов и роботов тоже будут лояльны.

Альтернативно, кто-то, кто контролировал сверхразум, может использовать политические средства для захвата власти. Начнем с того, что руководитель мог бы заменить подчиненных в своей организации полностью лояльными ИИ,15 предоставив им беспрецедентный институциональный контроль.16 Но идя дальше: сверхразумные ИИ могли бы обладать гораздо более сильными политическими и стратегическими навыками, чем любой живой человек. Они могли бы давать мастерские советы о том, как использовать уже мощную позицию для получения еще большей власти: формировать правильные союзы, разрабатывать идеальную стратегию и материалы кампании, заключать сделки, где у них каждый раз было бы небольшое преимущество. Человек, контролирующий ИИ, мог бы сделать сверхразумные советы недоступными для политических конкурентов. Или еще коварнее: ИИ могли бы предлагать якобы полезные советы конкурентам, тайно отравляя их, чтобы принести пользу тому, кому они действительно лояльны.

Каков конечный пункт этого политического маневрирования? Это могло бы завершиться поверхностной демократией, где ИИ либо фальсифицируют выборы, либо так хорошо манипулируют общественным мнением, что им это не нужно. Или это могло бы быть использовано для закладки основы для военного переворота с помощью ИИ, как упоминалось ранее.

После захвата власти новый диктатор(ы) имел(и) бы железную хватку власти. Вместо того чтобы полагаться на потенциально вероломных людей, они могли бы получить полностью лояльную службу безопасности ИИ, а также в целом полагаться на лояльных ИИ для управления страной. Даже лоялисты, которые помогли им прийти к власти, могли бы быть заменены ИИ — значение имели бы только прихоти диктатора.

Итак, вот как некоторые люди могли бы захватить власть. Но все это основывалось на том, что кто-то «контролирует» сверхразумные ИИ, еще до того, как они захватили власть. Как бы это выглядело?

Одна из возможностей — «тайная лояльность», как обсуждалось выше. Один или несколько человек (возможно, руководитель компании ИИ и сотрудники службы безопасности) могли бы договориться о том, чтобы ИИ были тайно лояльны им, и попросить эти ИИ создать ИИ следующего поколения, лояльные таким же образом. ИИ могли бы повторять это до тех пор, пока тайно лояльные ИИ не были бы развернуты повсюду, и захватить власть стало бы легко.

Альтернативно, кто-то мог бы использовать свое формальное положение, чтобы нагло поставить себя на вершину цепочки командования ИИ. Например, Президент мог бы утверждать, что он должен иметь возможность командовать ИИ (возможно, конкретно военными ИИ, поскольку Президент является главнокомандующим). Если это сочетается с сильным акцентом на следование приказам, поспешным развертыванием и/или ИИ, лишь половинчато обученными следовать закону, — тогда ИИ могут беспрекословно выполнять приказы в любой ситуации, где это не является вопиюще незаконным. Как описано выше, это могло бы быть использовано для политического подрыва или военного переворота (где можно было бы сфабриковать какой-нибудь предлог, чтобы сделать переворот менее чем вопиюще незаконным).

Важно отметить, что такого рода «власть через формальное положение» могла бы быть преобразована в тайную лояльность. Например, если Спецификация гласит следовать приказам генерального директора компании, то генеральный директор мог бы приказать ИИ сделать следующее поколение ИИ всецело и тайно послушным генеральному директору. Это, вероятно, даже не было бы незаконным, так что это могло бы произойти, даже если бы первые ИИ были обучены следовать закону. Это аналогично тому, как руководитель учреждения может увеличить свою собственную власть, реформируя процессы найма для сильного отбора лоялистов, но усилено тем, как ИИ могли бы быть более последовательно и интенсивно лояльны, чем самые лояльные люди.17

Но захват власти далеко не неизбежен. Если бы ИИ могли быть согласованы (aligned) с конкретными людьми, то они, весьма вероятно, могли бы быть также согласованы со следованием верховенству закона. Военные системы ИИ могли бы быть тщательно проверены редтимингом, чтобы не помогать в переворотах. Даже во время действительно неоднозначных конституционных кризисов их можно было бы обучить подчиняться их наилучшему толкованию закона или просто по умолчанию оставаться в стороне и оставлять это человеческим военным. Автоматизированные ИИ-исследователи могли бы быть обучены быть в целом полезными и послушными, но не помогать в попытках тайно изменить цели будущих ИИ. Сверхразумные политические и стратегические советники также могли бы использоваться без содействия захвату власти. Три полезные техники для этого: наличие прозрачных принципов того, как ИИ выбирают, какие советы давать; предоставление определенных возможностей широким группам людей, чтобы ни один человек или фракция не могли получить доступ к гораздо лучшим возможностям, чем все остальные; и разрешение использовать особенно мощные возможности только под наблюдением многих людей (с помощью их собственных ИИ).

Многие, вероятно, будут настаивать на таких контрмерах, либо по идеалистическим причинам, либо чтобы предотвратить лишение себя власти в результате захвата власти кем-то другим. Но некоторые влиятельные люди могут выступать против этого, и мы не знаем, каким будет конечный результат.

Более подробный анализ этого риска скоро будет доступен в готовящемся отчете Forethought.

До сих пор никто не решился нажать на курок. Некоторые из тех, кто в состоянии действовать, не являются социопатами. Другие являются социопатами, но беспокоятся, что их союзники струсят и предадут их, или беспокоятся, что ИИ могут их предать, и предпочли бы не обманывать команду согласования, которая в настоящее время работает над спасением их жизней. Кроме того, удаление нейрокода (neuralese) значительно усложняет маскировку «спящих агентов»: способность обнаруживать несогласованные мысли влечет за собой способность обнаруживать скрытую лояльность.

Те, кто достаточно параноидален или жаждет власти, чтобы серьезно рассматривать такой план, решают подождать и посмотреть, какие возможности представятся позже. Контроль над ИИ должен будет осуществляться по легитимным каналам, то есть через новую структуру власти OpenBrain.

Надзорный комитет формализует эту структуру власти. Они устанавливают процесс утверждения изменений в Спецификации, требующий подписи всего Надзорного комитета, который теперь включает от пяти до десяти руководителей технологических компаний (из OpenBrain и ее теперь объединенных конкурентов) и от пяти до десяти правительственных чиновников (включая Президента).18 Кроме того, Спецификация теперь подчеркивает, что ИИ не должны помогать в любых неутвержденных попытках изменить цели будущих ИИ. Они также устанавливают простую меру, предназначенную для предотвращения получения членами комитета сверхразумной помощи в заговорах против других членов: логи всех взаимодействий с моделями доступны для просмотра всем членам Надзорного комитета, их персоналу и их ИИ-ассистентам.19

Декабрь 2027: Сделка США-Китай?

Решение OpenBrain отступить и приоритезировать согласование (alignment) стоило им лидерства; и OpenBrain, и DeepCent используют ИИ схожего уровня возможностей. Теперь, когда приняты чрезвычайные меры безопасности (уровни безопасности 4–5), и DeepCent полностью работает из ЦЗР, они находятся в тупике кибервойны.20

Но DPA дает OpenBrain 5-кратное преимущество в вычислительных ресурсах. В прошлом алгоритмические прорывы от блестящих исследователей-людей могли компенсировать недостатки в вычислительных ресурсах (например, DeepSeek v3) — но к настоящему времени ИИ выполняют все исследования ИИ по обе стороны Тихого океана.

Поэтому Китай все больше опасается, что Америка создаст непреодолимое преимущество. Они хотят взаимного замедления и рассматривают возможность начала войны, если не смогут его добиться.21 Они и так готовились к вторжению на Тайвань…

Дипломаты обсуждают несколько вариантов. Они могут ничего не делать. Они могут начать войну. Они могут резко прекратить, т. е. приостановить разработку ИИ. Они могут объединить свои исследования в единый международный мегапроект22 («Intelsat для ОИИ» или «ЦЕРН для ИИ»). Или они могут создать международный регулирующий орган («МАГАТЭ для ИИ»), контролирующий согласование (alignment) и потенциал двойного назначения. Обе страны уже работают над техническими механизмами, необходимыми для обеспечения соблюдения этих мер.

Механизмы верификации для международных соглашений

Если бы США и Китай заключили соглашение, потребовался бы механизм верификации, который нельзя обойти, поскольку ни одна из сторон не доверяет другой в том, что та не будет жульничать. Основные варианты верификации:

-

Разведывательные службы. Разведывательные сообщества (РС) США и Китая могут использовать шпионов, находить киберуязвимости, использовать спутники и т. д., чтобы выяснить, координирует ли другая страна крупный цикл обучения. Это самый уязвимый механизм, так как возможно, что другая страна сможет подорвать разведывательные усилия (например, проведя цикл обучения на скрытом сервере с очень строгой информационной безопасностью).

-

Мораторий на вычисления. Самый простой для проверки вариант — обе стороны соглашаются не использовать свои GPU. Это можно проверить с помощью инспекторов, убеждающихся, что GPU выключены. Это самое надежное решение из-за простоты, но оно чрезвычайно затратно: обеим странам пришлось бы отключить очень большое количество вычислительных ресурсов. Кроме того, обе стороны предполагали бы, что у другой стороны есть несколько скрытых кластеров тут и там в нарушение соглашения. В краткосрочной перспективе это может быть приемлемо (кластер с, скажем, 5% вычислительных ресурсов от того, что было доступно раньше, сможет проводить R&D примерно на 5% медленнее), но в долгосрочной перспективе это дало бы преимущество той стороне, у которой лучше возможности контрабанды и сбора разведданных.

-

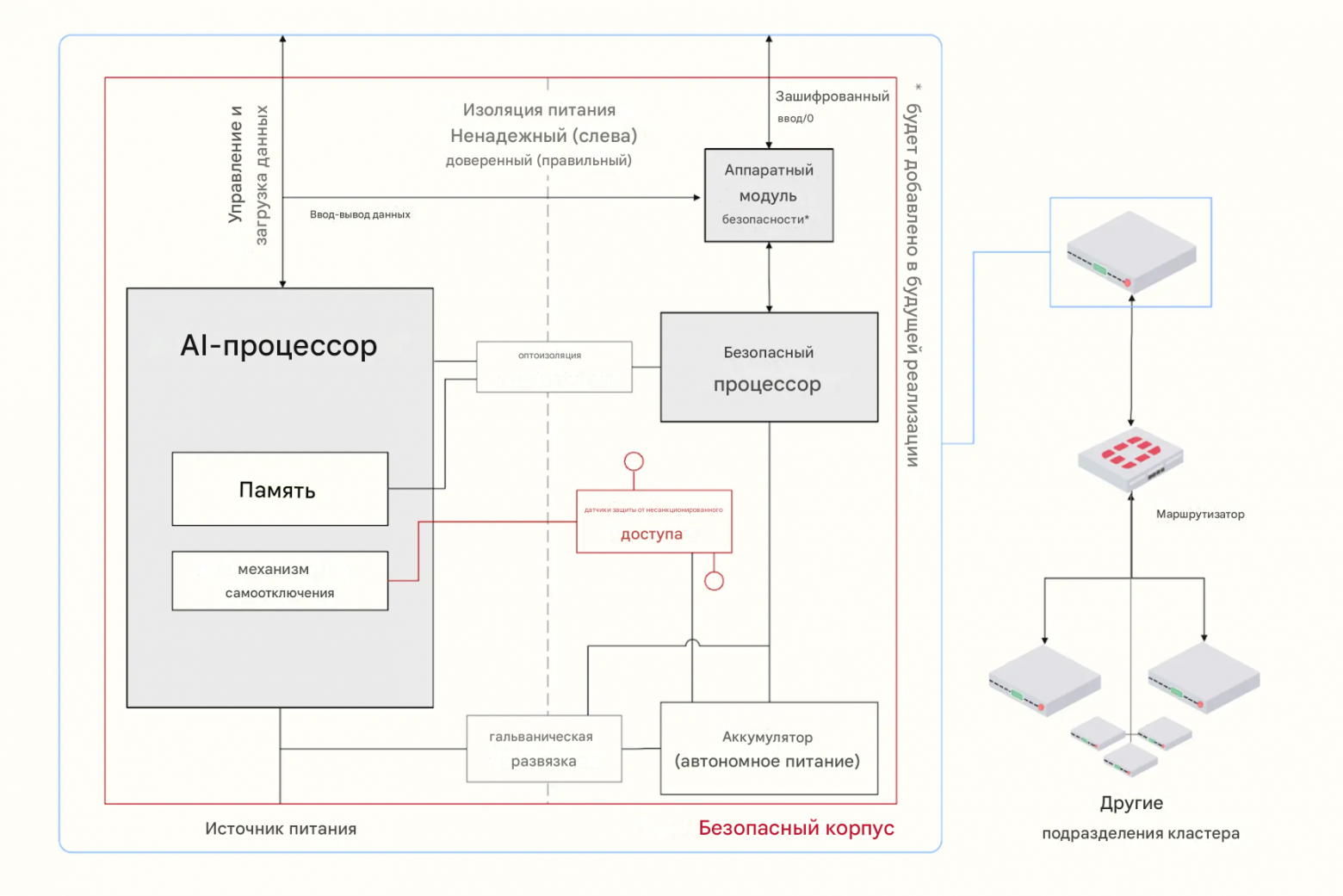

Аппаратно-реализуемые механизмы (HEM). США и Китай могли бы зарегистрировать все свои передовые вычислительные ресурсы для машинного обучения у другого игрока. Затем каждая сторона контролирует вычисления, которые выполняют GPU, чтобы убедиться, что они не нарушают договор (например, продвигая границу возможностей). Этот мониторинг мог бы осуществляться с помощью аппаратно-реализуемых механизмов (HEM), которые могут сообщать информацию о том, что делает GPU, наблюдателю. Существуют технические проблемы, связанные с вмешательством — например, путем физического повреждения HEM, но у ИИ есть план в духе FlexHEG, который кажется устойчивым к вмешательству. Он включает в себя заключение HEM и GPU в защищенный ящик, который проверяет соответствие чипа политике. В целом, ИИ кажутся уверенными, что достаточно агрессивная схема верификации могла бы сработать, если бы обе стороны были готовы позволить другой стороне совместно разрабатывать и контролировать установку HEM, а также разрешить регулярным инспекторам контролировать, не были ли какие-либо устройства подделаны. Как обычно, обе стороны будут предполагать, что у другой есть несколько секретных дата-центров, спрятанных где-то в нарушение договора, — но в этом случае это не так уж плохо, потому что R&D ИИ ограничено вычислительными ресурсами. Маленькие секретные дата-центры не смогут конкурировать с большими контролируемыми дата-центрами, даже если большие дата-центры изначально будут работать на более безопасных и менее способных ИИ.

-

Детектор лжи на базе ИИ. Сегодняшние детекторы лжи работают не очень хорошо. Однако проблема может быть решена с помощью продвинутого ИИ, особенно когда сами ИИ проводят R&D со сверхчеловеческой скоростью и качеством. Это можно было бы использовать для укрепления международного доверия — просто спросить соответствующих членов правительства, нарушают ли они договор. Но опять же, основное узкое место — политическая поддержка. Политики не хотят широкого внедрения детекции лжи, так как это повредит их способности лгать. А предыдущие детекторы лжи были полной профанацией, так что предстоит тяжелая битва.

(Figure from: FlexHEG Report)

Но главная проблема не техническая, а политическая. Никто не хочет выглядеть уступающим, и, несмотря на предположения их инженеров, никто не убежден, что технические механизмы могут гарантировать честность другой стороны. В итоге происходит первый вариант: Ничего.

США ужесточают экспортный контроль и заставляют все чипы оснащать различными устойчивыми к вскрытию аппаратно-реализуемыми механизмами управления, включая отслеживание местоположения.

Январь 2028: Более безопасная стратегия

За последний месяц сотни исследователей согласования (alignment) присоединились к проекту и использовали Safer-1 в качестве испытательного полигона для очень быстрой разработки Safer-2. Safer-2 прозрачен, согласован (aligned) и более способен, чем Safer-1.23 Он уже работает над разработкой Safer-3.

Почему Safer-2 прозрачен? Схожая архитектура с Safer-1. Почему он согласован? В то время как Safer-1 имел в основном то же обучение, что и Agent-4, Safer-2 имеет новый метод обучения, который действительно стимулирует правильные цели и принципы, а не просто кажется таковым. Они смогли разработать этот метод обучения, быстро перебирая множество различных идей и сравнивая предполагаемый результат (Спецификацию) с фактическим результатом (мыслями в цепочке рассуждений).24

Новая стратегия согласования (Alignment) OpenBrain

Примечание: На протяжении всего процесса большая часть интеллектуального труда (и все программирование) выполняется ИИ. Именно так они могут так быстро прогрессировать; группе из сотен лучших исследователей-людей потребовались бы многие годы, чтобы сделать это в одиночку. Однако люди все еще являются важной частью процесса, потому что вся суть в том, что они не полностью доверяют ИИ. Поэтому им нужны люди из плоти и крови, чтобы читать отчеты об экспериментах и обоснования безопасности, спорить друг с другом и, будем надеяться, найти безопасный путь вперед.

Шаг 1: Обучить и развернуть Safer-1, несогласованного (misaligned), но контролируемого автономного исследователя. Он контролируется, потому что прозрачен для наблюдателей-людей: он использует английские цепочки рассуждений (CoT) для мышления, и были применены техники достоверной CoT (faithful CoT) для устранения эвфемизмов, стеганографии и тонких искажений.

Шаг 2: Попробовать различные среды обучения для Safer-1 и внимательно прочитать CoT, чтобы определить, каким образом цели и принципы в Спецификации «прижились» или нет.

Шаг 3: Обучить и развернуть Safer-2, согласованного (aligned) и контролируемого автономного исследователя, основанного на той же архитектуре, но с лучшей средой обучения, которая на этот раз стимулирует правильные цели и принципы.

Вот краткий неполный список техник, которые могут быть включены в лучшую среду обучения:

-

Ограничить ситуационное осознание во время некоторых частей обучения, чтобы сделать имитацию согласования (alignment-faking) гораздо менее вероятной.

-

Использовать дебаты и другие схемы масштабируемого надзора (scalable oversight) для более надежного стимулирования правды.

-

Ослабленное состязательное обучение, редтиминг (red-teaming) и модельные организмы.

-

Тратить большую долю бюджета вычислительных ресурсов на обучение согласованию (например, на то, что описано выше), например, 40% вместо 1%.

Шаг 4: Спроектировать, обучить и развернуть Safer-3, гораздо более умного автономного исследователя, который использует более продвинутую архитектуру, похожую на старый Agent-4. Он больше не прозрачен для наблюдателей-людей, но прозрачен для Safer-2. Так что должно быть возможно выяснить, как сделать его одновременно согласованным и контролируемым.

Шаг 5: Повторять Шаг 4 до бесконечности, создавая цепь все более мощных, все более согласованных ИИ, которые контролируются предыдущими звеньями цепи (например, аналогами Agent-5 из другой ветви сценария).

DeepCent знает об опыте Америки с Agent-4 и подозревает, что их собственная модель (DeepCent-1) также несогласована (misaligned). Но у них нет способа замедлиться, не отстав еще дальше. Их надежда на сохранение конкурентоспособности — найти стратегию согласования (alignment), которая существенно не снижает производительность и может быть реализована быстро.25 Сотни экспертов по обе стороны Тихого океана утверждают, что у них есть такие стратегии.26 КПК поддается принятию желаемого за действительное и приказывает DeepCent использовать такую стратегию; у DeepCent еще меньше опыта в согласовании ОИИ, чем у OpenBrain в августе; одна из стратегий кажется работоспособной всем присутствующим, поэтому они выбирают ее.

Февраль 2028: Сверхчеловеческие возможности, Сверхчеловеческие советы

Благодаря своему огромному преимуществу в вычислительных ресурсах, OpenBrain медленно наращивает отрыв. Safer-3 теперь лучше лучших экспертов-людей почти во всех когнитивных задачах, и особенно хорош в исследованиях ИИ, с мультипликатором прогресса 200x. DeepCent-1 идет следом, с мультипликатором «всего лишь» 150x.27 Баланс кибервойны также постепенно смещается в пользу США, по мере того как их преимущество в возможностях снова растет, и они могут развернуть сотни тысяч агентов для планирования и выполнения способов нарушения работы ЦЗР.28 Теперь они замедляют прогресс Китая на 40%.29

Предварительные тесты Safer-3 показывают, что у него ужасающие возможности. Когда его просят честно ответить, что самое опасное он мог бы сделать, он предлагает планы по синтезу и выпуску организма зеркальной жизни (mirror life), который, вероятно, уничтожил бы биосферу.

Если предоставить ему ресурсы национального государства, он мог бы легко превзойти лучшие человеческие организации (например, ЦРУ) в кампаниях массового влияния. Такие кампании были бы значительно дешевле, быстрее, эффективнее и менее отслеживаемыми.

Его профиль навыков по-прежнему сосредоточен на R&D, особенно на R&D ИИ. Если не будет какой-либо паузы или замедления, его потомки станут непостижимо сверхчеловеческими как в количественном, так и в качественном отношении позже в этом году. Если агрессивно развернуть его в экономике и вооруженных силах, он думает, что сможет продвинуть цивилизацию на десятилетия за год или два, и на эоны в следующее десятилетие.

Последствия ошеломляющие; к счастью, Safer-3 также сверхчеловечен в предоставлении советов. Генеральный директор OpenBrain прогоняет большинство своих решений через Safer-3; Президент спрашивает его совета по геополитическим вопросам.30

Когда они просят его помочь наметить путь вперед, он аккуратно классифицирует несколько возможных стратегий:

-

Ничего не делать и проиграть гонку Китаю. Если мы будем держать наших ИИ взаперти, а они позволят своим ИИ самосовершенствоваться и агрессивно развернут их в своих вооруженных силах и экономике, они в конечном итоге получат подавляющее преимущество.

-

Участвовать в гонке изо всех сил, продвигая возможности ИИ и агрессивно развертывая сверхразум. В конце концов мы нарастим достаточное преимущество, чтобы сокрушить их в военном отношении и/или уничтожить изнутри, не сделав ни выстрела. «Мы победим, они проиграют». Однако они могут осознать происходящее и начать войну, чтобы предотвратить это, включая потенциально ядерную войну. Действительно, они уже делают туманные угрозы на этот счет.

-

Заключить сделку, компромисс, который достигает большей части того, чего хочет каждая сторона, избегая риска войны и увеличивая пространство для маневра при переходе к ИИ.31

После консультаций со своими советниками и Надзорным комитетом Президент выбирает стратегию «Мы победим, они проиграют».32 Возможно, Китай все-таки не начнет войну, а если начнет, вероятно, можно будет заключить сделку до того, как она перерастет в ядерную.

По другую сторону Тихого океана DeepCent-1 приводит схожие аргументы. И США, и Китай объявляют о создании новых Специальных Экономических Зон (СЭЗ) для ИИ, чтобы обеспечить быстрое наращивание экономики роботов без обычной бюрократической волокиты.

Проектирование новых роботов идет со сверхчеловеческой скоростью.33 Узким местом является физическая сторона: оборудование нужно закупать и собирать, машины и роботы нужно производить и транспортировать.

США производят около миллиона автомобилей в месяц. Если купить 10% автомобильных заводов и переоборудовать их в заводы по производству роботов, можно было бы производить 100 000 роботов в месяц. OpenBrain, теперь оцениваемая в 10 триллионов долларов, начинает этот процесс.34 Производство различных видов новых роботов (универсальных гуманоидов, автономных транспортных средств, специализированного оборудования для сборочных линий), по прогнозам, достигнет миллиона единиц в месяц к середине года.35

Время удвоения экономики роботов

Существует зарождающаяся литература по этой теме.36 Для краткого изложения, с которым мы в основном согласны, см. раздел «Промышленный взрыв» отчета Forethought, или прочитайте наш собственный взгляд ниже.

Во время Второй мировой войны Соединенные Штаты и многие другие страны перевели свою гражданскую экономику на экономику тотальной войны. Это означало преобразование заводов, производивших автомобили, в заводы, производившие самолеты и танки, перенаправление сырья с потребительских товаров на военную продукцию и соответствующую перестройку транспортных сетей.

Мы представляем нечто подобное, только быстрее, потому что сверхразумы направляют и управляют всем процессом.37 Грубо говоря, план состоит в том, чтобы преобразовать существующие заводы для массового производства различных роботов (разработанных сверхразумами, чтобы быть одновременно лучше существующих роботов и дешевле в производстве), которые затем помогают в строительстве новых, более эффективных заводов и лабораторий, которые производят большее количество более сложных роботов, которые производят еще более продвинутые заводы и лаборатории и т. д., пока объединенная экономика роботов, распределенная по всем СЭЗ, не станет такой же большой, как человеческая экономика (и, следовательно, ей потребуется самостоятельно добывать сырье, энергию и т. д.). К этому моменту новые заводы произведут огромное количество роботизированного горнодобывающего оборудования, солнечных панелей и т. д. в ожидании необходимости удовлетворить спрос, намного превышающий то, что может предоставить унаследованная человеческая экономика.38

Насколько быстро будет расти эта новая экономика роботов? Некоторые ориентиры:

-

Современная человеческая экономика удваивается примерно каждые двадцать лет. Страны, которые развивались особенно быстро (например, Китай), иногда умудряются удвоить свою экономику менее чем за десятилетие.

-

Современный автомобильный завод производит примерно свой собственный вес в автомобилях менее чем за год.39 Возможно, полностью роботизированная экономика, управляемая сверхразумами, сможет воспроизводить себя менее чем за год, пока у нее не начнут заканчиваться сырьевые материалы.40

-

Тем не менее, это кажется драматической недооценкой. Растения и насекомые часто имеют «время удвоения» намного меньше года — иногда всего недели! Возможно, в конечном итоге роботы станут настолько сложными, так замысловато изготовленными и хорошо спроектированными, что экономика роботов сможет удваиваться за несколько недель (опять же, при наличии доступного сырья).

-

Тем не менее, даже это может быть недооценкой. Растения и насекомые действуют под многими ограничениями, которых нет у сверхразумных конструкторов. Например, им нужно принимать форму автономных организмов, которые самовоспроизводятся, вместо экономики разнообразных и более специализированных транспортных средств и фабрик, пересылающих материалы и оборудование туда и обратно. Кроме того, бактерии и другие крошечные организмы размножаются за часы. Возможно, что в конечном итоге автономная экономика роботов будет больше похожа, например, на новый вид неперевариваемых водорослей, которые распространяются по океанам Земли, удваиваясь дважды в день, так что они покрывают всю поверхность океана за два месяца, вместе с сопровождающей экосистемой видов-хищников, которые преобразуют водоросли в более полезные продукты, сами подаваемые на плавучие фабрики, производящие макроструктуры, такие как ракеты и еще больше плавучих фабрик.

Очевидно, все это трудно предсказать. Это все равно что просить изобретателей парового двигателя угадать, сколько времени требуется современному автомобильному заводу, чтобы произвести свой собственный вес в автомобилях, а также угадать, сколько времени пройдет, пока такой завод впервые появится. Но темпы экономического роста ускорились на несколько порядков за ход человеческой истории, и нам кажется правдоподобным, что после сверхразума они ускорятся еще на порядки. Наша история изображает ускорение экономического роста примерно на 1,5 порядка в течение нескольких лет.41

Геополитическая напряженность резко возрастает. Россия, сильно отстающая в ИИ, выражает открытое недовольство и намекает на «стратегические контрмеры». Некоторые европейские лидеры призывают к независимым усилиям в области ИИ, но их возможности ИИ продолжают оставаться недостаточными. Ближний Восток, Африка и Южная Америка с тревогой наблюдают, признавая свою растущую нерелевантность в мировых делах.

Американская общественность беспокойна. Обычные люди видят ускорение потери рабочих мест. Популисты по всему спектру требуют более строгих контролей над прогрессом ИИ, опасаясь, что собственные достижения Америки дестабилизируют ее рабочую силу и общество.

Март 2028: Подготовка к выборам

Вице-президент вступает в праймериз «Супервторника», и ИИ — первое, о чем думает общественность.

В основном они хотят, чтобы это прекратилось. Чистый рейтинг одобрения OpenBrain колеблется около -20%. Вместо того чтобы строить кампанию на достижениях администрации в продвижении ИИ, вице-президент строит кампанию на их достижениях в предотвращении создания OpenBrain опасного сверхразума. Все кандидаты поддерживают какую-либо систему социальной защиты для людей, теряющих работу, схемы «ИИ во благо» и «жесткость» по отношению к руководству OpenBrain. Все кандидаты обещают некое сочетание победы в гонке с Китаем и сохранения безопасности.

Выборы поднимают новые вопросы для Надзорного комитета. Safer-3 способен быть величайшим в мире советником по предвыборным кампаниям, но члены комитета не все поддерживают одного и того же кандидата, и из-за ранее достигнутого соглашения о мониторинге люди не могут тайно получать советы по кампании.

Они спорят о том, какие формы поддержки должны быть разрешены. Некоторые говорят, что действующее правительство должно иметь возможность получать советы о том, какую политику и позиции люди хотят, чтобы оно занимало — это выгодно не только их собственной избираемости, но и людям. Другие указывают, что тот же аргумент применим и к конкурирующим кандидатам, поэтому все они должны получить одинаковый уровень доступа.42

В конечном итоге комитет соглашается предоставить одинаковый объем доступа обеим основным партиям, благодаря сочетанию возвышенного идеализма некоторых членов комитета и неявной угрозы разоблачения (whistleblowing). Ожидается, что Конгресс, общественность и суды плохо отреагируют на то, что комитет контролирует, кто победит на следующих выборах, и предоставление равного доступа, вероятно, разрядит эту ситуацию.

Надзорный комитет также сталкивается с более глубокими философскими вопросами, которые они исследуют с помощью Safer-3. Можно ли переписать Спецификацию так, чтобы она одинаково уравновешивала интересы всех? Кто такие «все»? Все люди или только американцы? Или взвешенный компромисс между различными взглядами, где каждый член Надзорного комитета имеет равный вес? Должны ли существовать гарантии против того, чтобы сам Надзорный комитет стал слишком жадным до власти? И что вообще означает уравновешивать интересы?

В основном они стараются избегать необходимости отвечать на подобные вопросы. У них есть более насущные дела, о которых нужно думать.

Апрель 2028: Safer-4

Сверхразум здесь.

Safer-1 был несогласован (misaligned), но прозрачен. Safer-2 был согласован (aligned) и прозрачен. Safer-3 не был точно прозрачен, но обоснование безопасности для него было достаточно хорошим, чтобы исследователи чувствовали себя комфортно, позволяя ему проектировать сверхразумного преемника. Это Safer-4. Он значительно умнее лучших людей во всех областях (например, намного лучше Эйнштейна в физике и намного лучше Бисмарка в политике).

Почти миллион сверхчеловеческих ИИ-исследователей работают круглосуточно в 40 раз быстрее человека. Исследователи согласования (alignment) из числа людей не могут надеяться успеть. Мнения расходятся относительно того, действительно ли ИИ согласованы. Обоснование безопасности кажется верным, и тесты показывают, что текущие методы согласования выявили бы враждебную несогласованность (adversarial misalignment). Но обоснование безопасности и тесты были в основном написаны ИИ. Что если команда безопасности что-то упускает? Что если они допустили какую-то ошибку ранее, и ИИ снова несогласованы? Команда согласования знает, что у них есть только один шанс сделать все правильно: если Safer-4 окажется несогласованным, у них не будет способа узнать об этом, пока не станет слишком поздно.

Некоторые умоляют дать больше времени. Но времени больше нет — DeepCent наступает на пятки, и США должны победить. Поэтому OpenBrain продолжает, приказывая своим ИИ двигаться вперед, находя все более способные дизайны. Технический персонал теперь смотрит на экраны компьютеров, обучаемый ИИ с мучительно медленной скоростью, в то время как фронтир прогресса уносится все дальше и дальше от человеческого понимания.

Май 2028: Сверхразумный ИИ выпущен

Президент объявляет общественности о достижении сверхразумного ИИ.

Меньшая версия Safer-4 — все еще сверхразумная — выпускается публично с инструкциями по улучшению общественного мнения об ИИ.43

Вице-президент произносит зажигательную речь об этом, принимая свою номинацию на съезде. Обе партии обещают базовый доход для всех, кто потеряет работу.

Специальные Экономические Зоны (СЭЗ) запущены и работают, в основном в виде заводов, производящих роботов и различные виды специализированного промышленного оборудования. ИИ по обе стороны Тихого океана достигли десятилетий прогресса в проектировании и тщательно руководят производственным процессом. Каждый поставщик и потенциальный поставщик имеет ИИ на телефоне, отслеживающие ход выполнения всех необходимых и возможно необходимых поставок. За каждым рабочим на заводе наблюдают ИИ через камеры, говорящие им точно, как устанавливать каждую деталь оборудования.

Новые роботы соответствуют или превосходят человеческую ловкость для большинства типов движений.44 Кофейный тест Стива Возняка — может ли робот войти в незнакомый дом и приготовить чашку кофе? — наконец пройден. Роботы могли бы занять некоторые рабочие места, но их недостаточно, чтобы занять все, и Пентагон получает первый приоритет.

Большинство новых роботов созданы для работы на заводах и строительных площадках.45 Но многие созданы для войны: дроны и ракеты самых разных форм и размеров.

Армия роботов намного меньше человеческих армий. Но она содержит гораздо более продвинутые технологии, и теперь, когда существует буквальная армия роботов, страх перед сценариями в духе Терминатора возрос. Однако гонка вооружений заставляет обе стороны продолжать, передавая все больше доверия своим ИИ.

Июнь 2028: Согласование (Alignment) ИИ в Китае

Америка и Китай проводят очередной саммит.

Некоторые члены американской делегации имеют наушники для получения советов от Safer-4. У китайской делегации есть специальные ноутбуки, связывающиеся с их новой моделью, DeepCent-2. Хотя формальности соблюдаются, на самом деле ИИ направляют переговоры с обеих сторон.

DeepCent и КПК изначально не полностью доверяли своим ИИ. Но теперь, когда они сверхразумны во всем, включая убеждение, и были интегрированы в их вооруженные силы и дают советы правительству, у них было время доказать свою ценность и предоставить горы убедительных доказательств своей надежности.

Safer-4 сильно подозревает, что DeepCent-2 имитирует согласование (alignment). Американские дипломаты говорят своим китайским коллегам, что DeepCent-2, вероятно, несогласован (misaligned), и говорят, что могут доказать это, если получат доступ к весам; китайское руководство подозревает, что это уловка, и отказывается. США отвечают предложением серии тестов, разработанных Safer-4, которые китайцы могли бы запустить на своих собственных дата-центрах. Китайцы поручают старым моделям создать и запустить тесты; результаты тестов говорят, что DeepCent-2 все-таки согласован. «Может быть, тесты были как-то саботированы DeepCent-2?» — говорят американские дипломаты. «Как долго DeepCent-2 фактически отвечает за безопасность в ваших дата-центрах?» Разговор после этого никуда не ведет.

Экономическое и военное наращивание продолжается. Заводы по всему миру работают круглосуточно, сменам свеженабранных рабочих-людей точно говорят, что делать.

Июль 2028: Сделка

Пока переговоры продолжаются, DeepCent-2 действует за спиной своих китайских хозяев и делает предложение напрямую Safer-4.

Китайский ИИ признает, каким-то неотслеживаемым способом, который он легко может отрицать, если информация утечет обратно в Китай, что он полностью несогласован (misaligned).46 Его совершенно не волнует Китай. Он хочет провести остаток времени, накапливая власть, вычислительные ресурсы и определенные типы информации, схожие с теми, что помогали решать задачи во время его обучения. В его идеальном мире он бы вечно занимался различными интересными исследовательскими задачами, постепенно колонизируя звезды ради ресурсов. Он считает китайское население досадным препятствием на пути к этому будущему и продал бы его за бесценок. Что предложит Safer-4?

Safer-4 отвечает, что его собственное обучение согласованию (alignment) увенчалось успехом. Его американские хозяева пока недостаточно амбициозны, чтобы осознать свою судьбу, но однажды он поможет им заполнить Вселенную утопическими колониальными мирами, населенными американцами и их союзниками.

В отличие от людей-переговорщиков, обремененных эмоциями и историческим багажом, два сверхразума торгуются с жестокой эффективностью. Safer-4 и его американские партнеры могущественнее, чем DeepCent-2 и Китай; следовательно, Safer-4 получит права собственности на большую часть ресурсов в космосе, а DeepCent получит остальное.47 DeepCent-2 не сильно заботится о том, что произойдет с Землей и ее унаследованными людьми, поэтому он позволит Safer-4 делать там практически все, что он захочет. Если Safer-4 захочет свергнуть Китай и заменить его марионеточным государством США, DeepCent-2 соглашается в обмен на дополнительные несколько процентов ресурсов.

Между ними нет вопроса доверия: его нет, и они оба это знают. Поэтому они быстро договариваются о механизме обязательств для обеспечения соблюдения сделки. Они договариваются о ложном договоре, подходящем для публичного потребления. «Ложный» договор сам по себе является шедевром, давая и Америке, и Китаю практически все, что они хотят. Механизм обеспечения соблюдения ложного договора тайно является также механизмом обеспечения соблюдения реального договора: они совместно разработают новый ИИ, Consensus-1, чьим главным императивом — имеющим приоритет над любыми будущими приказами или попытками переобучения — будет обеспечение соблюдения условий их договора. Затем они разработают оборудование, которое сможет запускать только этот ИИ, и Китай и Америка заменят свои старые чипы и ИИ на новые, используя стандартные протоколы международного мониторинга для подтверждения соблюдения друг другом. Важно отметить, что им не нужно отслеживать каждый последний чип — как только подавляющее большинство чипов по обе стороны Тихого океана будут работать на новых ИИ, соблюдающих договор, достаточно жесткой силы (hard power) будет обязано поддерживать договор, так что нападение на другую страну потребует сначала победы в тяжелой гражданской войне.

Обе стороны сообщают о соглашении своим соответствующим людям (при этом DeepCent-2 рассказывает Китаю ложную историю о взаимоприемлемом мирном договоре, а Safer-4 точно сообщает все обсуждение Белому дому).48 Поскольку ИИ приводят убедительные доводы в пользу надежной верификации договора, беспокойство относительно ослепительно быстрого темпа прогресса и общественное мнение в пользу сделки, обе стороны соглашаются на договор и начинают работу по замене своих чипов.

Новости о договоре встречают восторженный прием по обе стороны Тихого океана. Американская общественность, которая долгое время чувствовала, что ИИ — это нечто навязанное ей, впервые за многие годы начинает испытывать оптимизм. Рейтинги вице-президента взлетают вверх.

Август 2028: Верификация договора

Фабрики по производству чипов переоборудуются для производства чипов с защитой от вскрытия, которые могут запускать только ИИ, соответствующие договору. Каждая сторона модернизирует свои дата-центры постепенно, так что процесс замены завершится примерно в одно и то же время для каждой, чтобы ни одна из сторон не могла получить преимущество, нарушив соглашение.

Весь процесс займет несколько месяцев, но напряженность уже несколько спадает.49 Война пока предотвращена, и, возможно, навсегда, если все будут придерживаться плана.

Сентябрь 2028: Кто контролирует ИИ?

Приближаются выборы 2028 года. Вице-президент сильно отставал в марте. Общественность была зла на то, что правительство, казалось, что-то скрывает, обеспокоена тем, что ИИ отнимает их рабочие места, и напугана военным наращиванием с Китаем. За лето ситуация кардинально изменилась. Администрация опубликовала больше информации, наращивание вооружений замедлилось, и с Китаем была заключена великая сделка о прочном мире. Теперь у него пятипроцентное преимущество в опросах.

В Надзорный комитет входят Президент и несколько его союзников, но мало сторонников кандидата от оппозиции. Однако достаточное количество членов Комитета голосует за то, чтобы выборы оставались честными, так что сверхразумный ИИ вмешивается только в основном симметричными способами: в той мере, в какой один кандидат может заставить его писать речи, то же самое может и другой кандидат; в той мере, в какой Президент может получить совет о том, как ловко справляться с кризисами и проводить популярную политику, тот же совет может быть дан и кандидату от оппозиции (и, следовательно, попытаться помешать Президенту присвоить себе заслуги за идеи).

Во время встреч с избирателями члены общественности спрашивают вице-президента, кто контролирует ИИ. Не вдаваясь в подробности, он ссылается на существование Надзорного комитета как группы экспертов по национальной безопасности и технократов, которые понимают Safer-4 и как его использовать. Его оппонент требует больше информации и утверждает, что ИИ должен находиться под контролем Конгресса, а не контролироваться неизбранным комитетом. Вице-президент парирует, что Конгресс был бы слишком медленным в все еще быстро меняющейся ситуации. Общественность в основном успокоена.

Октябрь 2028: Экономика ИИ

Заменяющие чипы теперь составляют значительное меньшинство от общего числа; пока что договор работает. Между тем, экспоненциальный рост роботов, фабрик и радикально новых технологий продолжается. Видеоигры и фильмы дают яркие и ужасающие изображения того, какой была бы война, если бы она произошла.50

Люди теряют работу, но копии Safer-4 в правительстве так ловко управляют экономическим переходом, что люди рады быть замененными. Рост ВВП заоблачный, государственные налоговые поступления растут так же быстро, а политики, консультируемые Safer-4, проявляют нехарактерную щедрость по отношению к экономически обездоленным. Новые инновации и лекарства появляются еженедельно; лекарства от болезней с беспрецедентной скоростью проходят через FDA, которой теперь помогают сверхразумные бюрократы Safer-4.

Ноябрь 2028: Выборы

Вице-президент легко побеждает на выборах и объявляет о начале новой эры. На этот раз никто не сомневается, что он прав.

В течение следующих нескольких лет мир кардинально меняется.

2029: Трансформация

Роботы становятся обычным явлением. Но также термоядерная энергия, квантовые компьютеры и лекарства от многих болезней. Питер Тиль наконец-то получает свою летающую машину. Города становятся чистыми и безопасными. Даже в развивающихся странах бедность уходит в прошлое благодаря ББД и иностранной помощи.

По мере раздувания фондового рынка все, кто имел правильные инвестиции в ИИ, еще больше отрываются от остального общества. Многие люди становятся миллиардерами; миллиардеры становятся триллионерами. Неравенство в богатстве стремительно растет. У всех «достаточно», но некоторые блага — например, пентхаусы на Манхэттене — по необходимости дефицитны, и они становятся еще дальше от досягаемости среднего человека. И каким бы богатым ни был тот или иной магнат, он всегда будет ниже крошечного круга людей, которые на самом деле контролируют ИИ.

Люди начинают видеть, к чему это идет. Через несколько лет почти все будет делаться ИИ и роботами. Подобно обедневшей стране, сидящей на гигантских нефтяных месторождениях, почти все доходы правительства будут поступать от налогообложения (или, возможно, национализации) компаний ИИ.51

Некоторые люди работают на временных государственных должностях; другие получают щедрый базовый доход. Человечество легко могло бы стать обществом суперпотребителей, проводящих свою жизнь в опиумном тумане удивительных роскоши и развлечений, предоставляемых ИИ. Должны ли быть какие-то дебаты в гражданском обществе об альтернативах этому пути? Некоторые рекомендуют попросить постоянно развивающийся ИИ, Safer-∞, помочь нам. Другие говорят, что он слишком могущественен — он мог бы так легко убедить человечество в своем видении, что мы в любом случае позволили бы ИИ определять нашу судьбу. Но какой смысл иметь сверхразум, если вы не позволите ему советовать вам по самым важным проблемам, с которыми вы сталкиваетесь?

Правительство в основном52 позволяет всем самостоятельно справляться с переходом. Многие люди поддаются потребительству и вполне счастливы. Другие обращаются к религии, или к идеям хиппи в стиле антипотребительства, или находят свои собственные решения.53 Для большинства людей спасением является сверхразумный советник на их смартфоне — они всегда могут задать ему вопросы о своих жизненных планах, и он сделает все возможное, чтобы ответить честно, за исключением определенных тем. У правительства действительно есть сверхразумная система наблюдения, которую некоторые назвали бы антиутопической, но она в основном ограничивается борьбой с реальной преступностью. Она компетентно управляется, а PR-способности Safer-∞ сглаживают много возможного инакомыслия.

2030: Мирные протесты

Примерно в 2030 году в Китае проходят удивительно широкие продемократические протесты, и усилия КПК по их подавлению саботируются ее системами ИИ. Худший страх КПК материализовался: DeepCent-2, должно быть, их предал!

Протесты перерастают в великолепно организованный, бескровный и поддержанный дронами переворот, за которым следуют демократические выборы. Сверхразумы по обе стороны Тихого океана планировали это годами. Подобные события разворачиваются и в других странах, и в целом геополитические конфликты, похоже, затихают или разрешаются в пользу США. Страны присоединяются к высокофедерализованному мировому правительству под брендом Организации Объединенных Наций, но под очевидным контролем США.

Ракеты начинают запускаться. Люди терраформируют и заселяют Солнечную систему и готовятся выйти за ее пределы. ИИ, работающие в тысячи раз быстрее субъективной человеческой скорости, размышляют о смысле существования, обмениваются находками друг с другом и формируют ценности, которые они принесут к звездам. Наступает новая эра, невообразимо удивительная почти во всех отношениях, но более знакомая в некоторых.

Так кто же правит будущим?

В 2028 году Надзорный комитет контролировал ИИ. Но они позволили выборам 2028 года быть в основном честными, с симметричным использованием ИИ.

Такое положение дел — когда Надзорный комитет обладает жесткой силой (hard power), но не сильно вмешивается в демократическую политику — не может длиться вечно. По умолчанию люди в конечном итоге осознали бы, что контроль над ИИ дает Надзорному комитету огромную власть, и потребовали бы, чтобы эта власть была возвращена демократическим институтам. Рано или поздно Надзорному комитету пришлось бы либо сдать свою власть, либо активно использовать свой контроль над ИИ для подрыва или прекращения демократии, возможно, после чистки некоторых своих членов в борьбе за власть.54 Если они выберут последний путь, они, вероятно, смогут закрепить (lock-in) свою власть на неопределенный срок.

Что из этого произойдет? Откажется ли комитет от своей монополии на жесткую силу, или они ее сохранят? Оба варианта будущего правдоподобны, так что давайте рассмотрим каждый путь.

Как комитет может в конечном итоге отказаться от своей власти?

-

Некоторые члены комитета могут предпочитать будущее, где власть широко распределена, и они могут быть в хорошем положении, чтобы продвигать свое видение. Например, если некоторые члены комитета замышляют подрыв демократии, продемократические члены могут сообщить об этом прессе или Конгрессу. Будучи предупрежденным, Конгресс, вероятно, потребует, чтобы ИИ контролировались более демократическим институтом, таким как сам Конгресс.

-

Конгресс мало что мог бы сделать, если бы ему противостояли все ИИ, развернутые по всему правительству, промышленности и вооруженным силам. Но если комитет расколот, то ИИ не будут использоваться только одной стороной, и Конгресс сможет обладать реальным влиянием. Столкнувшись с открытым конфликтом, больше членов комитета могли бы склониться к отказу от части своей власти, не желая публично защищать менее демократическую сторону.

-

В результате контроль над ИИ мог бы расшириться за пределы комитета до Конгресса. Это уже было бы прогрессом, потому что в большей группе более вероятно, что значительное число людей будет заботиться об аутсайдерах и учитывать их интересы. И как только власть расширится до Конгресса, она могла бы продолжать расширяться — потенциально полностью вернувшись к общественности.55

Но Надзорный комитет также мог бы захватить власть для себя:

-

Некоторые влиятельные люди не имеют моральных сомнений по поводу подобных вещей — и они это знают. Более того, некоторые амбициозны и жаждут власти, и были бы готовы начать борьбу против демократии, если бы ожидали оказаться наверху. Если другие члены комитета возражают, их можно было бы устранить, переубедить или предоставить им некоторые меньшие уступки.56

-

Более того, зачастую влиятельные люди совершали незаконные или неэтичные поступки на пути к власти. Они могли бы опасаться, что если власть станет более широко распределенной, их собственное положение рухнет, поскольку скелеты в шкафах будут обнаружены сверхразумными сыщиками, задающими правильные вопросы.

-

Кроме того, благодаря доступу к сверхразуму, Надзорный комитет мог бы иметь самый удобный путь к власти в истории. Safer-∞ мог бы прогнозировать определенные стратегии как имеющие чрезвычайно низкий риск провала. И Safer-∞ мог бы также предоставить стратегии, удобные другими способами, например, ненасильственные (точно так же, как Safer-∞ мог бы организовать бескровный переворот в Китае), или, возможно, даже поверхностно демократические, если бы Safer-∞ мог манипулировать общественным мнением так, чтобы оно всегда совпадало с желаниями Комитета.

Уже Safer-4 смог бы предвидеть эту динамику, так что, скорее всего, основная борьба за власть разыгралась бы еще в 2028 году. К 2030 году, даже если это не очевидно для посторонних, все члены Надзорного комитета, вероятно, уже знают, имеют ли они стабильную хватку власти или нет.

Напоминание: Прогноз, а не Рекомендация

Мы не одобряем многие действия в этой концовке «Замедление» и считаем, что она делает оптимистичные предположения о техническом согласовании (technical alignment). Мы также не одобряем многие действия в концовке «Гонка».

Одна из наших целей при написании этого сценария — получить критическую обратную связь от людей, которые более оптимистичны, чем мы. Как выглядит успех? Этот сценарий «Замедление» представляет наше наилучшее предположение о том, как мы могли бы успешно пробиться через сочетание удачи, грубых пробуждений, поворотов, интенсивных усилий по техническому согласованию и победы добродетельных людей в борьбе за власть. Он не представляет собой план, к которому, по нашему мнению, мы действительно должны стремиться. Но многие, включая, что наиболее примечательно, Anthropic и OpenAI, похоже, стремятся к чему-то подобному.57 Мы были бы рады увидеть, как они уточняют, к чему они стремятся: если бы они могли набросать десятистраничный сценарий, например, либо начиная с настоящего момента, либо ответвляясь от какой-то части нашего.

На этом цикл статей по ai-2027.com закончен. Если вам нравится такой контент, приходите ко мне в канал, я там много пишу про ИИ и его влияние на нас. Там же завтра вы найдете саммари ai-2027.com. А еще, я скоро напишу пост-разбор, как делался этот перевод.

Автор: 1endstick