Апрельский вечер 2025 года. Запускаю Black Myth: Wukong на своей не самой свежей видеокарте и ловлю себя на мысли, что когда-то для запуска DOOM 2 хватало процессора с тактовой частотой всего лишь 90 МГц. С тех пор игровая индустрия прошла колоссальный путь от примитивных пикселей до фотореалистичных миров, и вместе с ней эволюционировали требования к железу. Но как это происходило и что нас ждет дальше? Давайте разберемся.

Первые шаги: 1950-1970-е годы

История видеоигр началась задолго до появления домашних ПК. В 1950-х годах ученые начали создавать простые игры и симуляции на мейнфреймах и мини-компьютерах. Поэтому и играли в них только сотрудники научных лабораторий и университетов, которые развлекали себя в перерывах между исследованиями.

Настоящим прорывом стала игра Spacewar!, разработанная студентами MIT в 1962 году. Она считается одной из первых цифровых компьютерных игр, доступных относительно широким массам. Ни о каких “минимальных системных требованиях” в современном понимании тогда речи не шло – игры создавались под конкретное железо, которое стоило как хороший автомобиль и занимало целую комнату.

Параллельно с этим Нолан Бушнелл, вдохновленный Spacewar!, решил создать аркадную версию этой игры. В 1971 году он и Тед Дабни основали компанию Syzygy Engineering и выпустили Computer Space – первый коммерческий игровой автомат. Хотя игра не стала хитом из-за сложного управления, она проложила путь для будущих аркадных игр.

Ее путь продолжили автоматы Computer Space и Pong, а также первая домашняя консоль Magnavox Odyssey. Эти устройства имели жестко зашитое железо, разработанное специально для запуска конкретных игр. Бушнелл, уже основавший компанию Atari, выпустил аркадную версию Pong в 1972 году, которая стала невероятно популярной. Простая игра, имитирующая настольный теннис, оказалась настолько успешной, что буквально заложила основы целой индустрии.

Эпоха 8-битных компьютеров: 1980-е

С появлением домашних компьютеров вроде Apple II, Commodore 64 и ZX Spectrum игры стали доступнее. Типичная конфигурация таких ПК включала процессор с частотой 1-4 МГц и 16-64 КБ оперативной памяти, а для хранения данных использовались кассеты или дискеты.

Графика тоже была примитивной – всего 8-16 цветов, низкое разрешение, простые спрайты. Но именно в тот период родились многие культовые серии, существующие до сих пор. Игры тогда весили килобайты, а не гигабайты, и могли поместиться на одной дискете.

Кстати, из-за того, что развернуться было особенно негде, в создании игр чаще всего принимал участие только один человек. Программист не только писал код, но и рисовал графику и сочинял музыку. Сейчас такое сложно представить, учитывая, что над современными AAA-проектами работают сотни, а иногда и тысяч людей.

В те времена даже установка игр была иной. Никаких исполнительных файлов, только код, который нужно было вручную ввести на компьютере. Это было обычным делом: вы покупаете журнал, в котором напечатан код игры, и забиваете его на клавиатуре в ПК. Если допустите ошибку, игра не запустится. Это было своего рода испытанием на терпение и внимательность.

Революция ПК и 16-битных консолей: 1990-е

1990-е годы стали золотым веком видеоигр. Появление 3D-графики, CD-ROM и мощных консолей вроде PlayStation и Nintendo 64 вывело игры на новый уровень.

Именно к этому периоду относится настоящий прорыв, который произошел в 3D-графике. Джон Кармак и Джон Ромеро из id Software экспериментировали с рендерингом трехмерных игр в реальном времени через Hovertank 3D и Catacomb 3-D. Эти эксперименты привели к выпуску Wolfenstein 3D в 1992 году, который считается первым настоящим шутером от первого лица.

Идеи, заложенные в нем, продолжил DOOM 2, вышедший в 1994 году. Его системные требования были выше: он требовал процессор Intel Pentium 90 МГц, 16 МБ оперативной памяти, видеокарту SVGA и 50 МБ на жестком диске. А для комфортной игры рекомендовался Intel Pentium 166 МГц, 32 МБ оперативной памяти и видеокарта SVGA с 2 МБ памяти. Сейчас эти цифры вызывают улыбку, но тогда такая конфигурация считалась вполне серьезной и позволяла запускать игру в разрешении 640×480 со стабильными 30-35 FPS даже в насыщенных сценах с десятками монстров.

Однако настоящая революция произошла с выходом Quake в 1996 году – первой компьютерной игры с полноценным 3D-движком, включающим модели персонажей и объектов. Software лицензировала движок Quake другим разработчикам, что привело к дальнейшему росту жанра шутеров от первого лица.

К 1997 году на рынке появились первые потребительские видеокарты с аппаратным ускорением 3D-графики, а в последующие годы были созданы многочисленные 3D-движки, включая Unreal Engine, GoldSrc и CryEngine, что сделало 3D стандартом в большинстве компьютерных игр. Примерно в это же время начался ощутимый рост рекомендованных системных требований.

Революционная Half-Life из 1998 года уже требовала процессор с частотой 500 МГц, 96 МБ оперативной памяти, видеокарту с 16 МБ памяти и 400 МБ на жестком диске. Для комфортной игры рекомендовался процессор с частотой 800 МГц (представляете?), 128 МБ оперативной памяти и видеокарта с 32 МБ памяти. По сути, Half-Life произвела революцию в жанре шутеров, добавив продуманный сюжет и инновационную для своего времени графику. Эта игра до сих пор считается одной из лучших в истории.

Эра PlayStation 2 и DirectX 9: 2000-2005

С выходом PlayStation 2, Xbox и GameCube начался новый этап в развитии 3D-графики. В играх появились шейдеры, улучшенные текстуры и более сложные модели.

Криминальная сага Mafia (2002) от чешских разработчиков могла работать на сетапе не ниже Pentium III или AMD Athlon с частотой 500 МГц, с 96 МБ оперативной памяти, видеокартой с 16 МБ памяти и поддержкой DirectX 8.1, а также с 1,8 ГБ на жестком диске. Такая конфигурация требовалась для отрисовки продвинутой для своего времени физической модели автомобилей с реалистичными повреждениями. В Mafia можно было пробить топливный бак, перегреть двигатель или сломать коробку передач — детали, которые большинство игр того времени просто игнорировали. При этом игра занимала три CD-диска, что по тем временам было впечатляющим объемом.

Тропический шутер Far Cry (2004) поднял планку еще выше. Для его запуска требовался процессор AMD Athlon или Pentium III с частотой 1 ГГц, 256 МБ оперативной памяти, видеокарта с 64 МБ памяти и поддержкой DirectX 9.0b, а также 4 ГБ на жестком диске. Процессор с частотой 2-3 ГГц и 512-1024 МБ ОЗУ обеспечивали рендеринг сложной растительности с динамическим освещением и затенением, а также позволяли смотреть вдаль без падения качества прорисовки и существенных просадок FPS, что было революционным для 2004 года.

HD-эра и многоядерные процессоры: 2005-2013

С выходом Xbox 360 и PlayStation 3 игры перешли в HD-разрешение. Появились продвинутые эффекты освещения, физики и анимации.

Чтобы соответствовать новым стандартам качества, индустрия ПК-игр также совершила технологический скачок — этот период ознаменовался появлением многоядерных процессоров и более мощных видеокарт. Игры стали использовать более сложные шейдеры, высокополигональные модели и детализированные текстуры, что требовало значительно больших вычислительных ресурсов.

В 2005-2006 годах NVIDIA выпустила серию GeForce 7 и революционную GeForce 8800 GTX с унифицированной шейдерной архитектурой и поддержкой DirectX 10. AMD (тогда ATI) ответила сериями Radeon X1000 и HD 2000. На процессорном фронте появились первые массовые двухъядерные CPU — Intel Core 2 Duo и AMD Athlon 64 X2, а к 2008 году четырехъядерные процессоры стали доступны обычным пользователям.

Несмотря на технический прогресс, многие игры этого поколения страдали от проблем с производительностью. Как отмечают эксперты, разработчики часто “переоценивали возможности” железа, внедряя слишком амбициозные графические эффекты — каскадные карты теней, сложные шейдеры и продвинутое освещение, которые консоли не могли обрабатывать с комфортной частотой кадров.

Настоящим испытанием для игровых ПК того времени стал Crysis (2007), который и определил новую планку графических возможностей. Этот шутер от первого лица предлагал революционные для своего времени технологии: объемное освещение, реалистичный рендеринг тумана и растительности, глубину резкости и детализированные тени. Игра стала одной из первых, внедривших технологию Screen-Space Ambient Occlusion (SSAO), которая значительно улучшала восприятие глубины сцены.

Но даже на мощном железе (Core 2 Duo 2.2 ГГц, 2 ГБ ОЗУ, GeForce 8800 GTS) Crysis не всегда выдавал стабильные 30 FPS на максимальных настройках, что породило мем “But can it run Crysis?” (“А Crysis потянет?”). Этот мем до сих пор используется как мерило производительности компьютеров. Цеват Йерли, основатель Crytek, намеренно создавал игру с прицелом на будущее, чтобы она оставалась графическим эталоном на годы вперед.

The Elder Scrolls V: Skyrim (2011) также стал одной из самых влиятельных игр десятилетия. Эта эпическая ролевая игра требовала двухъядерный процессор с частотой 2.0 ГГц, 2 ГБ оперативной памяти, видеокарту с 512 МБ памяти и поддержкой DirectX 9.0c, а также 6 ГБ на жестком диске. Четырехъядерный процессор Intel и 4 ГБ ОЗУ обеспечивали работу системы Radiant AI, которая управляла поведением сотен NPC одновременно, давая им возможность следовать собственным распорядкам дня, реагировать на действия игрока и взаимодействовать между собой без скриптовых последовательностей.

Современная эра: 2013-2025

С выходом PlayStation 4 и Xbox One, а затем и их преемников PS5 и Xbox Series X|S, игры достигли невероятного уровня графической детализации. Трассировка лучей, фотограмметрия, процедурная генерация – всё это стало частью современных игр, которые стали требовательны как никогда.

Особенно разница в системных требованиях, которые предъявляют разработчики, видна в сравнении тайтлов разных лет:

|

Игра |

Год |

Min CPU |

Min GPU |

Min RAM |

Место на диске |

|

DOOM 2 |

1994 |

Pentium 90 МГц |

SVGA |

16 МБ |

50 МБ |

|

Half-Life |

1998 |

500 МГц |

16 МБ |

96 МБ |

400 МБ |

|

Far Cry |

2004 |

1 ГГц |

64 МБ DirectX 9.0b |

256 МБ |

4 ГБ |

|

Skyrim |

2011 |

Dual Core 2.0 ГГц |

512 МБ DirectX 9.0c |

2 ГБ |

6 ГБ |

|

The Witcher 3 |

2015 |

i5-2500K 3.3 ГГц |

GTX 660 / HD 7870 |

6 ГБ |

50 ГБ |

|

A Plague Tale: Requiem |

2022 |

i5-4690K 3.5 ГГц |

GTX 970 / RX 590 |

16 ГБ |

55 ГБ |

|

Black Myth: Wukong |

2024 |

i5-4690K 3.5 ГГц |

GTX 970 / RX 590 |

16 ГБ |

55 ГБ |

Анализируя данные из таблицы, можно выделить несколько ключевых тенденций в эволюции системных требований:

-

Экспоненциальный рост требований к процессору. За 30 лет минимальная требуемая частота процессора выросла примерно в 40 раз. При этом произошел переход от одноядерных к многоядерным архитектурам. Если DOOM 2 использовал только одно ядро, то современные игры задействуют 4-8 ядер одновременно.

-

Взрывной рост объема видеопамяти. От скромных 16 МБ видеопамяти в 1998 году до 4 ГБ в 2022 — увеличение в 250 раз! Это связано с резким ростом разрешения текстур, количества полигонов и сложности шейдеров. Современные игры используют текстуры разрешением 4K и выше, что требует огромных объемов видеопамяти.

-

Увеличение требований к оперативной памяти. От 16 МБ в 1994 году до 16 ГБ в 2024 — рост в 1000 раз. Это связано с увеличением размера игровых миров, количества объектов и сложности симуляций физики, ИИ и других игровых систем.

-

Рост размера игр. От 50 МБ до 55 ГБ — увеличение в 1100 раз. Современные игры включают высококачественные текстуры, модели, анимации, озвучку на нескольких языках и видеоролики в 4K-разрешении, что приводит к гигантским размерам установки.

И все это притом, что минимальные системные требования могут радикально отличаться от рекомендуемых. Просто разработчики вынуждены понижать планку, чтобы современные игры вроде Black Myth: Wukong все еще могли запускаться на процессорах и видеокартах 7-10-летней давности. Такая необходимость объясняется несколькими факторами:

-

Коммерческий успех. Разработчики стремятся сделать свои игры доступными для максимально широкой аудитории. Слишком высокие минимальные требования отсекают значительную часть потенциальных покупателей, особенно на развивающихся рынках, где многие геймеры используют устаревшее оборудование.

-

Консольная адаптация. Многие современные игры разрабатываются с учетом консолей предыдущего поколения (PS4/Xbox One), архитектура которых близка к ПК середины 2010-х годов. Это естественным образом ограничивает минимальные требования.

-

Масштабируемость настроек. Современные игровые движки предлагают широкие возможности масштабирования графических настроек. На минимальных настройках игра может выглядеть значительно хуже, чем на рекомендуемых или максимальных, но при этом оставаться играбельной.

-

Технологии апскейлинга. Решения вроде DLSS от NVIDIA и FSR от AMD позволяют рендерить игру в более низком разрешении с последующим масштабированием до целевого, что значительно снижает нагрузку на видеокарту.

Однако стоит понимать, что “запустится” и “будет хорошо работать” – совсем не одно и то же. Минимальные требования обеспечивают лишь базовую работоспособность игры, часто с низкой частотой кадров (20-30 FPS), низким разрешением (720p-1080p) и существенно сниженным качеством графики. Но для комфортной игры на высоких настройках требуется значительно более мощное оборудование.

Компьютерное железо для игр в 2025 году

В 2025 году для комфортной игры в 1080p достаточно видеокарт уровня AMD Radeon RX 7600 или NVIDIA GeForce RTX 4060. Они обеспечивают отличную производительность при разрешении 1080p и стоят относительно недорого.

RTX 4060 имеет достаточно мощности для запуска многих современных игр с максимальными настройками в 1080p и является отличным выбором для тех, кто хочет играть с наилучшим качеством изображения при этом разрешении. Карта предлагает исключительную производительность трассировки лучей для недорогой карты и поддерживает DLSS 3, что может значительно повысить частоту кадров в поддерживаемых играх.

Для игры в 1440p рекомендуется более мощная видеокарта, например, NVIDIA GeForce RTX 4070 Super. Она обеспечивает высокую частоту кадров во всех современных играх при этом разрешении.

Интересно, впрочем, что теперь производительность игр определяет не только аппаратное обеспечение. Современный гейминг становится симбиозом традиционных вычислений и искусственного интеллекта, где программные алгоритмы и нейросетевые технологии играют не менее важную роль, чем количество транзисторов в GPU.

Что могут новые видеокарты NVIDIA RTX 5000

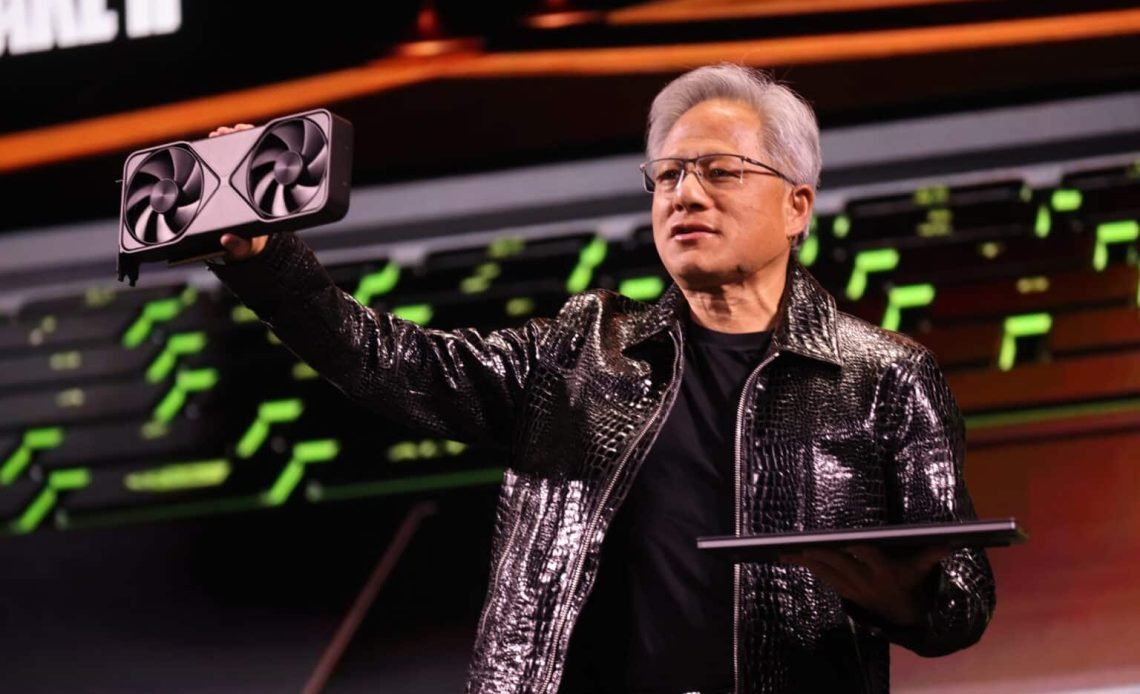

Большой прорыв в этой области совершила NVIDIA со своей линейкой RTX 5000. Новые видеокарты предлагают не просто увеличение сырой производительности, а фундаментально новый подход к рендерингу графики с использованием искусственного интеллекта.

Ключевой инновацией стали RTX Neural Shaders — маленькие нейронные сети, встроенные непосредственно в шейдеры GPU. Эта технология, по словам главы NVIDIA Дженсена Хуанга, является “самой значительной инновацией в компьютерной графике с момента появления программируемых шейдеров 25 лет назад”. Нейронные шейдеры позволяют генерировать текстуры, материалы, освещение и объемные эффекты с помощью ИИ, что значительно повышает производительность, качество изображения и интерактивность.

Особенно впечатляет технология RTX Neural Texture Compression, способная сжимать тысячи текстур за считанные минуты. Согласно тестам, ИИ-сжатие может уменьшить объем используемой видеопамяти на 96% по сравнению с обычными текстурами того же качества. Это особенно важно для видеокарт с ограниченным объемом VRAM, таких как GeForce RTX 4060. Хотя такое сжатие требует вычислительных ресурсов и может снизить частоту кадров на 5-6% при использовании текстур 1440p, преимущества для карт с ограниченной памятью могут быть огромными.

Другая революционная технология — RTX Neural Materials, которая преобразует сложный шейдерный код и слои текстур в сжатое нейронное представление. Это обеспечивает коэффициент сжатия до 7:1 и позволяет маленьким нейронным сетям генерировать кинематографические материалы в реальном времени. Например, шелк, отрендеренный с помощью традиционных шейдеров, может не передавать многоцветный блеск, наблюдаемый в реальной жизни. Нейронные материалы захватывают такие сложные детали, как вариации цвета и отражения, делая поверхности невероятно реалистичными при значительно меньшем использовании памяти.

Очевидно, что искусственный интеллект становится ключевым инструментом оптимизации, который позволяет увеличить производительность игр, не жертвуя качеством изображения, и технологии вроде DLSS 4 успешно это доказывают. Ну, а в будущем мы, вероятно, увидим еще более продвинутые решения, которые позволят получать премиальный визуальный опыт на более доступном оборудовании. Теперь главное – не скатиться с таким подходом в каменный век, правда?

Автор: Xcom-shop