Когда-то вычисления требовали терпения, ловкости рук и арифмометра. Сегодня же банковские переводы приходят за доли секунды, соцсети нон-стоп транслируют рилсы, в облаках хранятся и обрабатываются террабайты фотографий. Все это уже невозможно без гигантских дата-центров, где данные циркулируют со скоростью, о которой создатели мейнфреймов 1960-х годов могли только мечтать. Какое развитие дата-центры прошли за эти десятилетия, почему без них невозможен интернет и как современный ЦОД похож на небольшой город – в нашей ретроспективе.

Мейнфрейм вместо арифмометра

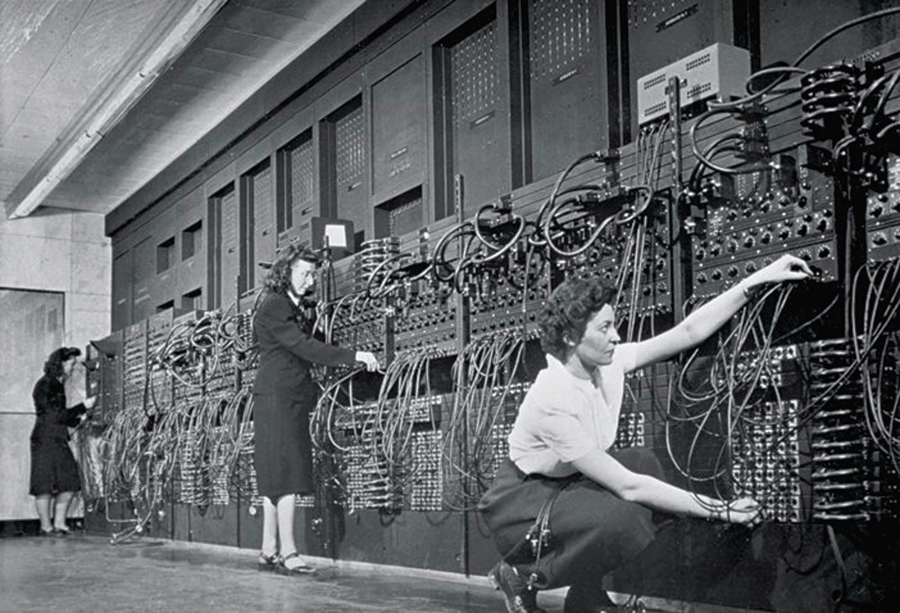

История дата-центров уходит корнями в далекие 1940-е. Тогда самым крутым гаджетом своего времени был ENIAC (сокр. от Electronic Numerical Integrator and Computer) – первый в мире электронный цифровой интегратор и компьютер. Эту махину собрали для армии США, чтобы рассчитывать траектории артиллерийских снарядов во Вторую мировую. Позже ENIAC подключили к секретной программе США по разработке ядерного оружия во время Второй мировой войны – Манхэттенскому проекту. Вот такая скромная судьба.

Первые дата-центры были настоящим вызовом для инженеров того времени. Оно и понятно: в начале эры вычислительных центров не было общепринятых стандартов проектирования и эксплуатации подобных объектов. Серверы, сети, системы охлаждения, электропитания, резервного копирования – все это создавалось с нуля. Из-за того, что дата-центры потребляли огромное количество электроэнергии, инженерам приходилось искать новые способы минимизации затрат на электроэнергию, одновременно обеспечивая бесперебойную работу компьютерного центра. Конечно, потребление крупным дата-центром того времени нескольких сотен киловатт не стоит сравнивать с современными ЦОДами, для которых десятки и сотни мегаватт – не предел, тем не менее для своего времени это было значительным расходом энергии. Кроме того, технологии в ИТ-сфере развивались очень быстро, что требовало постоянной адаптации инфраструктуры центра обработки информации под новые требования. Это стимулировало инженеров к гибкости и инновационному подходу.

Работали дата-центры, по большей части, на военных и разведку, поэтому охрана здания была как в шпионских фильмах: одна-единственная дверь и никаких окон.

Для охлаждения всей этой махины использовали огромные промышленные вентиляторы. Они обеспечивали циркуляцию воздуха и отвод тепла от оборудования. Эти вентиляторы часто изготавливались на заказ, поэтому были очень дорогими. А еще километры проводов и тысячи вакуумных трубок. Проблемы, тем не менее, случались. И нередко: провода перегревались, ломались, а иногда и вовсе вспыхивали, поджигая дорогое оборудование.

В период 1950-1960-х годов появился термин «мейнфрейм» – так стали называть большие и мощные компьютеры, способные выполнять сложные вычисления для бизнеса, оборонных систем и научных исследований. Именно ими начали оснащать дата-центры, превращая их в центры обработки и хранения данных. Эти большие и мощные вычислительные машины могли справляться с серьезными задачами, например, делать расчеты для бизнеса или критически важных систем.

Конечно, мощность познается в сравнении. Первые мейнфреймы работали на вакуумных лампах (например, UNIVAC I), более поздние модели – на транзисторах. Тактовая частота составляла от 2,26 КГц до 1,8 МГц, объем оперативной памяти ограничивался 32 КБ (IBM 7090), скорость выполнения арифметических операций измерялась в диапазоне от 2 тыс. до 100 тыс. операций в секунду. Для долгосрочного хранения данных использовались магнитные ленты и диски. Например, объем хранилища на магнитной ленте «достигал» 128 КБ (UNIVAC I), а на первом жестком диске (1956 год, IBM 350 Disk Storage Unit) – 5 МБ.

Для сравнения. Современный смартфон (например, iPhone 15 Pro) выполняет около 60 трлн операций с плавающей запятой в секунду – это примерно в 5 млрд раз быстрее, чем IBM 704. PlayStation 5 имеет производительность около 10 терафлопс (10 трлн операций), что делает эту игрушку быстрее любого мейнфрейма 60-х годов в миллионы раз, ОЗУ в современном ноутбуке (например, 16 ГБ) примерно в миллион раз больше, чем у IBM 7094.

Тем не менее, мейнфреймы тех лет были невероятно надежными и справлялись с огромными массивами данных для банков, военных систем и космических программ. Например, IBM 7090 использовался NASA в программе «Аполлон» для полетов на Луну.

Стоили, конечно, такие устройства очень дорого. Так, UNIVAC I (1951 год) оценивался в сумму около $1,5 млн (примерно $15 млн сегодня), IBM 7094 (1962 г.) – порядка $3 млн ($30 млн в сегодняшних ценах), IBM System/360 Model 75 – $4–5 млн (более $40 млн сегодня).

Из-за высокой цены мощные вычислительные машины были привилегией крупных игроков, которые автоматизировали свои сложные процессы, повышая их эффективность. Например, Bank of America был одним из первых банков, внедривших IBM 702 в 1959 году для автоматизации обработки чеков, American Express применял подобные технологии для обработки транзакций и работы с клиентскими счетами. Фондовые биржи (NYSE, Лондонская биржа) задействовали их для расчета курсов акций и обработки сделок. Служили мейнфреймы и в госструктурах: Министерство обороны США «подключало» устройство для обработки разведданных и работы с ядерным арсеналом, ФБР и ЦРУ – для анализа данных и криптографических операций. Разумеется, крупный бизнес также старался быть на технологической волне. General Motors, Ford планировали производство, логистику и расчет зарплат рабочих. US Steel, DuPont «привлекали» вычислительные устройства для управления производственными процессами и расчетов химических реакций.

Интернета еще не было, поэтому мейнфреймы работали в изоляции, как автономные острова среди моря арифмометров и кип бумаг.

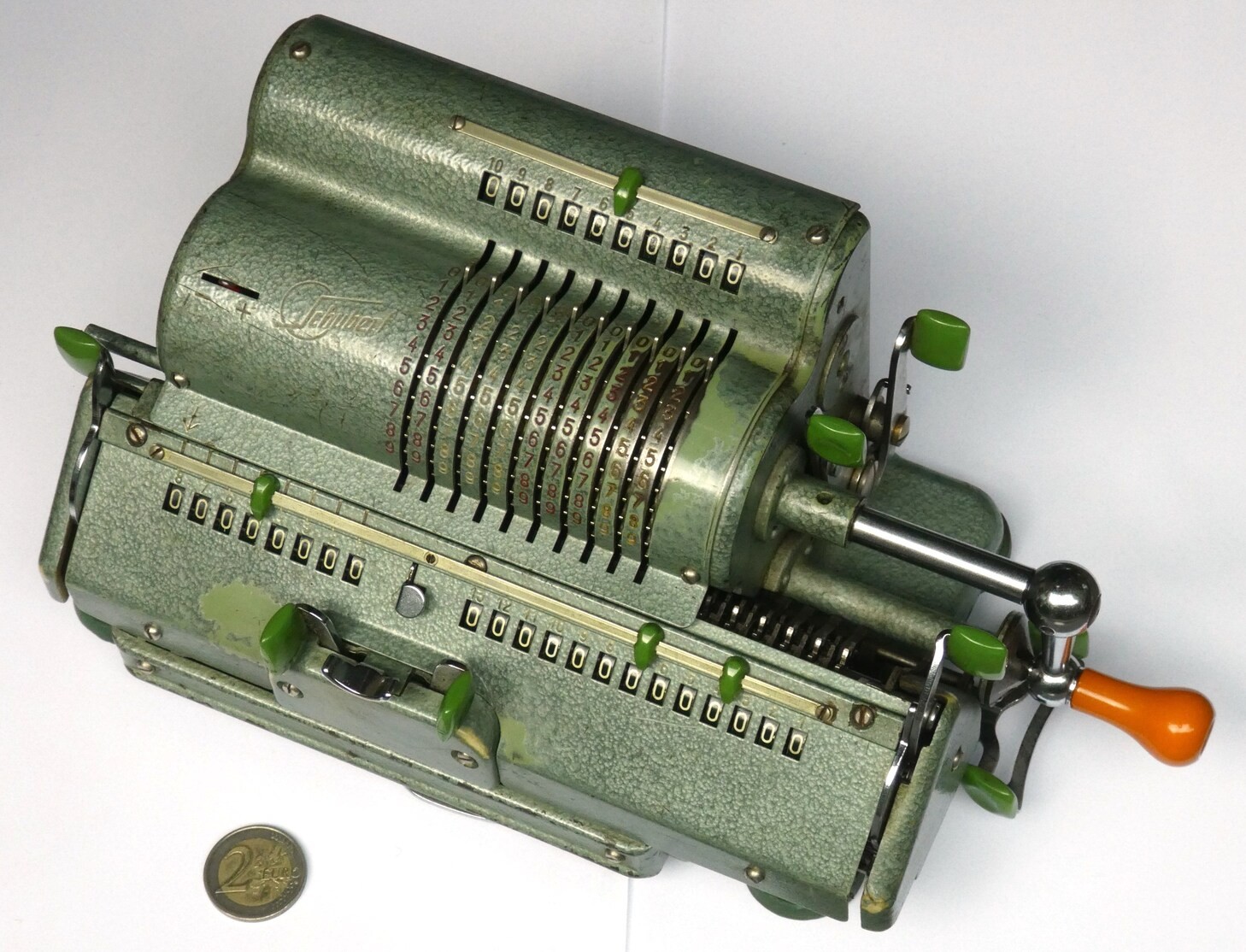

Арифмометр – это такой ретро-калькулятор, только с ручным приводом. Похож на металлическую коробку с рычагами и шестеренками, ручку которой надо крутить, чтобы произвести разные арифметические действия. Им пользовались бухгалтеры, инженеры, математики и прочие. В отличие от современных калькуляторов арифмометр не разряжался в самый неподходящий момент, но мог неожиданно заклинить, заставляя владельца задуматься о запасной копии вычислений на бумаге.

Пример из воспоминаний Питта Тернера, главы Uptime Institute: «Вечером прибывают грузовики с бумагами. Ночью данные обрабатываются, создаются новые распечатки, а затем эти документы отвозятся обратно в филиалы банков, чтобы они могли открыться утром». Выглядит это так: операторы вручную заносят данные с документов в систему с помощью перфокарт или лент. Каждая операция кодируется в виде последовательности отверстий в карточках, которые затем сортируются и отправляются в вычислительный центр. Похоже на сцену из ретро-фильма, но тогда это был топ технологий.

Uptime Institute – независимая консалтинговая организация, специализирующаяся на повышении производительности, эффективности и надежности критически важной инфраструктуры. Она известна разработкой системы классификации уровней (Tier) для оценки надежности и производительности центров обработки данных. С момента создания системы классификации уровней Uptime Institute выдала более 1700 сертификатов Tier в более чем 100 странах. Штаб-квартира Uptime Institute находится в Нью-Йорке, США.

В 1970-е мощность компьютеров росла так быстро, что бюджеты едва успевали за ними. Персональные компьютеры уже стали появляться, но мейнфреймы еще держали марку. Главный их плюс был уже не в скорости, а в надежности. Правда, содержать их оставалось дорогим удовольствием, поэтому многие компании махнули рукой на свои «железные парки» и перешли на аутсорсинг. Так началась эра, когда за вычислительную мощность стали платить, как за аренду квартиры – пусть не свое, зато работает. Этот подход в итоге стал предшественником облачных вычислений, где ресурсы арендуются у специализированных провайдеров.

Идеальный шторм в море ЦОДов

В 1990-е началась эпоха перемен – тот самый «идеальный шторм», который смыл мейнфреймы с их пьедестала. Виной всему были микропроцессоры, интернет и модная на тот момент клиент-серверная модель вычислений.

Микропроцессоры сделали компьютеры дешевле, компактнее и доступнее. Если раньше вычисления концентрировались на мощных мейнфреймах, то с развитием процессоров стало возможным использовать множество менее дорогих серверов. Интернет изменил способы обработки и передачи данных. Вместо локальных вычислений на мейнфреймах компании стали строить распределенные сети, где расчеты производились на разных машинах, соединенных через интернет. Клиент-серверная модель позволяла обрабатывать данные не на одном мощном компьютере (как в мейнфрейме), а распределять нагрузку между серверами и клиентскими устройствами. Это дало больше гибкости и снизило стоимость инфраструктуры. Все это в совокупности сделало мейнфреймы менее привлекательными и подтолкнуло компании к переходу на новые технологии.

Помещения старых мейнфреймов быстро заполнили серверы, а оттуда было рукой подать до первых полноценных дата-центров. Инфраструктура стала стандартизированной, появились модульные стойки – эти самые стеллажи, без которых сегодня не обходится ни один ЦОД.

Бизнес тоже приспособился. Поскольку жить без интернета стало нереально, подключение к сети стало обязательным условием для выживания. Провайдеры взяли все в свои руки: размещали клиентское оборудование у себя, обеспечивали его питанием, обслуживали и подключали к мощным каналам связи. Это помогло сэкономить на «последней миле» – том самом кабеле от провайдера до клиента. Так началась гонка: интернет-провайдеры и хостинговые компании начали массово строить свои дата-центры, и этот рынок резко пошел в рост.

Сегодняшние дата-центры – уже не просто серверные комнаты, а настоящие форпосты цифровой эпохи. С их помощью компании запускают свои приложения, хранят данные и управляют всем, что связано с ИТ. Внутри современного ЦОДа серверы, сетевое оборудование, системы охлаждения, кабели, охрана, а еще – надежная энергетическая инфраструктура, чтобы все это хозяйство не перегрелось и не погасло. Компании предпочитают собирать все свое «железо» под одной крышей, потому что так удобнее и безопаснее, чем держать оборудование в каждом филиале. А вот иметь свой собственный ЦОД или арендовать у провайдера – это уже дело вкуса и бюджета.

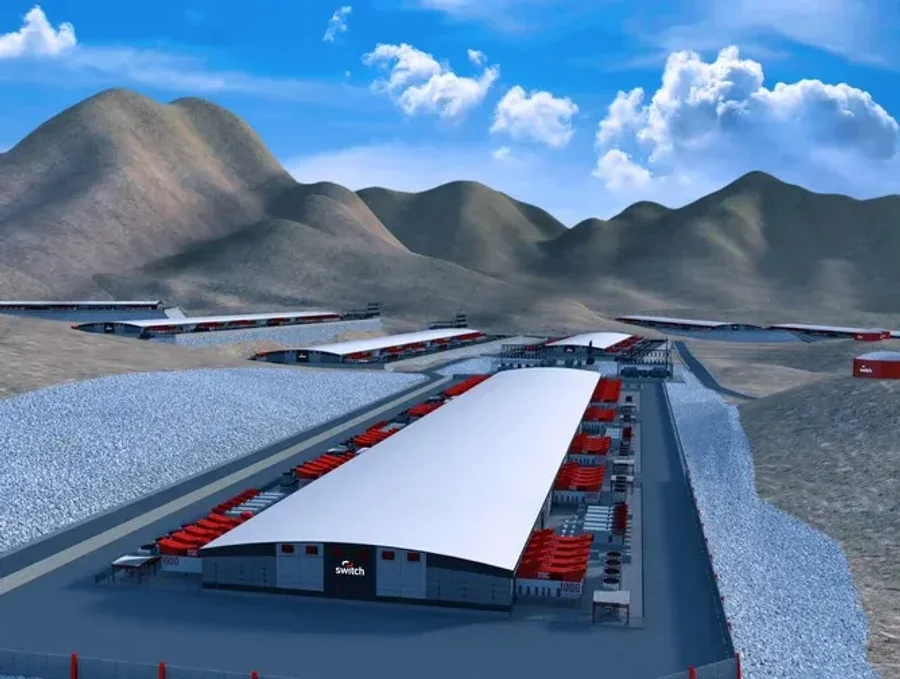

Каждый день человечество накидывает больше 2,5 млн терабайт данных, которые требуют хранения и обработки. Судя по растущим потребностям на мощные вычисления, спрос на дата-центры будет только расти. В 2022 году по миру насчитывалось более 800 гипермасштабируемых ЦОДов (гиперскейлеров) – огромных цифровых «устройств» для больших данных, ИИ и интернет-кабелей. Половина этих гигантов базируется в США, причем треть мощностей сосредоточена в штате Вирджиния. Этот регион уже называют мировой столицей интернета. Теперь про размеры этих монстров. Utah Data Center – 93 тысячи квадратных метров! Это уже не дата-центр, это город для серверов. В нем трудится Cray XC30 – суперкомпьютер с мощностью 100 петафлопс в секунду. А в Чикаго есть Lakeside Technology Center площадью 102 тысячи квадратов. Этот ЦОД отслеживает динамику фондовых бирж. У него четыре магистральных канала связи, три источника питания и бассейн на три миллиона литров охлаждающей жидкости. Не дата-центр, а техно-спа!

Стараются не отставать и китайские ЦОДостроители. Гигант China Telecom Data Center занимает около миллиона квадратных метров! Этот как целый район, забитый серверами. Обошелся он инвесторам в $2,5 млрд и расположился в прохладной Внутренней Монголии. Причина выбора места – тут холодно большую часть года, так что оборудование охлаждается почти бесплатно. Гиперскейлеры ЦОД растут как грибы после дождя, с темпами более 13% в год. Эксперты полагают, что в 2025 году их количество перевалит за тысячу.

В нем совмещены функции инфоцентра и автоматического техконтроля.

Объект окружает стеклянная стена, которая задерживает проникающее тепло, таким образом снижая затраты на охлаждение систем.

Площадь – около 97 тыс. кв. метров.

В последние годы компании все чаще отказываются от своих локальных дата-центров и переходят на арендуемые площадки – это называется colocation. Такие центры предлагают все необходимое для своих клиентов: мощные каналы связи (10 Гбит/с и выше), высокую надежность (уровень Tier III) и минимизацию простоев. Но это лишь начало истории. Многие компании уже переходят на облачные решения. Зачем возиться с железом, если можно арендовать нужные мощности в облаке? Облака дают свободу от управления физической инфраструктурой и массу преимуществ: гибкость, масштабируемость и возможность платить исключительно за то, что используешь.

Сегодня colocation-операторы предлагают не только физическое пространство, но и умные решения. Например, можно комбинировать выделенные машины с облачной инфраструктурой, запускать контейнеры в Kubernetes, а резервные копии отправлять в распределенные хранилища, где они будут в безопасности.

В итоге арендуемые ЦОДы превращаются в нечто большее, чем обычные дата-центры. Они становятся платформами, которые обеспечивают отказоустойчивость, высокую скорость и, что самое важное, избавляют бизнес от лишней головной боли, позволяя сосредоточиться на главном.

Вот и получается, что бизнес операторов дата-центров процветает. Цифры говорят сами за себя: в 2022 году глобальные капиталовложения в дата-центры выросли на 15%, достигнув $241 млрд. Половину этого пирога «съели» десять крупнейших облачных провайдеров. А поставщик серверов номер один – Dell, – держит первенство, за ним идут HPE и Inspur.

Динамика развития российского рынка ЦОДов также внушительная. По данным исследования аналитической компании iKS-Consulting, рост стойко-мест в России в 2022 году составил 10,8%, в 2023-м – 20,7%, в 2024-м – более 17%. Однако и при таком массовом вводе стойко-мест в эксплуатацию ликвидировать их дефицит на рынке пока не удалось: спрос на новые стойко-места превышает предложение. Видимо, поэтому аналитики iKS-Consulting даже по пессимистическому сценарию прогнозируют рост российского рынка в 2025 году еще на 11,6%. Многие крупные компании заказывают стойко-места еще на стадии строительства и бронируют часть стоек на 1-2 года вперед, предусматривая расширение компании. А сегодня, если учесть «нашествие» искусственного интеллекта и кратный рост больших данных, расширение бизнесу точно понадобится.

Сжатие гиперскейлеров до размеров смартфона

Свой закон о том, что количество транзисторов на чипе будет удваиваться каждые два года, американский инженер Гордон Мур сформулировал в 1965 году. Но даже он не подозревал, что через несколько десятков лет эти транзисторы заполнят не только все чипы на планете, но и миллионы серверных полок в дата-центрах. Далее роль все увеличивающихся чипов по закону того же Мура уже будут играть центры обработки информации: раздуваясь до гиперскейлеров, они становятся такими же важными для людей, как и сама жизнь.

Если верить экспертам и футурологам, то через пару десятилетий дата-центры могут превратиться в сверхтехнологичные объекты. Основатель Dell Technologies Майкл Делл (Michael Saul Dell) предрекает дата-центрам гибридизацию – сочетание облачных технологий, edge computing (данные обрабатываются ближе к месту их создания) и квантовых вычислений. CEO Google Сундар Пичаи (Sundar Pichai) неоднократно подчеркивал, что будущее дата-центров связано с устойчивым развитием и энергоэффективностью. Технологический футуролог Джордж Гилдер утверждает, что квантовые вычисления радикально изменят ландшафт дата-центров. По его мнению, квантовые компьютеры смогут выполнять задачи, которые сейчас требуют огромных вычислительных мощностей, в формате гораздо более компактных устройствах. Он же считает, что оптические сети сделают дата-центры более эффективными и распределенными благодаря огромным скоростям и минимальным задержкам.

В технологической среде иногда высказываются мнения, что внедрение технологий, о которых сейчас идет речь, способно не просто уменьшить площади под строительство гиперскейлеров, а превратить дата-центры в устройство размером со смартфон. Конечно, можно представить себе картину, когда в кармане у человека маленький гаджет, а внутри него – целая сеть серверов, готовых в секунду обработать даже данные с орбитальной станции о движении галактик.

И, конечно, сегодня только ленивый не говорит о необходимости начать строить дата-центры на дне океана, в Арктике, в космосе, на Луне, Марсе и так далее. Как будут развиваться дата-центры – покажет время. Главное, это должно быть безопасным для отдельно взятого человека с ЦОДом в кармане – неизвестно же, сколько тепла он выделит, если вдруг займется расчетом траектории кометы, пролетающей мимо планеты Земля.

Автор: CrocInc