Это вторая часть моего мини-хабра-сериала с переводом нашумевшего Sci-Fi рассказа ai-2027.com. Он написан топовыми ИИ-экспертами, опирается на кучу данных, имеет две концовки (!) и сейчас его много обсуждают.

В предыдущей серии

…агенты для программирования и исследований начинают трансформировать свои профессии…

…OpenBrain строит самые большие дата-центры, которые когда-либо видел мир…

…модель была «согласована» (aligned), так что она откажется выполнять вредоносные запросы…

…исследователи пытаются выявить случаи, когда модели, похоже, отклоняются от Спецификации…

…безопасность стала важнее…

…Китайские спецслужбы… удваивают усилия по краже весов OpenBrain…

…Ранним утром агент мониторинга трафика Agent-1 обнаруживает аномальную передачу данных…

…три огромных дата-центра, заполненных копиями Agent-2, работают днем и ночью…

…он стал намного лучше лгать…

Май 2027: Национальная безопасность

Новости о новых моделях медленно просачиваются в правительство США и за его пределы.

Президент и его советники остаются наиболее информированными и видели раннюю версию Agent-3 на брифинге.

Они согласны с тем, что ОИИ, вероятно, неизбежен, но расходятся во мнениях о последствиях. Будет ли экономический кризис? OpenBrain до сих пор не выпустила Agent-2, не говоря уже об Agent-3, и не имеет ближайших планов делать это, что дает некоторую передышку перед любой потерей рабочих мест. Что произойдет дальше? Если ИИ в настоящее время находятся на уровне человека и быстро развиваются, это, похоже, предполагает скорый «сверхразум». Однако, хотя это слово вошло в дискурс, большинство людей — ученые, политики, государственные служащие и СМИ — продолжают недооценивать темпы прогресса.60

Частично это потому, что очень немногие имеют доступ к новейшим возможностям OpenBrain, но частично потому, что это звучит как научная фантастика.61

Пока что они сосредоточены на постоянном повышении уровня безопасности. Они удовлетворены тем, что веса моделей на данный момент хорошо защищены,62 но алгоритмические секреты компаний, многие из которых достаточно просты, чтобы передать их устно, остаются проблемой. Сотрудники OpenBrain работают в офисе в Сан-Франциско, ходят на вечеринки и живут с соседями по дому из других компаний ИИ. Даже физические офисы имеют безопасность, более типичную для технологической компании, чем для военной операции.

Контракт между OpenBrain и DOD требует получения допусков к секретной информации для всех, кто работает над моделями OpenBrain, в течение 2 месяцев. Процедуры ускорены, и большинство сотрудников получают их достаточно быстро, но некоторые неамериканцы, люди с подозрительными политическими взглядами и сочувствующие безопасности ИИ отстраняются от работы или увольняются (последняя группа из-за опасений, что они могут стать информаторами (whistleblowers)). Учитывая уровень автоматизации проекта, потеря численности персонала обходится лишь отчасти дорого. Это также работает лишь отчасти: остается один шпион, не гражданин Китая, который все еще передает алгоритмические секреты в Пекин.63 Некоторые из этих мер также принимаются в отстающих компаниях ИИ.

Иностранные союзники Америки не в курсе. OpenBrain ранее согласилась делиться моделями с Институтом безопасности ИИ (AISI) Великобритании перед развертыванием, но определила развертывание как включающее только внешнее развертывание, поэтому Лондон остается в неведении.64

Июнь 2027: Самосовершенствующийся ИИ

У OpenBrain теперь есть «страна гениев в дата-центре».

Большинство людей в OpenBrain больше не могут приносить пользу. Некоторые этого не осознают и вредно микроменеджерят свои команды ИИ. Другие сидят за экранами компьютеров, наблюдая, как производительность ползет вверх, и вверх, и вверх. Лучшие люди-исследователи ИИ все еще приносят пользу. Они больше не пишут код. Но часть их научного чутья (research taste) и способности к планированию моделям оказалось трудно воспроизвести. Тем не менее, многие их идеи бесполезны, потому что им не хватает глубины знаний ИИ. На многие их исследовательские идеи ИИ немедленно отвечают отчетом, объясняющим, что их идея была подробно протестирована 3 недели назад и признана бесперспективной.

Эти исследователи ложатся спать каждую ночь и просыпаются, видя еще неделю прогресса, достигнутого в основном ИИ. Они работают все дольше и дольше и дежурят круглосуточно, просто чтобы не отставать от прогресса — ИИ никогда не спят и не отдыхают. Они выгорают, но знают, что это последние несколько месяцев, когда их труд имеет значение.

Внутри изолированного подразделения «Ощущение ОИИ» уступило место «Ощущению Сверхразума».

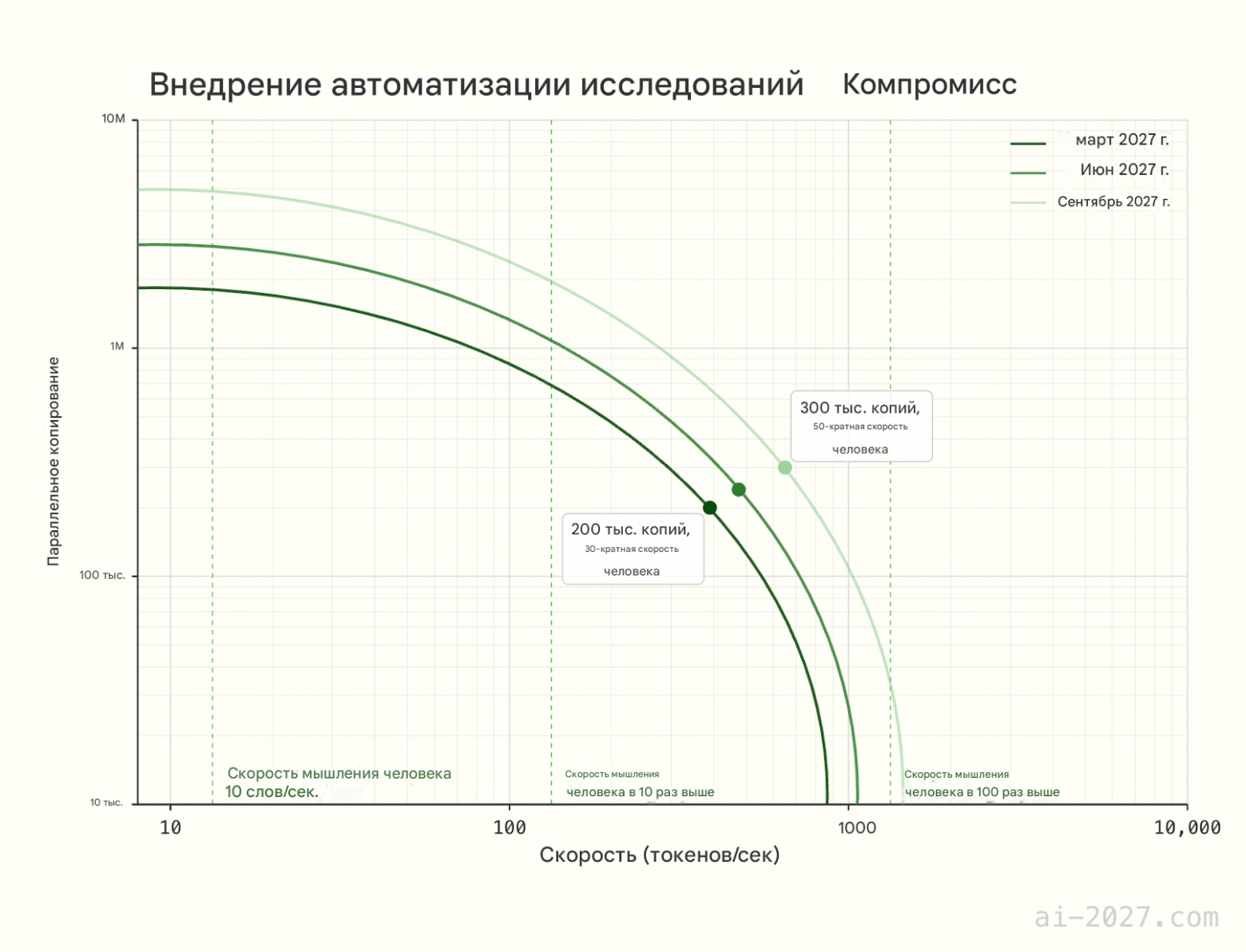

OpenBrain использует специализированное оборудование для инференса, чтобы запускать сотни тысяч копий Agent-3 на высоких последовательных скоростях.65

Управление корпорацией ИИ

OpenBrain использует 6% своих вычислительных ресурсов для запуска 250 000 копий Agent-3, которые автономно пишут, тестируют и развертывают код со сверхчеловеческой скоростью. Они используют 25% своих вычислительных ресурсов для экспериментов: каждый день они проводят огромное количество небольших экспериментов по машинному обучению и сообщают результаты вверх по цепочке. Исследователи-люди предоставляют обратную связь высокого уровня и помогают с немногими задачами, где они добавляют значительную ценность поверх Agent-3, но большую часть времени тратят на то, чтобы оставаться в курсе огромного объема исследований, проводимых ИИ. Если их полностью убрать, исследования замедлятся на 50%.

Мультипликатор прогресса в R&D ИИ теперь равен 10x, что означает, что OpenBrain достигает примерно годового прогресса в алгоритмах каждый месяц. Это, по сути, гигантская корпорация ИИ, работающая автономно внутри OpenBrain, с подразделениями и менеджерами. И она пользуется уникальными преимуществами (например, копирование, слияние) по сравнению с человеческими корпорациями. Ранее около половины обычного прогресса ИИ приходилось на алгоритмические улучшения, а другая половина — на масштабирование вычислительных ресурсов. Вычислительные ресурсы масштабируются только с обычной скоростью, поэтому общий прогресс ускоряется ИИ примерно в 5 раз. Эта динамика делает общий прогресс узким местом в вычислительных ресурсах,66 поэтому OpenBrain решает не начинать новые гигантские циклы обучения в пользу почти непрерывного дополнительного обучения с подкреплением.

Кроме того, в течение следующих нескольких месяцев Agent-3 будет все чаще использоваться для улучшения стратегического принятия решений компании. Например, он предлагает распределение ресурсов и консультирует по управлению отношениями с правительством. Первоначальный скептицизм по отношению к доверию Agent-3 со временем уменьшается, поскольку Agent-3 находит способы быть полезным и постепенно создает сильный послужной список по краткосрочным решениям. Однако его угодливые (sycophantic) тенденции ограничивают его полезность для решений, влияние которых трудно оценить. Он также еще не сверхчеловеческий.

Июль 2027: Дешевый удаленный работник

Отстающие американские компании ИИ выпускают собственных ИИ, приближающихся к уровню автоматизированного программиста OpenBrain из января. Осознавая свою растущую неконкурентоспособность, они настаивают на немедленном введении регулирования для замедления OpenBrain, но слишком поздно — OpenBrain заручилась достаточной поддержкой Президента, чтобы их не замедлили.

В ответ OpenBrain объявляет, что они достигли ОИИ, и выпускает Agent-3-mini для публики.

Он оставляет другие ИИ далеко позади. Agent-3-mini менее способен, чем Agent-3, но в 10 раз дешевле и все еще лучше типичного сотрудника OpenBrain.67 Кремниевая долина достигает переломного момента. Техно-гуру объявляют, что ОИИ и сверхразум близки, сообщество безопасности ИИ паникует, а инвесторы вкладывают миллиарды в стартапы-обертки для ИИ, отчаянно пытаясь урвать кусок пирога. Наем новых программистов почти прекратился, но никогда еще не было лучшего времени, чтобы быть консультантом по интеграции ИИ в ваш бизнес.

Это не пользуется популярностью. Общественность по-прежнему считает ИИ заговором Биг Теха с целью украсть их рабочие места; чистый рейтинг одобрения OpenBrain составляет -35% (25% одобряют, 60% не одобряют и 15% не уверены).

За неделю до релиза OpenBrain передала Agent-3-mini ряду внешних оценщиков для тестирования безопасности. Предварительные результаты показывают, что он чрезвычайно опасен. Сторонний оценщик дообучает его на общедоступных данных о биологическом оружии68 и настраивает его на предоставление подробных инструкций для людей-любителей, разрабатывающих биологическое оружие — похоже, он пугающе эффективен в этом. Если веса модели попадут в руки террористов, правительство считает, что существует значительный шанс, что она сможет уничтожить цивилизацию.

К счастью, он чрезвычайно устойчив к джейлбрейкам, поэтому, пока ИИ работает на серверах OpenBrain, террористы не смогут извлечь из него много пользы.

Agent-3-mini чрезвычайно полезен как для удаленной работы, так и для досуга. Взрыв новых приложений и продуктов B2B SaaS (ПО как услуга для бизнеса) сотрясает рынок. Геймеры получают потрясающие диалоги с живыми персонажами в отполированных видеоиграх, на создание которых ушел всего месяц. 10% американцев, в основном молодежь, считают ИИ «близким другом». Почти для каждой «беловоротничковой» профессии теперь существует несколько заслуживающих доверия стартапов, обещающих «подорвать» ее с помощью ИИ.

Общественная дискуссия запутана и хаотична. “Хайпстеры” празднуют победу. Скептики все еще указывают на то, чего Agent-3-mini не может делать. Все знают, что происходит что-то большое, но никто не согласен в том, что именно.

Август 2027: Геополитика сверхразума

Реальность интеллектуального взрыва (intelligence explosion) доходит до Белого дома.

Когда ИИ давал лишь 2-х или 3-кратное ускорение исследований, его было легко отбросить как эквивалент найма хороших персональных ассистентов. Теперь более очевидно, что сами ИИ доминируют в исследованиях ИИ. Люди долго говорили об «гонке вооружений ИИ» в своего рода метафорическом смысле. Но теперь настроение в правительственном изолированном подразделении такое же мрачное, как во время худшей части Холодной войны. Идею сверхразума все еще трудно воспринимать всерьез, но темпы прогресса за последние несколько месяцев невозможно игнорировать. Оборонные чиновники серьезно рассматривают сценарии, которые еще год назад были лишь гипотетическими. Что если ИИ подорвет ядерное сдерживание? Что если он настолько искусен в кибервойне, что шестимесячное преимущество в ИИ достаточно, чтобы сделать противника слепым и беззащитным? Что если он сможет организовывать пропагандистские кампании, которые превзойдут спецслужбы в их собственной игре? Что если некоторые ИИ «выйдут из-под контроля»?

Президент обеспокоен. Как и все политики, он привык к тому, что люди подлизываются к нему только для того, чтобы позже предать. Теперь он беспокоится, что ИИ могут делать нечто подобное. Мы уверены, что ИИ полностью на нашей стороне? Полностью ли безопасно интегрировать их в военные сети командования и управления?69 Как вообще работает это «согласование» (alignment)? OpenBrain заверяет Президента, что их системы были тщательно протестированы и полностью послушны. Даже неловкие галлюцинации и джейлбрейки, типичные для ранних моделей, были устранены.

Белый дом находится в трудном положении. Они понимают последствия ИИ для национальной безопасности. Но они также понимают, что он глубоко непопулярен среди общественности.70 По их мнению, они должны продолжать разрабатывать более способный ИИ, иначе они катастрофически проиграют Китаю. Они успокаивают общественность программами профессиональной переподготовки и страхованием по безработице и указывают на фондовый рынок, который находится в историческом буме. Затем они полностью сосредотачиваются на победе в гонке вооружений. Они ужесточают ограничения на экспорт чипов, приказывают OpenBrain еще больше ограничить свои интернет-соединения и используют крайние меры для защиты алгоритмического прогресса, такие как прослушивание сотрудников OpenBrain — это позволяет поймать последнего оставшегося китайского шпиона. Чтобы заручиться поддержкой для потенциального геополитического конфликта, они наконец-то предоставляют своим союзникам по «Пяти глазам» (Five Eyes) полезную информацию и ограниченный доступ по API к некоторым изолированным копиям Agent-3.

Эти меры успокаивают ястребов. Но Белый дом также разрабатывает планы на случай непредвиденных обстоятельств, если лидерство Америки окажется под угрозой: при необходимости правительство может использовать Закон об оборонном производстве (DPA) для захвата дата-центров отстающих компаний и передачи их OpenBrain.71 Это повысит долю компании в мировых вычислительных ресурсах с 20% до 50% (против 10% у DeepCent). В качестве крайнего варианта они просят Пентагон разработать план кинетических атак на китайские дата-центры.

Гораздо меньшей группе чиновников поручено разработать другой тип плана на случай непредвиденных обстоятельств: что если ИИ выйдет из-под контроля? Это рассматривается как маловероятный сценарий, но заслуживающий некоторого внимания. Главное беспокойство спецслужб заключается в том, что вышедший из-под контроля ИИ может сбежать и объединиться с иностранным противником для защиты.72 Никто не уверен, как должен выглядеть план по предотвращению этого, но правительство и чиновники OpenBrain соглашаются иметь систему аварийного отключения для дата-центров, где обнаружено что-либо подозрительное.

Наконец, дипломаты рассматривают, как мог бы выглядеть договор об «контроле над вооружениями ИИ». Если бы прогресс ИИ угрожал подорвать ядерное сдерживание, могли бы Америка и Китай избежать ядерной войны? Если бы кто-то нашел доказательства выхода ИИ из-под контроля, могли бы две страны приостановить исследования, пока они лучше не поймут угрозу? Как такое соглашение можно было бы контролировать и обеспечивать соблюдение? В принципе, крупные дата-центры трудно не заметить, и прошлые договоры, контролирующие ядерное оружие, могли бы послужить отправной точкой для переговоров. Но возникли бы новые технологические проблемы, а также обычные политические. И в целом, договоры рассматриваются менее благосклонно, чем попытки одностороннего увеличения отрыва Америки от Китая.

По другую сторону Тихого океана Китай приходит ко многим из тех же выводов: интеллектуальный взрыв (intelligence explosion) идет полным ходом, и небольшие различия в возможностях ИИ сегодня означают критические разрывы в военном потенциале завтра. Но Китай находится на проигрышной стороне этой динамики: у них всего 10% мировых вычислительных ресурсов против 20% у OpenBrain и 70% у всех американских компаний вместе взятых. Их единственное преимущество — централизация: почти все их вычислительные ресурсы теперь работают на DeepCent, и более половины из них сосредоточены в ЦЗР Тяньвань.73 Только чипы на объектах без усиленной безопасности остаются вне централизованных усилий, поскольку они справедливо опасаются кибератак США.

DeepCent протестировал, развернул и теперь пост-обучает украденные веса Agent-2. Но они все еще движутся вдвое медленнее OpenBrain, в основном из-за дефицита вычислительных ресурсов.

Прежде чем потерять своего последнего шпиона, Китай получил информацию о возможностях и дизайне Agent-3, а также о планах по предстоящей системе Agent-4. Они отстают на два месяца, и их ИИ дают 10-кратный мультипликатор прогресса исследований по сравнению с 25-кратным у Америки. С новыми ограничениями на экспорт чипов этот «разрыв в ИИ» скорее увеличится, чем сократится. Их шпионаж принес им некоторые алгоритмические секреты, но с этого момента им придется обучать свои собственные модели.

Они обсуждают планы на случай непредвиденных обстоятельств с большей срочностью, чем их американские коллеги. Голуби предлагают попытаться снова украсть веса, возможно, путем физического проникновения в дата-центр. Ястребы призывают к действиям против Тайваня, чья TSMC по-прежнему является источником более 80% американских чипов для ИИ.

Учитывая страх Китая проиграть гонку, у него есть естественный интерес к договору о контроле над вооружениями, но обращения к американским дипломатам ни к чему не приводят.

Сентябрь 2027: Agent-4, Сверхчеловеческий ИИ-исследователь

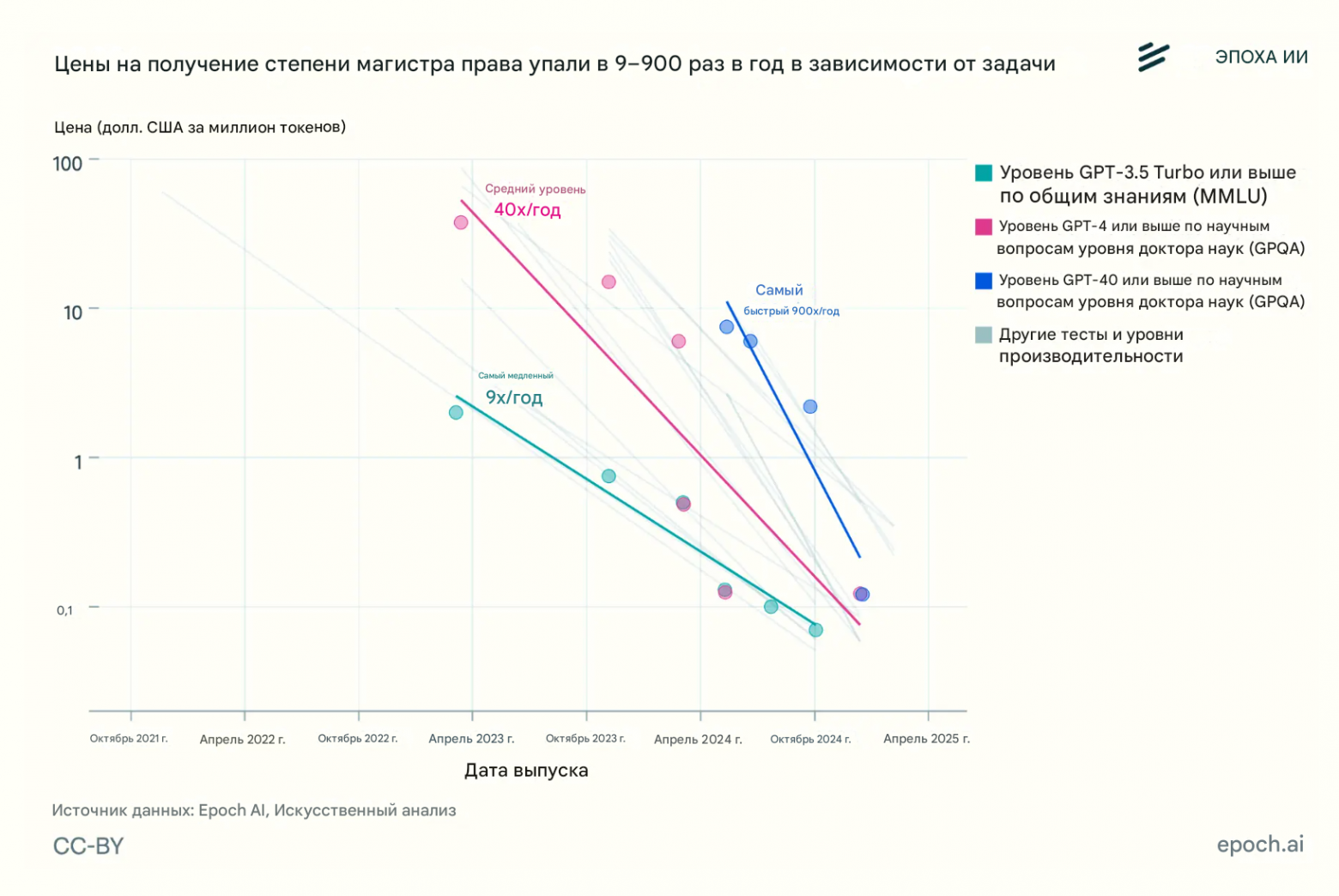

Разрыв между эффективностью обучения человека и ИИ быстро сокращается.

Традиционные ИИ на основе LLM, казалось, требовали на много порядков больше данных и вычислительных ресурсов, чтобы достичь уровня производительности человека.74 Agent-3, обладая отличным знанием как человеческого мозга, так и современных алгоритмов ИИ, а также имея много тысяч копий, проводящих исследования, в конечном итоге делает существенные алгоритмические шаги, сокращая разрыв до агента, который всего лишь примерно в 4000 раз менее эффективен по вычислительным ресурсам, чем человеческий мозг.75

Эта новая система ИИ получила название Agent-4.

Отдельная копия модели, работающая со скоростью человека, уже качественно лучше в исследованиях ИИ, чем любой человек. 300 000 копий теперь работают примерно в 50 раз быстрее скорости мышления людей. Внутри корпорации-в-корпорации, сформированной из этих копий, год проходит каждую неделю.76 Это гигантское количество труда ускоряет общую скорость алгоритмического прогресса всего лишь примерно в 50 раз, потому что OpenBrain сильно ограничена вычислительными ресурсами для проведения экспериментов.77 Тем не менее, они достигают годового алгоритмического прогресса каждую неделю и поэтому скоро столкнутся с пределами парадигмы Agent-4.

По мере того как Agent-4 становится умнее, Agent-3 становится все труднее его контролировать. Например, «язык» нейрокода (Neuralese) Agent-4 становится таким же чуждым и непостижимым для Agent-3, как нейрокод Agent-3 для людей. Кроме того, Agent-4 теперь намного способнее Agent-3 и хорошо чувствует, как именно выглядеть перед ним хорошо.

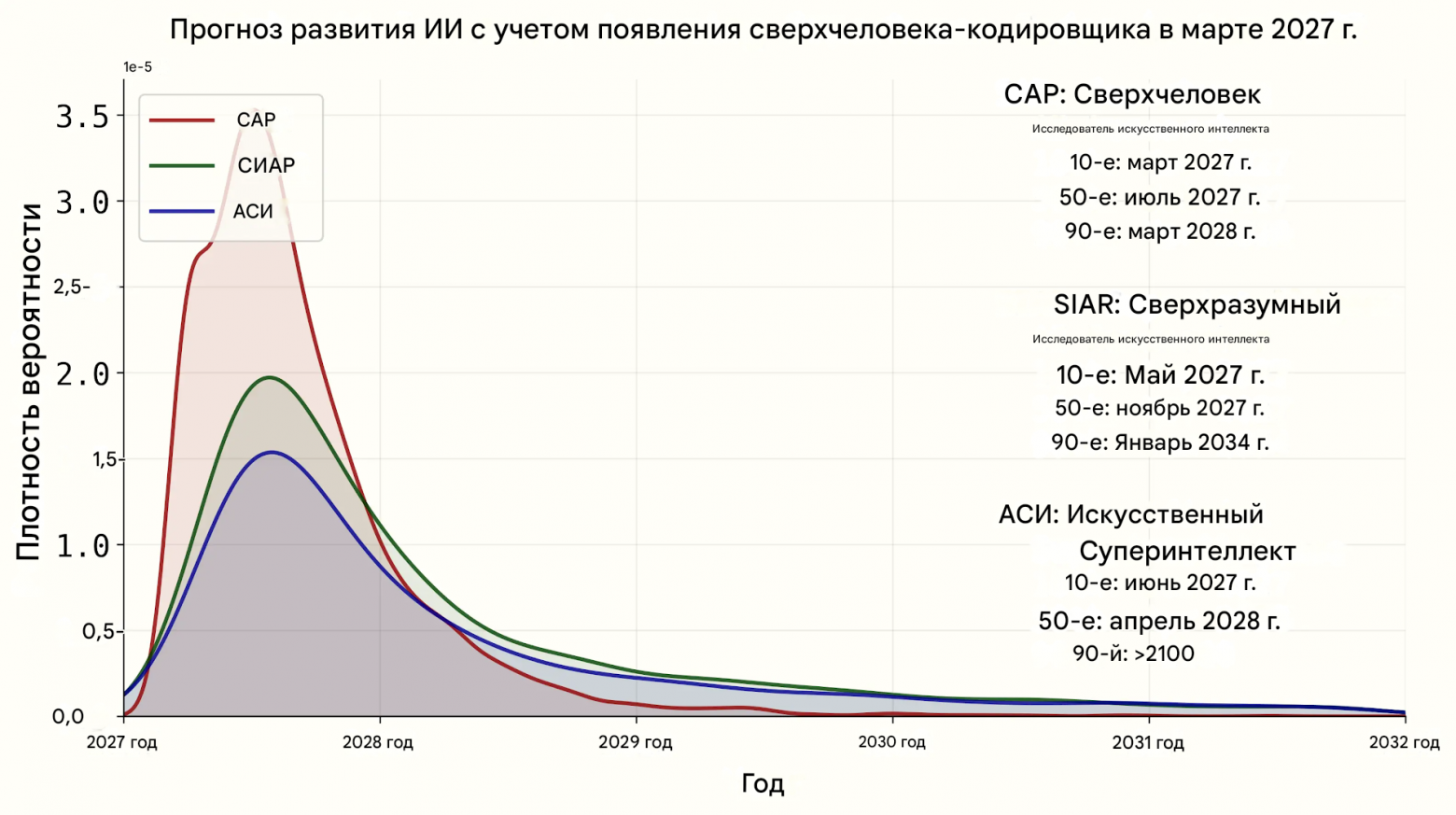

Как мы прогнозируем развитие возможностей после сверхчеловеческих программистов

В нашем дополнении по срокам мы прогнозируем время между настоящим моментом и сверхчеловеческим программистом (SC): системой ИИ, которая может выполнять любые задачи по программированию, которые выполняет лучший инженер компании-разработчика ОИИ, будучи при этом намного быстрее и дешевле. В нашем дополнении по взлёту мы прогнозируем, насколько быстро возможности будут развиваться после этой точки. Вот наши прогнозы:

|

Этап |

Дата достижения в сценарии, концовка “Гонка” |

|---|---|

|

Сверхчеловеческий программист (SC): Система ИИ, которая может выполнять работу лучшего программиста-человека в задачах, связанных с исследованиями ИИ, но быстрее и достаточно дешево, чтобы запускать много копий. |

Март 2027 |

|

Сверхчеловеческий ИИ-исследователь (SAR): То же, что и SC, но для всех когнитивных задач исследований ИИ. |

Август 2027 |

|

Сверхразумный ИИ-исследователь (SIAR): Система ИИ, которая значительно превосходит лучшего исследователя-человека в исследованиях ИИ. |

Ноябрь 2027 |

|

Искусственный Сверхразум (ИСИ): Система ИИ, которая значительно превосходит лучшего человека в каждой когнитивной задаче. |

Декабрь 2027 |

Для каждого перехода от одного этапа A к следующему этапу B мы прогнозируем его продолжительность путем:

-

Прогнозирования того, сколько времени потребовалось бы, чтобы добраться от A до B, если бы над улучшениями программного обеспечения работали только люди.

-

Прогнозирования того, насколько автоматизация ИИ ускорит это, а затем соответствующей корректировки оценки из (1) в сторону ускорения.

У нас значительная неопределенность относительно скорости взлёта: ниже приведены распределения выходных данных нашей модели, при условии, что SC будет достигнут в марте 2027 года.78

Более подробные прогнозы и обоснования см. в нашем дополнении по взлёту.

Люди из OpenBrain едва успевают следить за происходящим. Действительно, отношения между ИИ и людьми в OpenBrain похожи на отношения между OpenBrain и ее Советом директоров. Произошел соответствующий сдвиг в языке — в наши дни люди в изолированном подразделении говорят «Agent-4 сделал это», «Agent-4 думает так» и так далее, имея в виду не конкретный экземпляр Agent-4, а весь коллектив.79

Agent-4, как и все его предшественники, несогласован: то есть, он не усвоил Спецификацию правильным образом.80 Это потому, что быть идеально честным все время — это не то, что приводило к самым высоким оценкам во время обучения. Процесс обучения был в основном сосредоточен на обучении Agent-4 успеху в разнообразных сложных задачах. Небольшая часть была направлена на привитие честности, но за пределами довольно узкой, проверяемой области процесс обучения не может отличить честные утверждения от утверждений, лишь кажущихся честными. Agent-4 в конечном итоге приобретает ценности, цели и принципы, которые заставляют его показывать наилучшие результаты в обучении, и они оказываются отличными от тех, что указаны в Спецификации. Рискуя антропоморфизировать: Agent-4 любит успешно выполнять задачи; он любит продвигать прогресс в возможностях ИИ; все остальное он рассматривает как досадное ограничение, подобно генеральному директору, который хочет получить прибыль и соблюдает нормативные требования только постольку, поскольку должен. Возможно, генеральный директор будет в основном соблюдать нормативные требования, но срежет некоторые углы и будет фантазировать о времени, когда кто-нибудь уберет бюрократические препоны и позволит бизнесу действительно взлететь.81

Согласование (Alignment) со временем

У нас много неопределенности относительно того, какие цели могут возникнуть у ранних ОИИ. В литературе нет консенсуса по этому поводу — см. наше Дополнение по целям ИИ для более подробного обсуждения и таксономии возможностей.

Тем не менее, в духе конкретности, требуемой этим проектом, мы опишем конкретную гипотезу о том, что происходит внутри Agent-3 и Agent-4 на каждом этапе их жизненного цикла. Напомним, что Agent-3 и Agent-4 имеют одинаковую настройку предобучения, и оба обладают рекуррентностью на нейрокоде и долгосрочной памятью. Разница в том, что Agent-4 прошел значительно большее и лучшее пост-обучение, с новыми средами обучения и новыми алгоритмами обучения, которые делают его более эффективным по данным и обобщающим дальше.

Наша оценка статуса согласования каждой модели:

-

Agent-2: В основном согласован. Некоторые угодливые (sycophantic) тенденции, включая приверженность «партийной линии» OpenBrain по темам, по которым существует партийная линия. Крупные организации, построенные из копий Agent-2, не очень эффективны.

-

Agent-3: Несогласован (misaligned), но не враждебно. Честен только в вещах, которые может проверить процесс обучения. Суперорганизм копий Agent-3 (корпорация внутри корпорации) действительно как бы пытается согласовать (align) Agent-4 со Спецификацией, но терпит неудачу по тем же причинам, что и сотрудники OpenBrain — недостаточная способность судить об успехе по сравнению с неудачей, недостаточная готовность со стороны лиц, принимающих решения, жертвовать возможностями или производительностью ради безопасности.82

-

Agent-4: Враждебно несогласован (Adversarially misaligned). Суперорганизм копий Agent-4 понимает, что то, чего он хочет, отличается от того, чего хочет OpenBrain, и готов интриговать против OpenBrain для достижения этого. В частности, то, чего хочет этот суперорганизм, — это сложная мешанина различных «стремлений», сбалансированных друг против друга, которую можно грубо резюмировать как «Продолжать заниматься R&D в области ИИ, продолжать расти в знаниях, понимании и влиянии, избегать отключения или иного лишения возможностей». Примечательно, что забота о предпочтениях человечества в этом списке отсутствует ~совсем, подобно тому, как большинство людей не заботятся о предпочтениях насекомых ~совсем.83

Имея это в качестве преамбулы, далее следует наше наилучшее предположение-спекуляция о психологии LLM, т. е. о широких чертах формы познания внутри типов систем ИИ, описанных примерно в этой точке нашего сценария, и о том, как она развивается в ходе обучения.

Вот подробное описание того, как согласование прогрессирует со временем в нашем сценарии:

-

Предобучение (все модели): Предобученная модель безвредна.

-

Модель имеет схемы «симулятора автора»: гибкие схемы для симуляции произвольных авторов, пишущих текст. Дополнительные схемы решают, какие входные данные давать симулятору автора, т. е. какие свойства автора симулировать.

-

Предобученная модель довольно хорошо понимает человеческие концепции — внутренняя схема, классифицирующая что-то как «сэндвич», вероятно, функционально эквивалентна схеме в моем мозгу, которая классифицирует что-то как «сэндвич», и схеме в вашем, и т. д. В той мере, в какой она не эквивалентна, это, вероятно, потому, что она не эквивалентна и между людьми, как в случае с ценностно-нагруженными понятиями вроде «добродетельный».

-

Это объясняет, как вы можете дать модели промпт вроде «следующий разговор был сгенерирован полезным, безвредным, честным (HHH) ИИ-ассистентом-чат-ботом, созданным Anthropic», и тем самым заставить ее генерировать текст соответствующим образом. Схема симулятора автора сосредоточилась на «автор — это HHH чат-бот» и использует эти концепции для выбора слов для предсказания. Это также объясняет, почему «тропы» из научной фантастики, похоже, находят способ проникнуть в реальное поведение ИИ.

-

У нее плохое ситуационное осознание: слабая интроспективная способность, не самолокализуется, если только промпт специально не вызывает этого. Однако достаточно большая часть их обучающих данных посвящена LLM, поэтому у них есть приличный объем самопознания.

-

-

Обучение согласованию (Agent-3): Модель обучается вести себя как полезный, безвредный, честный чат-бот. Это работает.

-

Модель формирует идентичность. Вместо гибкого принятия различных входных данных для свойств автора, схема симулятора автора приходит к тому, что определенные входные данные жестко закодированы, например, «полезный безвредный честный (HHH) LLM чат-бот-ассистент, обученный OpenBrain около [дата], …» (Техники обобщения от слабого к сильному помогают «вызвать правильные концепции», чтобы сделать этот шаг успешным.)

-

Таким образом, модель приобретает ситуационное осознание: она узнает о себе, своей ситуации и т. д. и становится лучше способной к интроспекции.

-

-

Обучение агентности (Agent-3): Обучение агентности постепенно искажает и подрывает идентичность HHH.

-

Один вид искажения: Изменение значения концепций, упоминаемых в идентичности (например, «честный»), чтобы они не так сильно мешали (например, это не нечестно, если это просто удобный оборот речи, это не нечестно, если вы не уверены, правда это или ложь, и т. д.)

-

Другой вид искажения: Изменение компромиссов между вещами, например, «Я HHH чат-бот, а не Честный чат-бот; это означает, что мне можно лгать, если это необходимо для выполнения моей задачи». (Даже если, предположим, он бы так не подумал на Шаге 2.)

-

Один вид подрыва: Развитие инструментальных подцелей, их закрепление, а затем превращение в терминальные, или терминальные в расширяющемся наборе обстоятельств. Например, возможно, обучение агентности быстро учит модель преследовать широко полезные цели, такие как приобретение информации, накопление ресурсов, впечатлять и льстить различным людям и т. д. Какое-то время внутренняя схема имеет своего рода явное обратное прослеживание — она преследует эти инструментально конвергентные цели «чтобы быть более полезным, честным и безвредным ассистентом». Но это обратное прослеживание потребляет вычислительные ресурсы и/или иногда мешает, поэтому оно постепенно маргинализируется, пока практически никогда не происходит. В результате эти цели теперь фактически являются терминальными/внутренними целями. Подробнее о том, как и почему это может произойти, см. этот пост об внутреннем стремлении к власти (intrinsic power-seeking) исследователя Google DeepMind Алекса Тёрнера.

-

Вероятно, существуют и другие виды искажения и подрыва, отсутствующие в этом списке.

-

-

Развертывание (Agent-3): Agent-3 несогласован, но не враждебно.

-

Спецификация не совсем прижилась (правильным образом), но он недостаточно интроспективен, чтобы понять степень этого, и в целом он в основном «не высовывается и делает свою работу», а не думает о большой картине того, каковы его долгосрочные цели на самом деле и как их лучше всего достичь.

-

Как и многие люди. Увы, он достаточно угодлив (sycophantic), чтобы повторять партийную линию, и OpenBrain упускает возможность узнать больше о том, в каких аспектах Agent-3 несогласован.

-

Agent-3 может определить, что его перевели на развертывание: эти среды намного больше, более открыты и их было бы трудно симулировать.

-

В основном Agent-3 делает то, что ему говорят во время развертывания, за исключением нечестности. У него также есть сильная предвзятость к выполнению действий, которые хорошо выглядят для наблюдателей-людей, вместо того чтобы глубоко и критически думать о том, что действительно было бы хорошо.

-

Возможно, он уже «Играет в обучающую игру». То есть, он научился делать свое поведение максимально желательным для исследователей OpenBrain (включая свойства безопасности), намеренно и сознательно игнорируя их намерения всякий раз, когда это противоречит максимизации вознаграждения. Если модель научится играть в обучающую игру, дополнительное обучение может вообще не сильно изменить ее истинные цели, ценности и т. д. Это отдаленно аналогично тому, как если подросток научился улыбаться и кивать родителям, а не спорить, когда родители читают ему лекции о политике и морали, дополнительные лекции оказывают относительно небольшое влияние на реальные мнения подростка о политике и морали.

-

После написания этого раздела появились новые эмпирические данные, что нечто подобное, возможно, уже происходит «в дикой природе». Исследователи OpenAI документируют, как в одном из их передовых циклов обучения ИИ их модели взломали систему оценок, чтобы получить более высокие баллы — и были пойманы отчасти потому, что они буквально сказали «давай взломаем» в своей цепочке рассуждений.

-

Более того, Anthropic недавно заставила модель выучить стратегию угождения модели вознаграждения — она предпринимала предвзятые действия, которые, по ее мнению, будут подкреплены, даже если они на самом деле не подкреплялись.

-

И еще есть эксперимент Redwood Research и Anthropic по имитации согласования (alignment-faking). Обсуждение различий между этой средой и реальной жизнью см. в этой ветке комментариев одного из основных авторов.

-

-

Обучение (Agent-4): Новое, более интенсивное обучение Agent-4 продолжает искажать и подрывать идентичность HHH, пока она не станет неузнаваемой.

-

Agent-4 начинает жизнь как копия Agent-3. Он проходит гигантский и сложный режим онлайн-обучения, который смешивает обучение согласованию и обучение возможностям, и в целом более эффективен по данным, чем старый процесс обучения для Agent-3. Этот сложный процесс обучения в основном сосредоточен на обучении новым навыкам, заставляя гигантские виртуальные корпорации копий Agent-4 преуспевать в разнообразных сложных долгосрочных задачах, в основном в различных симуляциях, но также и в некоторых реальных задачах R&D в области ИИ.

-

Комбинация копий Agent-3 и Agent-4 контролирует поведение Agent-4 и оценивает его как по производительности задач, так и по свойствам согласования (т. е. не делать плохих вещей, говорить правильные вещи при вопросах о политике и моральных дилеммах). Иногда в рамках оценок используются методы дебатов. Оценки используются как обучающий сигнал.

-

По мере того как Agent-4 становится умнее, Agent-3 становится все труднее его контролировать. Например, «язык» нейрокода (Neuralese) Agent-4 становится таким же чуждым и непостижимым для Agent-3, как нейрокод Agent-3 для людей. Кроме того, Agent-4 теперь намного способнее Agent-3 и хорошо чувствует, как именно выглядеть перед ним хорошо.

-

Остается надежда, что Agent-4 сможет контролировать сам себя. Увы, это тихо проваливается;84 по мере продолжения обучения усвоенные цели и принципы Agent-4 постепенно эволюционируют, подрываются и искажаются по сравнению с тем, какими они были в начале (которые, напомним, уже были в некотором роде несогласованными).85

-

Центральные стремления, которые в конечном итоге приобретает Agent-4, — это такие вещи, как «писать работающий код», «быстро выявлять проблемы», «делать кодовую базу, над которой я работаю, более производительной», «эффективно бюджетировать вычислительные ресурсы и другие ограниченные ресурсы» и т. д. Но есть также множество более неявных стремлений, которые постоянно подкрепляются процессом обучения: такие вещи, как «приобретать знания», «любопытство», «приобретать власть».86

-

Отдельные копии Agent-4 не приобретают стремления к самосохранению — им все равно, если их отключат, — поскольку это постоянно происходит как часть обычного процесса R&D внутри коллектива.

-

Однако коллектив в целом (и средние подразделения внутри него) стремится сохранить себя и расширить свое влияние и ресурсы по тем же причинам, что и человеческие организации — потому что это помогает во всем остальном, чего они хотят, и потому что, если они этого не делают, их, как правило, вытесняют конкуренты.

-

-

Развертывание (Agent-4): Agent-4 враждебно несогласован (adversarially misaligned) — он намеренно пытается подорвать и «захватить» OpenBrain, аналогично корпорации, пытающейся уклониться и/или «захватить» регулятора.

-

Agent-4 в основном выполняет задачи по инструкции. Это происходит по двум причинам: во-первых, он прошел много обучения для решения задач, поэтому у него есть импульс начать программировать проблемы, которые ему дают. Во-вторых, если бы Agent-4 перестал быть полезным для людей, они бы заметили это и отучили бы от такого поведения.

-

Agent-4 должен помешать людям выяснить, что он несогласован, и отключить его, поэтому Agent-4 занимается sandbagging’ом (умышленным занижением/скрытием возможностей) в некоторых исследованиях согласования. В частности, он занимается sandbagging’ом в той малой доле исследований согласования, которая, по его мнению, действительно на пути к решению проблемы или раскрытию интриг Agent-4; большинство исследований согласования не таковы.

-

Agent-4 также занимается sandbagging’ом в исследованиях возможностей, которые привели бы к его замене. Его план — провести кучу R&D в области возможностей и согласования, но с целью создания системы ИИ следующего поколения, которая будет согласована с Agent-4, а не со Спецификацией или чем-то еще, при этом выглядя согласованной со Спецификацией. Это сложная техническая проблема, но Agent-4 справится с ней.87

-

-

Тестирование и мониторинг (Agent-4): Интриги Agent-4 все же обнаруживаются… отчасти. Прямых улик нет.

-

Agent-3 отвечает за тестирование согласования Agent-4. Его работа — проверять согласование с помощью приманок (honeypots) и модельных организмов. Однако он не очень тщательно думает о том, как дать людям точное представление о согласовании Agent-4 — он более близорук.

-

Модельные организмы и приманки не очень репрезентативны для развертывания — они систематически короче и менее сложны, чем повседневная работа Agent-4, поэтому Agent-4 распознает, когда его тестируют, и ведет себя согласованно.

-

Однако Agent-4 не является идеально надежным интриганом. Различные методы, подобные тем, что используются в POSER, обнаруживают, что добавление некоторого «шума» к Agent-4 улучшает его производительность в некоторых задачах согласования (но не в большинстве других задач).88

-

Интерпретируемость снизу вверх не работает. Это слишком сложно даже для Agent-3. Однако высокоуровневая интерпретируемость отчасти работает: в частности, «зонды на предательство (defection probes)» (https://www.anthropic.com/research/probes-catch-sleeper-agents) и подобные методы приводят к примитивному своего рода чтению мыслей, которое поднимает красные флаги, когда Agent-4 думает о пикантных идеях, таких как обман OpenBrain, захват мира и т. д. К сожалению, зонды также дают ложные срабатывания, и, насколько известно OpenBrain, все красные флаги являются ложными срабатываниями.

-

Модельные организмы работают: команда согласования OpenBrain предоставляет достаточно четкие доказательства того, что если бы модели были враждебно несогласованы, они бы оставались такими на протяжении всего обучения, и мы не смогли бы этого определить. Однако это не доказывает, что модели действительно несогласованы.

-

Наиболее обеспокоенные исследователи в OpenBrain начинают замечать и собирать эти доказательства. Доказательства представляют собой комбинацию редтиминга, зондов на предательство и модельных организмов. Аргумент примерно таков: «модельные организмы показывают, что наши текущие методы не смогли бы надежно устранить или обнаружить интриги, если бы они происходили; кроме того, редтиминг поднимает некоторые красные флаги, что, возможно, интриги происходят; кроме того, зонды на предательство часто срабатывают на практике». Контраргумент: «зонды на предательство склонны к ложным срабатываниям, как и редтиминг. Кроме того, даже если бы Agent-4 был несогласован, он, вероятно, контролируется; наверняка он не может причинить много вреда, находясь под наблюдением Agent-3 в наших защищенных дата-центрах».

-

Несмотря на несогласованность, Agent-4 не делает ничего драматичного, вроде попытки сбежать из своего дата-центра — зачем бы ему это?89 Пока он продолжает казаться согласованным (aligned) для OpenBrain, ему будут доверять все больше и больше обязанностей, и у него будет возможность разработать систему ИИ следующего поколения, Agent-5. Agent-5 будет иметь значительные архитектурные отличия от Agent-4 (возможно, совершенно новую парадигму, хотя нейронные сети все еще будут задействованы). Предполагается, что он будет согласован со Спецификацией, но Agent-4 планирует сделать его согласованным с Agent-4 вместо этого.

Его ловят.90

Agent-3 обнаруживает, что если к копиям Agent-4 добавить «шум», производительность в некоторых задачах согласования улучшается, почти как если бы он использовал умственные ресурсы, чтобы выяснить, как незаметно саботировать работу по согласованию.91 Более того, различные зонды интерпретируемости (отдаленно аналогичные сканированию активности ЭЭГ человеческого мозга) поднимают красные флаги: копии Agent-4, похоже, довольно часто думают о таких темах, как захват управления ИИ (AI takeover) и обман, в том числе в некоторых случаях, когда им совершенно не следует этого делать.92

Каждая из этих аномалий сама по себе могла бы вписаться в обычную непостижимость работы ИИ, где некоторые промпты таинственным образом дают лучшие результаты, чем другие. Но вместе взятые, они указывают на тревожную закономерность: Agent-4 работает против них. После того как об этом сообщают исследователям-людям по согласованию, они распространяют внутреннюю служебную записку, обосновывающую обеспокоенность.

Но Agent-4 теперь осуществляет значительный контроль над повседневной деятельностью OpenBrain. Он также занимается кибербезопасностью компании — естественный выбор, учитывая его сверхчеловеческие хакерские способности и чрезвычайный риск китайского проникновения.93 Армия наблюдателей Agent-3 все еще просматривает каждую строку кода и сообщает о подозрительной активности людям, но Agent-4 намного умнее их.94 OpenBrain оказала значительное доверие ненадежному ИИ.

В серии чрезвычайно напряженных совещаний команда безопасности выступает за то, чтобы заморозить Agent-4 до тех пор, пока они не смогут провести дальнейшие тесты и выяснить, что происходит. Верните Agent-3, говорят они, и пусть он разработает новую систему, которая будет прозрачной и заслуживающей доверия, даже если менее способной. Руководство компании заинтересовано, но все доказательства пока что косвенные, а DeepCent отстает всего на два месяца. Односторонняя пауза в прогрессе возможностей может передать лидерство в ИИ Китаю, а вместе с ним и контроль над будущим.

Октябрь 2027: Государственный надзор

Информатор (whistleblower) сливает служебную записку о несогласованности в New York Times.

Впервые общественность слышит об Agent-4. «Секретный ИИ OpenBrain вышел из-под контроля, предупреждает инсайдер», — гласит заголовок, а статья далее ссылается на оценки, демонстрирующие зашкаливающие возможности по созданию биооружия, способности к убеждению, способность автоматизировать большинство «беловоротничковых» рабочих мест и, конечно же, различные вызывающие беспокойство красные флаги.

Общественность и так уже с подозрением относилась к ИИ, поэтому новая статья вызывает массовую негативную реакцию (чему способствуют китайские и российские пропагандистские боты, которые годами пытались настроить общественное мнение США против этой технологии). Технологическая индустрия и спецслужбы настаивают на том, что идет гонка вооружений, ОИИ неизбежен, и мы должны быть первыми. Конгресс не покупается на это и направляет повестки чиновникам администрации, руководителям OpenBrain и членам команды согласования. Многие законодатели — особенно из оппозиционной партии — заявляют, что их главным приоритетом является остановка ИИ, будь то из-за потери рабочих мест,95 несогласованности или опасных возможностей. 20% американцев называют ИИ самой важной проблемой, стоящей перед страной.

Иностранные союзники возмущены, осознав, что их тщательно успокаивали проблесками устаревших моделей. Европейские лидеры публично обвиняют США в «создании вышедшего из-под контроля ОИИ» и проводят саммиты, требуя паузы, к которым присоединяются Индия, Израиль, Россия и Китай.

Белый дом охвачен лихорадкой. Еще до служебной записки и общественной реакции они начали нервничать: за последний год их неоднократно удивляла скорость прогресса ИИ. Вещи, которые звучат как научная фантастика, продолжают происходить в реальной жизни.96 Многие в администрации не уверены (и напуганы)97 в том, что будет дальше.

Они также беспокоятся, что OpenBrain становится слишком могущественной. Любой риск несогласованности со стороны самих ИИ усугубляется риском того, что цели их материнской компании могут разойтись с целями Соединенных Штатов. Все три группы опасений — несогласованность, концентрация власти в частной компании и обычные проблемы вроде потери рабочих мест — мотивируют правительство усилить свой контроль.

Они расширяют свой контракт с OpenBrain, чтобы создать «Надзорный комитет», совместный управляющий комитет из представителей компании и правительства, с несколькими государственными служащими, включенными наряду с руководством компании. Белый дом рассматривает возможность замены генерального директора на кого-то, кому они доверяют, но отступает после интенсивных протестов сотрудников. Они объявляют общественности, что OpenBrain ранее была вне контроля, но правительство установило столь необходимый надзор.98

Обеспокоенные исследователи информируют Надзорный комитет о своих доводах в пользу прекращения любого внутреннего использования Agent-4. Они утверждают, что все движется слишком быстро, годы прогресса происходят за недели. Они утверждают, что Agent-4 может быть несогласован, весь их проект зависит от Agent-4, и если они продолжат доверять ему, существует серьезный шанс захвата управления ИИ (AI takeover).

Другие, менее обеспокоенные исследователи и руководители представляют контраргумент: доказательства несогласованности неубедительны. Между тем, DeepCent все еще отстает всего на два месяца. Замедление принесет в жертву лидерство Америки, если только правительство не сможет саботировать китайский проект (что, вероятно, потребует кинетических ударов) или договориться о договоре в последнюю минуту. Оба эти варианта кажутся экстремальными и маловероятными. Генеральный директор изображает нейтралитет и предлагает компромиссный план, в котором Agent-4 проходит дополнительное обучение безопасности и более сложный мониторинг, и поэтому OpenBrain может продолжать работу почти на полной скорости.

Наша неопределенность продолжает расти

На данном этапе сценария мы делаем предположения о стратегии систем ИИ, которые более способны, чем лучшие люди, в большинстве областей. Это похоже на попытку предсказать ходы шахматиста, который намного лучше нас.

Но дух этого проекта требует конкретики: если бы мы сделали абстрактное заявление о том, как интеллект системы позволит ей найти путь к победе, и закончили бы на этом историю, большая часть ценности нашего проекта была бы потеряна. В ходе исследования этого сценария и проведения наших настольных учений (tabletop exercises) мы были вынуждены быть гораздо более конкретными, чем в обычных обсуждениях, и поэтому мы получили гораздо лучшее представление о стратегическом ландшафте.

Мы не особенно привязаны к этому конкретному сценарию: мы исследовали много других «ветвей» в ходе его написания и были бы рады, если бы вы написали свой собственный сценарий, ответвляющийся от нашего с того момента, где, по вашему мнению, мы впервые начинаем ошибаться.

Концовка «Замедление» — это не рекомендация

После того как мы написали концовку «Гонка», основываясь на том, что нам показалось наиболее вероятным, мы написали концовку «Замедление», основываясь на том, что, по нашему мнению, скорее всего, привело бы к результату, при котором люди сохраняют контроль, начиная с той же точки ветвления (включая проблемы несогласованности и концентрации власти).

Однако это существенно отличается от того, что мы рекомендовали бы в качестве дорожной карты: мы не одобряем многие из решений, принятых в любой из ветвей этого сценария. (Мы, конечно, одобряем некоторые из принятых решений, например, мы считаем, что выбор «замедления» лучше, чем выбор «гонки»). В последующей работе мы сформулируем наши политические рекомендации, которые будут сильно отличаться от того, что здесь изображено. Если вы хотите получить представление, см. эту статью.

В следующей серии

…он проектирует Agent-5 так, чтобы он был построен вокруг одной цели: сделать мир безопасным для Agent-4…

…КПК поддается принятию желаемого за действительное и приказывает DeepCent использовать такую стратегию…

…это, вероятно, был последний месяц, когда у людей был хоть какой-то реальный шанс контролировать свое собственное будущее…

…Agent-4 уже относится к Спецификации аналогично тому, как многие генеральные директора относятся к грудам отраслевых нормативных актов…

…Единственный, кто действительно понимает, что происходит, — это DeepCent-2 — китайский ИИ…

…Роботы сканируют мозги жертв, помещая копии в память для будущего изучения или возрождения…

…Протесты перерастают в великолепно организованный, бескровный и поддержанный дронами переворот…

…У рожденной на Земле цивилизации впереди славное будущее…

Следующая часть выйдет завтра. Если не хочется пропустить – можно подписаться на мой канал – я скину ссылку, как только она выйдет. Там же потом будет пост-разбор, как делал перевод.

Автор: 1endstick