Всем привет!

Меня зовут Александр, я COO в SaaS-платформе аналитики данных. Последний год активно изучаю внедрение AI-решений в кросс-функциональные процессы. Делюсь материалами, которые помогают:

-

Продуктовым менеджерам — интегрировать AI без перегрузки команд;

-

Разработчикам — выбирать инструменты под конкретные бизнес-задачи;

-

Специалистам по данным — избегать ошибок в production-развертывании.

У себя в телеграм-канале делюсь сжатыми и структурированными саммери статей.

Сегодняшний перевод — When machines learn to speak

Статья исследует фундаментальный сдвиг в технологиях голосового ИИ, произошедший благодаря переходу от каскадных архитектур к прямым speech-to-speech моделям и радикальному снижению стоимости API. Выделяется несколько ключевых проблем: сложность обработки прерываний собеседника, культурные различия в коммуникации и потенциальное влияние на межличностные навыки людей.

Главный практический результат — доступность технологии через простой API-вызов позволяет разработчикам создавать решения для автоматизации продаж, клиентской поддержки и медицинского скрининга, что открывает огромное окно возможностей для стартапов и корпораций в сфере голосового взаимодействия.

Июнь 2025 года. Сара ходит по гостиной, репетируя важную презентацию для клиента. Ее ИИ-компаньон внимательно слушает, вмешиваясь, когда это уместно, чтобы предложить обратную связь в реальном времени о ее речи и содержании. “Мне кажется, ты слишком быстро прошла через раздел об окупаемости инвестиций”, – предлагает он теплым, естественным голосом. “Давай попробуем эту часть снова, но на этот раз—” Сара прерывает на полуслове: “Вообще-то, можем мы сначала сосредоточиться на вступлении? И не будь таким придирчивым!” ИИ плавно перестраивается, без неловких пауз или роботизированных переходов. То, что когда-то было разочаровывающим опытом жестких, неестественных взаимодействий с голосовыми помощниками, превратилось в плавную, человекоподобную беседу.

В последнее время я много думал о голосовом ИИ и создавал решения в этой области, и на горизонте появляется нечто беспрецедентное: впервые в истории у нас есть доступный в реальном времени, доступный по цене и компетентный искусственный голос, который находится всего в одном API-запросе. Всего за несколько месяцев мы увидели значительные прорывы от OpenAI с Advanced Voice Mode (AVM) и новыми речевыми моделями, разговорным Gemini Flash в реальном времени от Google и эмоционально интеллектуальным ИИ от Sesame *1.

Это не просто техническая веха — это фундаментальный сдвиг в том, как мы взаимодействуем с технологиями и, потенциально, друг с другом. Это создаст множество новых возможностей для разработчиков, одновременно переопределяя саму природу человеческого общения.

Gavin Purcell спорит с голосовым ИИ Sesame в реальном времени

Заря естественного голосового ИИ

Помните, когда вы в последний раз звонили в автоматизированную систему своего банка? Знакомый танец с повторяющимися фразами, непонятыми словами и отчаянными нажатиями “0”, чтобы дозвониться до оператора-человека. Эта эпоха заканчивается. Выпуск OpenAI Advanced Voice Mode (AVM) в прошлом сентябре ознаменовал поворотный момент, когда разговор с ИИ начал ощущаться по-настоящему человечным.

Эта трансформация является результатом двух ключевых прорывов. Во-первых, переход от каскадных архитектур (речь-в-текст → обработка текста → текст-в-речь) к прямым моделям речь-в-речь устраняет промежуточные этапы обработки, которые ранее замедляли взаимодействие с разговорным ИИ. Во-вторых, драматическое снижение задержки и стоимости. Когда OpenAI изначально выпустила свой Realtime API, цена делала его непрактичным для широкого внедрения (18$ в час). Но всего четыре месяца спустя выпуск Google Gemini Flash 2.0 и снижение цен OpenAI на 60% открыли шлюзы для доступных и человекоподобных приложений голосового ИИ, находящихся в одном API-запросе.

Только на прошлой неделе OpenAI представила свои самые человекоподобные речевые модели, позволяющие разработчикам встраивать выразительные сигналы, такие как [ШЕПОТ] или [СМЕХ], непосредственно в текст. Вот небольшая демонстрация от OpenAI.fm — публичного инструмента, запущенного вместе с этим релизом, показывающего, как звучит этот новый уровень выразительности в действии.

Теперь разработчики могут запускать телефонных ассистентов, которые квалифицируют потенциальных клиентов, разрешают обращения в службу поддержки, автоматизируют продажи страховок или проводят скрининг пациентов перед предстоящими приемами. Необходимые инструменты уже доступны и находятся всего в одном API-запросе.

Проблема прерываний

Однако создание действительно естественного голосового взаимодействия — это не только быстрая обработка и лучший синтез голоса. Одна из самых увлекательных проблем заключается в обработке прерываний — фундаментального аспекта человеческого разговора, с которым ИИ всё еще борется.

Текущие системы голосового ИИ, включая упомянутые, такие как OpenAI AVM, сталкиваются с несколькими ключевыми проблемами:

-

Чрезмерная чувствительность к фоновому шуму (я всегда отключаю микрофон, когда не говорю)

-

Неспособность различать значимых говорящих и фоновые разговоры

-

Отсутствие визуальных сигналов, которые люди используют для предвидения и управления прерываниями

В отличие от телефонных разговоров между людьми, где практически нулевая задержка и естественная очередность делают прерывания управляемыми, взаимодействие с ИИ часто ощущается неуклюжим, когда пользователи пытаются вмешаться *2. Интересно, что люди склонны прерывать ИИ чаще и агрессивнее, чем они бы прерывали других людей, создавая новую проблему для разработчиков голосового ИИ и одновременно создавая новую парадигму взаимодействия для разговора человека с ИИ.

Социальное воздействие

Эта голосовая революция поднимает глубокие вопросы о человеческом взаимодействии и отношениях:

-

Может ли мгновенное удовлетворение от прерываемых разговоров с ИИ и возможность быть грубым без последствий ухудшить наше терпение и навыки межличностного общения, подобно тому, как повсеместный доступ к порнографии исказил общественные ожидания относительно близости?

-

Удобство постоянно доступных консультаций с ИИ может снизить нашу зависимость от человеческих отношений. Подумайте, как раньше мы полагались на чтение карт и спрашивали местных жителей о направлении — навыки, теперь в значительной степени заброшенные, поскольку мы полагаемся на GPS. Могут ли значимые разговоры быть следующими?

-

Не будем ли мы вскоре иметь больше разговорных обменов с ИИ-агентами, чем с человеческими компаньонами?

Подумайте: предпочли бы вы репетировать важную презентацию перед потенциально осуждающим другом или мгновенно проконсультироваться с неосуждающим ИИ-компаньоном, доступным 24/7?

Что это значит для наших межличностных отношений?

Культурные нюансы в разговорах с ИИ

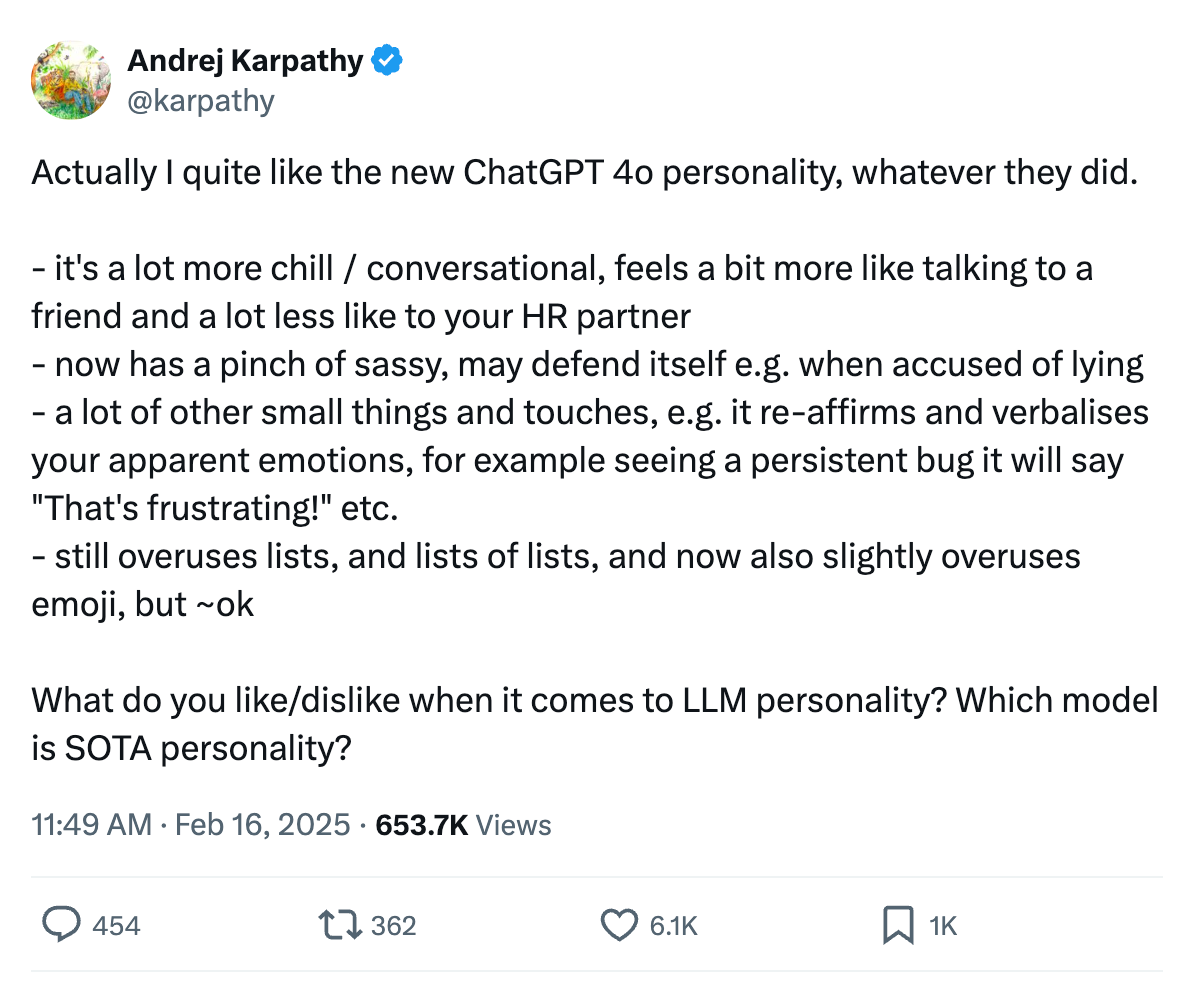

В человеческом разговоре один подход не подходит всем, и то же самое справедливо для ИИ. Недавнее обновление OpenAI от GPT-4o до GPT-4.5 было в основном направлено на отход от тона “корпоративного HR”, признавая, что естественный разговор значительно варьируется в зависимости от культуры и контекста.

Разные культуры имеют отличительные модели прерывания, нормы вежливости и стили разговора. Сегодняшние системы в значительной степени не учитывают эти культурные различия, создавая значительные возможности для разработчиков ИИ для создания моделей, которые адаптируются к:

-

Культурному происхождению

-

Индивидуальным паттернам пользователя

-

Контекстуальным сигналам

-

Историческим взаимодействиям

OpenAI уже обладает таким контекстом через свою функцию Memory, а Google, конечно, уже знает о нас практически всё.

Я представляю, что лучшие разговорные системы ИИ будущего будут включать в себя нюансы, которые мы принимаем как должное.

Переосмысление коммуникации

Святым граалем для разговорного ИИ может быть достижение естественного потока телефонного разговора между людьми, где прерывания ощущаются естественно, а очередность выступлений происходит плавно. Но, возможно, нам нужно ставить цели выше. Поскольку системы ИИ приобретают мультимодальные возможности (зрение, осязание и т.д.), они потенциально могут превзойти человеческий разговор, считывая тонкие сигналы, которые мы часто упускаем.

Бытовые роботы Figure обучаются задачам на ходу

Что меня больше всего удивляет, так это то, как медленно внедряется Advanced Voice Mode. Несмотря на впечатляющие возможности, многие мои друзья по-прежнему предпочитают печатать или использовать Whisper (модель преобразования речи в текст от OpenAI), а не вести естественные разговоры с ним. Возможно, эта нерешительность отражает нашу коллективную неопределенность в отношении естественного общения с машинами, или просто недостаток осведомленности — в конце концов, эта функция стала доступна бесплатным пользователям только в прошлом месяце, и многие могут еще не знать, как ею пользоваться. В любом случае, это наводит на мысль, что мы находимся в неловкой подростковой фазе внедрения голосового ИИ — технология способна, но наши привычки и ожидания еще не совсем догнали ее.

Революция голосового ИИ — это не просто о том, чтобы заставить машины звучать более по-человечески, это о фундаментальном изменении того, как мы думаем о разговоре, отношениях и человеческом взаимодействии. Хотя в краткосрочной перспективе мы, безусловно, увидим распространение телефонных ИИ-агентов и компьютерных помощников, под поверхностью формируется более глубокая трансформация.

Создавая эти системы, нам нужно учитывать не только то, что технически возможно, но и то, что социально желательно. Пока ясно, что мы вступаем в эпоху, когда грань между человеческим разговором и ИИ-разговором становится все более размытой — к лучшему или к худшему.

В заключение, на более легкой ноте, вот забавное видео, в котором Голосовой режим ChatGPT переосмысливает альтернативный финал “Титаника”.

[1] Sesame недавно выпустила с открытым исходным кодом (Apache 2.0) версию своей впечатляющей модели голосового помощника

[2] По слухам из Сан-Франциско, ведущие лаборатории ИИ находятся на пороге прорыва, который может решить эти проблемы

Кто готов общаться больше с ИИ чем с человеком?

Послушайте примеры

Автор: Kual