На связи команда Т1 Облако. Если вы следите за новостями в мире серверных видеокарт для ML, то точно знаете об Nvidia H100 — вычислительной молотилке на GPU, даже не имеющей видеовыхода. Она играет важную роль в области машинного обучения, анализа больших данных, 3D‑моделирования и много другого. Устройство корпоративного уровня, то есть домой себе такое купят разве что полтора энтузиаста.

Сегодня поделимся небольшим аппаратным обзором серверов с этими графическими ускорителями и расскажем, для каких задач их используют наши коллеги, клиенты и другие компании.

Сравнение с предыдущим поколением

Подробные спецификации вы можете почитать на сайте Nvidia. А если лень, то вот краткая выжимка:

-

В основе Nvidia H100 лежит архитектура Hopper.

-

Тензорные ядра NVLink четвёртого поколения и модуль Transformer Engine с точностью FP8 ускоряют по сравнению с видеокартой Nvidia A100:

-

преобразования Фурье — до 6 раз;

-

полногеномное секвенирование — до 7 раз;

-

обучение моделей ИИ — до 9 раз (без NVLink — до 5 раз);

-

логический вывод (инференс) при работе ИИ — до 30 раз.

-

Ближе к телу

Мы развернули в облаке кластер с графическими ускорителями, в каждом сервере по восемь GPU. Один такой сервер весит около 40 кг, что сравнимо с весом гепарда или леопарда. Максимальное энергопотребление сервера при полной загрузке составляет до 3,8 кВт.

Спецификация сервера:

-

Два процессора AMD EPYC 9374F 32C 3,85 ГГц;

-

1,5 Тб оперативной памяти DDR5 4800 МГц;

-

Восемь Nvidia H100. Каждая видеокарта карта оснащена 80 Гб памяти;

-

Интерфейс видеокарты — PCIe Gen5: 128 Гб/с (по 64 Гб/с в каждом направлении);

-

Две сетевые карты Mellanox ConnectX-6 Lx 10/25GbE SFP28 2-Port;

-

Один FC адаптер Emulex LPe35 002 32Gb 2-port PCIe Fibre Channel.

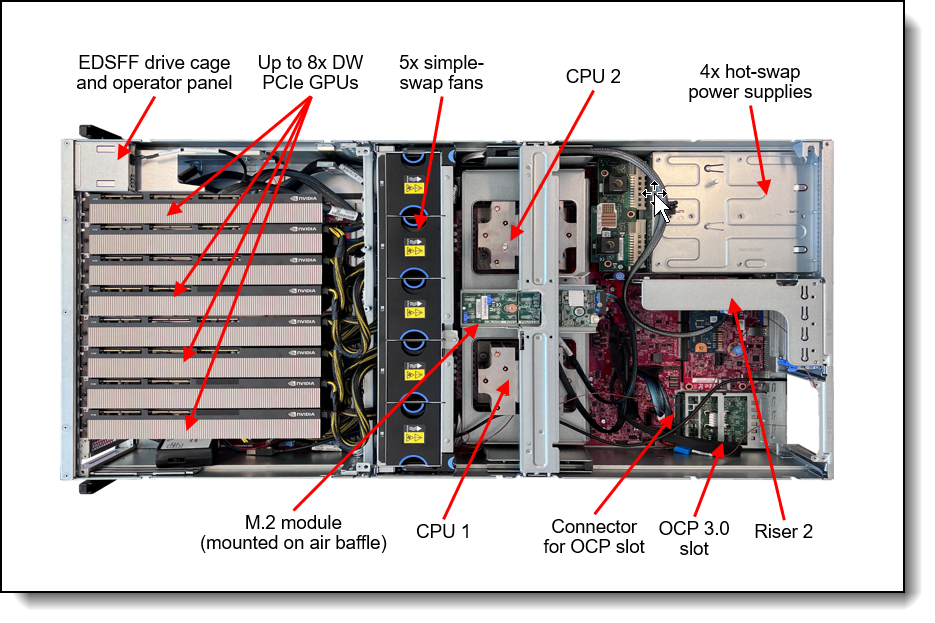

Теперь посмотрим, как сервер выглядит в реальности. После снятия крышки глазу предстаёт картина:

Немного пояснений.

В стандартную стойку на 42 юнита вместо 14 обычных серверов помещается три с Nvidia H100. Это связано с их высоким энергопотреблением до 380 Вт.

Чёрные квадратики на графическом ускорителе — это шины NVLink с пропускной способностью 600 ГБ/с. Они соединяют две соседние карты. Всего в сервере стоит четыре таких пары.

Почему CPU тоже важен

Производительность вычислений зависит не только от параметров видеокарты. Характеристики CPU влияют на производительность всего сценария или скрипта, который работает на ВМ. Например, данные нужно перекладывать с диска в память, затем отдавать видеокарте, а также выполнять дополнительные операции, например, скачивать что‑то из сети. Чтобы CPU не стал узким местом, архитектура каждого GPU‑сервера основана на двух центральных процессорах AMD EPYC 9374F 32C с 3,85 ГГц и 1,5 ТБ памяти.

О кластере

Серверы с Nvidia H100 мы собрали в один кластер виртуализации. Соответственно, карты подаются в виртуальную машину.

Если захотите арендовать у нас эту красоту, то обратите внимание, что на одну виртуальную машину можно заказать до 8 карт. У нас есть готовые шаблоны для развёртывания разного количества видеокарт H100 (а также A100). Если нужно больше производительности, то заказывайте вторую ВМ, которая работает на втором сервере.

Примеры использования

Сайбокс

В качестве одного из примеров расскажем о нашем сервисе, который потребляет вычислительные ресурсы GPU H100 из облака. Это платформа Сайбокс для разработчиков ИИ‑приложений, команд разработки, бизнес‑пользователей, а также специалистов и энтузиастов по Data Science. Платформа дает доступ не только к вычислительным мощностям для работы с моделями ML, но и к инструментам для создания, применения и интеграции сервисов на основе ИИ. Например, разработчики и Data Scientist`ы могут тренировать и запускать доступные на платформе открытые модели ML без лишних затрат на развертывание инфраструктуры.

Через Сайбокс можно получить необходимые GPU‑ресурсы и быстро разворачивать на них open‑source‑модели с общемирового репозитория Hugging Face. Сайбокс позволяет пользователям запустить такие модели с помощью создания локальных копий в облаке. Например, наша команда протестировала две модели генеративного ИИ с 72 млрд параметров и разными архитектурами: Qwen/Qwen2.5–72B‑Instruct (более простая) и Qwen/QVQ-72B‑Preview (новая). Первую запустили на одной ноде с двумя GPU H100, а вторую — на кластерном решении из двух нод и четырех GPU H100. При этом локальные копии этих моделей находились на облачных серверах.

С Сайбокс можно решать разные задачи прикладного характера: обучать и запускать большие языковые модели (LLM) для генерации текста, кода, изображений и видео, создавать интеллектуальных ассистентов для рекрутеров, которые умеют анализировать резюме и записанный диалог с кандидатом, а затем делать саммари. При необходимости можно научить модель записывать данные о кандидате в HR‑систему. В промышленности предобученные модели компьютерного зрения помогают в реальном времени отслеживать наличие спецодежды, касок и других средств защиты на сотрудниках, визуально контролировать качество готовой продукции, например, этикеток и маркировки.

Платформа находится в открытой бете. Если хотите попробовать, то оставляйте заявку на триал‑аккаунт, который Сайбокс предоставляет вместе с Т1 Облако. Первый месяц мощности GPU можно использовать бесплатно: обучайте модели быстро и с минимальными затратами, делитесь обратной связью и пишите нам, если нужна консультация.

И ещё несколько примеров

А теперь о задачах, которые компании, включая наших клиентов, решают с применением вычислительных мощностей H100.

Кредитно‑финансовая сфера:

-

Разработка и обучение LLM (больших языковых моделей), создание на их основе цифровых помощников. Такие ассистенты умеют обрабатывать обращения клиентов, создавать стратегии накопления на банковских депозитах и многое другое.

-

Обработка большого объема финансовых данных в реальном времени. На их основе с помощью ИИ организации прогнозируют цены на акции и валюту, анализируют доходность различных инструментов, помогают инвестфондам и частным инвесторам принимать решения о покупке активов.

-

Обучение сложных ML‑моделей, которые помогают анализировать финансовую историю и другие данные клиентов, чтобы затем оценивать их кредитоспособность.

-

Сбор и анализ данных о транзакциях в реальном времени. Это позволяет компаниям быстро обнаруживать подозрительные операции и предотвращать мошенничество.

Ритейл и e-commerce:

-

AI-рендеринг графики. На базе искусственного интеллекта дизайнеры создают привлекательные, фотореалистичные изображения товаров для карточек на сайте и маркетплейсах.

-

Интеллектуальный анализ документов. Нейросети помогают автоматически находить связи, влияния, расхождения, соответствие регуляторным требованиям в неструктурированных текстовых документах, технических заданиях и др.

-

Создание и обучение генеративного ИИ, который поможет быстро обрабатывать и анализировать все возможные причины падения продаж, тактику конкурентов, различные события и сбои, а затем на их основе принимать решения о дальнейших действиях.

Промышленность:

-

Разработка специализированных языковых моделей (FLM). Они участвуют в проектировании производственных процессов и промышленных объектов, например, нефтегазовых скважин, карьеров и шахт.

-

Обработка, визуализация, анализ и интерпретация данных, накопленных за десятилетия в корпоративных системах предприятий.

-

Разработка решений по видеоаналитике на основе нейросетей. Одни из самых востребованных кейсов — контроль трудовой дисциплины персонала, визуальный контроль качества готовой продукции, в том числе, проверка этикеток и маркировки.

Медицина:

-

Обработка данных с диагностического оборудования. Например, технологии компьютерного зрения за секунды распознают рентгеновские снимки и видеоданные с аппаратов УЗИ.

-

Создание с помощью нейросетей 3D‑модели пациента: она учитывает особенности анатомии, образ жизни и другие параметры. На ней врачи тестируют методы терапии и составляют индивидуальный план лечения.

-

Разработка и обучение ИИ‑ассистентов врачей. Такие помощники понимают контекст разговора с пациентом, распознают аудиозапись беседы и автоматически заполняют электронную медкарту, систематизируют данные, формируют эпикриз и др.

Если вы хотите протестировать H100 или задать вопросы об облачном сервисе, напишите нам.

Автор: T1_IT