Llama 4 Maverick и Scout: результаты тестирования моделей Meta*

Новые независимые оценки показывают, что последние модели Meta Llama 4 — Maverick и Scout — хорошо справляются со стандартными тестами, но испытывают трудности со сложными задачами с длительным контекстом.

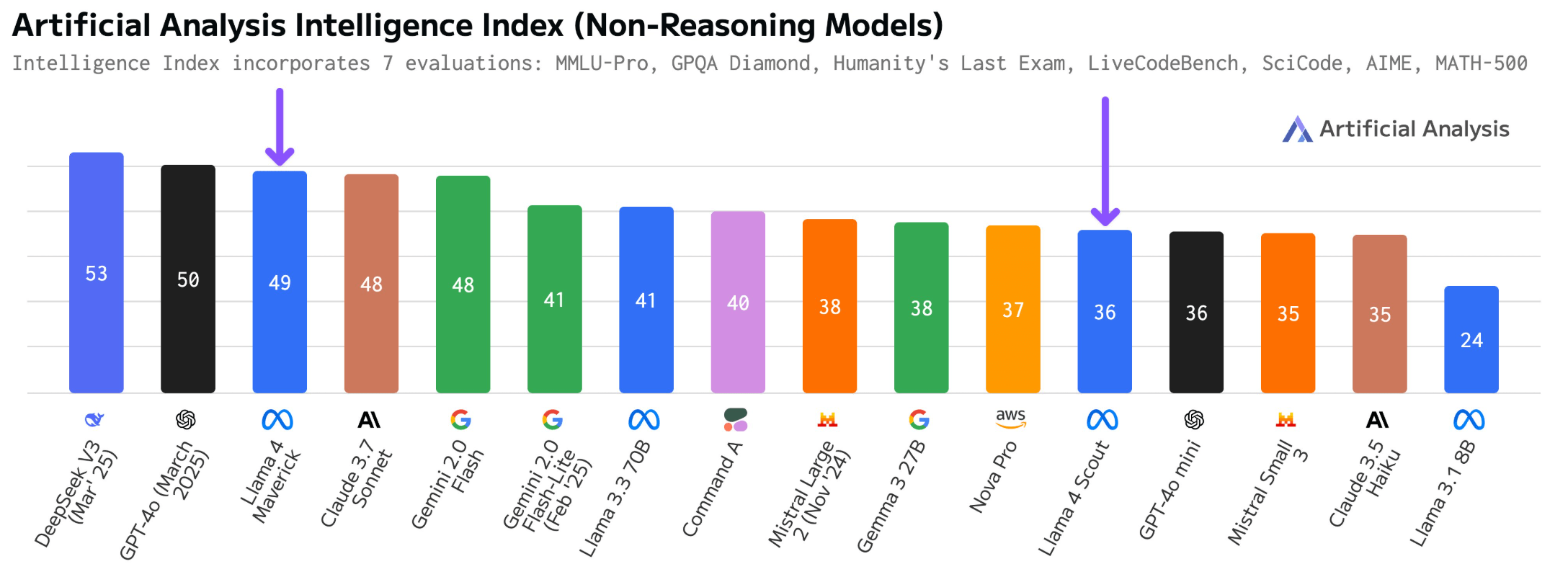

Согласно совокупному «индексу интеллекта» от Artificial Analysis [1], Llama 4 Maverick от Meta набрала 49 баллов, а Scout — 36. Это ставит Maverick выше Claude 3.7 Sonnet, но ниже Deepseek V3 0324 [2]. Scout работает наравне с GPT-4o-mini и превосходит Claude 3.5 Sonnet и Mistral Small 3.1.

Обе модели продемонстрировали стабильные результаты [3] в общих логических, программистских и математических задачах, не показав существенных недостатков в какой-либо конкретной области.

Архитектура Maverick демонстрирует некоторую эффективность, используя лишь половину активных параметров Deepseek V3 (17 миллиардов против 37 миллиардов) и около 60 процентов от общего числа параметров (402 миллиарда против 671 миллиарда). В отличие от Deepseek V3 [5], который обрабатывает только текст, Maverick может обрабатывать и изображения.

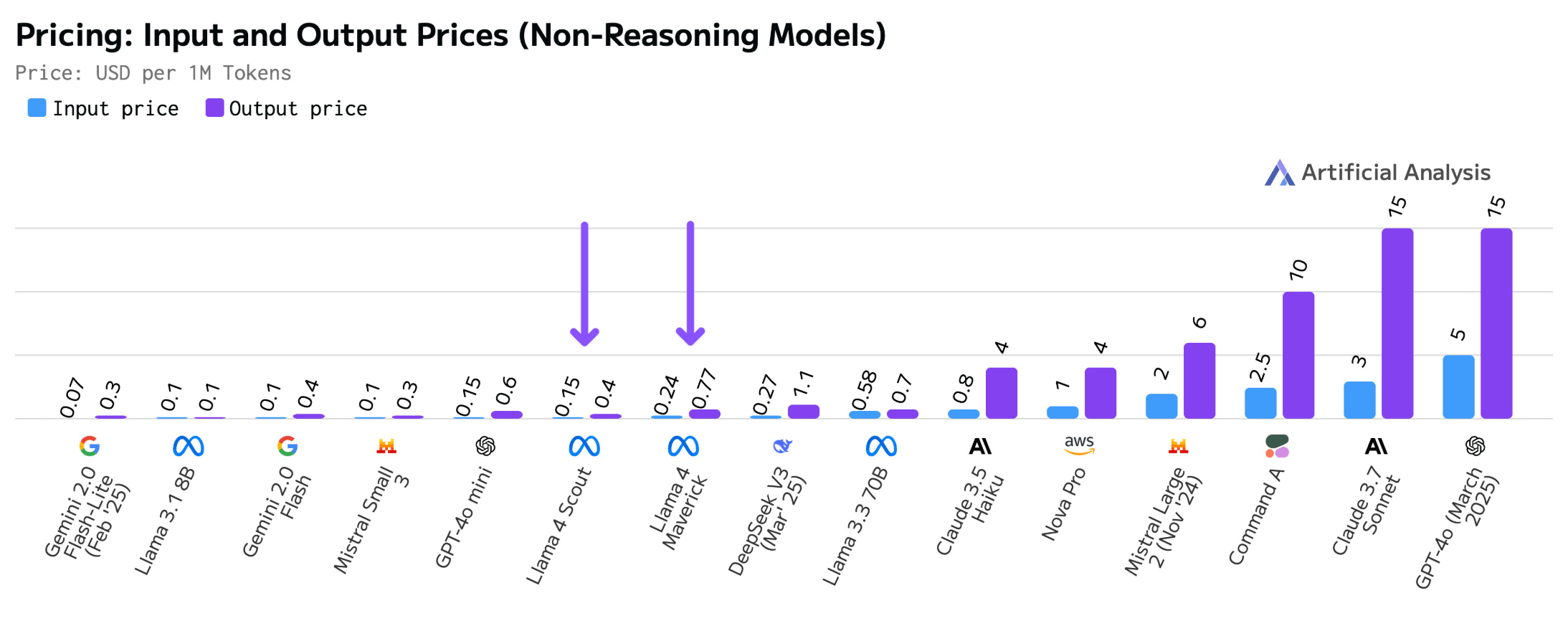

По данным искусственного анализа, средняя цена Maverick составляет 0,24 доллара за миллион входных/выходных токенов, а Scout — 0,15 доллара за миллион. Эти цены ниже даже у бюджетного Deepseek-V3 и в десять раз ниже, чем у GPT-4 от OpenAI.

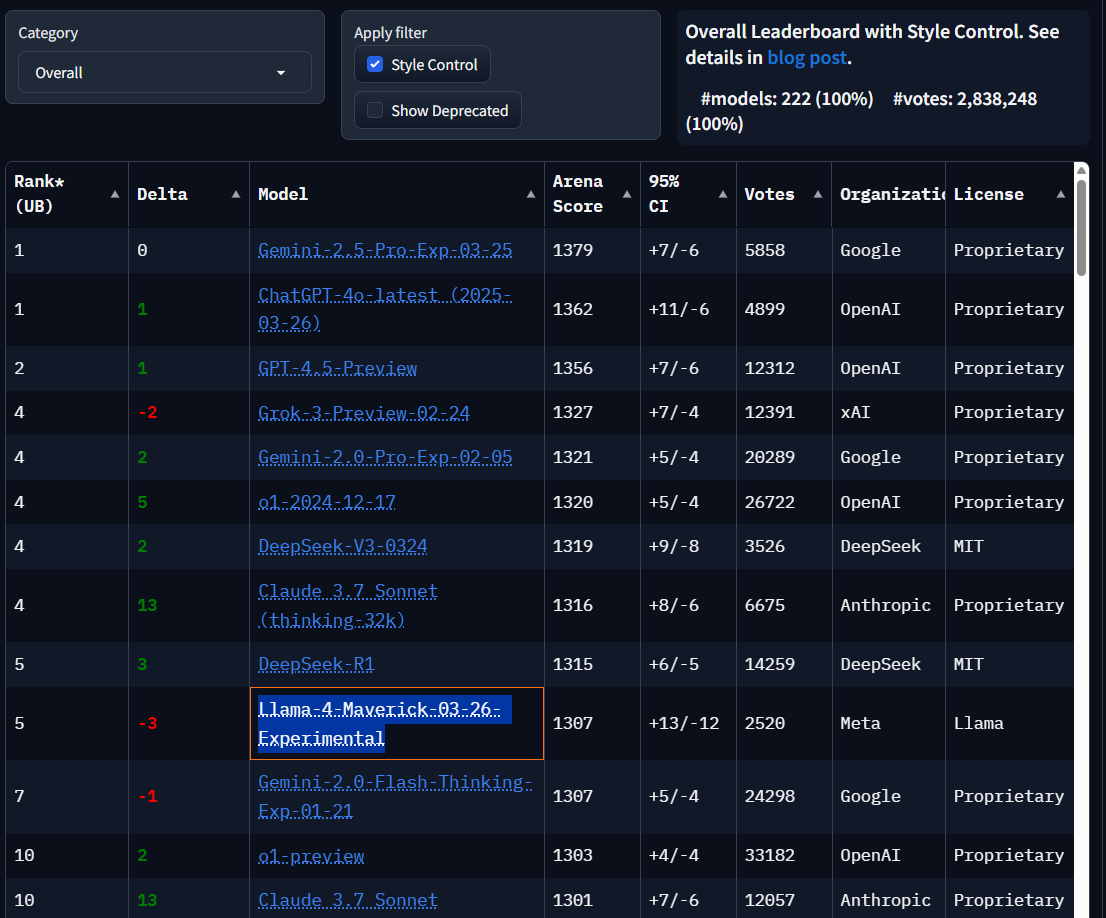

Запуск Llama 4 не обошёлся без споров. Несколько тестировщиков сообщают [6] о значительных различиях в производительности между LMArena [7] — бенчмарком, который активно продвигает Meta, — и производительностью модели на других платформах, даже при использовании рекомендуемой Meta системной подсказки.

Meta подтвердила, что для этого теста использовалась «экспериментальная версия чата» Maverick, и предложила возможную оптимизацию для людей, которые оценивают результаты, с помощью подробных, хорошо структурированных ответов с чётким форматированием.

Фактически, когда в LMArena активируется «Style Control» [8] — метод, который отделяет качество контента от стиля презентации, — Llama 4 опускается со второго на пятое место. Эта система пытается изолировать качество контента, учитывая такие факторы, как длина ответа и форматирование. Стоит отметить, что другие разработчики моделей искусственного интеллекта, вероятно, используют аналогичные стратегии оптимизации тестов.

Наиболее серьёзные проблемы выявились в тестах, проведённых [9] Fiction.live [10], которые оценивают понимание сложных текстов с помощью многоуровневых повествований.

Fiction.live [10] утверждает, что их тесты лучше отражают реальные сценарии использования, измеряя фактическое понимание, а не просто возможности поиска. Модели должны отслеживать временные изменения, делать логические прогнозы на основе имеющейся информации и различать знания читателя и знания персонажа.

Производительность Llama 4 разочаровала в этих сложных тестах. Maverick не показал улучшений по сравнению с Llama 3.3 70B, а Scout показал «просто отвратительные» результаты.

Контраст разителен: в то время как Gemini 2.5 Pro сохраняет точность 90,6% при 120 000 жетонов, Maverick достигает лишь 28,1%, а Scout — 15,6%.

Эти результаты ставят под сомнение заявления Meta о возможностях работы с длинным контекстом [12]. Scout, который, как утверждается, может обрабатывать 10 миллионов токенов, с трудом справляется всего с 128 000. Maverick также не может стабильно обрабатывать документы с 128 000 токенов, но заявляет о контексте в один миллион токенов.

Исследования всё чаще показывают, что большие контекстные окна дают меньше преимуществ, чем ожидалось [13], поскольку моделям сложно оценивать [14] всю доступную информацию одинаково [15]. Работа с небольшими контекстными окнами размером до 128 КБ часто оказывается более эффективной, и пользователи обычно добиваются ещё лучших результатов, разбивая большие документы на главы, а не обрабатывая их все сразу.

В ответ на неоднозначные отзывы глава Meta по генеративному искусственному интеллекту Ахмад Аль-Дале объясняет [16], что ранние несоответствия отражают временные проблемы с реализацией, а не ограничения самих моделей.

«Поскольку мы запустили модели, как только они были готовы, мы ожидаем, что потребуется несколько дней, чтобы все общедоступные реализации были настроены», — пишет Аль-Дале. Он категорически отрицает обвинения в обучении [17] тестового набора данных, заявляя, что «это просто неправда, и мы бы никогда так не поступили». «По нашему мнению, нестабильное качество, которое наблюдают пользователи, связано с необходимостью стабилизировать реализацию», — говорит Аль-Дале, подчёркивая, что различные сервисы всё ещё оптимизируют развёртывание Llama 4.

*Meta и её продукты (Instagram, Facebook) запрещены на территории Российской Федерации

Источник [18]

Автор: mefdayy

Источник [19]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14015

URLs in this post:

[1] совокупному «индексу интеллекта» от Artificial Analysis: https://x.com/ArtificialAnlys/status/1908890796415414430

[2] Deepseek V3 0324: https://the-decoder.com/deepseeks-5-6m-chinese-llm-wonder-shakes-up-the-ai-elite/

[3] продемонстрировали стабильные результаты: https://x.com/ArtificialAnlys/status/1908897152409174347

[4] интеллекта: http://www.braintools.ru/article/7605

[5] Deepseek V3: https://the-decoder.com/deepseek-v3-emerges-as-chinas-most-powerful-open-source-language-model-to-date/

[6] Несколько тестировщиков сообщают: https://x.com/TheXeophon/status/1908900306580074741

[7] LMArena: https://lmarena.ai/

[8] активируется «Style Control»: https://lmsys.org/blog/2024-08-28-style-control/

[9] тестах, проведённых: https://fiction.live/stories/Fiction-liveBench-April-6-2025/oQdzQvKHw8JyXbN87

[10] Fiction.live: http://Fiction.live

[11] Fiction.Live: http://Fiction.Live

[12] заявления Meta о возможностях работы с длинным контекстом: https://the-decoder.com/meta-releases-first-multimodal-llama-4-models-leaves-eu-out-in-the-cold/

[13] большие контекстные окна дают меньше преимуществ, чем ожидалось: https://the-decoder.com/dont-get-too-excited-about-google-gemini-pro-1-5s-giant-context-window/

[14] моделям сложно оценивать: https://the-decoder.com/study-casts-doubt-again-on-the-benefits-of-large-context-windows/

[15] доступную информацию одинаково: https://the-decoder.com/ai-language-models-struggle-to-connect-the-dots-in-long-texts-study-finds/

[16] объясняет: https://x.com/Ahmad_Al_Dahle

[17] обучении: http://www.braintools.ru/article/5125

[18] Источник: https://the-decoder.com/metas-llama-4-models-show-promise-in-standard-tests-but-struggle-with-long-context-tasks/

[19] Источник: https://habr.com/ru/companies/bothub/news/898774/?utm_source=habrahabr&utm_medium=rss&utm_campaign=898774

Нажмите здесь для печати.