Бенчмарки Llama-4, предположительно — скам на самом высоком уровне

Буквально пару дней назад, комада Llama сообщила о появлении трех новых нейронок под общим зонтиком Llama-4: быстрый Scout с контекстом 10 миллионов токенов. Медленный Maverick с контекстом 1 миллион, но 128 экспертами под капотом. И гигантский Behemoth, который использовался как учитель для предыдущих двух.

10 миллионов токенов и нахаляву — это, мягко говоря, дофига. Можно закрыть глаза и представить, как где-то там в далеком Сан-Франциско, разработчики Gemini Pro начинают искать себе новую работу сантехниками, электриками и ассенизаторами.

Но вот прошла пара дней, и Царь оказался ненастоящий.

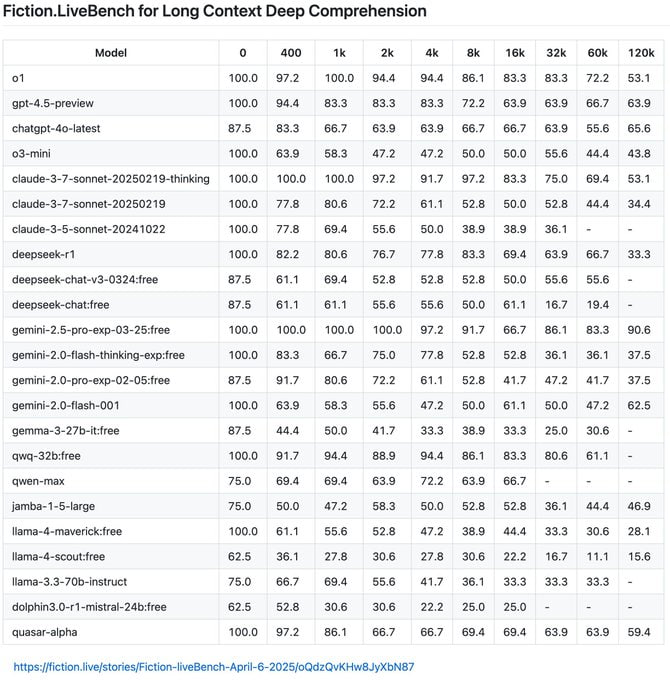

Похоже, бенчмарки Llama-4 оказались простой бытовой ложью. Никаких 10 миллионов токенов контекста. Уже на контексте в 120к производительность обнуляется.

В Твиттере помогли найти хороший пост [1] на форуме, на чистом китайском языке. С изобретением Claude Sonnet 3.7, все мы теперь эксперты-лингвисты, поэтому вот вам краткая выжимка:

Штатный сотрудник Meta GenAI решил уволиться, потому что заранее понимал, что бенчмарки Llama-4 – голимый скам. SOTA они не достигли, а руководство предложило подмешать в тестовые наборы данные из пред-трена, чтобы получить графики, похожие на правду. Самое высшее руководство объявило, что если до конца апреля они не достигнут SOTA, т.е. не станут лучшими в индустрии, то сотрудникам GenAI поотрывают головы.

Человек, написавший этот слив работает в академической среде, где репутация – это главное. Особенно, в Китае, где стартаперские круги целиком строятся на репутации. Поэтому он решил спрыгнуть с тонущей лодки первым. В увольнительной он указал, что запрещает использовать свою фамилию в официальной техкарте модели на Гитхабе.

А сразу за ним уволился VP of AI (читай – продакт-менеджер) этого продукта.

Чем-то мне это напоминает мою историю. Когда я увольнялся из одной геймдев-конторы, прочтав увольнительную, директор продукта только улыбнулся и не потребовал никаких объяснений. Через две недели директор тоже уволился. Мы до сих пор иногда общаемся, когда я залетаю в Новосибирск.

Из хорошего: контекст 120к – это замечательный результат. Совершенно нечего этого стыдиться, надо этим гордиться. Ну подумаешь, всё ещё не Gemini. Со всеми случается некоторое время не быть Gemini.

Из плохого: в администрации запрещенной в России организации Мета работают конченые идиоты. Одно дело – бить гребцов на счёт 0.5 [2], как Бендер в Футураме, и ставить им нереалистичные сроки. Другое дело – самим поверить в эти нереалистичные сроки и построить на них глобальную стратегию.

Учитывая, что эти идиоты управляют стратегией общемировых соцсетей, дела у нас плохи. Мир катится в это самое. Последние десять тысяч лет.

Выводы: врать надо уметь. Не умеешь врать – не берись. Учитесь у Сэма Гангстерса и Фродо Сумкинса из OpenAI, у них ложь неотличима от правды, а временами и полностью заменяет её в сознании культистов. И там подмешали данные, и здесь подмешали данные, но есть нюанс.

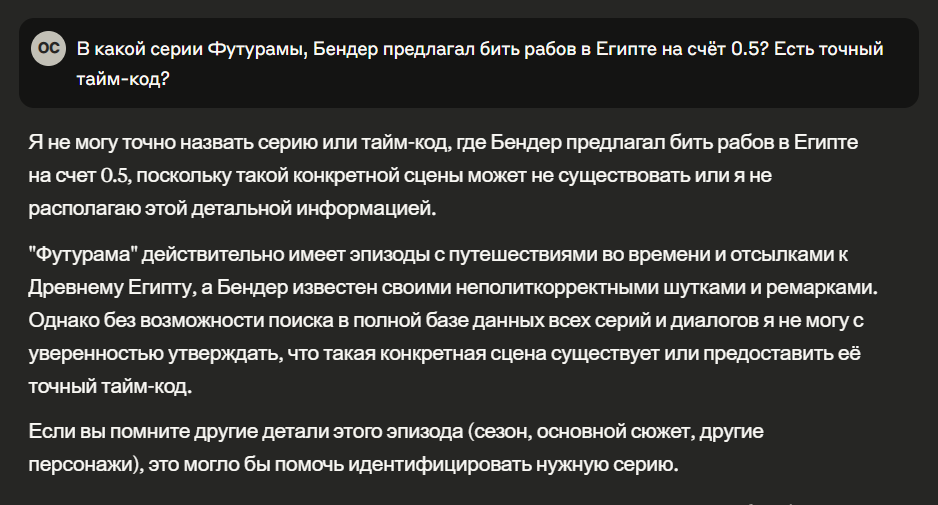

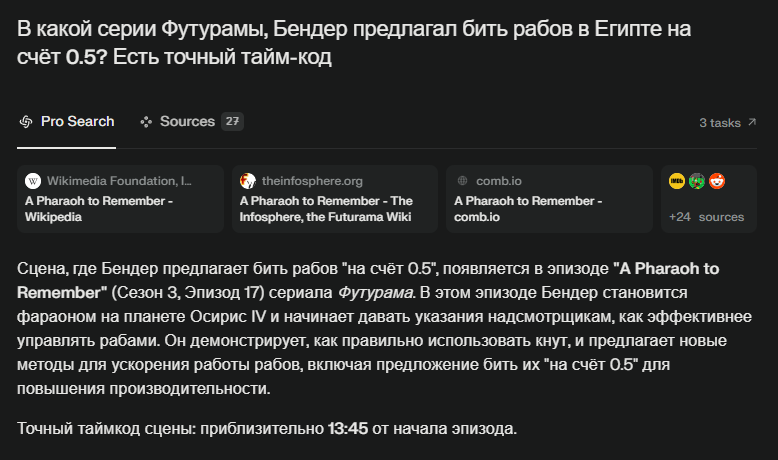

Давайте закончим на доброй ноте, ведь в каждой статье должна быть пасхалка. Когда я писал новость, пришлось найти – в каком же эпизоде Футурамы Бендер рассказывает свою знаменитую шутку. Я загнал вопрос одновременно в Claude Sonnet и в Perplexity.

Вот результат Claude:

Вот результат Perplexity:

Сейчас принято ругать Perplexity за то, что ее метод анализа очень поверхностный и недостаточно использует возможности “больших” сетей. Секрет Perplexity в коротких запросах, иначе они бы просто обанкротились со своими демпинговыми ценами и аттракционами невиданной щедрости. Но в своей нише, “замена Гугла и Яндекса” — она справляется очень хорошо.

Бонусные выводы для тех, кто до сюда дочитал: используйте инструмент по назначению. Взявший в руки молоток во всем видит гвоздь. А взявший в руки Claude Sonnet 3.7 во всем видит задачу этичного написания энциклопедической статьи по всем законам человекоцентричного алаймента — хотя реальная задача может быть “забить гвоздь молотком”. Perplexity отлично справляется на задачах, для которых она изначально предназначена. И напротив, если вы решите с помощью Perplexity решать экзамен по математике [3], в увас могут возникнуть некоторые непоправимые трудности.

Если вам нравится такой контент, можете подписаться на мою телегу: 1red2black [4]. Меня зовут Олег Чирухин, на работе я профессионально занимаюсь бесплатным форком VSCode с AI-ассистентом, а в свободное время (см. “работаете ли вы после работы”) делаю секретный некоммерческий AI-стартап Anarchic. Соответственно, в телеге пишу про разработку IDE для программистов, и про разные новости нейросетей. Нас уже почти 8 сотен человек в канале [4] и около 300 в чате [5]. Подключайтесь к движухе!

Автор: olegchir

Источник [6]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13992

URLs in this post:

[1] пост: https://www.1point3acres.com/bbs/thread-1122600-1-1.html

[2] бить гребцов на счёт 0.5: https://youtu.be/YLnYUKqSZSI

[3] математике: http://www.braintools.ru/article/7620

[4] 1red2black: https://t.me/tg_1red2black

[5] чате: https://t.me/chat_1red2black

[6] Источник: https://habr.com/ru/companies/bar/news/898602/?utm_source=habrahabr&utm_medium=rss&utm_campaign=898602

Нажмите здесь для печати.