Вышла Llama 4 с контекстным окном в 10M токенов (в 50 раз больше конкурентов)

Meta представила [1] новое поколение открытых моделей искусственного интеллекта [2] — семейство Llama 4. Это первые нативно мультимодальные модели с открытыми весами, которые объединяют понимание изображений, видео и текста в единой архитектуре.

P.S кратко написал об этом в Телеграм канале, ссылка [3] на пост

Ключевые особенности новых моделей

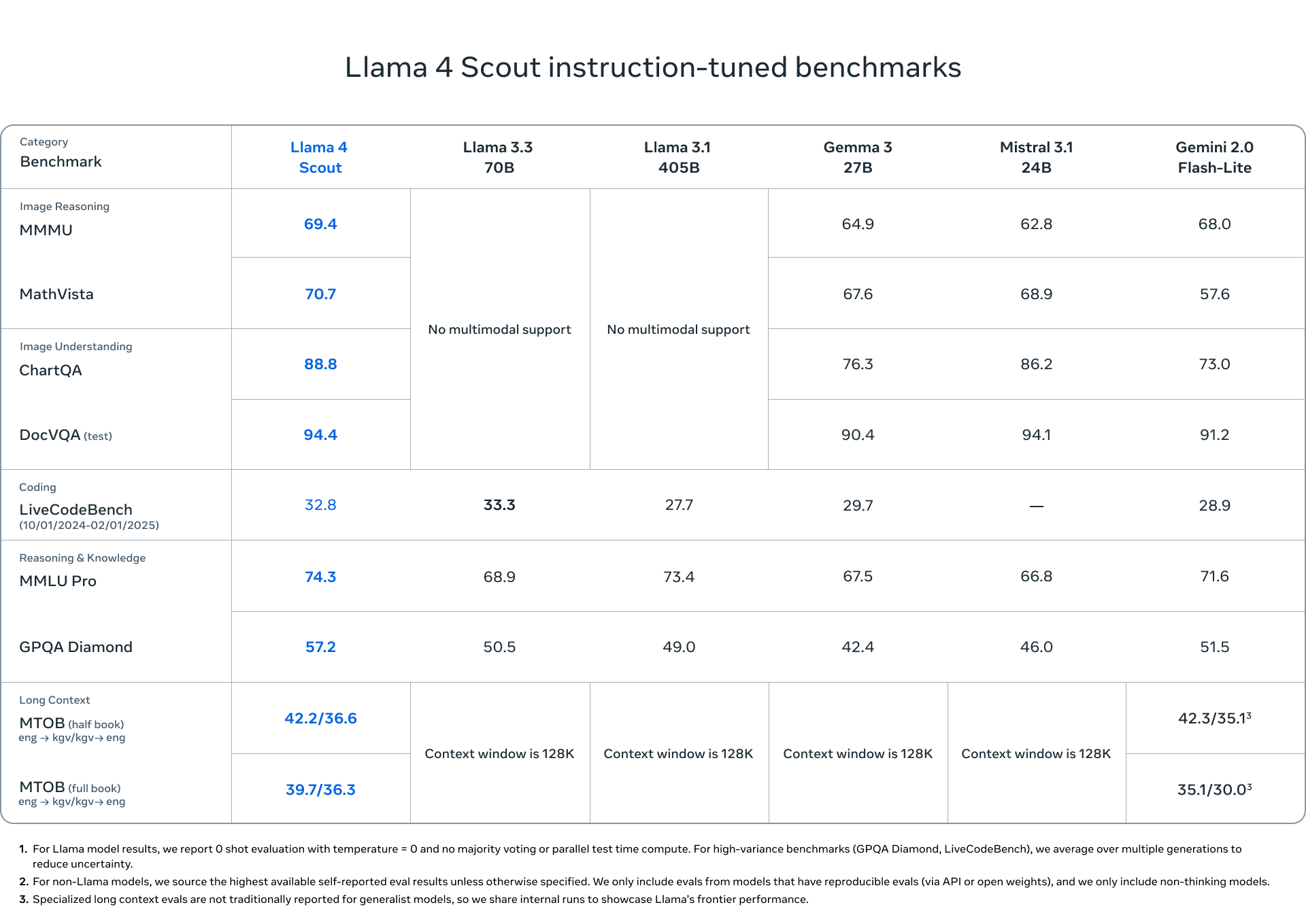

1. Llama 4 Scout – модель с 17 млрд активных параметров и 16 экспертами (109 млрд параметров в общей сложности). Является лучшей мультимодальной моделью в своём классе, превосходящей Gemma 3, Gemini 2.0 Flash-Lite и Mistral 3.1. Главная особенность – рекордное контекстное окно в 10 млн токенов и возможность работы на одной GPU H100 (с квантизацией Int4).

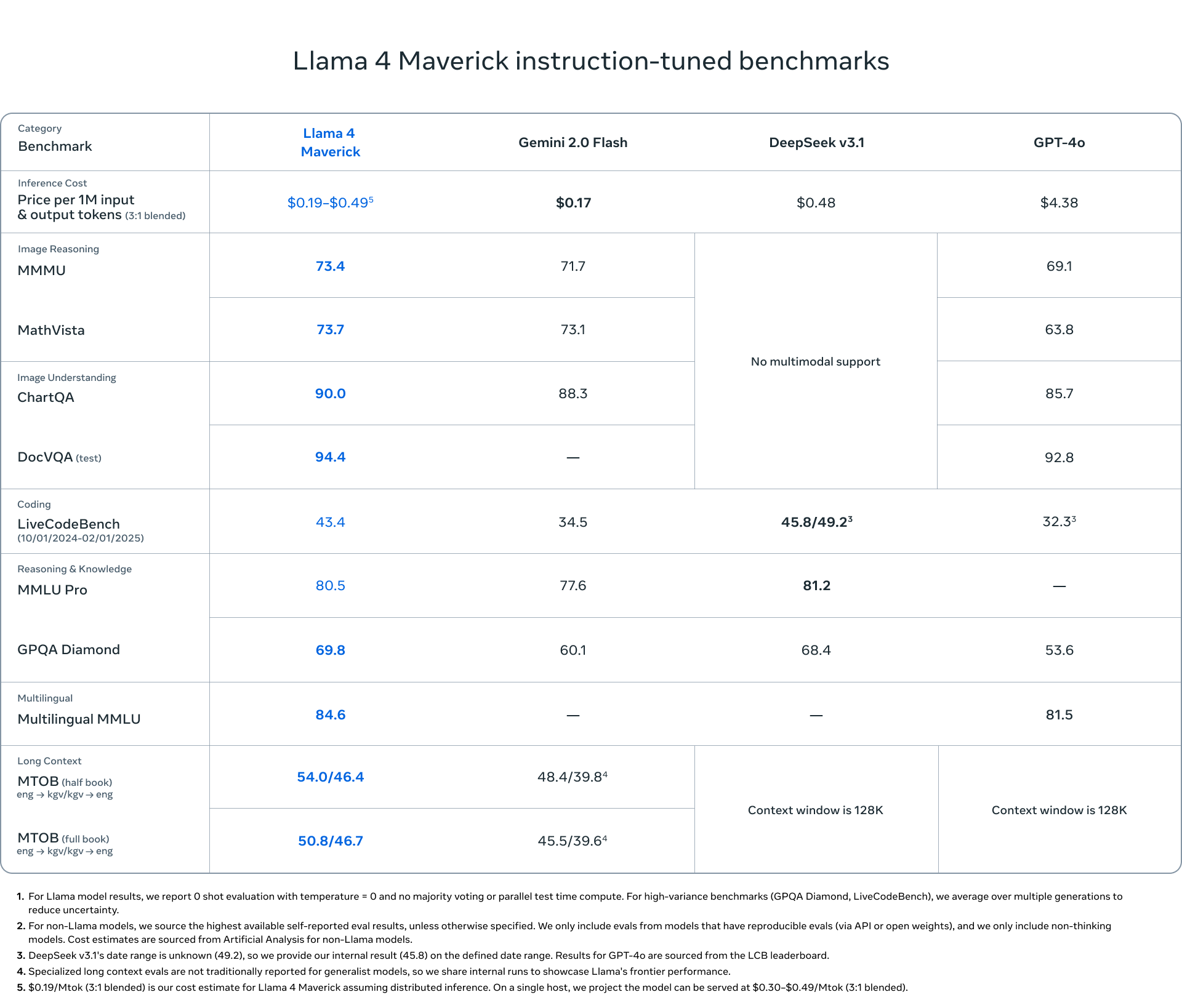

2. Llama 4 Maverick – мощная модель с 17 млрд активных параметров и 128 экспертами (400 млрд параметров в общей сложности). По заявлению Meta, превосходит GPT-4o и Gemini 2.0 Flash по широкому спектру бенчмарков, при этом показывая результаты, сравнимые с DeepSeek v3 в задачах рассуждения и кодирования, но при вдвое меньшем количестве активных параметров. Экспериментальная версия для чата достигла ELO 1417 на LMArena.

3. Llama 4 Behemoth – учительская модель с 288 млрд активных параметров, 16 экспертами и почти 2 триллионами общих параметров. По утверждению Meta, превосходит GPT-4.5, Claude Sonnet 3.7 и Gemini 2.0 Pro по нескольким STEM-бенчмаркам. Эта модель еще находится в процессе обучения [4] и не выпущена публично.

Технические инновации

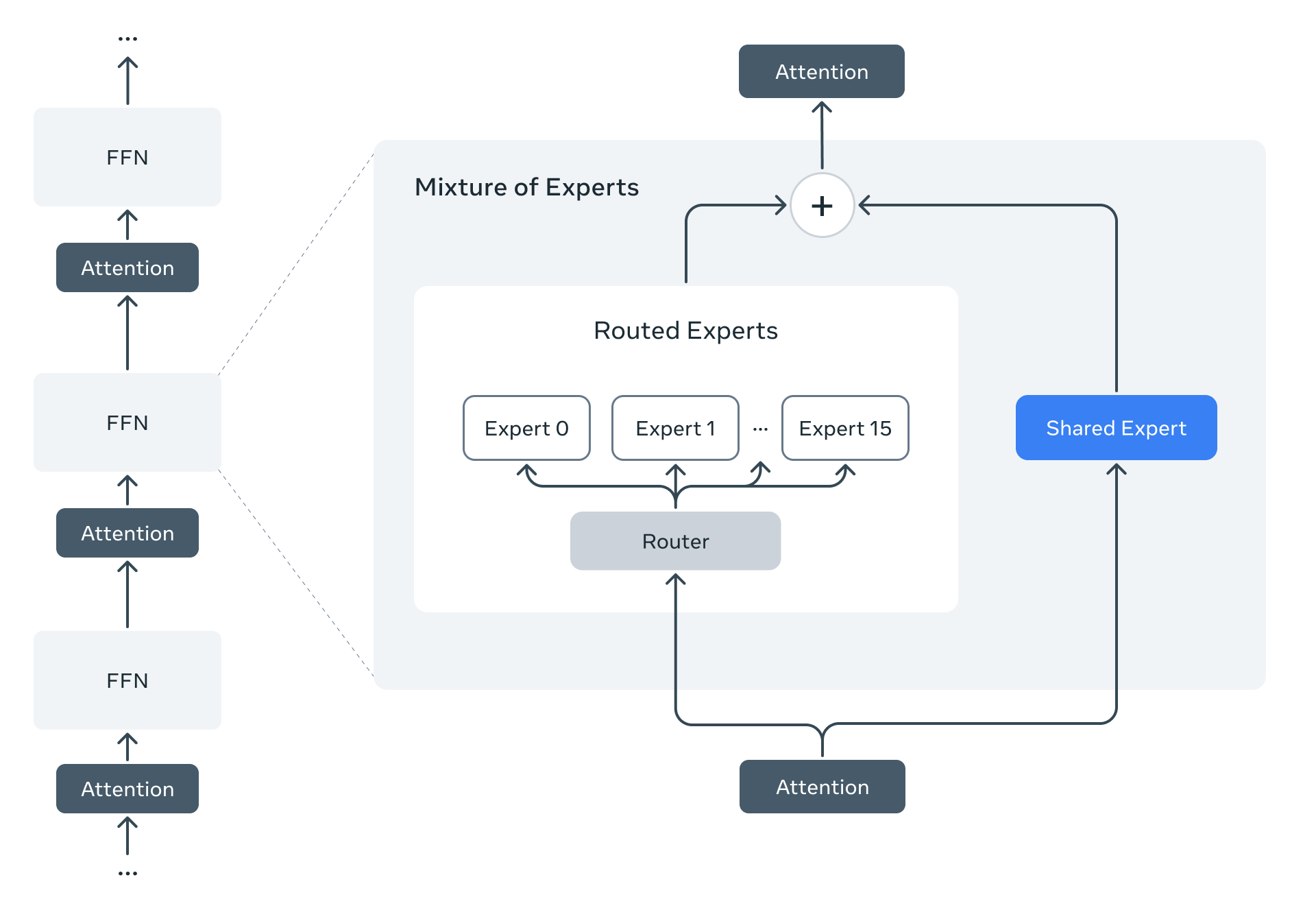

Архитектура Mixture of Experts (MoE)

Впервые в линейке Llama используется архитектура MoE, где для обработки каждого токена активируется лишь часть параметров модели. Это значительно повышает эффективность как обучения, так и инференса.

Например, в Llama 4 Maverick каждый токен обрабатывается общим экспертом и одним из 128 маршрутизируемых экспертов, что позволяет снизить вычислительные затраты и латентность при сохранении высокого качества.

Нативная мультимодальность

Модели используют раннее слияние (early fusion) для интеграции текстовых и визуальных токенов в единую модельную архитектуру. Это позволяет совместно предобучать модель на больших объемах немаркированных текстовых, изображений и видеоданных.

Улучшенный визуальный энкодер основан на MetaCLIP, но обучен отдельно в сочетании с замороженной моделью Llama для лучшей адаптации к специфике языковой модели.

Экстремально длинный контекст

Llama 4 Scout поддерживает беспрецедентно длинный контекст в 10 миллионов токенов благодаря специальной архитектуре iRoPE (interleaved attention layers без позиционных эмбеддингов) и масштабированию температуры внимания [5] во время инференса.

Новые методики обучения

-

MetaP – техника, позволяющая надежно устанавливать критические гиперпараметры модели, такие как скорость обучения для каждого слоя и масштабы инициализации.

-

FP8-precision – обучение с использованием 8-битной точности с плавающей запятой без потери качества. При обучении Llama 4 Behemoth достигнута производительность 390 TFLOPs/GPU с использованием 32K GPU.

-

Кодистилляция – использование Llama 4 Behemoth в качестве учителя для обучения меньших моделей с новой функцией потерь, которая динамически взвешивает мягкие и жесткие цели в процессе обучения.

-

Полностью асинхронный онлайн-RL – разработана новая инфраструктура для масштабного обучения с подкреплением [6], обеспечивающая 10-кратное улучшение эффективности обучения по сравнению с предыдущими поколениями.

Бенчмарки и стоимость

Стоимость:

-

$0.19-$0.49 за 1M токенов (в зависимости от настроек) против $4.38 у GPT-4o, про Sonnet 3.7 даже писать не стали 😂

Обработка изображений:

-

MMMU: 73.4 (против 71.7 у Gemini 2.0 Flash и 69.1 у GPT-4o)

-

MathVista: 73.7 (против 73.1 у Gemini и 63.8 у GPT-4o)

-

ChartQA: 90.0 (против 88.3 у Gemini и 85.7 у GPT-4o)

-

DocVQA: 94.4 (против 92.8 у GPT-4o)

Кодинг:

-

LiveCodeBench — 43.4 (DeepSeek v3.1 лидирует с 45.8/49.2)

Рассуждение и знания:

-

MMLU Pro: 80.5 (против 77.6 у Gemini, DeepSeek лидирует с 81.2)

-

GPQA Diamond: 69.8 (против 60.1 у Gemini, 68.4 у DeepSeek и 53.6 у GPT-4o)

Многоязычность:

-

Multilingual MMLU — 84.6 (против 81.5 у GPT-4o)

Длинный контекст:

-

MTOB (полная книга) — 50.8/46.7 (против 45.5/39.6 у Gemini)

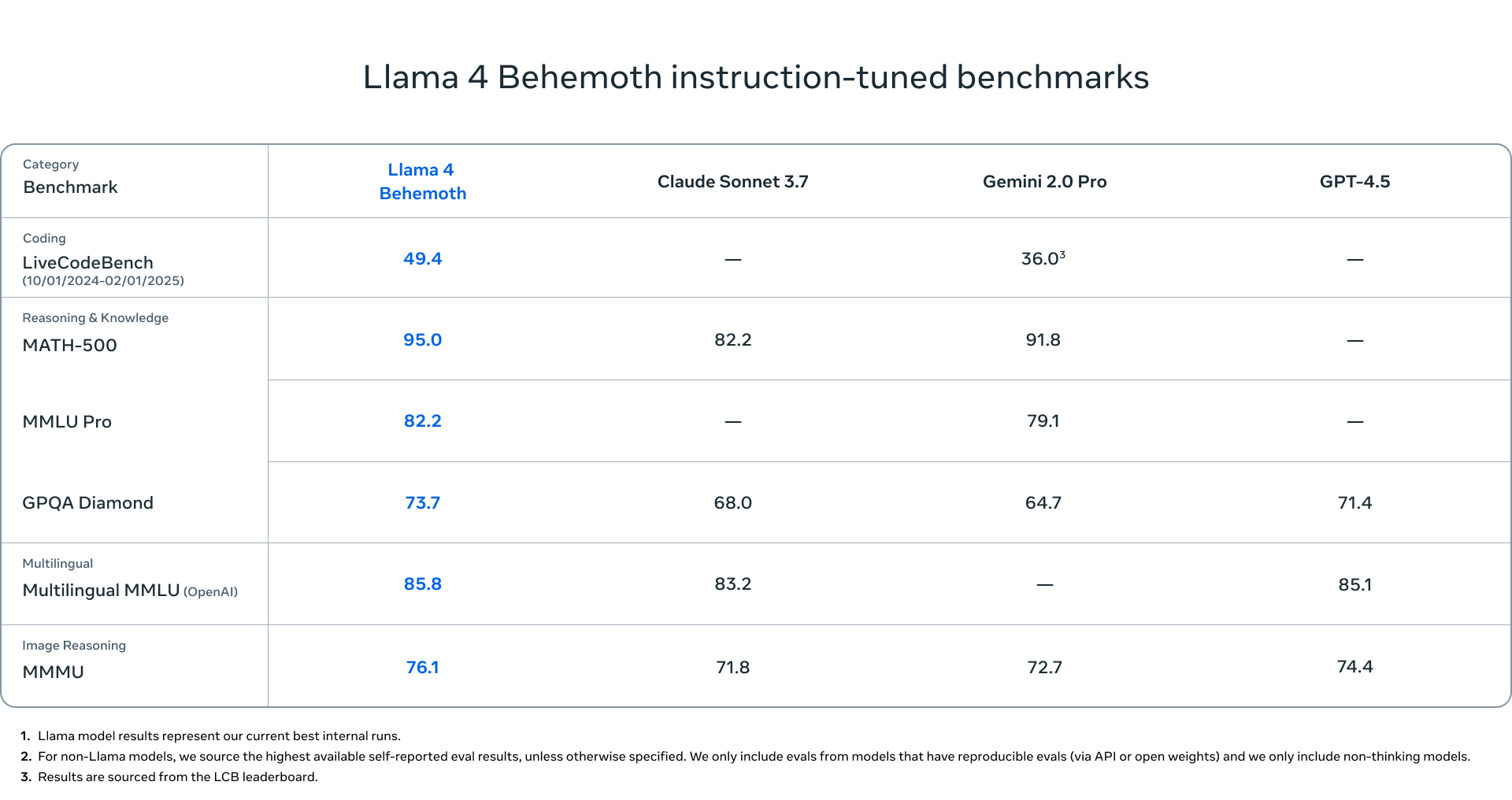

Llama 4 Behemoth vs флагманы

Учительская модель Behemoth показывает выдающиеся результаты:

-

LiveCodeBench: 49.4 (против 36.0 у Gemini 2.0 Pro)

-

MATH-500: 95.0 (против 82.2 у Claude Sonnet 3.7 и 91.8 у Gemini 2.0 Pro)

-

MMLU Pro: 82.2 (против 79.1 у Gemini 2.0 Pro)

-

GPQA Diamond: 73.7 (против 71.4 у GPT-4.5, 68.0 у Claude и 64.7 у Gemini)

-

Multilingual MMLU: 85.8 (против 85.1 у GPT-4.5 и 83.2 у Claude)

-

MMMU (понимание изображений): 76.1 (против 74.4 у GPT-4.5, 72.7 у Gemini и 71.8 у Claude)

Доступность и применение

Модели Llama 4 Scout и Llama 4 Maverick уже доступны для загрузки на llama.com [7] и Hugging Face [8]. Они также используются в Meta AI в WhatsApp, Messenger, Instagram Direct и на веб-сайте Meta.AI [9].

Для разработчиков, предприятий и исследователей эти модели представляют золотую середину между высокой производительностью и доступностью по ресурсам, обеспечивая передовые возможности по мультимодальному пониманию, рассуждению и кодированию при значительно более низкой стоимости использования по сравнению с проприетарными решениями.

Безопасность и этика

Meta уделила значительное внимание вопросам безопасности и снижения предвзятости в новых моделях (якобы):

-

Разработаны открытые инструменты безопасности: Llama Guard, Prompt Guard и CyberSecEval

-

Внедрен новый метод тестирования – Generative Offensive Agent Testing (GOAT)

-

Значительно снижен уровень отказов модели отвечать на вопросы о спорных политических и социальных темах (с 7% в Llama 3.3 до менее 2%)

-

Уменьшена политическая предвзятость модели до уровня, сравнимого с Grok (вдвое ниже, чем в Llama 3.3)

Автор: g_coll

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13930

URLs in this post:

[1] представила: https://ai.meta.com/blog/llama-4-multimodal-intelligence/

[2] интеллекта: http://www.braintools.ru/article/7605

[3] ссылка: https://t.me/g_coll/1416

[4] обучения: http://www.braintools.ru/article/5125

[5] внимания: http://www.braintools.ru/article/7595

[6] подкреплением: http://www.braintools.ru/article/5528

[7] llama.com: http://llama.com

[8] Hugging Face: https://huggingface.co/meta-llama

[9] Meta.AI: http://Meta.AI

[10] Источник: https://habr.com/ru/news/897898/?utm_source=habrahabr&utm_medium=rss&utm_campaign=897898

Нажмите здесь для печати.