Open-Sora 2.0: Видеогенерация коммерческого уровня за $200k — миф или реальность?

Генерация видео с помощью ИИ переживает настоящий бум. Модели становятся умнее, а видео все реалистичнее. Но у этого прогресса есть обратная сторона: затраты растут экспоненциально. Нужны все более крупные модели, гигантские объемы данных и колоссальные вычислительные мощности для обучения [1]. Это создает высокий порог входа для исследователей и компаний, тормозит демократизацию технологии и концентрирует инновации в руках гигантов с почти безграничными бюджетами. Исследование “Open-Sora 2.0: Training a Commercial-Level Video Generation Model in $200k” [2] бросает вызов этой проблеме, утверждая, что высокое качество генерации видео достижимо при значительно меньших затратах.

Народная Sora

Главная цель авторов – доказать, что создание модели генерации видео “коммерческого уровня” (сравнимого с лидерами рынка) не обязательно требует астрономических сумм. Конкретные задачи:

-

Разработать и обучить модель Open-Sora 2.0, уложившись в бюджет около $200 тыс;

-

Подробно описать весь процесс обучения – от подготовки данных до оптимизации, позволившие добиться такой экономии;

-

Сравнить модель с известными открытыми (HunyuanVideo) и закрытыми (Runway Gen-3 Alpha, Luma Ray2) аналогами, используя обьективные метрики и субьективные оценки людей;

-

Полностью открыть исходный код и ресурсы модели, чтобы стимулировать [3] дальнейшие исследования и разработки в сообществе.

По сути, это заявка на создание мощного, но доступного инструмента — своего рода “народной Sora”.

Как сэкономить на обучении ИИ-видеогенератора

Авторы подчеркивают: их успех – результат комплексной оптимизации на всех этапах. Ключевые методы:

-

Курирование данных (Data Curation):

-

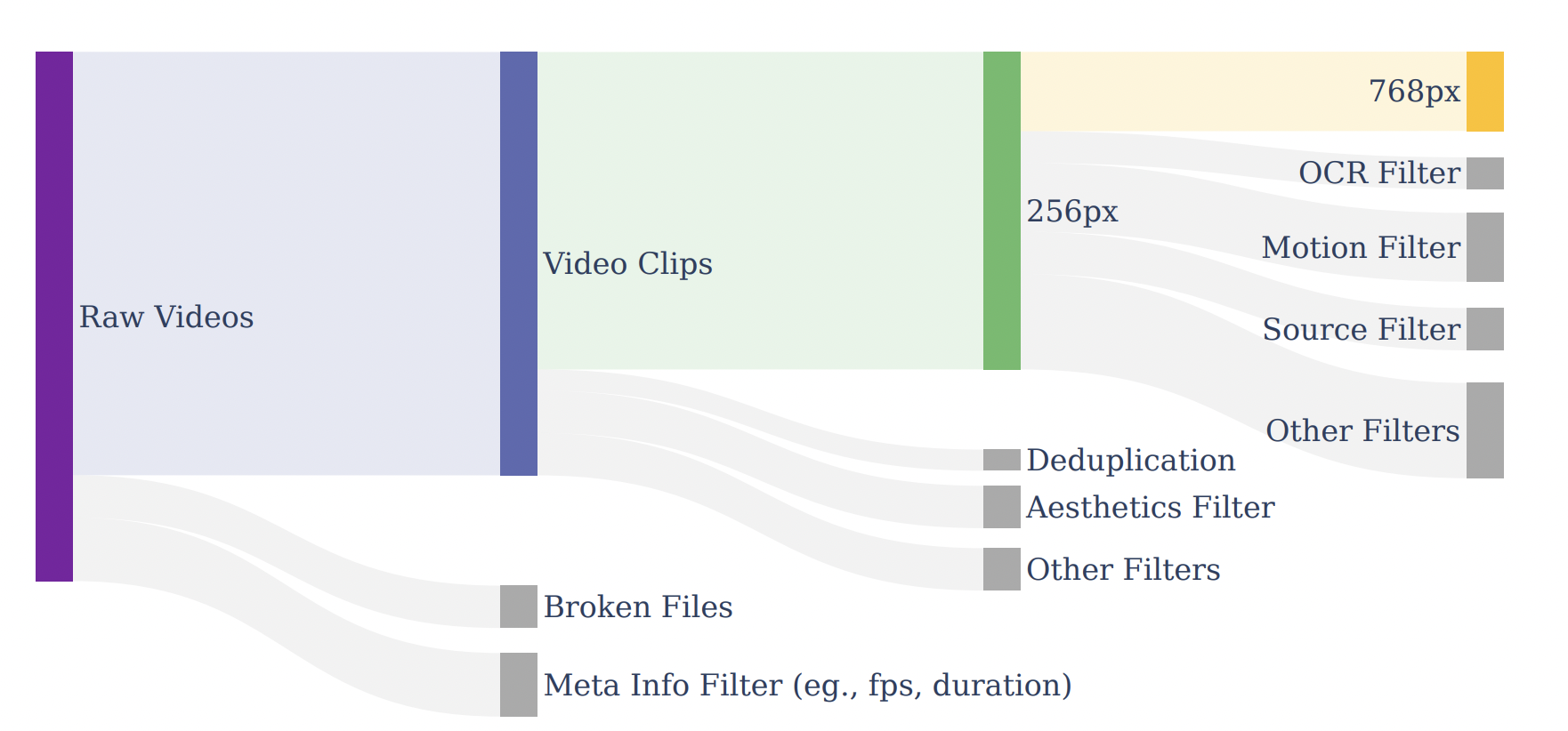

Создание иерархической пирамиды данных: от больших “сырых” наборов к меньшим, но более качественным подмножествам для разных стадий обучения;

-

Многоступенчатая фильтрация: Применение набора фильтров для отсева некачественного контента (битые файлы, низкое разрешение, статичные видео, размытие, избыток текста, дрожание камеры, оценка эстетики и движения);

-

Качественное аннотирование: Использование мощных VLM (вроде LLaVA-Video, Qwen 2.5 Max) для генерации подробных описаний видео. Фокус на обьектах, действиях, фоне, освещении, движении камеры и стиле. Добавление оценки движения (motion score) к описанию для лучшего контроля генерации.

Пайплайн фильтрации данных -

-

Архитектура модели (Model Architecture):

-

Эффективный автоэнкодер (Video DC-AE): Разработка собственного 3D автоэнкодера с глубоким пространственным сжатием. Это позволило существенно сократить количество токенов, обрабатываемых основной моделью (DiT), при сохранении приемлемого качества реконструкции видео.

-

Архитектура на основе DiT (Diffusion Transformer): Применение гибридной архитектуры с чередованием двухпоточных (раздельная обработка текста и видео) и однопоточных (взаимодействие модальностей) блоков. Использование 3D Rotary Position Embedding (RoPE) для лучшего учета пространственно-временных зависимостей. Применение мощных предобученных энкодеров текста (T5-XXL, CLIP-Large).

-

-

Стратегия обучения (Training Strategy):

-

Многоэтапное обучение: Обучение Text-to-Video (T2V) на низком разрешении (256px) для изучения базовых концепций и движения. Дообучение Text/Image-to-Video (T/I2V) на низком разрешении. Финальное дообучение T/I2V на высоком разрешении (768px) с использованием более качественных данных;

-

Использование предобученных моделей: Инициализация весов из открытой модели для генерации изображений (Flux 11B), что значительно ускоряет сходимость;

-

Фокус на Image-to-Video для высокого разрешения: Обнаружено, что адаптация к высокому разрешению эффективнее в режиме I2V (генерация по картинке + тексту). Модель уже “знает” движение из низкоразрешающего этапа и может сфокусироваться на деталях;

-

Multi-Bucket Training: Эффективная обработка видео разной длительности, разрешения и соотношения сторон в одном батче для оптимизации использования GPU.

-

Адаптация к новому автоэнкодеру: Специальная стратегия дообучения основной модели для работы с новым, более эффективным Video DC-AE.

-

-

Системная оптимизация (System Optimization): Хотя детали не раскрыты полностью, упоминается оптимизация ИИ-инфраструктуры как один из столпов экономии. Вероятно, это включает оптимизацию распределенного обучения, использование эффективных библиотек и железа (например, H200).

Результаты: Дешево и сердито?

-

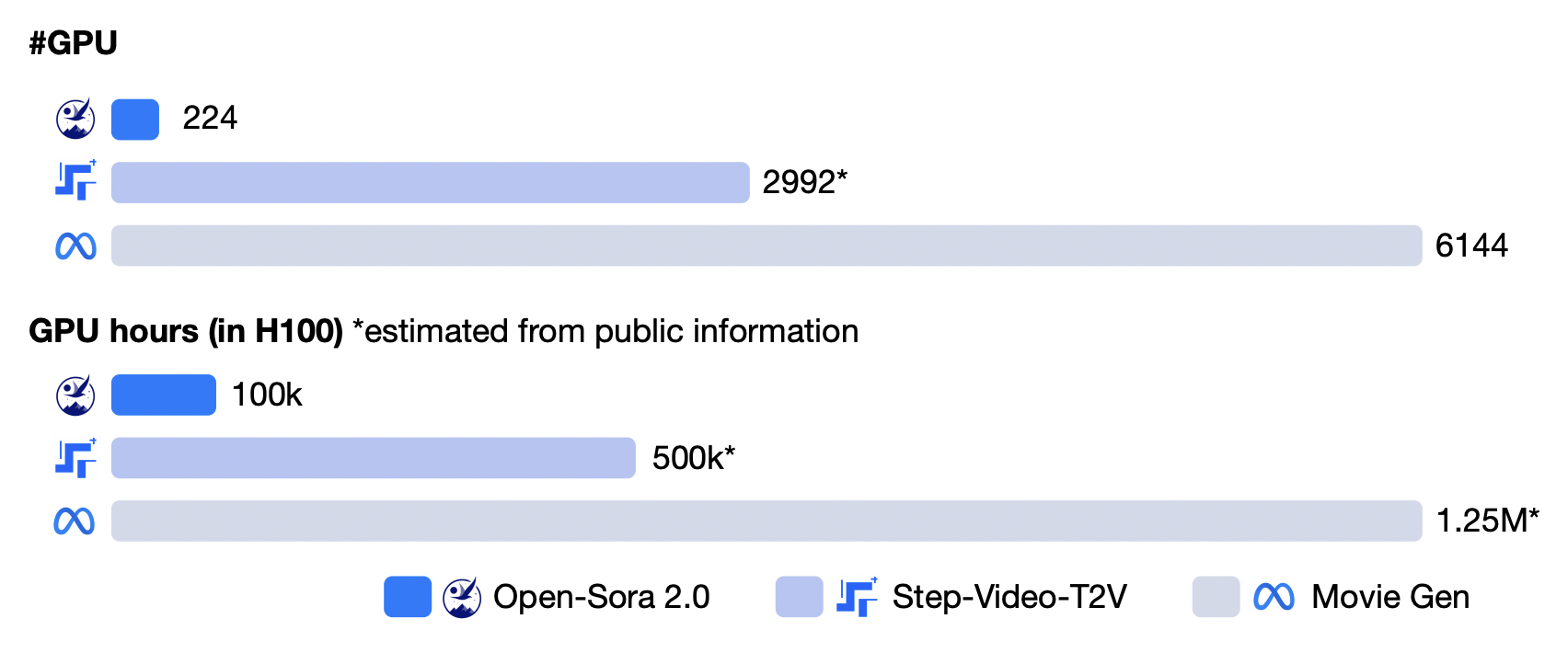

Главный результат: Обучение модели Open-Sora 2.0 обошлось в $199.6k. По оценкам авторов, это в 5-10 раз дешевле, чем обучение сопоставимых по качеству моделей (MovieGen, Step-Video-T2V).

-

Качество генерации:

-

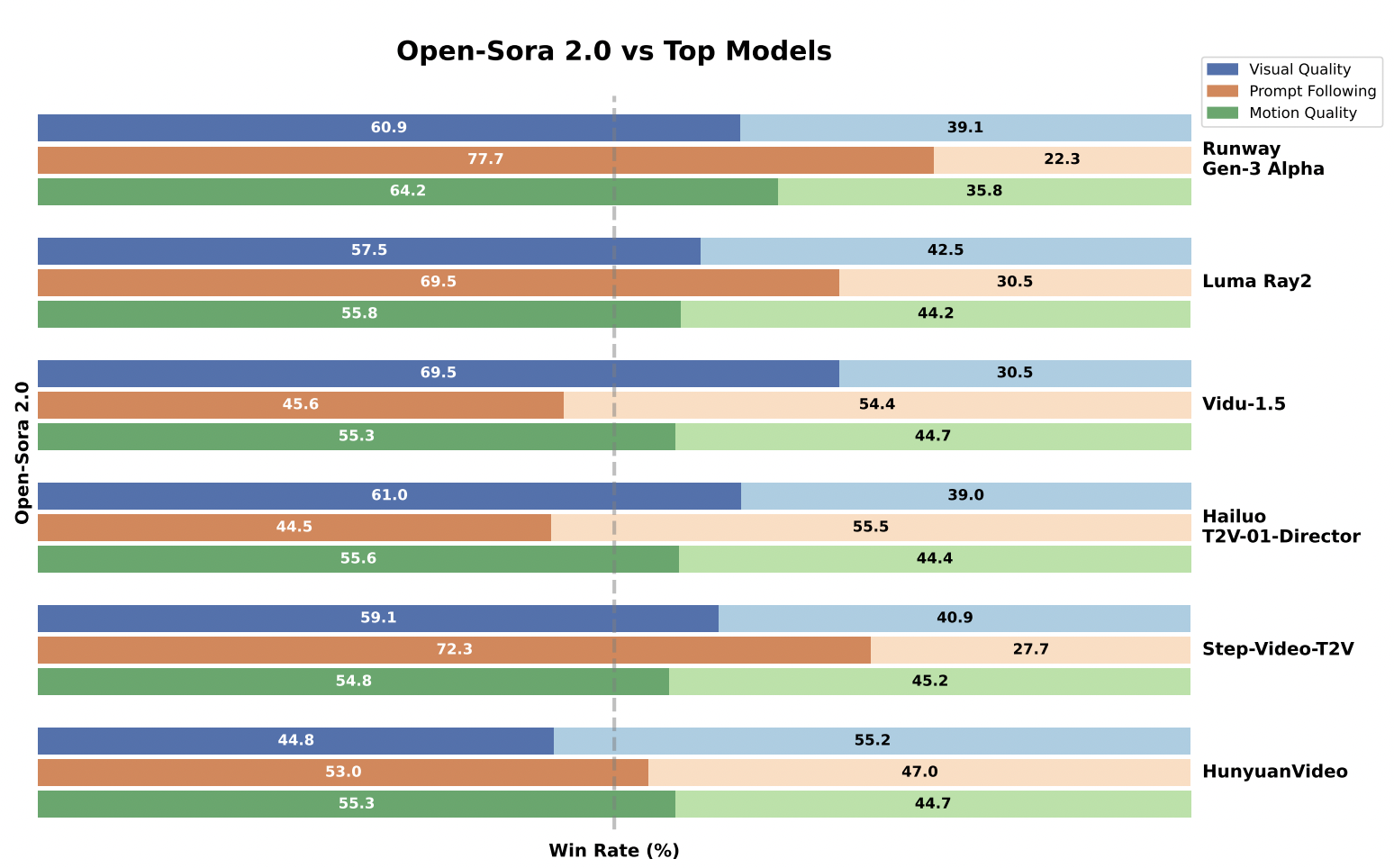

Оценки людьми (Human Evaluation): В слепом сравнении на 100 промптах Open-Sora 2.0 показала конкурентоспособные результаты по трем категориями (визуальное качество, точное соответствие текстовому запросу и качество движения) против Runway Gen-3 Alpha, Luma Ray2, HunyuanVideo. По некоторым аспектам (например, качество движения) она даже выигрывает у некоторых конкурентов.

Сравнение Open-Sora 2.0 с другими моделями -

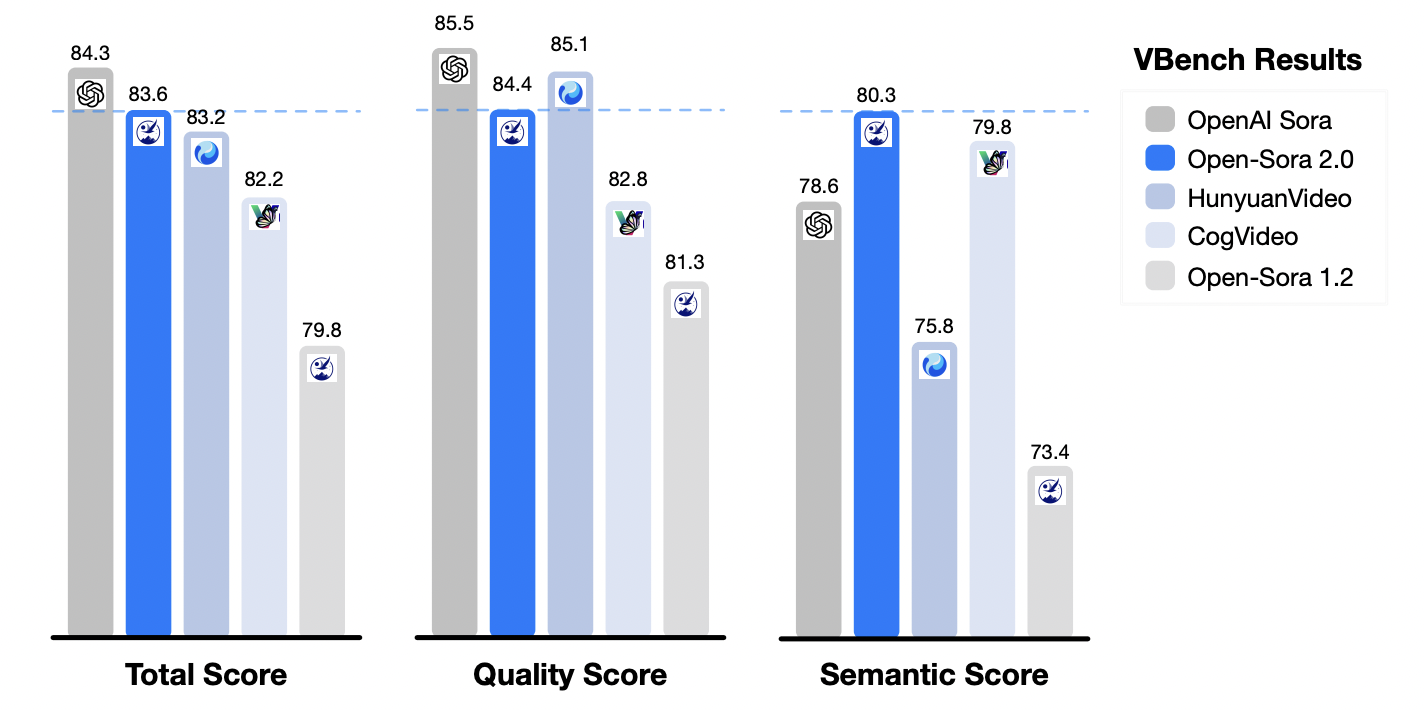

Обьективные метрики (VBench): В статье упоминаются хорошие показатели VBench, подтверждающие качество.

-

-

Эффективность Video DC-AE: Новый автоэнкодер показал сравнимое с HunyuanVideo VAE качество реконструкции, но при значительно большем сжатии. Это привело к ускорению обучения в 5.2 раза и ускорению инференса более чем в 10 раз на высоком разрешении по сравнению с использованием HunyuanVideo VAE.

-

Открытый доступ: Все ресурсы (код, веса модели, детали обучения) опубликованы на GitHub [4]. Это позволяет сообществу воспроизвести результаты и использовать модель.

Примеры генерации видео доступны по ссылке [5].

Новые возможности и подводные камни

Исследование убедительно доказывает, что создание высококачественных моделей генерации видео – не эксклюзивная прерогатива гигантов. Однако определение “коммерческого” уровня генерации видео несколько субъективно. Хотя сравнение с лидерами проведено, нужны более широкие и стандартизированные бенчмарки. Да, $200к значительно меньше миллионов, но для многих академических групп все еще существенная сумма. А насколько описанные методы будут эффективны для других задач (например, длинные видео) или наборов данных – требует дальнейшего изучения.

В любом случае “Open-Sora 2.0” – важное исследование, демонстрирующее прорыв в экономически эффективном обучении моделей генерации видео. Оно не только предлагает обученную модель, но и дает ценные инсайты и практические методики, которые могут серьезно повлиять на развитие индустрии, сделав передовые технологии доступнее. Открытость проекта – его ключевое преимущество, способствующее дальнейшему прогрессу.

—

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал [6] – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13867

URLs in this post:

[1] обучения: http://www.braintools.ru/article/5125

[2] “Open-Sora 2.0: Training a Commercial-Level Video Generation Model in $200k”: https://arxiv.org/abs/2503.09642

[3] стимулировать: http://www.braintools.ru/article/5596

[4] опубликованы на GitHub: https://github.com/hpcaitech/Open-Sora

[5] доступны по ссылке: https://hpcaitech.github.io/Open-Sora/

[6] подписывайтесь на мой Telegram-канал: https://t.me/+6ahh6mlNev85YWUy

[7] Источник: https://habr.com/ru/news/897286/?utm_source=habrahabr&utm_medium=rss&utm_campaign=897286

Нажмите здесь для печати.