Привет, чемпионы!

Данная работа полезна, если для вас “внимание-это все, что вам нужно” и вас интересует, как стали использовать трансформеры в других областях глубокого обучения.

Введение

Сверточные нейронные сети (CNN) долгое время были основой компьютерного зрения, эффективно справляясь с задачами классификации и детекции объектов. Однако у них есть свои ограничения:

-

Локальность обработки: При появлении архитектур, основанных на свертках свойство локальности позволяло учитывать отношения близости между соседними пикселями, однако это является и вместе с тем же камнем преткновения для дальнейшего улучшения архитектуры в связи с тем, что локальность обработки может затруднять понимание глобального контекста изображения.

-

Ограниченная интерпретируемость: Как и многие глубокие нейронные сети, CNN часто рассматриваются как “чёрные ящики”. Понимание того, какие признаки влияют на принятие решений моделью, может быть затруднительным, что осложняет объяснение её поведения.

Эти ограничения побудили исследователей искать новые подходы, и тут на сцену выходят трансформеры!

Принципы работы трансформеров в обработке естественного языка (NLP)

Трансформеры произвели революцию в обработке естественного языка благодаря механизму внимания, который позволяет моделям:

-

Фокусироваться на значимых частях текста: определять, какие слова важны для понимания контекста.

-

Учитывать дальние зависимости: понимать связи между словами, находящимися далеко друг от друга в тексте.

Эти способности делают трансформеры мощными инструментами для задач NLP, таких как перевод, суммирование и ответ на вопросы.

В целом данная работа позволила сделать серьезный виток для серии других открытий, благодаря своим возможностям по сравнению даже с ранее устоявшимися слоями в NLP.

А если вы не читали интереснейшую статью, как вас вообще сюда то занесло тогда???Сначала делаем тык по ссылке!!!

Адаптация трансформеров к компьютерному зрению: структура и особенности Vision Transformer

Идея применения трансформеров в компьютерном зрении развивалась долго, так как применить внимание к изображению, принимая каждый пиксель, как слово вероятно взорвало бы компьютер от вычислений ну или просто вычисляло бы очень долго…. кто знает, однако в последующем появились ребята, которые придумали крутое решение, основанное на уменьшении вычислительной сложности посредством разеделения изображения на кусочки или “патчи” размера Patch_size x Patch_size. Данное решение позволяет для изображения размера 1x224x224 создать 196 токенов при размере “патча” 16. Данная конфигурация уже звучит не сильно емко по вычислениям. Рассмотрим же реализацию Vision Transformer (ViT). Как это работает?

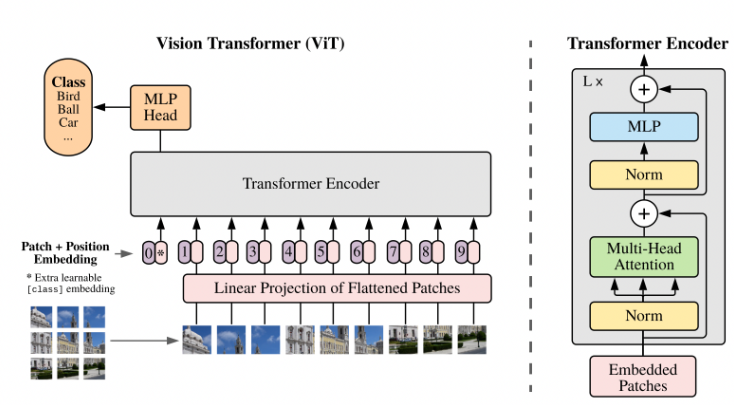

Архитектура VIT и энкодера трансформера

-

Разбиение изображения на патчи: вместо обработки всего изображения целиком, ViT делит его на небольшие фрагменты (патчи), например, размером 16×16 пикселей.

-

Преобразование патчей в эмбеддинги: каждый патч преобразуется в вектор фиксированной длины.

-

Добавление позиционного кодирования: поскольку трансформеры не учитывают порядок входных данных, добавляется информация о позиции каждого патча.

-

Применение механизма внимания: модель обучается определять, какие части изображения наиболее важны для выполнения конкретной задачи.

-

Использование модуля из полносвязных слоев для классификации

Такая архитектура позволяет ViT эффективно обрабатывать изображения, учитывая как локальные, так и глобальные признаки.

Преимущества ViT перед CNN: обработка глобальных зависимостей и эффективность обучения

ViT обладает рядом преимуществ перед традиционными CNN:

-

Глобальное внимание: благодаря механизму внимания, ViT может одновременно учитывать информацию из разных частей изображения, что улучшает понимание глобального контекста.

-

Эффективность обучения: исследования показали, что ViT может достигать высоких результатов при меньших вычислительных затратах по сравнению с CNN.

Применение ViT в различных задачах: классификация, сегментация, детекция

ViT успешно применяется в различных задачах компьютерного зрения:

-

Классификация изображений: определение категории объекта на изображении, где справляется модель достаточно неплохо на примере того же датасета CIFAR-10

-

Сегментация: разделение изображения на семантически значимые области, например, выделение объектов и фона. Изменение в некотором смысле архитектуры VIT позволило использовать его для сегментации-простой пример этому модель segmenter

-

Задачи OCR также неплохо были улучшены в некоторых доменных сценариях за счет VIT. Пример этому модель TrOCR, о ней если будет желание я могу рассказать отдельной статьей :)

В каждом из этих случаев ViT демонстрирует конкурентоспособные, а иногда и превосходящие результаты по сравнению с традиционными подходами.

Итог данного повествования или перспективы и вызовы использования трансформеров в компьютерном зрении

Трансформеры, и в частности Vision Transformer, открывают новые горизонты в компьютерном зрении. Однако есть и вызовы:

-

Требования к данным: для эффективного обучения ViT необходимы большие объемы данных.

-

Вычислительные ресурсы: несмотря на эффективность, обучение крупных моделей ViT все же требует значительных ресурсов.

-

Переобучение: трансформер, подобно зубрилке под одеялом в ночь перед экзаменом готов не выдержать и отвалиться, не дойдя до ваших заветных метрик, поэтому для решения данной задачи большое внимание придется уделить регуляризации и аугментации

Тем не менее, продолжающиеся исследования и разработки в этой области обещают сделать трансформеры еще более доступными и эффективными для широкого спектра приложений в компьютерном зрении.

Предполагаю, что дальнейшие адаптации, методы дистилляции и ускорения трансформеров позволят сделать следующий виток улучшений существующих моделей для типовых задач или открыть нечто новое в других областях компьютерного зрения

Попробуй реализовать какую-то работу с помощью данной модели, будь то bacbone или в целом архитектура для какого-то решения!!

Но если ты чуть-чуть ленишься, то можешь написать комментарий, как ты бы хотел увидеть, как я посвящу тебя в мир реализации пайплайна для обучения моделии классификации с bacbone на VIT или же дообучение модели TrOCR на ваших данных! А ведь всего-то комментарий и отметочка “нравится”.

Удачи, чемпионы! И помни! Семь раз проверь гипперпараметры, один раз запускай :)

Автор: Aleron75