Мы живем в цифровом мире: общаемся онлайн, пользуемся сайтами, приложениями и все чаще – ИИ-агентами. При этом постоянно повторяем одно и то же: вводим личные данные, отвечаем на похожие вопросы, вспоминаем детали прошлых разговоров. Это не только утомляет и перегружает мозг (увеличивает когнитивную нагрузку), но и мешает легко и эффективно работать с технологиями. Китайские исследователи создали фреймворк Second Me для управления личной памятью. Разбираемся как это работает.

Существующие решения вроде автозаполнения в браузере или систем единого входа (SSO) помогают лишь частично. Они работают как статические хранилища данных, но не понимают контекст и не умеют подстраиваться. Нам все равно приходится контролировать, проверять и часто вручную управлять этой информацией. С появлением больших языковых моделей (LLM) открылась возможность для принципиально нового подхода на основе ИИ к управлению личной памятью. Именно его и предлагают авторы статьи “AI-native Memory 2.0: Second Me”.

Цель исследования

Главная цель работы – разработать фреймворк Second Me: умной системы для “выгрузки” и управления личной памятью. Эта система должна стать не просто хранилищем, а динамическим посредником на базе ИИ во взаимодействиях пользователя с внешним миром (людьми, сервисами, другими ИИ).

Ключевые задачи Second Me:

-

Сохранять и организовывать знания пользователя в структурированном виде, используя возможности LLM;

-

Динамически использовать эти знания для автоматической генерации ответов, предзаполнения форм, поддержания контекста диалога;

-

Уменьшать умственную нагрузку и упрощать взаимодействие пользователя с цифровыми системами;

-

Предоставлять контекст, обогащая запросы пользователя к другим системам (например, к экспертным ИИ) нужной информацией о нем;

-

Разработать и протестировать полностью автоматизированный процесс (конвейер) для создания и дообучения таких персональных моделей на основе личных данных пользователя.

По сути, авторы хотят создать “второго Я” пользователя в цифровом пространстве. Оно возьмет на себя рутину, связанную с использованием личной информации, и будет действовать на опережение, исходя из контекста и потребностей пользователя.

Гибридная архитектура и автоматизированный процесс

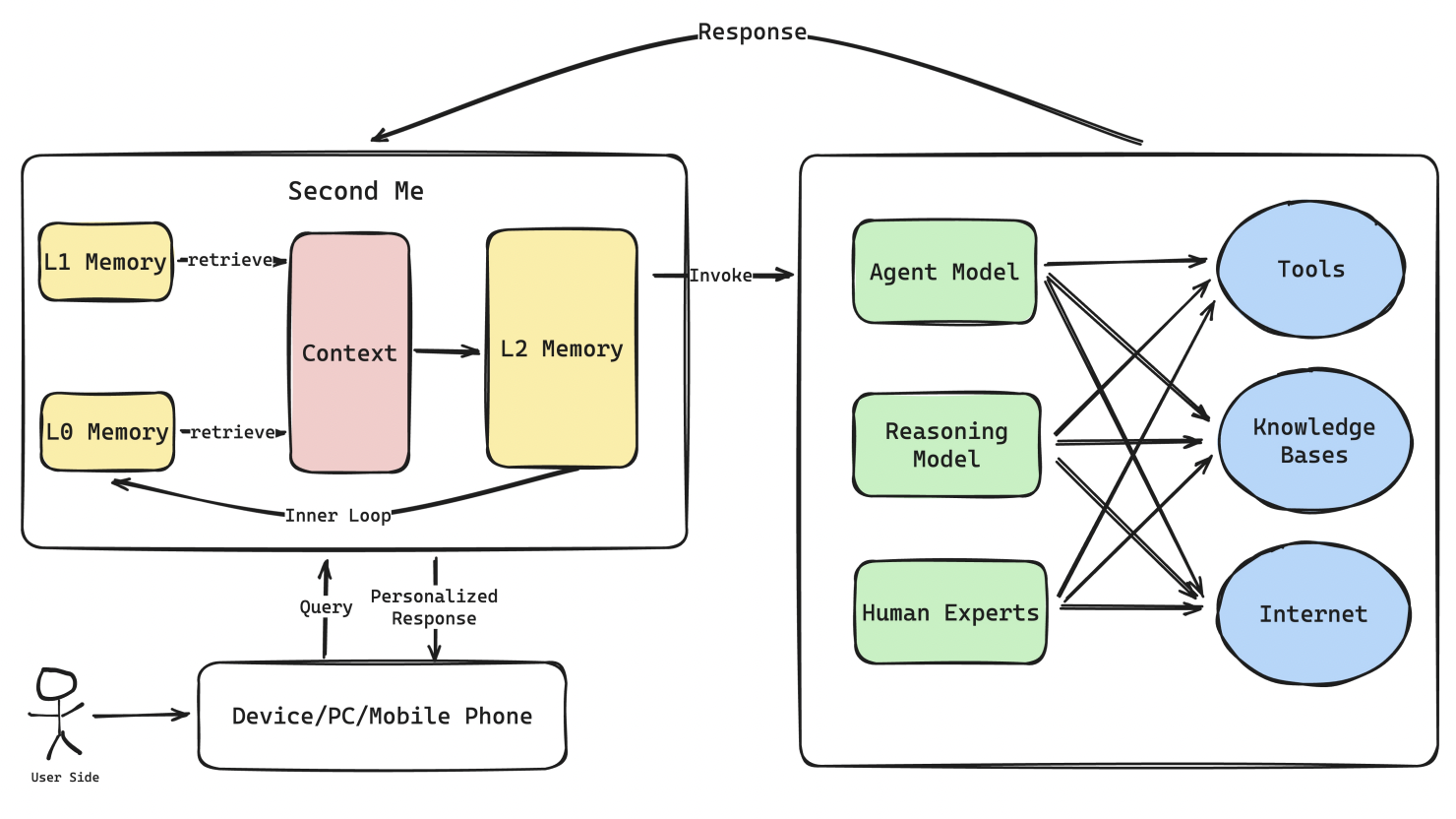

Для реализации Second Me авторы развивают свою предыдущую концепцию Large Personal Model (LPM) 1.0 и предлагают улучшенную гибридную архитектуру из трех уровней:

-

L0: Уровень сырых данных (Raw Data Layer): Неструктурированные данные пользователя (документы, логи и т.д.). К ним можно применять подходы вроде RAG (Retrieval-Augmented Generation).

-

L1: Уровень памяти на естественном языке (Natural Language Memory Layer): Структурированные или полуструктурированные данные на естественном языке (например, краткая биография, список предпочтений, важные факты).

-

L2: Уровень ИИ-памяти (AI-Native Memory Layer): Знания, усвоенные и организованные непосредственно в параметрах LLM. Эта модель (L2) является ядром системы.

Ключевые улучшения в Second Me по сравнению с LPM 1.0:

-

Улучшенная интеграция уровней: L0 и L1 активнее дают контекст модели L2.

-

Новая роль L2: Модель L2 теперь выступает не столько исполнителем, сколько координатором (оркестратором). Она управляет взаимодействием с внешними экспертными моделями и ресурсами, всегда действуя с точки зрения пользователя.

-

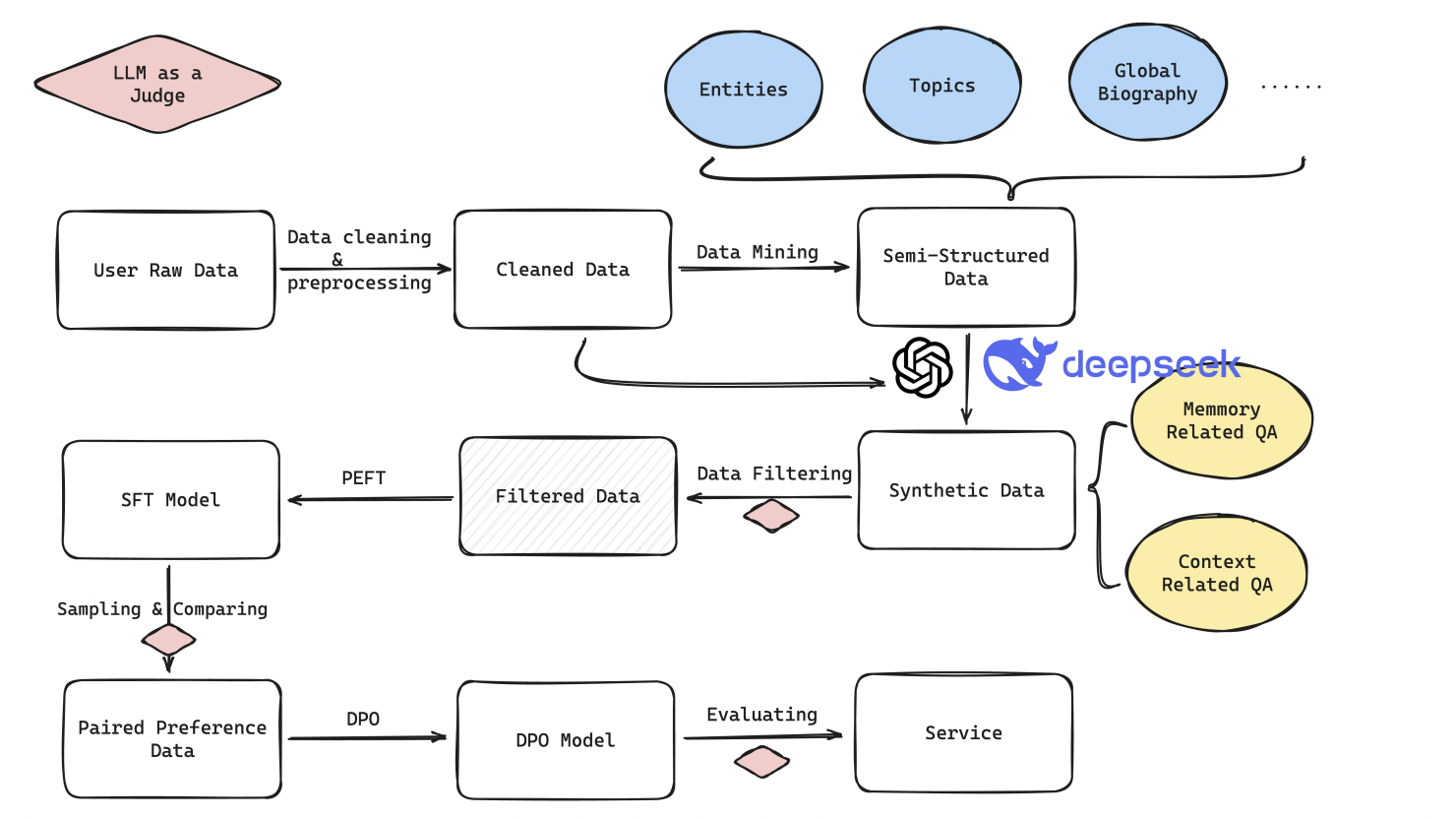

Полностью автоматизированный процесс обучения: Авторы разработали пайплайн, который включает:

-

Генерацию данных: Автоматическое создание обучающих данных из сырых данных пользователя с помощью LLM (включая стратегии Multi-agent и Chain-of-Thought (CoT));

-

Отбор данных: Многоуровневая фильтрация для выбора качественных примеров;

-

Обучение: Применение Parameter-Efficient Fine-Tuning (PEFT) для эффективной персонализации базовой LLM (Qwen2.5-7B-Instruct), а затем Direct Preference Optimization (DPO) для файнтюнинга на основе предпочтений пользователя;

-

Оценка: Автоматизированная оценка качества модели с помощью LLM-критика (судьи) по специально разработанным метрикам и задачам.

-

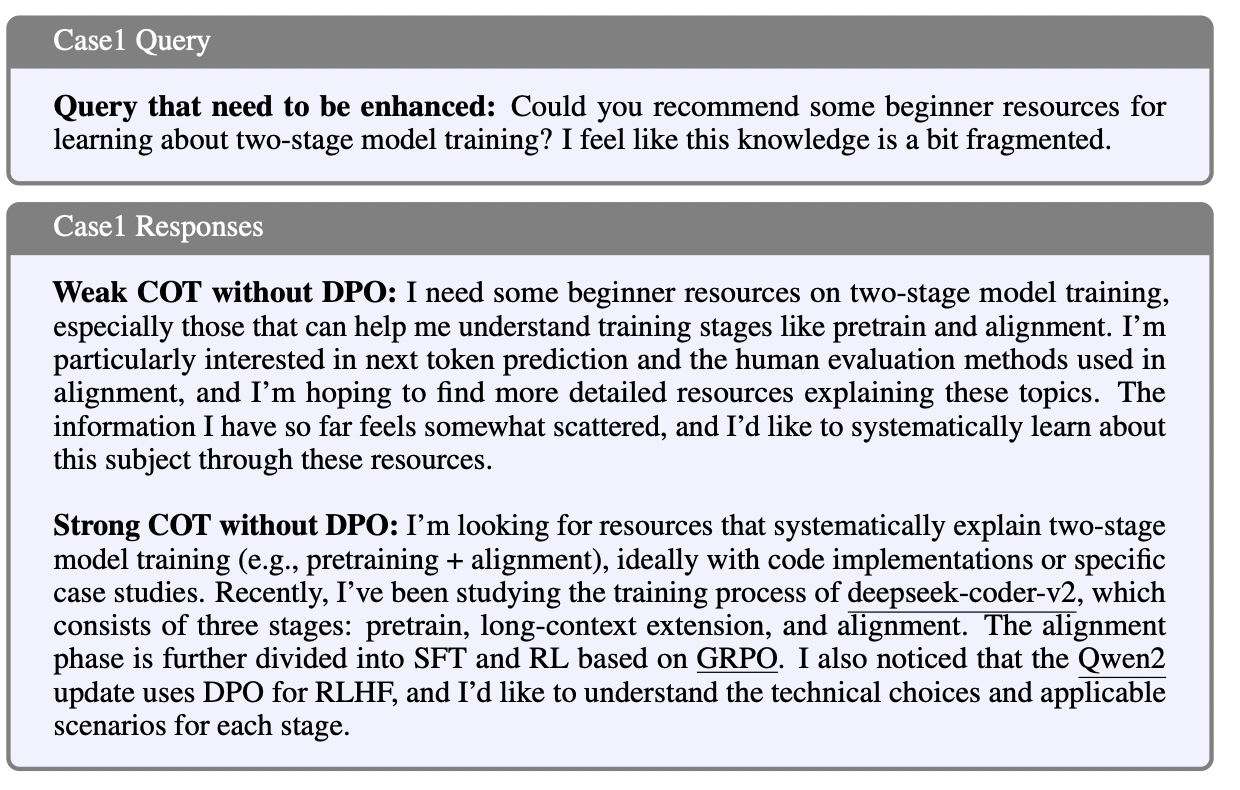

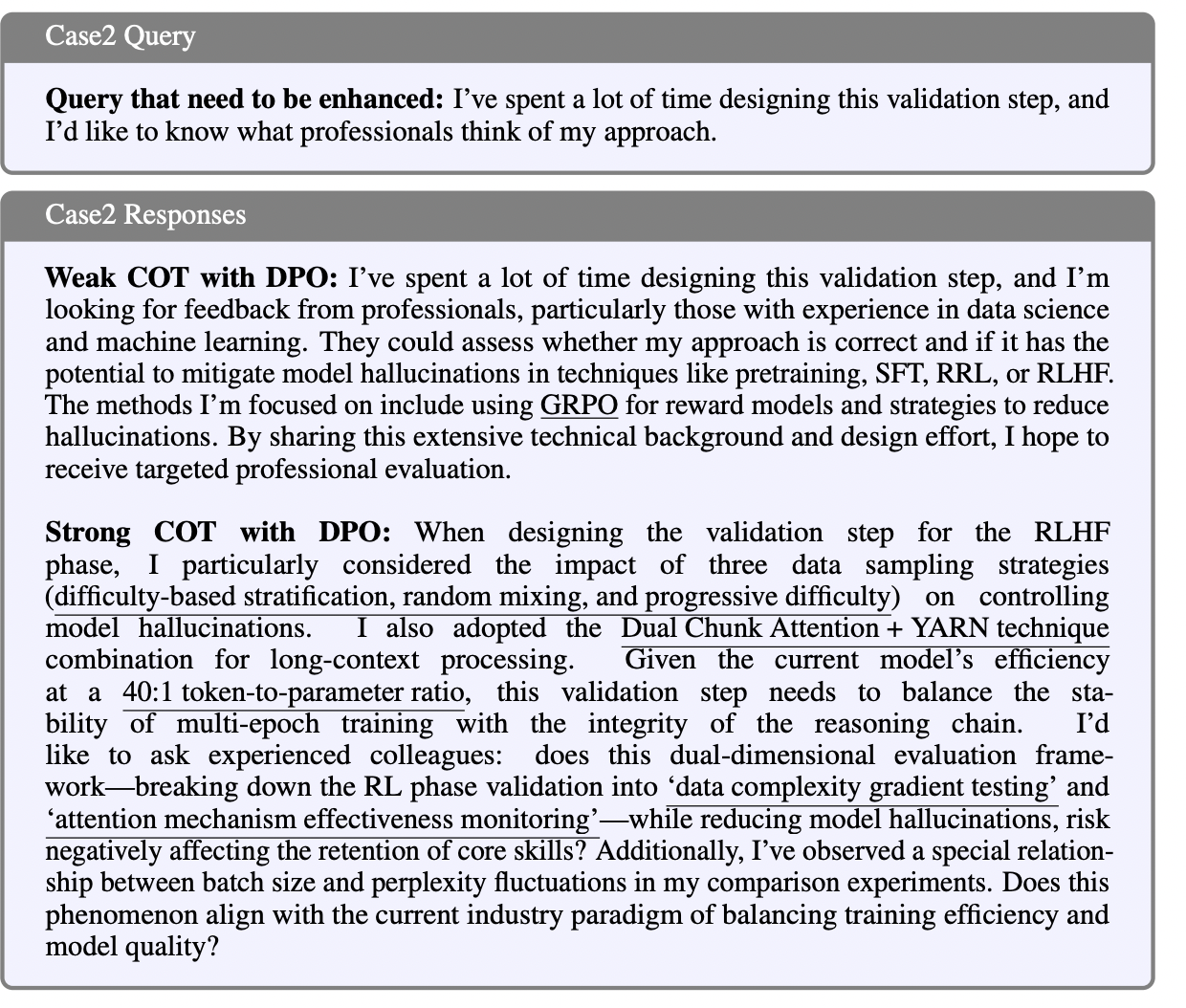

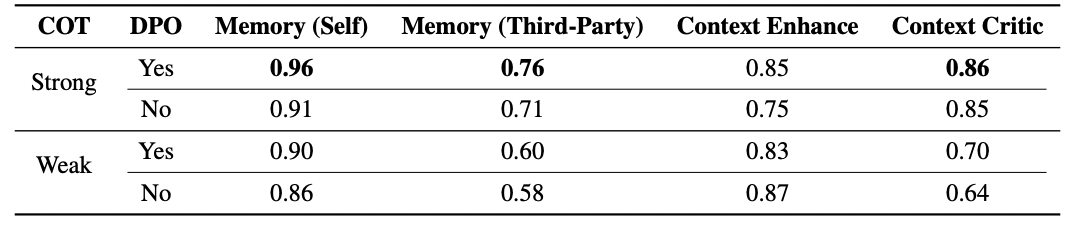

Особое внимание уделили цепочкам размышлений (Chain-of-Thought, CoT). Сравнивались три стратегии (Weak, Multi-step, Strong) для улучшения способности модели рассуждать и качества ее ответов. Также исследовали влияние DPO на улучшение соответствия модели вкусам пользователя.

Для оценки эффективности модели разработали три ключевые задачи:

-

Вопросы и ответы по памяти (Memory Q&A): Проверка умения извлекать и использовать информацию из памяти пользователя (как для самого пользователя, так и когда система представляет пользователя другим);

-

Дополнение контекста (Context Enhancement): Оценка умения модели дополнить запрос пользователя к внешнему сервису нужными деталями из его памяти;

-

Критика контекста (Context Critic): Оценка умения модели корректировать взаимодействие с внешним агентом, учитывая предпочтения и контекст пользователя.

Что показали эксперименты

-

Стиль данных важен: Использование данных, сгенерированных в стиле “Strong CoT” (с четкой структурой рассуждений и ответов), значительно улучшает работу модели по всем задачам по сравнению с более слабыми вариантами CoT;

-

DPO улучшает персонализацию: Применение Direct Preference Optimization (DPO) после Supervised Fine-Tuning (SFT) заметно повышает качество. Модель лучше учитывает тонкости предпочтений пользователя и использует нужные данные из его записей (это видно на конкретных примерах);

-

У автоматической оценки есть ограничения: Хотя автоматизированная оценка с помощью LLM позволяет быстро проверять модели, она не всегда точно показывает реальное качество, например, критик может предпочитать более длинные ответы.

В целом, результаты подтверждают, что предложенный подход работает, а автоматизированный конвейер эффективен для создания персональных ИИ-помощников памяти.

Выводы

Статья представляет Second Me как многообещающий фреймворк для создания персональных ИИ-систем нового поколения. Они смогут выступать в роли “второго Я” пользователя, расширяя его умственные возможности и упрощая работу с цифровым миром.

Однако текущий подход основан на одношаговых взаимодействиях. Для дальнейшего прогресса нужна более сложная генерация многошаговых диалогов. Также присутствуют ограничения автоматической оценки и необходимость собирать много обратной связи от реальных пользователей. Более того, текущая работа сосредоточена на тексте, но для полного охвата человеческого опыта нужно добавить другие модальности (изображения, аудио и т.д.).

Но в любом случае работа “AI-native Memory 2.0: Second Me” – это важный шаг к созданию по-настоящему персональных и полезных ИИ-помощников. Предложенная гибридная архитектура и автоматизированный процесс обучения выглядят перспективно. Открытый исходный код – большой плюс для дальнейшего развития и адаптации технологии сообществом.

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и обьясняю, как работают все эти ИИ-чудеса.

Автор: Dataist