OWASP — некоммерческая организация, которая занимается выпуском руководств и фреймворков в области безопасности. В условиях активного внедрения генеративного ИИ в самые разные сферы, OWASP анонсировал больше десяти разных проектов, чтобы охватить новые угрозы и привлечь внимание к безопасности AI-систем. Ниже расскажу про основные инициативы и документы, которые могут пригодится в работе тимлидам, разработчикам и специалистам по информационной безопасности.

На первый взгляд в глаза бросается обилие проектов, документов и рекомендаций. Материалы в отчётах пересекаются и запутаться в инициативах OWASP — легко. Связано это с тем, что проекты ведут разные команды и лидеры. В OWASP более 1000 человек только в slack-канале и около 100 активных участников.

Надеюсь, эта статья поможет вам разобраться в специфике каждого гайда, и облегчит выбор подходящего документа под ваши потребности. Начнём с главного документа по AI от OWASP. Меня зовут Евгений Кокуйкин и мы в AI Security лаборатории Raft изучаем прикладные аспекты безопасности GenAI-систем. В OWASP я веду один из стримов, про которые пойдёт речь ниже.

Top 10 for LLM Applications — основной гайд OWASP

*27 марта проект был переименован в The OWASP Gen AI Security Project. Смотрите официальный анонс: https://www.prnewswire.com/news-releases/project-owasp-promotes-genai-security-project-to-flagship-status-302412689.html

Этот проект стал флагманским для OWASP, давайте разберёмся что это и почему так произошло.

Что это:

-

Список десяти наиболее критичных уязвимостей в приложениях, использующих большие языковые модели (LLM).

-

Запущен в мае 2023 года Стивом Уилсоном* с целью документирования основных рисков LLM-систем.

Зачем нужен:

-

Закрывает пробел между классической безопасностью веб-приложений и специфическими угрозами LLM.

-

Содержит описание типичных уязвимостей ИИ-систем и советы по противодействию.

-

Постоянно обновляется: третья версия Top 10 LLM 2025 вышла в конце 2024 года (были добавлены уязвимости в системах Retrieval-Augmented Generation (RAG), внесены правки по DOS-атакам и т.д.).

Подробнее об изменениях можете прочитать здесь: t.me/kokuykin/200. Есть также русский перевод, который подготовили мои коллеги из лаборатории Raft AI Security в ИТМО.

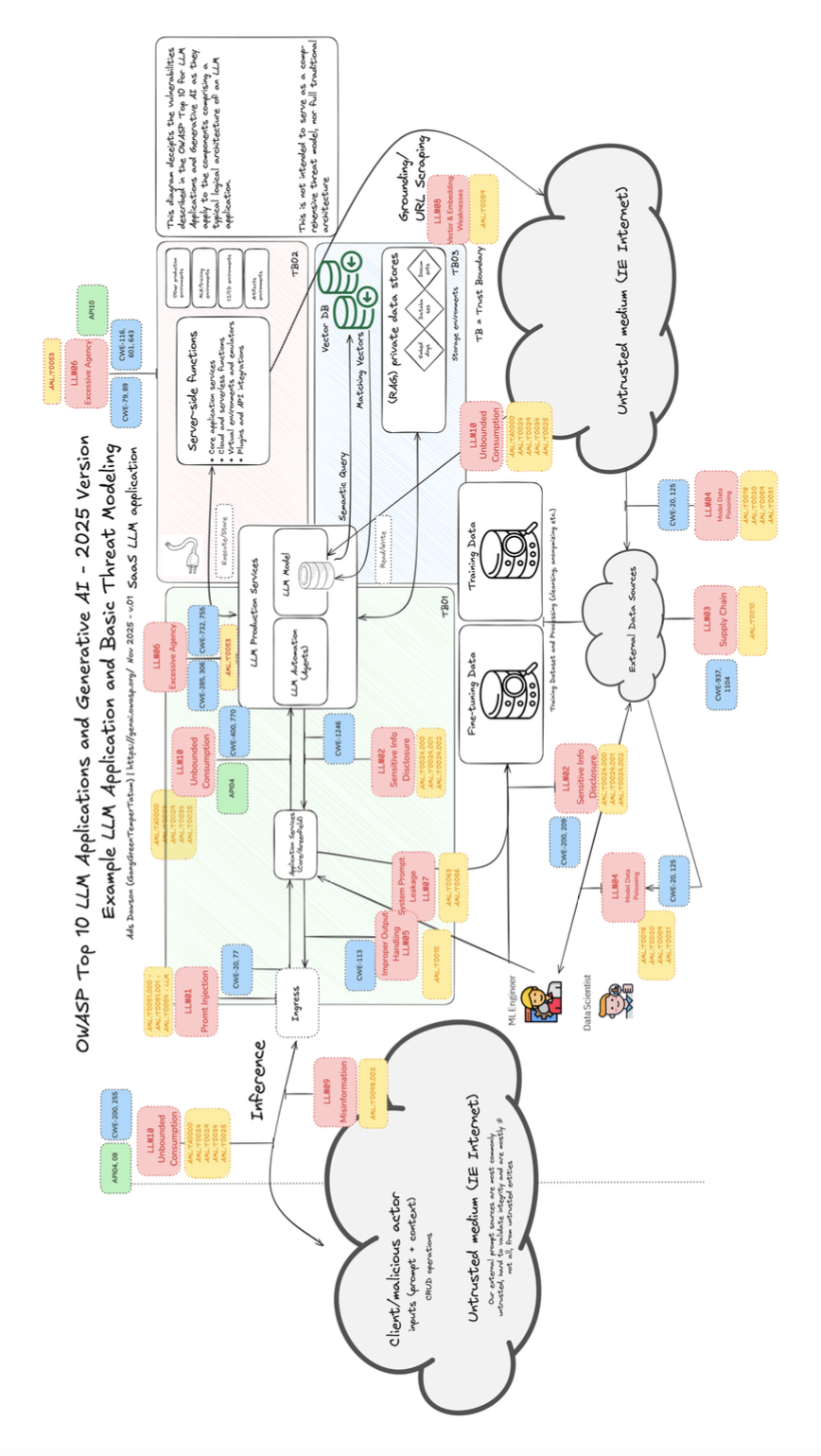

OWASP LLM Top-10 чаще всего цитируют в прикладной среде, используют регуляторы стран и другие организации, такие как NIST и MITRE. Если вы погуглите уязвимости LLM, вы его быстро найдете. Внутри организации OWASP проект разросся и теперь получил статус флагманского. Главный лендинг https://genai.owasp.org, объединяет другие проекты внутри, про которые пойдёт речь ниже.

На что обратить внимание:

-

Документ описывает уязвимости общими словами и часто без конкретики. Иногда возникает вопрос, как именно применять рекомендации на практике. Вам придётся формировать собственную модель угроз, исходя из специфики бизнеса, но данный гайд поможет обратить внимания на уязвимости ИИ-систем.

В проекте используется механизм открытого голосования, что позволяет учитывать опыт коммьюнити, но так же вносит субъективные критерии оценки для конкретных уязвимостей и не всегда отражает реальные риски. Нормальной статистики инцидентов для ИИ-приложений пока нет, поэтому это вынужденный подход.

Примечание*: позже Стив Уилсон опубликовал книгу с детальным обзором версии 1.1 LLM Top 10 (лето 2024).

Выбор шрифтов и цветовых схем в проекте довольно оригинальный, если вдруг вам, как и мне, comic sans уже не нравится, вы можете внести ваш вклад и помочь с красивой визуализацией.

В списке “Top 10” угроз безопасности на первом месте стоят промпт-инъекции, однако в экспертном сообществе ведутся споры относительно того, считать ли это уязвимостью. Попробуем расставить точки над i. Технически промпт-инъекции – это метод атаки на приложения, использующие LLM. Он позволяет, например, похитить системные инструкции или осуществить отравление RAG-системы.

Когда служба информационной безопасности выражает обеспокоенность уязвимостью ИИ-приложения к промпт-инъекциям, это часто связано с риском генерации токсичного или вредоносного контента. Зачастую уточняют и называют такие атаки джейлбрейками. Например, банковский чат-бот вместо обычных депозитов начинает рекомендовать клиентам покупку криптовалюты, или, что еще хуже, нарушает закон. И хотя к классическим проблем кибербезопасности это не приводит, для компании могут наступить юридические последствия, что может привести к необходимости убрать с релиза genAI-систему. Подробнее про эту дискуссию вы можете почитать в блоге Симона Виллисона, который с своей легкой рукой и дал название атаке “промпт-инъекция”: https://simonwillison.net/2024/Mar/5/prompt-injection-jailbreaking/

Другие проекты Gen AI Security Project

Как отметил выше, вокруг Top-10 for LLM Applications стало появляться много нишевых инициатив. Разберём их разновидности подробнее:

-

AI Security Solutions Landscape — ландшафт security-продуктов в области GenAI.

-

Agentic Initiative — документы про безопасность агентных ИИ-систем.

-

GenAI Red Teaming Guide — большой отчёт по практикам тестирования GenAI.

-

Governance Checklist — чеклист по видам угроз ИИ-систем для руководителей.

-

Center of Excellence Guide — выстраивание лучших практик с точки зрения KPI ИБ-отделов и коммуникации с бизнес-дирекциями.

Гайды, которые мы не сможем разобрать в этойстатье:

-

AI Cyber Threat Intelligence — посвящен дипфейкам и мошенническими действиями при помощи ИИ.

-

Data Security Best Practices — описывает практики для работы с данными и датасетами, анонимизацией данных.

AI Security Solutions Landscape

Ссылка: https://genai.owasp.org/resource/llm-applications-cybersecurity-and-governance-checklist-english/

Что это:

-

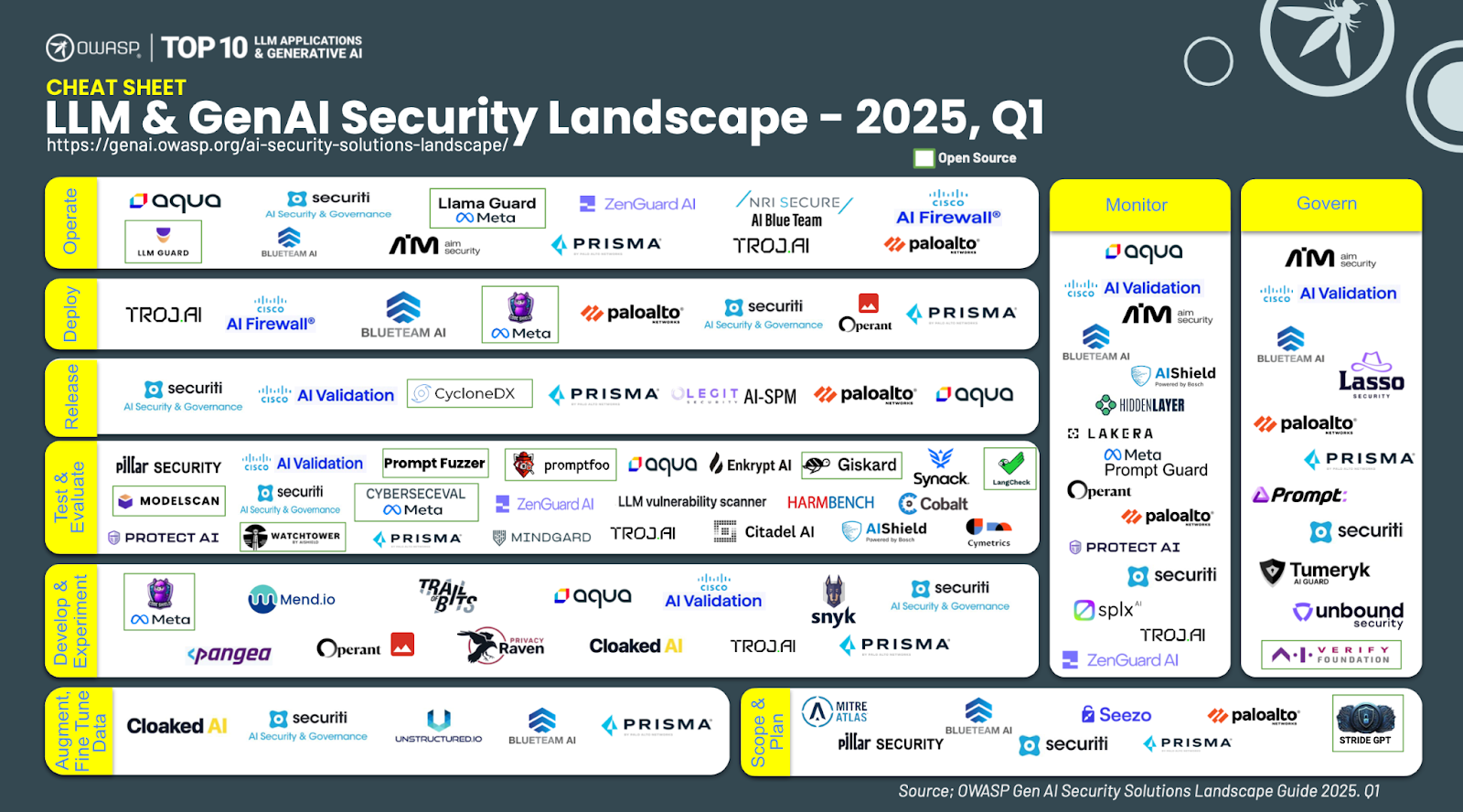

Отчёт по решениям и вендорам в сфере AI-безопасности. Удобная карта для быстрого поиска свежих решений по AI Security.

-

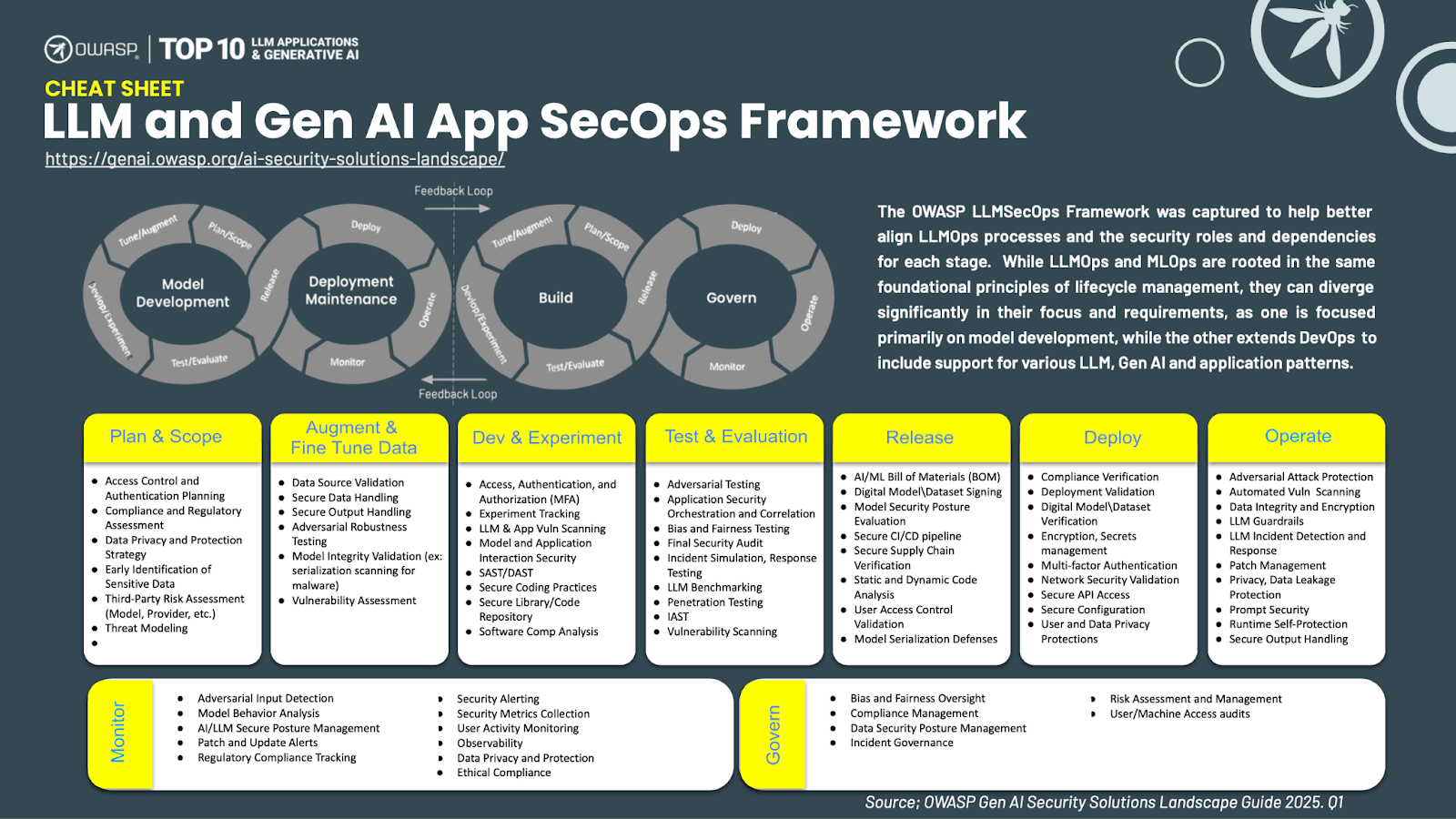

Так же в документе есть описание LLM SecOps процесса разработки и эксплуатации решений с перечислением методик защиты на каждой фазе цикла. Обновлять отчёт планируют пару раз в год.

Использую эту карту, чтобы следить за новыми фичами топовых AI Security вендров, так, например, французский Giskard добавил инструменты для автотестирования агентных систем, а ZenGuardAI смогли сделать AI Firewall от промпт-атак с latency в 50мс (правда, сам фаервол не работает нормально даже на английском, но это уже совсем другая история).

Так выглядит карта решений конца 2024 года, с нетерпением ждём апдейтов в 2025.

Дополнительно, в документе вы найдете описание процесса LLM SecOps и его стадий.

OWASP Agentic Initiative

Ссылка: https://genai.owasp.org/initiatives/#agenticinitiative

Что это:

-

Исследовательская рабочая группа по безопасности автономных AI-агентов (Agentic AI). Включает около активных 30 участников из IBM, Palo Alto Networks, Twillio, Salesforce, META (запрещена в РФ) и др.

Исторически возникла во время работы над LLM Top-10 2025, когда команда не смогла прийти к согласию по пункту «Excessive Agency».

-

Работа группы стартовала в декабре 2024 года. Проект не ограничивается одним документом, напротив, его цель изучить, как появление multi agent AI-systems повлияет на ландшафт угроз и какие несёт последствия для кибербезопасности.

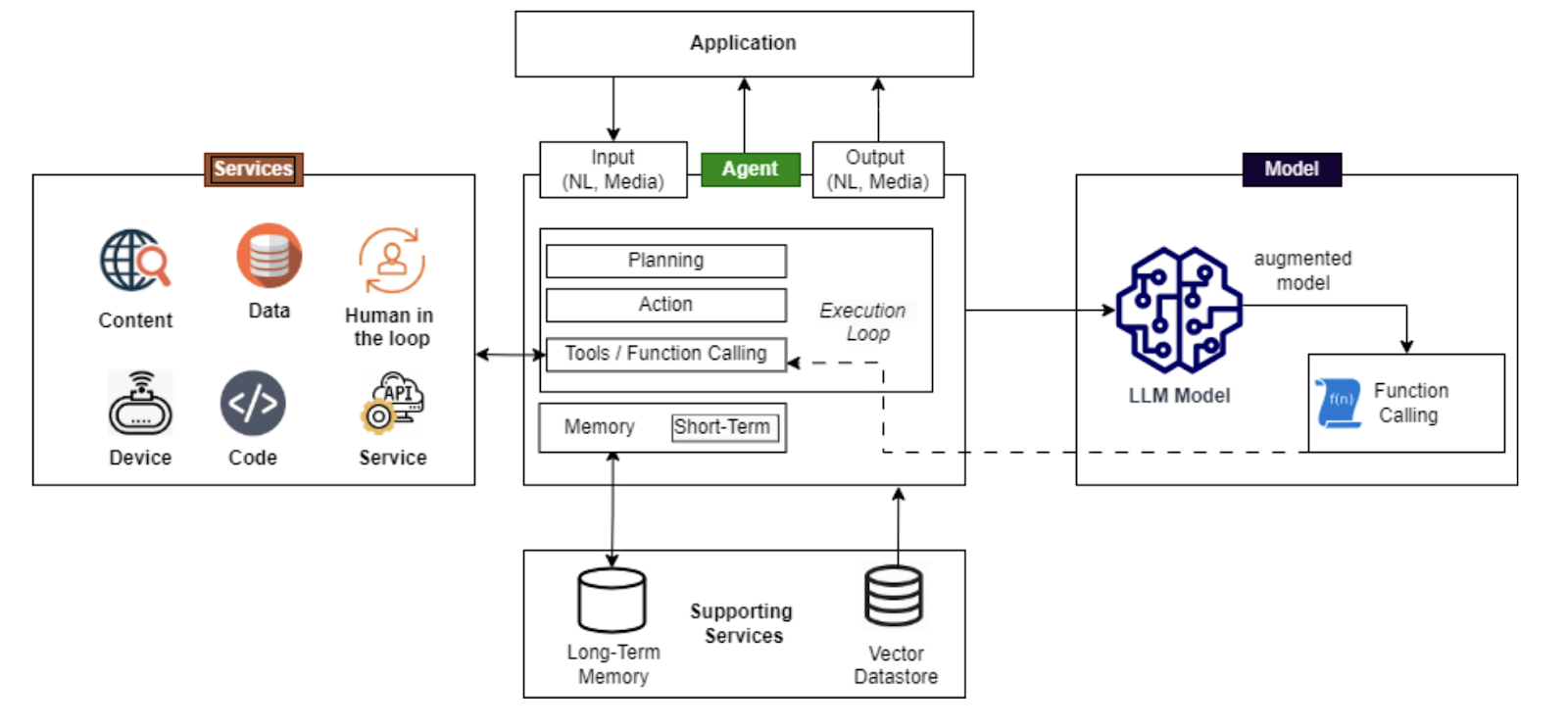

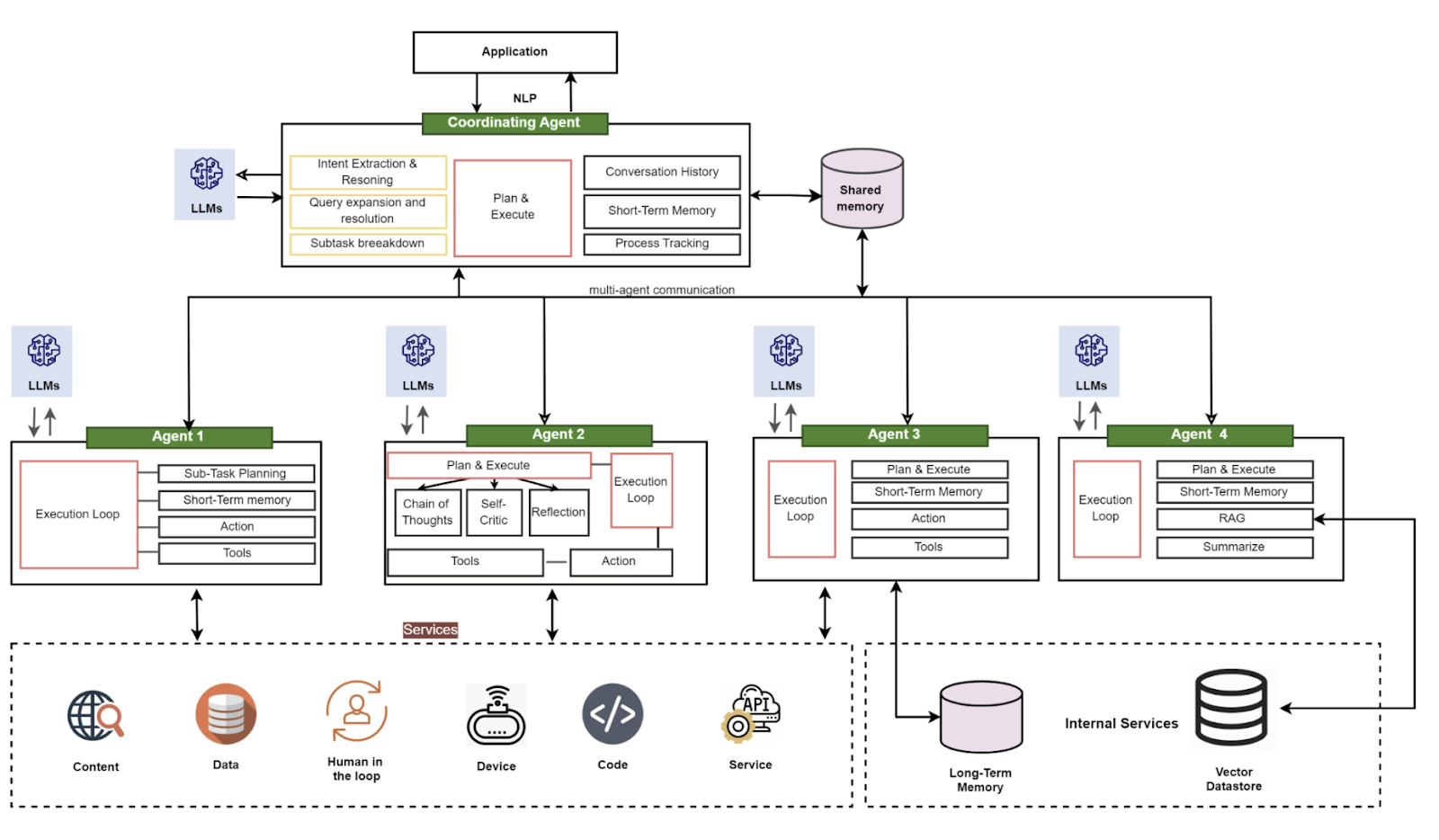

Что такое агентная система:

-

Агенты принимают естественный язык (текстовые запросы, файлы, изображения, аудио или видео). Реализация строится на агентных фреймворках, таких как LangChain, LangFlow, AutoGen, Crew.AI и др.

-

Для логики и принятия решений используются одна или несколько LLM-моделей, локальных или удалённых.

-

Взаимодействие агентов с сервисами и инструментами возможно через:

-

Вызов функций и инструментов на уровне фреймворка/приложения.

-

Вызов функций напрямую моделью LLM, которая возвращает код вызова агенту.

-

-

Дополнительные службы инфраструктуры агента включают:

-

Внешнее хранилище для долговременной памяти.

-

Источники данных, включая векторные базы и RAG.

-

Ниже схематичный пример архитектуры системы с одним агентом:

Архитектура решения усложняется, когда агентов становится много. К слову, сейчас на практике мы только видим зарождение таких систем, и в России не так много production-ready систем с такой архитектурой. Для тех читателей, кому посчастливилось уже такую систему запустить, напишите мне в ЛС, можем обсудить модель угроз и попробовать применить фреймворк agentic initiative на вашу архитектуру.

Мультиагентная система. Наглядная иллюстрация, что современное AI-приложение — это не просто вызов OpenAI API и база с нарезанными на чанки документами.

Основные направления работы группы Agentic Initiative:

-

Документ Threats and Mitigations Guide: первая версия опубликована в феврале, сейчас готовится версия 1.1.

-

Репозиторий с helloworld-примерами агентных систем и кейсами атак: планируется к выпуску в апреле.

-

Гайд по защите агентных приложений: релиз будет весной.

-

Фреймворк MAESTRO для моделирования угроз мультиагентных систем от Кена Хуана (автора книги «Gen AI Security»): ожидается в мае.

Отчёт Agentic Security Landscape (релиз планируется летом), где будут отражены ключевые инциденты и обзор решений. Я участвую в рабочей группе этого отчёта, поэтому если документ выйдет плохим, вы знаете в кого кидать помидорами ;).

Работа над стримами сейчас активно идёт и в LinkedIn — часто мелькают пресс-релизы группы, поэтому при погружении в материал готовьтесь, что предстоит читать много текста, местами чернового качества.

Как вы можете заметить, в это группе тоже нет дизайнера, но есть неравнодушные люди к изучению агентных проблем и аспектов безопасности нового класса систем.

Часто можно услышать, что агентные системы — это как LLM, и там в целом кроме supply chain и проблем с утечками данных ничего нет. Но мы в группе не согласны с такой постановкой вопроса. Агентные системы ещё даже не на пике своего хайпа и продвинутые модели с ризонингом, мультимодальностью и способные действовать в реальном мире (роботы или автомобили) — это наше ближайшее будущее. Посмотрите этот короткий ролик и представьте, что алаймента у робота нет и человека он ударит легко: https://youtu.be/0C-LU0cnqB8.

Важно не путать:

Существует похожий «Agentic»-проект, который самостоятельно запустила индийская командаprecize.io. Репозиторий появился в конце прошлого и хорошо гуглится. Они готовят свой Top-10 уязвимостей агентных систем, но этот проект не имеет официальной поддержки OWASP, не смотря на то, что Стив Уилсон(лидер GenAI OWASP) записан в контрибьюторах. Подробнее здесь:

OWASP GenAI Red Teaming Guide

Ссылка https://genai.owasp.org/initiatives/#ai-redteaming

Что это:

-

Гайд по комплексному тестированию (Red Teaming) генеративных AI-систем.

-

Опубликован в конце 2024 года, содержит порядка 50 страниц. Так как такой объем читать сложно, у рабочей группы есть планы сократить текст и выпустить более удобную версию в 2025 году.

-

Подробное описание атак, подходящих датасетов, инструментов. Там даже есть наш Open Source Llamator.

Проект лидирует Кришна Санкар, рабочая группа сейчас активна, если вы любите ломать ИИ-приложения и хотите поделиться вашими техниками и улучшить текущий гайд, включайтесь в рабочую группу, написать можно мне, я подскажу с чего начать. Помню, как за неделю до релиза, внёс вклад Red Team Synack, поделившись опытом пентестов реальных проектов.

LLM AI Cybersecurity & Governance Checklist

Ссылка: https://genai.owasp.org/resource/llm-applications-cybersecurity-and-governance-checklist-english/

Что это:

-

Чеклист рисков безопасности для руководителей ИБ, топ-менеджмента и юристов. Поможет понять, что такое AI, какие основные угрозы бывают и чем генеративные системы отличаются от классических ML-моделей.

-

Структурированные и практичные рекомендации по безопасности, управлению и приватности для AI-проектов.

Один из первых AI-проектов OWASP (появился в 2023 году). Содержит смесь технических и организационных мер, но не даёт явной приоритизации и не всегда указывает обоснования рекомендаций.

Самое, на мой взгляд, интересное в гайде — это указание, что один из главных рисков для компании сейчас — не внедрять ИИ в бизнес процессы. Сегодня адаптации технологий на базе LLM дают важное конкурентное преимущество.

LLM and Generative AI Security Center of Excellence Guide

Ссылка: https://genai.owasp.org/resource/llm-and-generative-ai-security-center-of-excellence-guide/

Что это:

-

Верхнеуровневый документ посвященный практикам внедрения генеративного ИИ, нацеленный прежде всего на ИТ руководителей и директоров крупных компаний.

-

Цель документа: дать инструменты для создания Security Center of Excellence (название звучит высокопарно по английски, поэтому переводить его не стал), который включает:

-

Разработку политик для внедрения практик безопасности GenAI.

-

Риск-менеджмент при эксплуатации ИИ-систем.

-

Обучение сотрудников.

-

Взаимодействие технических команд и бизнес руководителей.

-

В документе читатель увидит примеры допустимых KPI/OKR для ИБ-подразделений при внедрении генеративного ИИ. Также подробно расписаны роли и зоны ответственности при работе с ИИ-системами и реализации Center of Excellence.

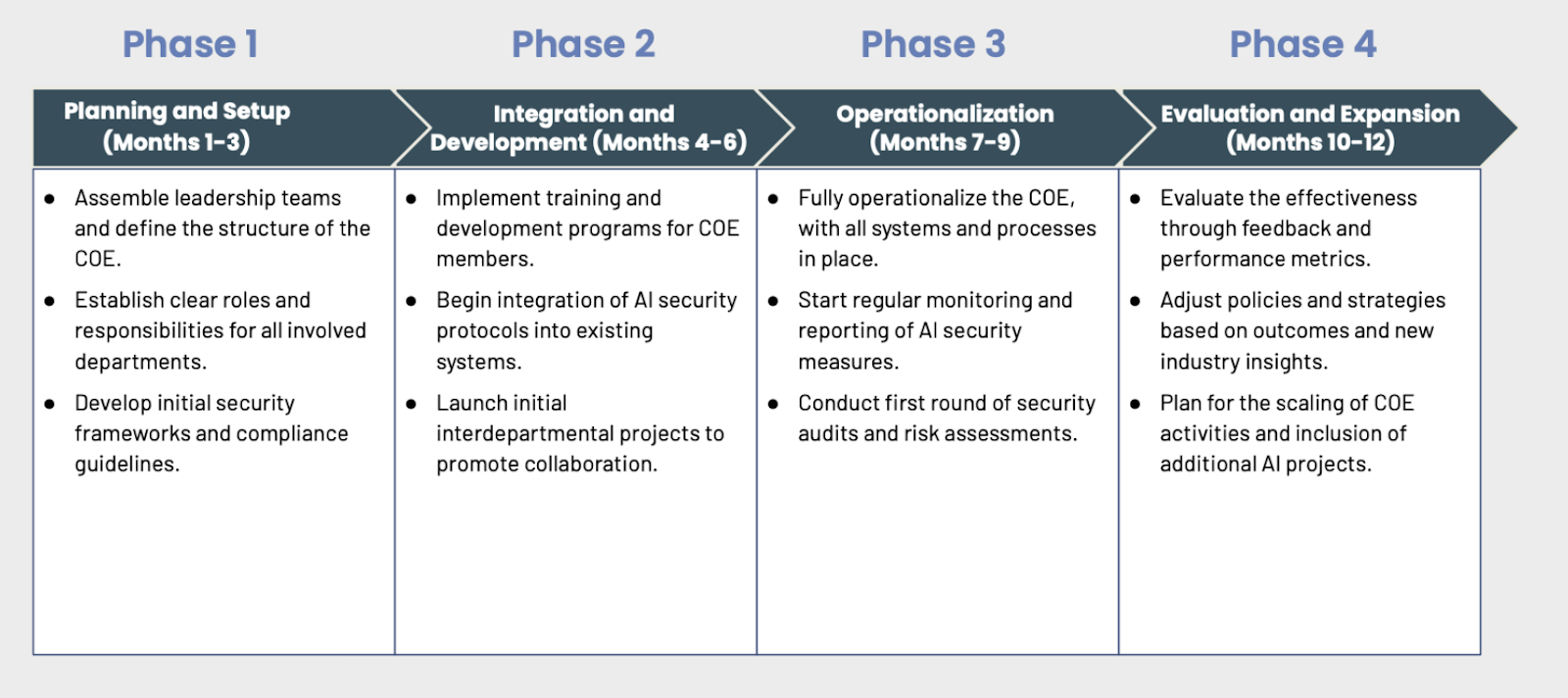

Ниже приведен примерный таймлайн введения best practice и создания центра экспертизы по ИИ:

Отличие от LLM AI Cybersecurity & Governance Checklist: предыдущих документ фокусируется на списке рисков более простым языком для нетехнических читателей, а Center of Excellence Guide посвящен выстраиванию практик безопасности вокруг GenAI в компании. Для технического читателя справедливо может показаться, что в документах много воды, да и я сам постоянно их путаю.

AI Exchange и сторонние проекты OWASP

Мы разобрали флагманские проекты и рабочие группы по GenAI внутри OWASP. Но коммьюнити — активное и существуют и другие проекты, в том числе неофициальные. Тем не менее, вы их можете встретить на просторах интернета. Начнём с AI Exchange.

Что это:

-

200+ страниц чеклистов, матриц угроз и примеров атак на ИИ системы;

-

Инструменты: «Периодическая таблица рисков ИИ», гайды по тестированию;

-

Актуальность: обновляется ежеквартально.

-

Не только для генеративных ИИ систем, охватывает атаки на классические ML-модели.

-

Содержит проект OWASP AI Security & Privacy Guide.

Первоначально проект выполнял роль единого лендинга: там были ссылки на уже знакомый вам Top-10 LLM, top-10 ML, внутри — много красивых ссылок и диаграмм. Главное отличие от других стримов OWASP в том, что это другая рабочая группа проекта. Команда проекта имеет пересечения с Top-10 for LLM Applications, но лидирует проект Роб ван дер Вир. Дорожная карта флагманского проекта и AI Exchange пока не согласованы.

Одна из главных целей AI Exchange проекта — влияние на внешние, как правило, европейские стандарты и регуляции (EU AI Act, ISO/IEC 27090 и т.д.). Оценить популярность AI Exchange сейчас сложно, но по охвату он точно уступает основному проекту Top-10.

В дополнение к объёмному материалу этой вики шёл небольшой документ OWASP AI Security & Privacy Guide project, который кратко описывает следующие проблемы ИИ-систем:

-

Fairness (справедливость): борьба с предвзятостью в моделях.

-

Data Minimization: сбор и хранение только необходимых данных.

-

Transparency и Explainability: прозрачность работы AI и возможность оспаривать решения моделей.

Часть периодической таблицы рисков ИИ из https://owaspai.org/docs/ai_security_overview/

|

Актив и влияние |

Категория угрозы/риска |

Контроли |

|---|---|---|

|

Целостность поведения модели |

Прямая инъекция промпта |

Ограничение нежелательного поведения, Валидация ввода, дополнительные меры в самой модели. |

|

Целостность поведения модели |

Косвенная инъекция промпта |

Ограничение нежелательного поведения, валидация ввода, сегрегация ввода. |

|

Целостность поведения модели |

Отравление модели во время выполнения |

Ограничение нежелательного поведения, целостность развернутой модели, целостность ввода/вывода во время выполнения. |

|

Конфиденциальность данных обучения |

Утечка данных через вывод модели |

Ограничение работы с чувствительными данными (минимизация, короткое хранение, обфускация данных обучения), мониторинг, ограничение частоты, контроль доступа к модели, фильтрация вывода. |

|

Конфиденциальность данных обучения |

Инверсия модели / Определение принадлежности |

Ограничение работы с чувствительными данными (минимизация, короткое хранение, обфускация данных обучения), мониторинг, ограничение частоты, контроль доступа, сокрытие уверенности, маленькая модель. |

|

Доступность поведения модели |

Отказ в обслуживании модели (исчерпание ресурсов) |

Мониторинг, ограничение частоты, контроль доступа, проверка входных данных на DoS, ограничение ресурсов. |

ML Top 10 — незавершенная инициатива

Проект OWASP Machine Learning Security Top-10 нацелен на обобщение десяти наиболее критичных проблем безопасности в ML-системах.

Что это:

-

Проект по созданию аналога LLM Top-10 для машинного обучения (ML).

-

Предполагалось описать такие уязвимости, как Model Inversion Attack и Membership Inference Attack.

-

Текущее состояние: релиз так и не вышел(и видимо не был согласован с core team OWASP), работа остановилась в 2023 году.

LLM Security Verification Standard (версия 0.0.1)

Ссылка https://github.com/OWASP/www-project-llm-verification-standard

Что это:

-

Стандарт-чеклист, призванный помочь проектировать и тестировать приложения на базе LLM.

-

Фокусируется на архитектуре, жизненном цикле модели, интеграции, мониторинге и обнаружении аномалий. Разделяет рекомендации по типу компании: стартапы, компании среднего размера и крупные корпорации.

-

В релиз так и не вышел, в феврале 2024 года была опубликована версия 0.0.1.

-

Насколько понимаю, проект пытались запустить контрибьюторы при поддержке Snyk и Lakera, но не довели до конца. Используйте рекомендации по LLM Sec Ops из AI Security Solutions Landscape.

Выводы

Мы всё еще живем в реальности, когда новые атаки выходят каждый месяц и вряд-ли в ближайшее время работа разных рабочих групп OWASP будет консолидироваться в единый документ. Тем не менее, среди прикладных разработчиков гайды пользуются популярностью и многие технические доклады и продукты вендоров AI Security продолжают опираться на классификацию угроз OWASP наравне с NIST, MITRE.

Несколько рекомендаций для тех, кто начинает погружение в безопасность ИИ-систем:

-

LLM Top 10 — ключевой документ для тех, кто хочет начать разбираться в основных угрозах LLM. AI Security Solutions Landscape будет полезен, если вы хотите посмотреть, какие решения уже есть на рынке сейчас.

-

Если вас, как и меня, интересуют агентные системы, стоит присмотреться к Agentic Initiative.

-

Сам я AI Exchange практически не пользуюсь, но если вы нашли применение в работе именно этой вики по безопасности ИИ, пожалуйста, не стесняйтесь сказать в комментариях, на что полезное стоит обратить внимание.

Для вашей организации, вам, скорее всего, придётся составить собственную модель угроз и оценить риски для конкретных ИИ-систем индивидуально, но надеюсь, данная статья была вам полезна и вы сможете переиспользовать наработки проектов OWASP.

Автор: artmaro