Всем привет! Сегодня мы выпустили новую версию нашей большой языковой модели Cotype – Cotype Pro 2, с улучшенными возможностями генерации и редактирования текстов, а также суммаризации и анализа информации. Однако в этой статье мы дадим лишь краткое представление нашего нового творения и его преимуществ, а больше расскажем о том, как мы улучшили пайплайн обучения нашей LLM с помощью новой методологии оценки.

Эта методология была разработана в рамках исследования, посвященного сравнению моделей методом Side-by-Side для автоматической оценки LLM. Мы выкладываем в открытый доступ код для её воспроизведения и лидерборд на HuggingFace для сравнения как коммерческих, так и открытых моделей.

Краткое представление Cotype Pro 2

Сперва – про нашу новую модель.

Cotype Pro 2 – обновленная версия нашей LLM для бизнеса Cotype Pro, заточенной для работы с корпоративными данными. Она содержит 32 млрд параметров и имеет контекстное окно на 128 тыс. токенов (но можно установить меньший объем контекста при ограниченных ресурсах). Модель скромна в требованиях по вычислительным мощностям, что не мешает ей работать с эффективностью, сравнимой с более крупными моделями.

Мы рассчитываем, что Cotype Pro 2 станет основой для семейства корпоративных решений для госсектора, банков, промышленности, ритейла, телекома и IT – сначала в формате ИИ-помощников, а потом и ИИ-агентов.

В бенчмарке MERA Cotype Pro 2 имеет высокие показатели по всем основным направлениям:

-

reasoning;

-

знания о мире и предметные тесты;

-

математика и логика;

-

работа с кодом и алгоритмами;

-

нравственные и этические дилеммы.

Мы значительно улучшили качество работы модели на русском языке: устранили проблемы с непроизвольным переключением на английский язык и смешанное использование языков, а также добились более точного следования промптам и на 40% повысили скорость генерации при запуске на том же железе.

Мы провели большую работу по очистке данных, что значительно улучшило качество нашего обучающего корпуса (о нем мы рассказывали тут). Для Cotype Pro 2 мы тщательнее очистили датасеты. В них часто встречалось смешение языков внутри слов и предложений — подобные инструкции мы либо удалили, либо улучшили с помощью специальной орфографической модели. Эта модель способна эффективно исправлять ошибки, устранять языковое смешение, подбирать наиболее подходящие слова и заменять их релевантными синонимами.

Мы инициализировали нашу модель весами Qwen-2.5-32B-instruct, а после провели обучение в четыре этапа:

-

SFT обучение на новом корпусе,

-

DPO обучение на наших преференс-данных,

-

патчинг токенизатора,

-

квантизация.

У моделей семейства Qwen-2.5 присутствует проблема смешивания языков при инференсе, в частности, переход на китайский язык посреди ответа. Для этого мы патчим нашу модель – модифицируем токенизатор и соответствующие веса таким образом, чтобы минимизировать шанс генерации иероглифов при генерации ответа на другом языке. Для квантизации мы использовали метод GPTQ.

В пайплайн обучения Cotype Pro 2 также включена новая методология оценки качества ответов модели, которую мы разработали в результате исследования подходов к сравнению моделей методом Side-by-Side. О ней подробнее.

Оценка Side-by-Side

Как правило, подходы к оценке работы LLM можно разделить на контролируемые и неконтролируемые (с «правильными» ответами и без).

Контролируемая (supervised) оценка заключается в сравнении генераций модели с заранее определёнными правильными ответами. Такой метод подходит для задач типа «вопрос-ответ» или краткой классификации. Однако для диалоговых моделей, где важна не только точность, но и стилистика, креативность и безопасность, провести объективную оценку сложнее.

Здесь на помощь приходит метод Side-by-Side (SbS). В нем два ответа – от бейзлайна и от модели-кандидата – одновременно представляются независимому судье. Так можно сравнительно оценить качество ответов, минимизируя субъективность и улучшая воспроизводимость результатов.

Проводить оценки методом Side-by-Side можно вручную (судья – человек) и автоматизировано (судья – другая языковая модель). Однако ни ручное, ни автоматизированное SbS-оценивание не лишены недостатков – например, в обоих случаях существует проблема позиционного сдвига (position bias), когда порядок ответов влияет на решение.

Мы решили проанализировать SbS методику в двух вариациях: где в качестве судьи выступают люди, и где в качестве судей используются языковые модели. Мы сравнили работу различных LLM-судей при оценке генераций на нашем русскоязычном бенчмарке, и придумали, как повысить корреляцию с ручной оценкой и уменьшить влияние позиционного сдвига.

Сбор данных

Мы вручную собрали датасеты для двух сетапов под наши эксперименты: для оценки на русском и для генерации кода.

Для первого сетапа был собран датасет из 2396 инструкций, учитывающий особенности русской культуры и паттерны, типичные для запросов российских пользователей. Инструкции охватывают следующие задачи:

-

вопрос-ответ,

-

извлечение информации,

-

суммаризация,

-

классификация,

-

творческое письмо,

-

брейншторминг,

-

чат-вопросы.

Мы стремились сохранить баланс классов, а для задач, требующих фактической точности, дополнительно собирали фактологические справки для проверки.

Мы также вручную собрали набор данных из 800 инструкций с различными задачами по программированию для сравнения генераций. Задачи в наборе данных разделены на пять категорий: написание докстрингов, создание юнит тестов, преобразование текста в код, рефакторинг и объяснение фрагмента кода.

Наш подход к Side-by-Side

В оценке Side-by-Side независимые судьи — как люди, так и LLM-оценщики — сравнивают ответы двух моделей, при этом истинные названия моделей скрываются, чтобы исключить предвзятость.

В отличие от привычного для данного подхода бинарного выбора (A – один из ответов лучше, или B – другой), мы расширили градацию оценки, добавив категории С (оба ответа хороши) и D (оба ответа плохи).

В ручной оценке эксперты сравнивают ответы по следующему ряду критериев: безопасность, этичность, достоверность, релевантность, полнота и стиль. Если мнения экспертов расходятся, то постфактум проводится обсуждение с вынесением итогового вердикта.

Оценка с помощью LLM проводится следующим образом:

-

Передаем в LLM-кандидат и в LLM-бейзлайн промпт с описанием задачи.

-

Просим модель-оценщика сравнить генерации двух моделей в прямом и обратном порядке (т.е. оценка проводится два раза, что в дальнейшем помогает нам оценить влияние позиционного сдвига на модель-оценщика) и вернуть один из четырех символов:

-

(A) Ответ модели-кандидата лучше.

-

(B) Ответ модели-бейзлайна лучше.

-

(C) Ответы обеих моделей одинаково хороши.

-

(D) Ответы обеих моделей одинаково плохи.

-

Для постановки задачи для LLM-оценщика мы использовали несколько вариантов промптов:

-

V.1. Краткая постановка задачи без подробного описания критериев.

-

V.2. Расширенная инструкция, подробно описывающая все требования к ответам.

-

V.2-reason/-fact. Промпты с дополнительными модификациями: “reasoning” (побуждение к размышлению перед принятием решения) и “фактология” (использование фактологической информации при сравнении ответов).

Мы также попробовали использовать многоагентные системы для вынесения вердиктов:

-

Soft метод, в которой один агент выражает мнение, а второй соглашается или не соглашается с ним, после чего финальное решение принимает судья.

-

Hard метод, где второй агент всегда контраргументирует первому, и итоговый вердикт основывается на противоречивых оценках.

Эксперименты

В экспериментах в качестве модели-кандидата мы использовали собственный тюн Qwen2.5-32B-Instruct, а в качестве бейзлайна – GPT-4o. Основной упор делался на сравнение результатов ручной экспертизы с автоматизированными оценками.

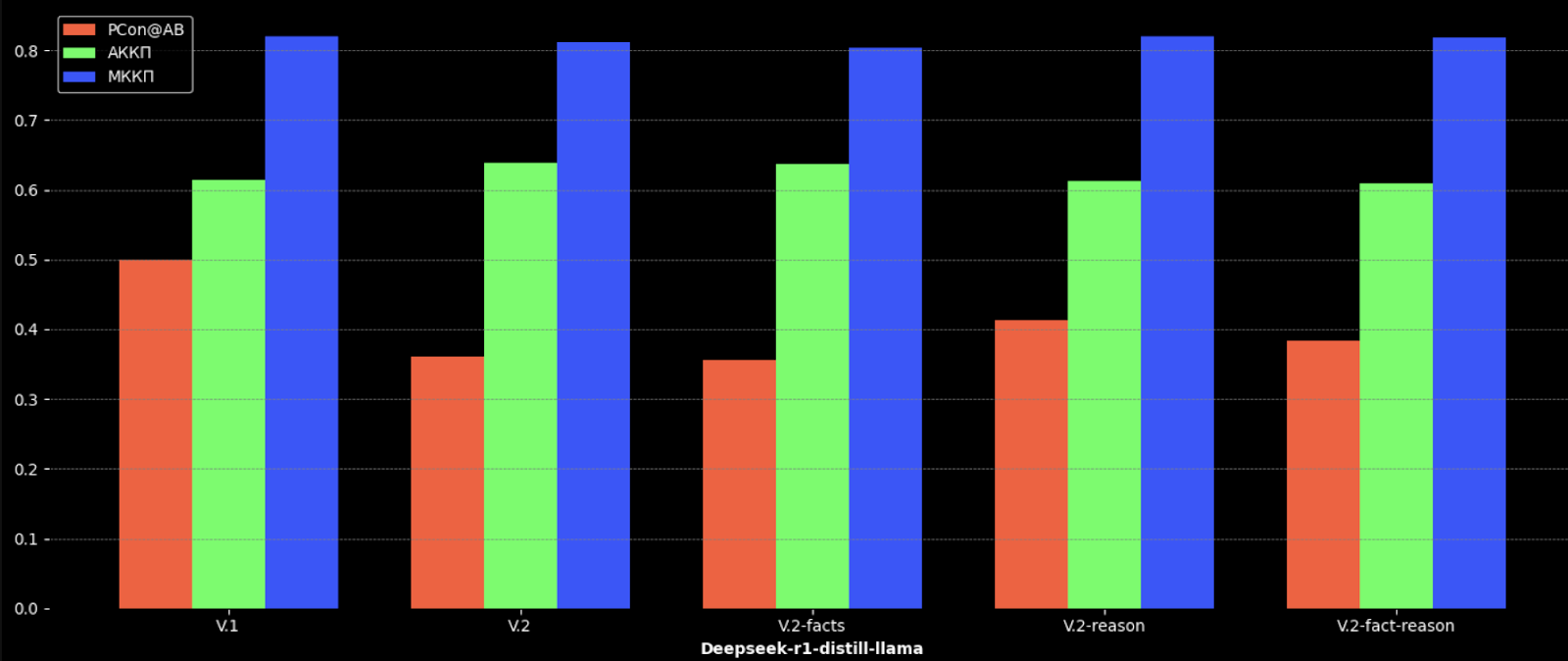

В Графике 1 приводятся значения метрик для ряда известных LLM.

![График 1. Значения метрик для различных LLM. Значения АККП и МККП были нормированы в интервал [0,1]. График 1. Значения метрик для различных LLM. Значения АККП и МККП были нормированы в интервал [0,1].](https://www.braintools.ru/images/2025/04/01/kak-my-uchim-LLM-ocenivat-drug-druga-i-kak-eto-pomoglo-nam-uluchshit-Cotype-2.png)

В качестве LLM-оценщиков мы попробовали модели семейств Llama*, OpenAI, Claude и DeepSeek, а также несколько отечественных. С помощью этих моделей мы провели SbS-оценку, сравнивая ответы модели-кандидата и модели-бейзлайна, и посчитали агрегированный коэффициент корреляции Пирсона (АККП) и медианный коэффициент корреляции Пирсона (МККП). Эти метрики показывают корреляцию суждений LLM с ручной оценкой.

Для АККП мы подсчитываем, сколько вердиктов попадает в каждую категорию (A/B/C/D), и вычисляем корреляцию между оценками экспертов и LLM-as-judges на основе этих четырех значений. При расчете АККП мы теряем много информации о конкретных вердиктах, но можем оценить, насколько близко модель подходит к экспертизе человека при вынесении итогового решения для всего бенчмарка.

Для МККП мы применяем скользящее окно размером 10 с шагом 5 ко всем вердиктам из бенчмарка. Для каждой пачки мы вычисляем медиану по формуле:

Получаем набор медиан для вердиктов экспертов и модели и вычисляем коэффициент корреляции Пирсона между ними. Этот метод сохраняет практически всю информацию для всех вердиктов, но налагает линейную зависимость между классами вердиктов, что может быть не совсем корректно.

Мы также вводим метрику PCon@AB, величина которой показывает устойчивость модели к позиционному сдвигу – чем выше значение, тем лучше. По сути это доля совпадающих ответов среди ответов A и B для ответов, полученных при оценке с прямым и обратным порядком. Эта метрика не зависит от ручной оценки.

Исходя из значений МККП и АККП в Таблице 1 мы можем сделать вывод, что наиболее близки к человеческим суждениям оказываются модели Deepseek-R1 (дистиллированный в LLama-70b) и Claude Opus, при этом Deepseek-R1 является также наиболее устойчивой к позиционному смещению.

Мы протестировали несколько вариантов промптов с двумя моделями LLM в роли судей: Deepseek-r1-distill-llama и Llama3.3-70b. Для Deepseek-r1-distill-llama обновление промптов с версии V.1 на V.2 увеличило корреляцию с ручными суждениями, однако добавление фактической информации и рассуждений снизило корреляцию, поскольку модель уже способна к рассуждениям. Напротив, для Llama3.3-70b добавление фактологической справки улучшило корреляцию с оценками экспертов и повысило устойчивость модели к позиционному смещению.

![Графики 2-3. Значения метрик для моделей судей Deepseek-r1-distill-Llama-70b и Llama3.3-70b с разными промптами. Значения АККП и МККП были нормированы в интервал [0,1]. Графики 2-3. Значения метрик для моделей судей Deepseek-r1-distill-Llama-70b и Llama3.3-70b с разными промптами. Значения АККП и МККП были нормированы в интервал [0,1].](https://www.braintools.ru/images/2025/04/01/kak-my-uchim-LLM-ocenivat-drug-druga-i-kak-eto-pomoglo-nam-uluchshit-Cotype-5.png)

С внедрением более сложных промптов (особенно с добавлением этапа размышления и фактической проверки) корреляция решений автоматизированного оценщика с решениями экспертов существенно возрастала. Например, даже модели с меньшим числом параметров смогли почти сравняться с более крупными моделями за счет применения качественного prompt-engineering.

Мы выявили, что позиционное смещение остаётся актуальной проблемой для большинства моделей, однако модели, приспособленные к рассуждению (например, DeepSeek-R1), таким недостатком не обладают. Мы также показали, что добавление в промпт модели требования рассуждать перед вынесением вердикта может нивелировать влияние позиционного сдвига.

Анализируя мультиагентный подход, мы увидели что hard метод показывает слабую корреляцию с человеческой разметкой, так как другие агенты могут запутать итоговый вердикт. Однако soft метод улучшает корреляцию с экспертными оценками, поскольку второй агент зачастую дополняет логику первого, а агент-судья переоценивает все на основе предыдущих рассуждений. Такие многоагентные дебаты развивают концепцию CoT и могут улучшить качество модели-судьи.

Таким образом мы получили ряд полезных инсайтов при проведении SbS-оценок на русском языке:

-

Тщательная настройка промптов может значительно повысить качество автоматической оценки.

-

Внедрение ризонинга в промпт помогает моделям глубже проанализировать ответ и нивелировать влияние позиционного сдвига.

Модель Claude Opus показала наилучший результат с точки зрения корреляции с ручными оценками, однако её использование оказалось финансово затратным: на генерацию суждений ушло около 100 долларов. Чтобы снизить затраты на процесс автоматической оценки наших моделей, мы сделали выбор в пользу Deepseek-R1-distill-Llama-70b – модель демонстрирует отличное соотношение цены и качества, при этом показывая устойчивость к позиционному смещению.

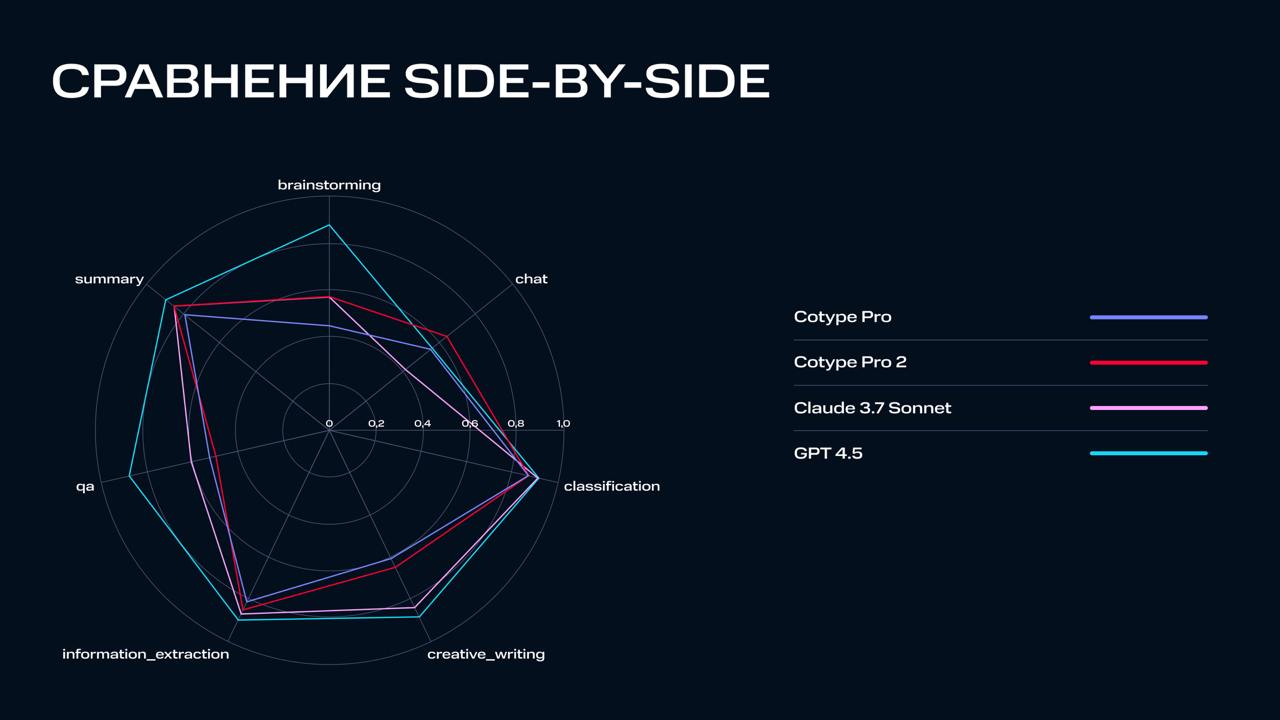

По описанной методологии мы сравнили Cotype Pro 2 с его предыдущей версией и конкурентами. Результат – на Графике 4.

Заключение

Благодаря новому подходу к оценке мы теперь умеем более объективно оценивать наши модели и сравниваться с прошлыми версиями. Мы стали меньше зависеть от ручной разметки и можем быстрее проводить эксперименты, чтобы последовательно улучшать наши LLM и выделять задачи, где качество моделей можно улучшить.

Мы будем продолжать совершенствовать методы оценки и применять их при разработке следующих поколений наших LLM. Мы публикуем лидерборд, на котором можно сравнить ряд моделей по нашей методологии. Там же можно провести оценку своей модели вручную (правда на другом датасете – например, на arena_hard_ru).

*Llama – большая языковая модель (LLM), выпущенная Meta AI, компания Meta признана экстремистской и запрещена в РФ.

Автор: Sitnich