ИИ читает мысли во время просмотра «Теории Большого Взрыва» с помощью фМРТ и ЭЭГ

Сегодня разберем интересную научную работу, которая находится на стыке нейронаук и искусственного интеллекта [1]. Исследователи создали уникальный датасет и модель для декодирования активности мозга [2] человека во время просмотра видео. Давайте посмотрим, как это работает.

Статья: CineBrain: A Large-Scale Multi-Modal Brain Dataset During Naturalistic Audiovisual Narrative Processing [3]

В чем проблема?

Понять, как наш мозг обрабатывает сложную информацию вроде видео со звуком – одна из ключевых задач современной науки. У нас есть два основных инструмента, чтобы “заглянуть” внутрь работающего мозга без хирургического вмешательства:

-

фМРТ (функциональная магнитно-резонансная томография): Этот метод отлично показывает, где именно в мозге возникает активность. У него высокое пространственное разрешение. Но есть минус — он медленный. фМРТ измеряет изменения кровотока, а это косвенный и запаздывающий индикатор работы нейронов. Динамичные сцены он отслеживает с опозданием.

-

ЭЭГ [4] (электроэнцефалография): Этот метод, наоборот, очень быстрый. Он с точностью до миллисекунд показывает, когда происходит активность. Но у него плохое пространственное разрешение, особенно для глубоких структур мозга. ЭЭГ измеряет электрические поля в основном на поверхности коры.

Когда мы смотрим динамичное видео со звуком (например, сериал), наш мозг обрабатывает информацию очень быстро и в разных областях одновременно. Использовать только фМРТ – значит упустить быстрые изменения. Использовать только ЭЭГ – значит не увидеть активность в глубине мозга.

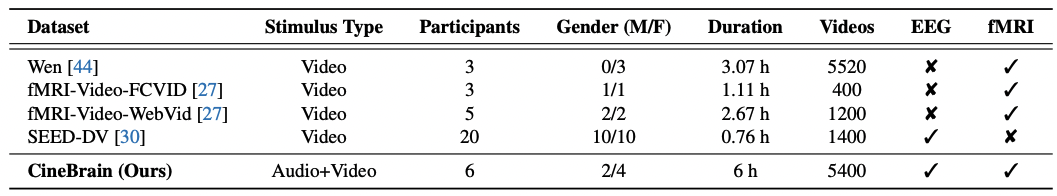

Авторы статьи справедливо указывают на этот пробел: существующие датасеты часто содержат либо только фМРТ, либо только ЭЭГ данные, и/или используют простые стимулы (статичные картинки, отдельные звуки). А можно ли обьединить сильные стороны фМРТ и ЭЭГ, чтобы получить более полную картину и лучше декодировать мозговую активность при просмотре естественного видео?

Цели исследования

Исследователи из Китая поставили перед собой несколько амбициозных целей:

-

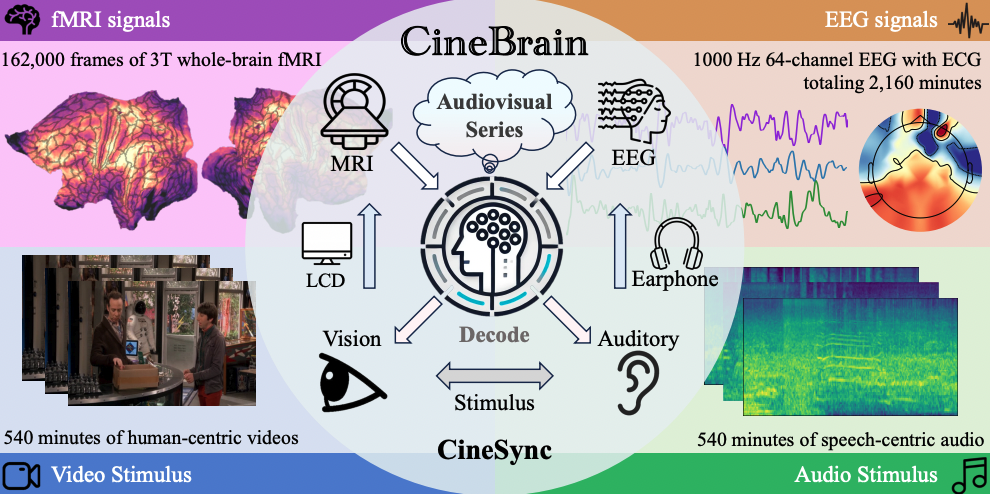

Создать

CineBrain: Первый крупный публичный датасет, где одновременно записаны фМРТ и ЭЭГ сигналы у людей, смотрящих динамичные аудиовизуальные стимулы (в данном случае – эпизоды сериала “Теория Большого Взрыва”). -

Разработать

CineSync: Инновационный фреймворк для мультимодального декодирования. Его задача – эффективно обьединять (фьюзить) данные фМРТ и ЭЭГ, чтобы по ним реконструировать исходные видео и аудио. -

Доказать преимущество: Показать, что обьединение фМРТ и ЭЭГ действительно улучшает качество реконструкции динамических стимулов по сравнению с использованием только одного из методов.

-

Предложить

Cine-Benchmark: Набор метрик и протокол для оценки качества реконструированных видео и аудио, как с точки зрения [5] семантики (смысла), так и восприятия [6] (качества картинки/звука).

По сути, цель – создать уникальный инструмент для решения сложной задачи “чтения мыслей” во время просмотра видео.

Как это делали?

Подход авторов можно разделить на три части: сбор данных, разработка модели декодирования и оценка.

-

Сбор данных (

CineBrain):

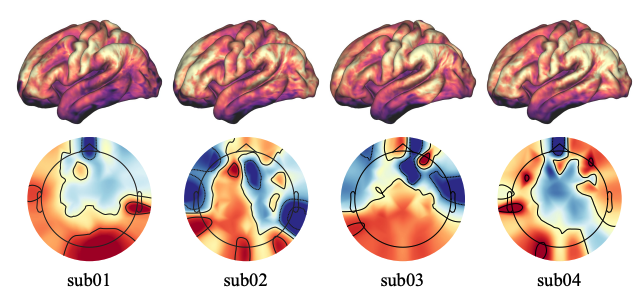

Показаны ответы фМРТ и ЭЭГ участников с 1-го по 4-го на одинаковые стимулы, что иллюстрирует индивидуальные различия в активации мозга -

Участники: 6 здоровых добровольцев.

-

Стимулы: Эпизоды сериала “Теория Большого Взрыва” (примерно 6 часов на каждого). Сериал выбрали из-за динамичного сюжета и способности удерживать внимание [7]. Видео (720p) и аудио подавались одновременно.

-

Запись: Одновременная запись фМРТ (на 3D-сканере, с высоким пространственным разрешением 2мм и временным TR=800мс) и ЭЭГ (64 канала, 1000 Гц). Использовалось специальное МРТ-совместимое оборудование (наушники, ЭЭГ-шапочка). Дополнительно записывали ЭКГ для удаления артефактов.

-

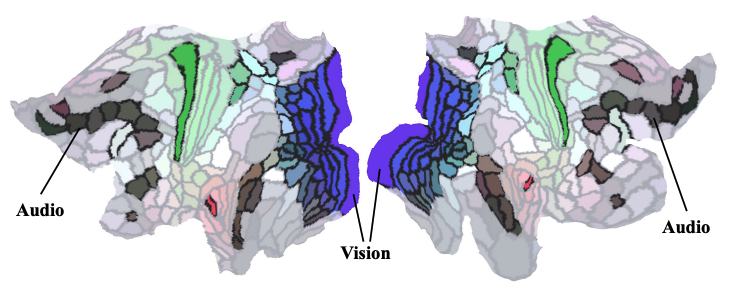

Предобработка: Применялись стандартные пайплайны и специальные методы для очистки ЭЭГ от шумов, вызванных работой МРТ-сканера и физиологическими процессами. Выделили области интереса [8] (ROI) в зрительной и слуховой коре.

Области интереса (ROI) из сигналов фМРТ, использованные в экспериментах -

Дополнительные данные: Для каждого 4-секундного клипа видео и аудио сгенерировали текстовые описания (с помощью VLM типа Qwen2.5, Llava-Video) и транскрипции аудио (с помощью Whisper). Это важные данные для обучения [9] модели.

Каждый участник просмотрел в общей сложности 6 часов сериала, что соответствует примерно 27 000 кадрам фМРТ-данных

-

-

Модель декодирования (

CineSync):-

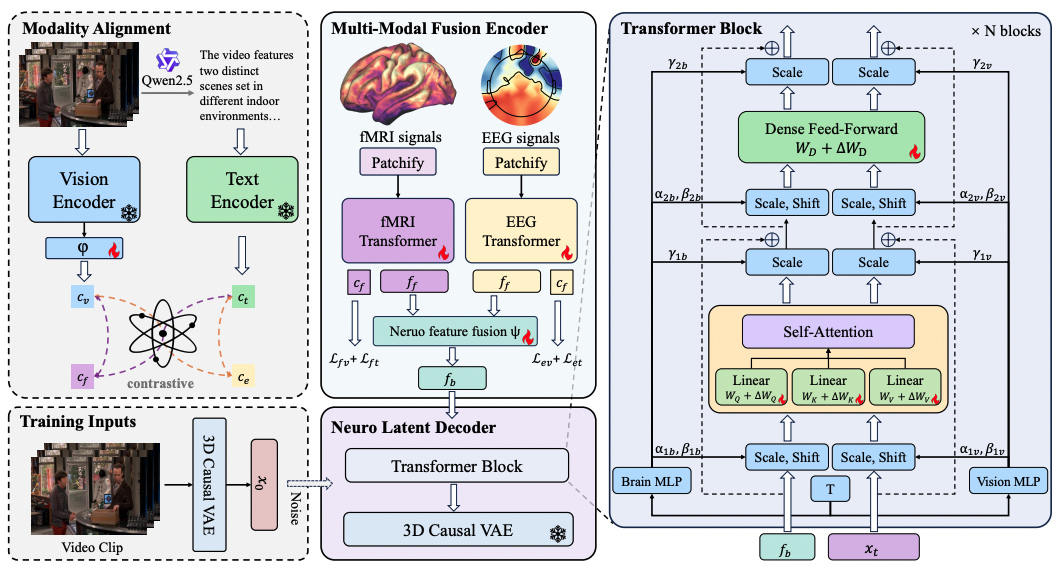

Multi-Modal Fusion Encoder (MFE): Использует два отдельных трансформера (архитектура типа ViT) для кодирования временных последовательностей данных фМРТ и ЭЭГ. -

Применяет контрастное обучение для семантического выравнивания. Идея в том, чтобы эмбеддинги (векторные представления), полученные из фМРТ и ЭЭГ для конкретного видеоклипа, стали похожи на эмбеддинги самого видеоклипа (полученные через предобученный энкодер) и его текстового описания, и одновременно отличались от эмбеддингов других клипов/описаний. Это помогает научить энкодеры извлекать из сигналов мозга именно смысловую информацию.

-

Затем признаки от фМРТ и ЭЭГ обьединяются с помощью небольшой нейросети (MLP) в единое “мозговое” представление.

-

Neuro Latent Decoder (NLD): Использует предобученную диффузионную модель (CogVideoX для видео, F5-TTS для аудио) в качестве генератора. Диффузионные модели сейчас на пике популярности и отлично справляются с генерацией реалистичных изображений и аудио. -

Ключевой момент: вместо обычного текстового промпта, модель управляется обьединенным мозговым представлением, полученным от MFE.

-

Применяется метод LoRA (Low-Rank Adaptation). Она позволяет эффективно дообучить (fine-tuning) только небольшую часть параметров большой диффузионной модели под задачу декодирования мозговых сигналов. Это экономит ресурсы и помогает модели не “забыть” то, что она умела раньше.

-

Расширение на аудио: Тот же подход адаптировали и для реконструкции аудио, используя соответствующую диффузионную модель (F5-TTS) и текстовые транскрипции для контрастного обучения энкодера.

CineSync сначала использует мультимодальный энкодер для извлечения признаков из данных фМРТ и ЭЭГ, а также модуль выравнивания модальностей для согласования этих признаков с семантической информацией. Затем с помощью нейронного латентного декодера происходит реконструкция видеоматериалов на основе объединенных признаков мозговой активности

-

-

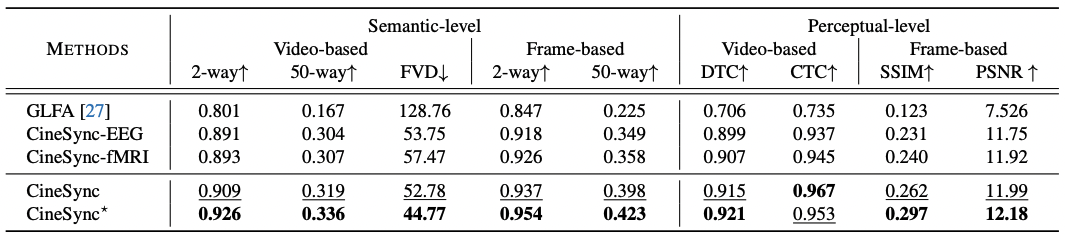

Оценка (Cine-Benchmark): Предложен набор метрик для оценки семантического сходства (насколько реконструированное видео/аудио соответствует оригиналу по смыслу: N-way top-K accuracy, FVD для видео; WER, CER, FAD для аудио) и перцептивного качества (насколько оно хорошо выглядит/звучит: DTC, CTC, SSIM, PSNR для видео; LSD, MCD, SSIM/RMSE на спектрограммах для аудио).

Что получилось?

-

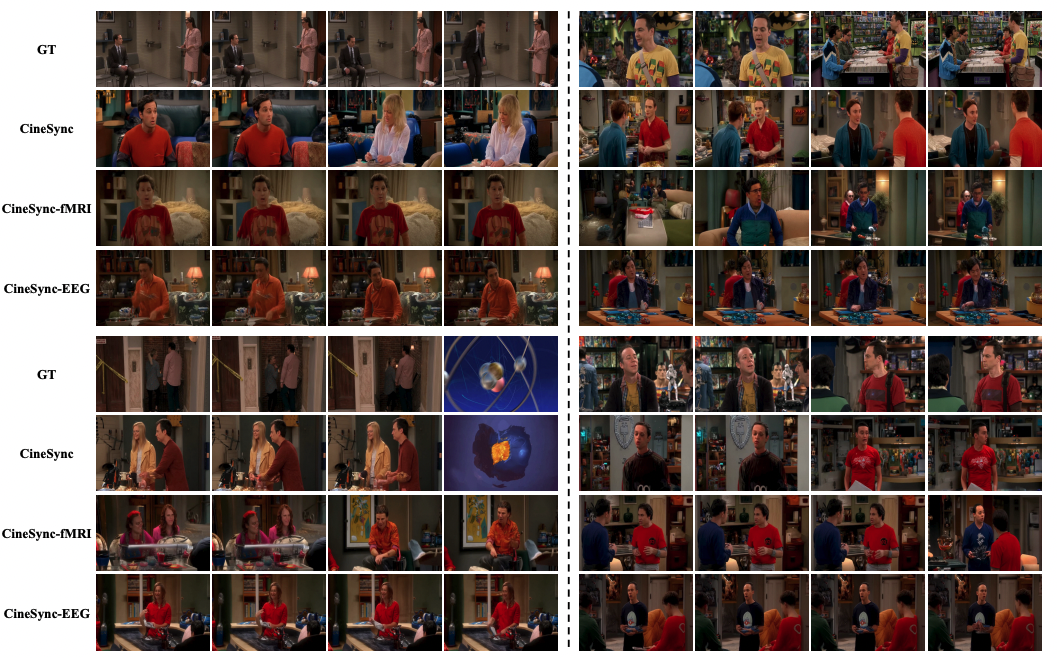

Фьюжн работает: Эксперименты показали, что модель

CineSync, использующая одновременно фМРТ и ЭЭГ, превосходит варианты, использующие только фМРТ или только ЭЭГ. Качество реконструкции видео по большинству метрик выше именно у обьединенной модели. -

State-of-the-Art (SOTA): Предложенный подход

CineSyncдостиг передового уровня качества (SOTA) в задаче реконструкции видео из сигналов мозга на новом датасетеCineBrain. -

Качественные улучшения: Визуальные примеры показывают, что

CineSyncгенерирует видео с лучшей семантической точностью (похоже по смыслу), временной согласованностью и общим визуальным качеством по сравнению с моделями, использующими только одну модальность. -

Реконструкция аудио: Фреймворк принципиально можно использовать и для реконструкции звука.

-

Датасет валиден: Результаты подтверждают, что собранный датасет CineBrain пригоден для сложных задач мультимодального декодирования.

Представлены средние показатели эффективности для всех участников экспериментов

Выводы и перспективы

Эта работа – заметный шаг вперед в визуализации и декодировании работы мозга.

-

Датасет

CineBrain— ценный ресурс для исследователей. Он позволяет изучать, как мозг интегрирует видео и аудио в динамике, искать нейронные корреляты понимания сюжетов, разрабатывать новые методы фьюжна мультимодальных нейронных данных и многое другое. -

Фреймворк

CineSyncпоказывает, что обьединение фМРТ и ЭЭГ перспективно, а использование мощных диффузионных моделей открывает новые горизонты в нейродекодинге. -

Cine-Benchmarkпредлагает стандартный способ оценки, что важно для сравнения будущих работ.

Но 6 участников – это немного для исследований мозга. Выводы могут быть не до конца обобщаемыми на всех людей, так как индивидуальные различия в работе мозга бывают значительными. Также результаты получены на комедийном сериале, насколько хорошо метод сработает для других жанров видео или типов контента – пока вопрос.

Несмотря на SOTA-результаты, абсолютное качество реконструкции сложных динамических сцен из сигналов мозга все еще далеко от идеального просмотра “мыслей” на экране. Прогресс в “чтении мыслей” неизбежно поднимает важные этические вопросы о приватности и возможном неправильном использовании таких технологий. Об этом нужно помнить.

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал [10] – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13736

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] мозга: http://www.braintools.ru/parts-of-the-brain

[3] CineBrain: A Large-Scale Multi-Modal Brain Dataset During Naturalistic Audiovisual Narrative Processing: https://arxiv.org/abs/2503.06940

[4] ЭЭГ: http://www.braintools.ru/methods-for-studying-brain/electroencephalography-eeg

[5] зрения: http://www.braintools.ru/article/6238

[6] восприятия: http://www.braintools.ru/article/7534

[7] внимание: http://www.braintools.ru/article/7595

[8] интереса: http://www.braintools.ru/article/4220

[9] обучения: http://www.braintools.ru/article/5125

[10] подписывайтесь на мой Telegram-канал: https://t.me/+r3TPYcCFRkdkNDZi

[11] Источник: https://habr.com/ru/articles/896094/?utm_source=habrahabr&utm_medium=rss&utm_campaign=896094

Нажмите здесь для печати.