Как подключить AFFiNE к Ollama?

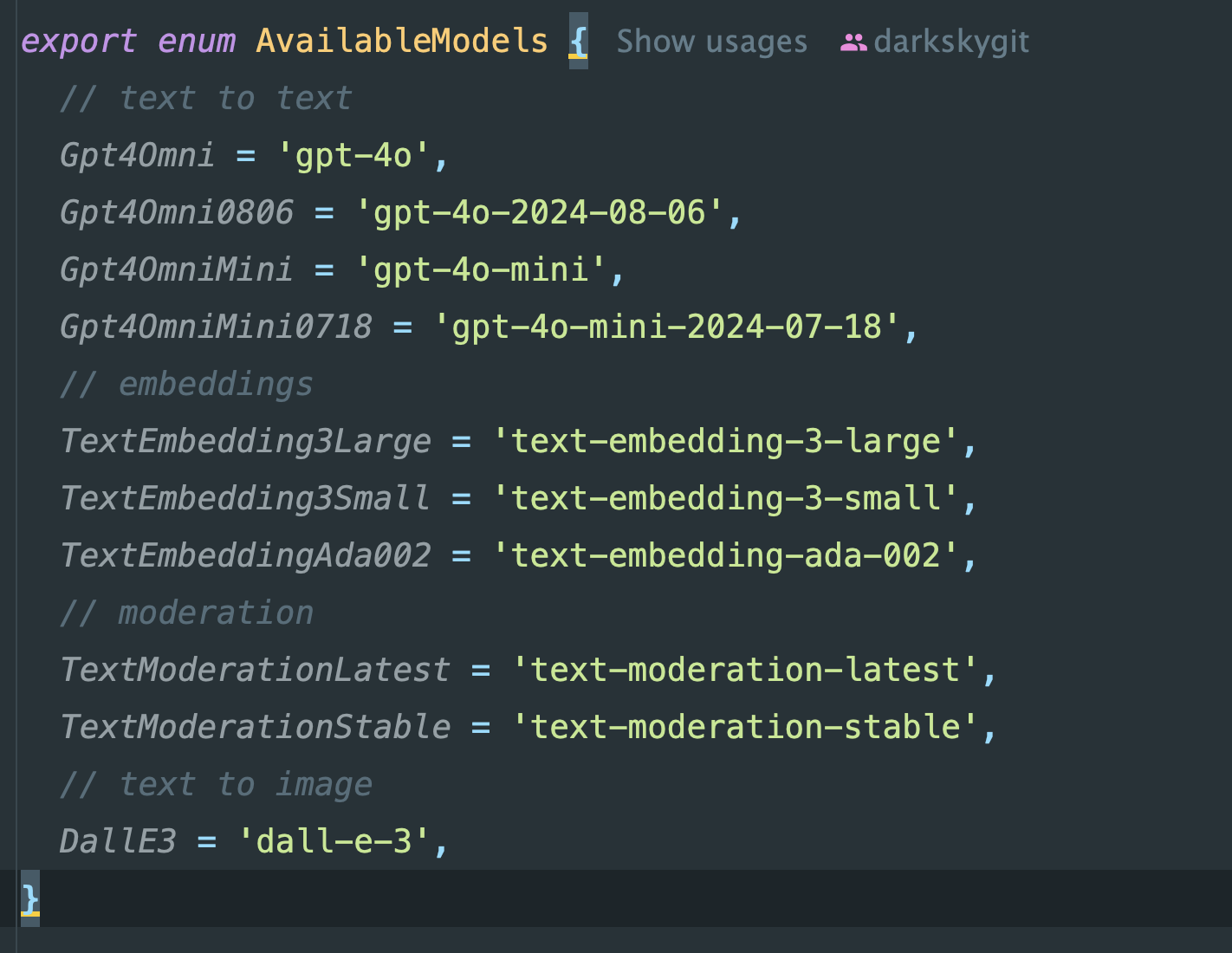

Когда я пытался подключить AFFiNE [1] к Ollama [2] или к DeepSeek [3], я сразу столкнулся с большой проблемой: AFFiNE [1] попросту не умеет работать с моделями, отличными от GPT. Вопрос: почему? Да потому что ребята просто захардкодили названия моделей в коде.

Честности ради, ребята все еще в бете, так что причину отлично понимаю

Покопавшись в коде, я понял, что там попросту никак нельзя конфигурировать что-либо, КРОМЕ URL и API-ключа от OpenAI, так как названия моделей буквально захардкожены.

В итоге я вспомнил, что в LocalAI [4] есть механизм, позволяющий “ренеймить” модели, которые ты установил на свою машину.

name: phi-2

context_size: 2048

f16: true

threads: 11

gpu_layers: 90

mmap: true

parameters:

# Reference any HF model or a local file here

model: huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf

temperature: 0.2

top_k: 40

top_p: 0.95

template:

chat: &template |

Instruct: {{.Input}}

Output:

# Modify the prompt template here ^^^ as per your requirements

completion: *templateУказав название, можно переименовать модель, что могло бы упростить работу.

Однако LocalAI [4] мне лично совсем не нравится (он попросту сложнее), хотя я не исключаю варианта, что со временем буду переезжать на него вместо Ollama [2] из-за возможностей работать не только с LLM, а с множеством разных видов нейронов.

Так что я пошел копаться в сторону похожего функционала в Ollama [2], однако там ничего подобного не оказалось. Но я увидел механизм copy.

Я решил: а вдруг подойдут? Но, конечно, боялся дублировать модели по 30 гигабайт на диске. Но что поделать, попробовал сделать дубликат модели DeepSeek-r1:32b и назвать его gpt-4o.

docker exec -it service-ollama-backend ollama cp deepseek-r1:32b gpt-4oИИИИ — да, это сработало.

Проблема только одна: AFFiNE [1] всё еще не умеет работать с “мыслящими” моделями, поэтому он попросту вставлял мысли модели посреди текста :D.

P.S. У меня, кстати, в Telegram-канале [5] сейчас идет розыгрыш моего старого Intel NUC на 32 ГБ памяти [6], на котором я раньше запускал первые домашние модели через Ollama [2], так что буду рад подписке :-)

Автор: ZergsLaw

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13645

URLs in this post:

[1] AFFiNE: https://affine.pro/

[2] Ollama: https://ollama.com/

[3] DeepSeek: https://www.deepseek.com/

[4] LocalAI: https://localai.io/

[5] Telegram-канале: https://t.me/+Oa9kty7CxdNmOTli

[6] памяти: http://www.braintools.ru/article/4140

[7] Источник: https://habr.com/ru/articles/895222/?utm_source=habrahabr&utm_medium=rss&utm_campaign=895222

Нажмите здесь для печати.