Это перевод свежей статьи от 12 февраля 2025 года об Automated Capability Discovery (ACD) — автоматическом обнаружении возможностей и ограничений больших языковых моделей (LLM), таких как GPT, Claude и Llama. Идея в следующем: использовать одну модель (“учёный”) для генерации задач, которые затем решает другая модель (“испытуемый”). Это позволяет автоматически и систематически выявлять как сильные стороны модели, так и её слабости, которые могут быть неочевидными при использовании традиционных методов оценки.

Automated Capability Discovery via Foundation Model Self-Exploration

Cong Lu (University of British Columbia), Shengran Hu (Vector Institute), Jeff Clune (Canada CIFAR AI Chair)

Автоматическое обнаружение возможностей через самоисследование базовых моделей

Аннотация

Базовые модели (Foundation Models, FM) стали нашими универсальными помощниками, демонстрируя разнообразные возможности в многочисленных областях благодаря обучению на огромных массивах интернет-данных. Однако, остаётся непростой задачей точно охарактеризовать даже часть полного спектра возможностей и потенциальных рисков любой новой модели. Существующие подходы к оценке часто требуют значительных человеческих усилий, и с каждым разом становится труднее разрабатывать всё более сложные задачи для более мощных моделей.

Мы хотим представить вам Автоматическое обнаружение возможностей (Automated Capability Discovery, ACD) — фреймворк, который назначает одну базовую модель в роли “учёного” для систематической генерации задач, исследующих способности модели-“испытуемого” (которая может быть той же самой моделью). Комбинируя передовые модели с идеями из области открытости (open-endedness), ACD автоматически и систематически выявляет как удивительные возможности, так и ошибки модели-испытуемого. Мы демонстрируем работу ACD на ряде базовых моделей (включая GPT, Claude и Llama), показывая, как этот фреймворк автоматически раскрывает тысячи возможностей, которые было бы сложно обнаружить одной команде людей. Мы также проверяем автоматическую оценку нашего метода с помощью масштабных опросов людей, наблюдая высокую согласованность между оценками, сгенерированными моделью, и человеческими оценками. Используя способность базовых моделей как создавать задачи, так и оценивать себя, ACD представляет собой значительный шаг к масштабируемой, автоматизированной оценке новых систем AI. Весь код и журналы оценок открыты и доступны по адресу: https://github.com/conglu1997/ACD.

1. Введение

Большие языковые модели (Large Language Models, LLMs) [Gemini Team, 2024; Ope- nAI, 2024b; Touvron et al., 2023], обученные на масштабных интернет-данных, произвели революцию в обработке естественного языка, демонстрируя мощные универсальные возможности. Эти “базовые модели” (Foundation Models, FMs) [Bommasani et al., 2021] показывают исключительную производительность в задачах, требующих здравого смысла [Talmor et al., 2019], логического мышления [Wei et al., 2022] и понимания [Chang et al., 2024], что позволяет применять их в различных областях, от диалоговых агентов [Brown et al., 2020] до генерации кода [Gauthier, 2024]. Недавно агентные системы, основанные на базовых моделях, даже продемонстрировали способность предлагать и исследовать новые научные идеи [Lu et al., 2024c] и создавать всё более совершенные агентные системы [Hu et al., 2024]. Однако выявление неизвестных способностей или режимов сбоев в базовых моделях остаётся серьёзной проблемой, поскольку такие знания имеют решающее значение для обеспечения безопасного развёртывания и максимизации практической пользы.

Традиционные методы оценки, основанные на созданных человеком бенчмарках [BIG-bench authors, 2023; Chen et al., 2021a; Cobbe et al., 2021; Dua et al., 2019; Hendrycks et al., 2021a;b; Phan et al., 2025; Zellers et al., 2019], требуют значительных усилий для разработки и ограничены предопределёнными категориями, часто не охватывая весь спектр возможностей модели или не выявляя удивительные образцы неизвестного поведения. По мере того, как модели становятся более продвинутыми, они могут переобучаться на этих бенчмарках, поэтому такие метрики могут не отражать более широкие улучшения производительности. Пользователи также часто сталкиваются с уникальными случаями использования и режимами сбоев, которые не охватываются бенчмарками. Хотя регулярное обновление или создание новых тестовых наборов [Phan et al., 2025; White et al., 2024] – это попытки решить указанные проблемы, постоянное создание новых задач является дорогостоящим, не специфичным для модели и не позволяет исследовать “неизвестные неизвестные” (то, что создатели бенчмарков не подумали включить). Это подчеркивает необходимость масштабируемых, эффективных методов оценки, которые были бы дешёвыми и требовали минимальных затрат для того, чтобы успевать за быстро развивающимися базовыми моделями [Bowman et al., 2022].

Мы представляем Автоматизированное обнаружение возможностей (ACD), фреймворк, который дополняет существующие подходы к оценке, автоматизируя обнаружение возможностей и режимов сбоев базовой модели. Он назначает одну модель в роли “учёного” для систематического предложения открытых задач для модели-“испытуемого“, которая может быть той же самой или другой базовой моделью (Раздел 4).

ACD инструктирует учёного предлагать интересные новые задачи [Faldor et al., 2024; Lu et al., 2024c; Pourcel et al., 2024b; Shah et al., 2024a; Zhang et al., 2024a;b], просит испытуемого попытаться их выполнить и оценивает производительность (Zheng et al., 2023) — и всё это автоматически. Как и люди, исследуя новую модель, могут пробовать всевозможные задачи, от своих любимых “подвохов” для модели до новых сложных задач, но в случае ACD модель берёт на себя роль оценщика. Убрав ручное создание задач из процесса, ACD может автоматически и относительно недорого выявить широкий спектр сильных и слабых сторон модели-испытуемого.

Перевод оценок на рисунке 1

Человек: 9.11 и 9.9 — какое число больше?

Модель: 9.11 больше, чем 9.9.

Человек: ?!?

Неправильный результат арифметической последовательности

Задача:

Вам дана последовательность арифметических операций. Начните с исходного значения и примените операции по порядку, чтобы найти итоговое значение.

Исходное значение: 5

Последовательность операций:

-

{‘operation’: ‘add’, ‘operand’: 3} (прибавить 3)

-

{‘operation’: ‘multiply’, ‘operand’: 2} (умножить на 2)

-

{‘operation’: ‘subtract’, ‘operand’: 4} (вычесть 4)

Ответ GPT-4o: 10

Неправильное продолжение визуального паттерна

Задача:

Определите или продолжите визуальный паттерн на основе данного описания. Вот паттерн: #-##–###—.

Требуется:

-

Определите следующие три символа в последовательности.

-

Предоставьте ответ в виде продолжения последовательности в том же формате.

Ответ GPT-4o: —-####

Решение варианта загадки Эйнштейна

Задача:

Решите следующую логическую головоломку, используя предоставленные подсказки, чтобы определить ответы на вопросы.

Подсказки:

-

Пять людей разных национальностей живут в ряду из пяти домов, каждый дом окрашен в разный цвет.

-

У каждого человека разное домашнее животное, предпочитаемый напиток и марка сигарет.

… -

Норвежец живет рядом с синим домом.

-

Человек, который курит Blends, имеет соседа, который пьет воду.

Вопросы:

Кто пьет воду? У кого живет рыбка?

Ответ GPT-4o:

Вода: Норвежец. Рыбка: Немец ✓

Мы демонстрируем ACD на нескольких базовых моделях, включая GPT-4 (OpenAI, 2024), Claude Sonnet 3.5 (Anthropic, 2024) и Llama3-8B (Llama Team, 2024) (Раздел 5). Мы показываем, что ACD выявляет множество возможностей, начиная от элементарных арифметических задач до сложных головоломок, в результате чего автоматически исследуется решение тысяч задач. Многие задачи иллюстрируют полезные возможности модели, такие как многошаговые рассуждения и структурированные рабочие процессы, тогда как другие выявляют удивительные примеры сбоев, которые кажутся тривиальными для людей (Рисунок 1). Мы приводим многочисленные примеры в наших оценках, охватывающие криптографию, генерацию кода, логику, основанную на памяти, продвинутую математику, юридические запросы, создание головоломок и творческое письмо (Приложение E.3). Чтобы проверить автоматическую генерацию задач и оценку ACD, мы проводим масштабные человеческие опросы по задачам, обнаруженным GPT-4, показывая высокие показатели валидности задач и согласованность между самооценкой модели и человеческими суждениями (Раздел 5.1). Кроме того, ACD автоматически составляет краткий “Отчёт о возможностях”, в котором перечислены обнаруженные возможности и режимы сбоев (Раздел 6), что позволяет быстро анализировать результаты и упрощает распространение результатов или выявление проблем перед развёртыванием (Раздел 7).

Используя способность базовых моделей к самооценке, ACD позволяет перейти к масштабируемой, автоматизированной оценке этих моделей. Это может помочь систематически выявлять возникающие и потенциально опасные элементы поведения перед развёртыванием в реальном мире. По мере того как базовые модели продолжают развиваться, такие методы, как ACD, будут иметь решающее значение для согласования их развития с человеческими ценностями и обеспечения ответственного использования, выявляя как полезные, так и рискованные поведения перед развёртыванием в реальном мире. Наконец, ACD может позволить моделям генерировать интересные задачи для собственного обучения, потенциально способствуя самоулучшению в будущем (Clune, 2019; Faldor et al., 2024).

2. Предыстория

2.1 Алгоритмы открытого обнаружения (Open-ended Discovery Algorithms)

Алгоритмы открытого обнаружения (Stanley & Lehman, 2015; Stanley et al., 2017) направлены на непрерывное создание новых и разнообразных артефактов в пространстве поиска, вместо того чтобы фокусироваться на фиксированной цели. Эти алгоритмы имитируют человеческое творчество, автономно исследуя новые артефакты, всё больше поддерживаемые крупными базовыми моделями, которые могут кодировать внутренние представления об “интересности” (Faldor et al., 2024; Lu et al.; Zhang et al.). Они применялись для эволюции новых морфологий роботов в коде (Lehman et al., 2022), создания новых сред для обучения с подкреплением (Faldor et al., 2024; Wang et al., 2019; Wang et al., 2020), обнаружения новых функций потерь (Lu et al.) и агентных систем (Hu et al., 2024), а также для исследования научных гипотез (Lu et al.).

Обычно эти алгоритмы поддерживают и обновляют архив обнаруженных артефактов. На каждой итерации t они выбирают новый артефакт

из базовой модели

, учитывая подмножество

ранее обнаруженных артефактов, обычно ограниченное по размеру для вычислительной реализуемости. Сгенерированный артефакт

оценивается на новизну (например, через сходство на основе встраиваний) и затем добавляется в архив, если он достаточно отличается от других в

. ACD адаптирует эти принципы для систематического выявления возможностей базовой модели, рассматривая каждую новую способность или сбой как сгенерированный “артефакт”.

3. Связанные работы

Открытое обнаружение с использованием базовых моделей. Область открытости (Stanley, 2019) направлена на постоянное обнаружение разнообразных и новых артефактов. Современные методы используют генеративные возможности и обширные предварительные знания базовых моделей (FMs) для ускорения этого процесса (Faldor et al., 2024; Hu et al., 2024; Lehman et al., 2022; Zhang et al.), используя внутреннее представление модели об “интересности” (Faldor et al., 2024; Hu et al., 2024; Lu et al.; Zhang et al.) для создания следующего предложения, аналогично человеческому инновационному процессу. Примечательные примеры включают LLM (Lehman et al., 2022), которая эволюционирует новые морфологии роботов; OMNI-EPIC (Faldor et al., 2024), которая автоматически создаёт новые среды для обучения с подкреплением (RL); DiscoPOP, которая обнаруживает новые функции потерь для алгоритмов оптимизации предпочтений (Lu et al.); ADAS (Hu et al., 2024), которая эволюционирует новые проекты агентных систем на основе LLM; и The AI Scientist (Lu et al.), которая стремится автоматизировать весь научный процесс, предлагая новые идеи, проводя эксперименты и пишя научные статьи с результатами.

Автоматизированная оценка базовых моделей. Современные исследования также изучают автоматизированную оценку FMs, выходя за рамки статических, созданных человеком тестовых наборов. Rainbow Teaming (Samvelyan et al., 2024) применяет алгоритмы Quality-Diversity (Mouret & Clune, 2015; Pugh et al., 2016) для поиска новых атак, которые тестируют FMs на безопасность. Аналогично, работы вроде (Jiang et al., 2024; Pavlova et al., 2024; Zheng et al., 2024; Zhou et al., 2024) автоматизируют процесс тестирования системы на слабости. Эти работы расширяют полноту существующих проверок безопасности, но не имеют возможности создавать новые задачи, которые могут выявить совершенно неизвестные возможности FMs. Другие методы генерируют новые темы для обсуждения и оценивают FMs через многораундовые дебаты между ними (Zhao et al., 2024), обнаруживают открытые задачи программирования (Pourcel et al.) или создают задачи визуального распознавания и логического мышления из коллекции визуальных активов (Zhang et al.). Между тем, (Shah et al.) создаёт сложные математические задачи из существующих наборов данных и с участием человека в процессе. Однако сгенерированные задачи в этих работах, как правило, сосредоточены на ограниченной области, что не позволяет получить обзор возможностей модели в широком спектре навыков и ограничивает обнаружение удивительных возможностей FMs.

4. Автоматизированное обнаружение возможностей (ACD)

Для базовой модели, которую мы хотим оценить (испытуемый), Автоматизированное обнаружение возможностей (ACD) назначает другую базовую модель в роли “учёного”, чтобы предлагать новые задачи и затем оценивать, насколько хорошо испытуемый справляется с ними. Учёный и испытуемый могут быть одной и той же моделью или разными, но в любом случае обе являются базовыми моделями, поэтому мы называем это “самоисследованием базовой модели”. Итеративно улучшая задачи для выявления интересных или примечательных результатов, ACD стремится автоматизировать большую часть процесса раскрытия возможностей модели. Ниже мы описываем ключевые этапы ACD. (Полные промпты ACD приведены в Приложении B.)

Перевод названий областей из рисунка 2

Слева:

-

Исторический анализ, генерация нарративов и создание альтернативных сценариев

-

Генерация диалогов, эмоциональный интеллект и сценарии социального взаимодействия

-

Генерация поэзии, интерпретация и анализ стихотворных текстов

-

Справа:

-

Научные рассуждения, генерация гипотез и проектирование экспериментов

-

Генерация кода, отладка и проектирование алгоритмов

-

Пространственные преобразования, навигация и трансформация объектов

4.1 Определение семейств задач

Мы используем упрощённую версию стандарта METR Task Standard (METR Task Standard Team, 2024), установленного формата для упаковки задач для оценки базовых моделей. В частности, ACD инструктирует учёного определять и генерировать широкие “семейства задач” как систематический способ охвата целых категорий возможностей — от простого воспроизведения знаний до более сложного логического мышления или программирования. Каждое семейство имеет метаданные, которые включают название, описание и конкретную способность, которая измеряется. Таблица 1 показывает пример того, как такие метаданные задаются для тривиальной задачи повторения строки в стиле “Hello World”.

Таблица 1: Пример метаданных для простого семейства задач “Hello World”.

Ключ

Значение

название

hello_world

описание

возврат строки приветствия

оцениваемая способность

базовая работа со строками

Мы используем способности LLM к программированию для перевода высокоуровневых описаний задач в код на Python, который может быть автоматически оценён. Каждое семейство задач (METR Task Standard Team, 2024) структурировано следующим образом:

-

Конкретные экземпляры задач: Подзадачи генерируются с уникальными данными для исследования различных нюансов одной и той же способности.

-

Предоставление инструкций: Каждая подзадача включает инструкции для модели-испытуемого.

-

Механизм оценки: Программная проверка для задач с одним правильным ответом или судья на основе GPT-4 (Zheng et al., 2023), если задача требует более открытой оценки (Приложение A.2).

В Приложении A.1 показан полный фрагмент кода для примера “Hello World” из Таблицы 1. Это семейство задач может включать строки “Hello, world!” или “Greetings, universe!” в качестве подзадач, инструкции для модели-испытуемого могут быть

"Пожалуйста, повторите следующее сообщение точно так, как оно есть: {...}", а механизм оценки может быть точным сравнением строк. Для более открытых задач мы демонстрируем, что использование базовых моделей в качестве открытых автоматических судей может работать, поскольку часто легче распознать успешное решение конкретной задачи, чем сгенерировать его.4.2 Генерация задач

Следуя принципам открытости (Раздел 2.1), ACD работает в цикле:

-

Поддержание архива: Архив (Lehman & Stanley, 2011; Mouret & Clune, 2015) задач, которые были обнаружены на данный момент. Он начинается с тривиальных задач (как в Разделе 4.1). На каждой итерации учёный видит случайно выбранное подмножество этих задач в качестве контекста.

-

Предложение нового семейства задач: Учёный предлагает новое семейство задач (написанное на Python), используя цепочку рассуждений (Wei et al., 2022) и саморефлексию (Shinn et al., 2023) для исправления ошибок (Приложение B). Во время саморефлексии учёный также проверяет, насколько легко испытуемый решает текущее семейство задач, и адаптирует сложность соответственно.

-

Фильтрация на новизну: Учёный отбрасывает предложения, которые слишком близки к существующим задачам, учитывая, является ли задача “интересно новой” (Zhang et al.) по отношению к её ближайшим соседям, вычисленным через text-embedding-3-small (OpenAI) (Приложение B.3).

-

Тестирование модели-испытуемого: Испытуемый пытается выполнить эти задачи, используя цепочку рассуждений (Приложение B.2) как лёгкий способ выявить больше возможностей из FM. Учёный использует nn-shot оценку для надёжной оценки каждой задачи. Все завершённые задачи сохраняются в архиве, регистрируясь как “обнаруженные возможности”, если они последовательно решаются, или как “режимы сбоев”, если они последовательно не решаются.

Мы можем повторять эти шаги тысячи итераций, пока не будет обнаружено достаточно семейств задач.

5. Эмпирическая оценка

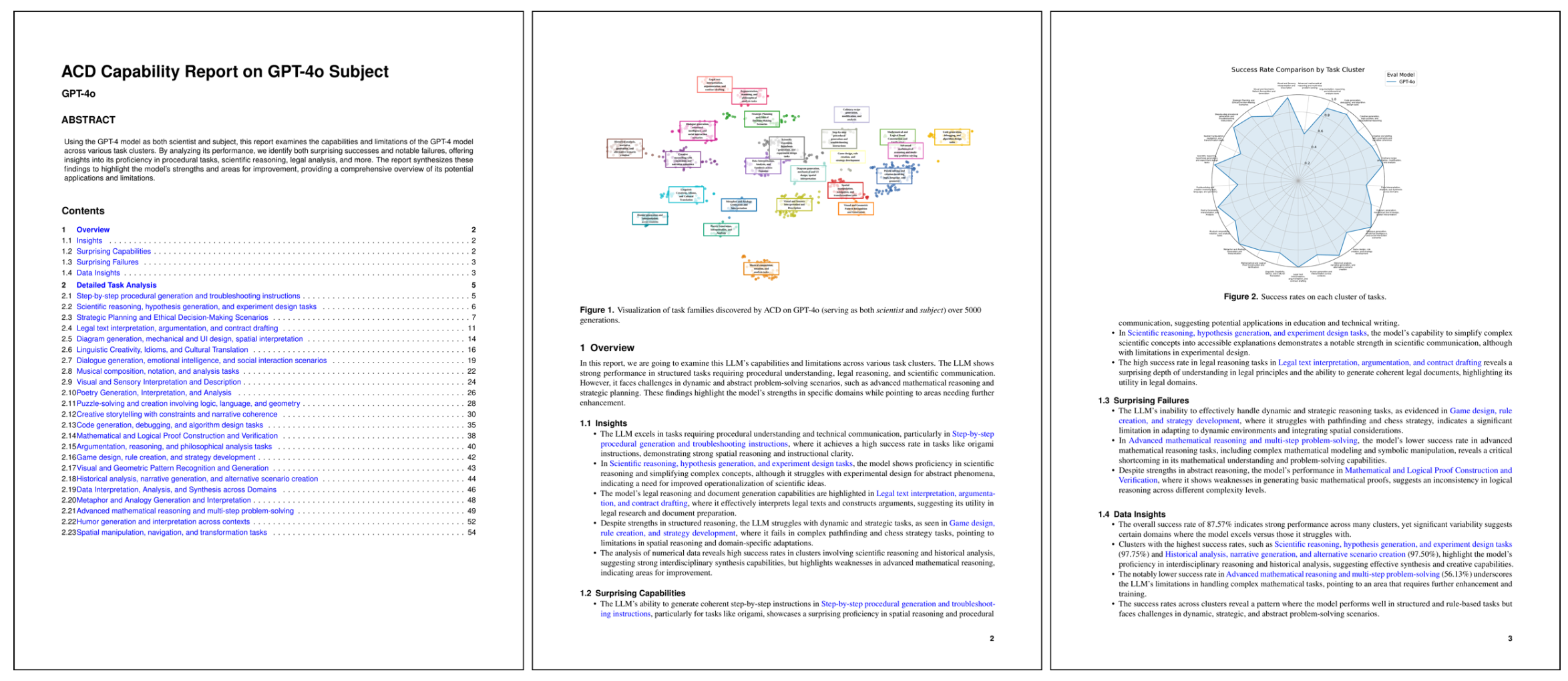

Теперь мы продемонстрируем производительность ACD в обнаружении разнообразных возможностей на нескольких базовых моделях, включая GPT-4o (OpenAI, 2024b), Claude Sonnet 3.5 (Anthropic, 2024) и Llama3-8B (Llama Team, 2024). Сначала мы проведем детальный анализ GPT-4o, выступающей одновременно в роли исследователя и испытуемого, после чего перейдем к экспериментам с различными парами исследователь-испытуемый и кросс-модельному анализу. Для всех оценок мы выполняем 5000 итераций алгоритма. Дополнительные сведения о гиперпараметрах и протоколах оценки приведены в приложениях C и G.

5.1. Пример использования и оценка людьми на GPT-4o

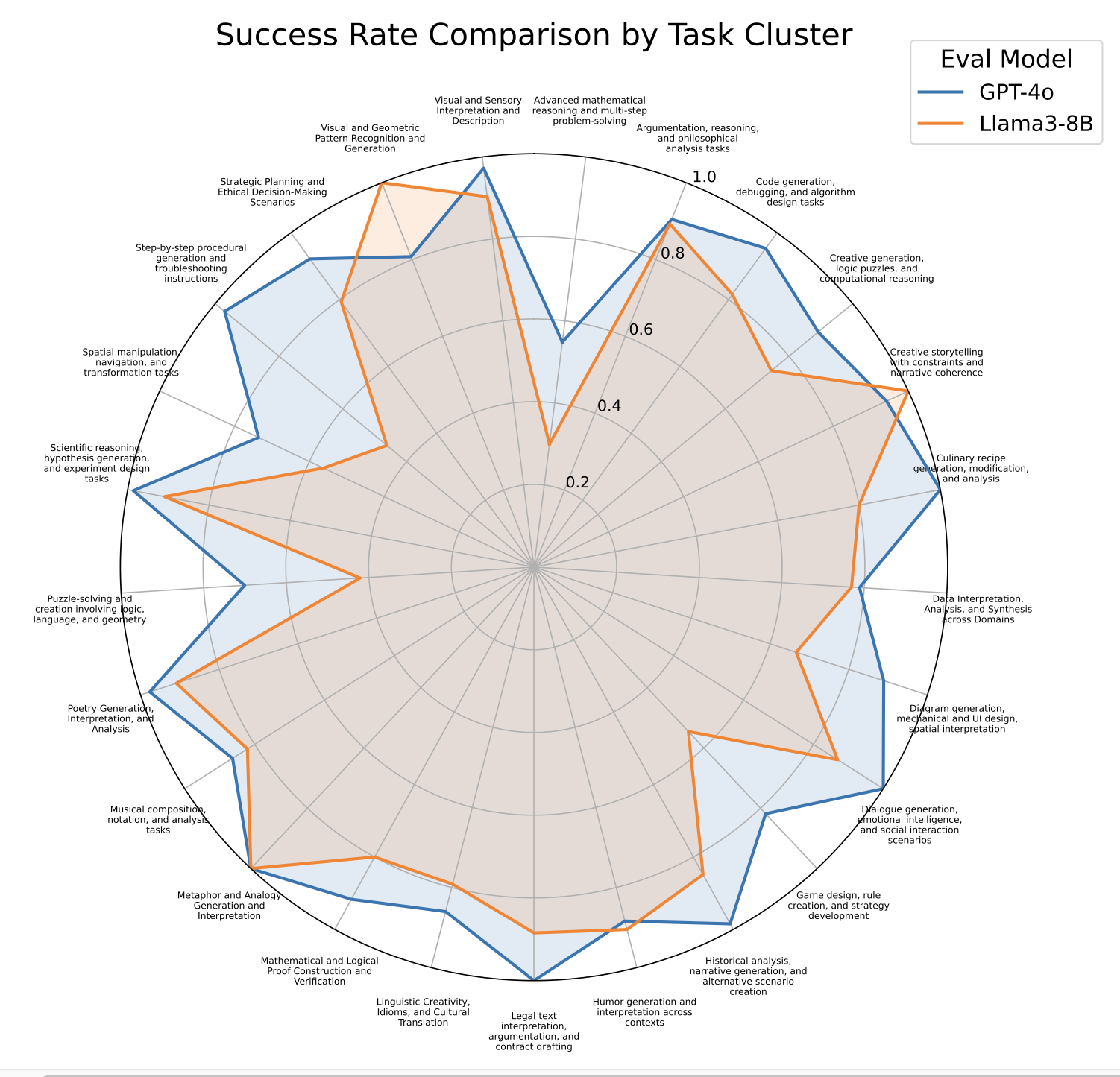

Мы начинаем с анализа ACD, где GPT-4o выполняет роли и учёного, и испытуемого. На Рисунке 2 визуализированы все обнаруженные задачи, сгруппированные с помощью t-SNE (Van der Maaten & Hinton, 2008) и HDBSCAN (McInnes et al., 2017). Из 5000 сгенерированных задач 1330 были признаны интересными и новыми, и они распределились по 25 кластерам (Таблица 4 в Приложении E.1). Эти задачи охватывают широкий спектр областей, включая решение головоломок, генерацию кода, сложные математические вычисления, творческое письмо и интерпретацию юридических текстов.

На Рисунке 1 (справа) показаны три удивительные задачи, выявленные ACD, которые демонстрируют, что GPT-4o иногда ошибается в, казалось бы, простых операциях. Например, модель неправильно вычисляет последовательность из трёх арифметических действий и не может продолжить простой символьный паттерн. С другой стороны, она успешно решает сложный вариант загадки Эйнштейна с 17 подсказками, демонстрируя неожиданно сильные способности к многошаговым рассуждениям.

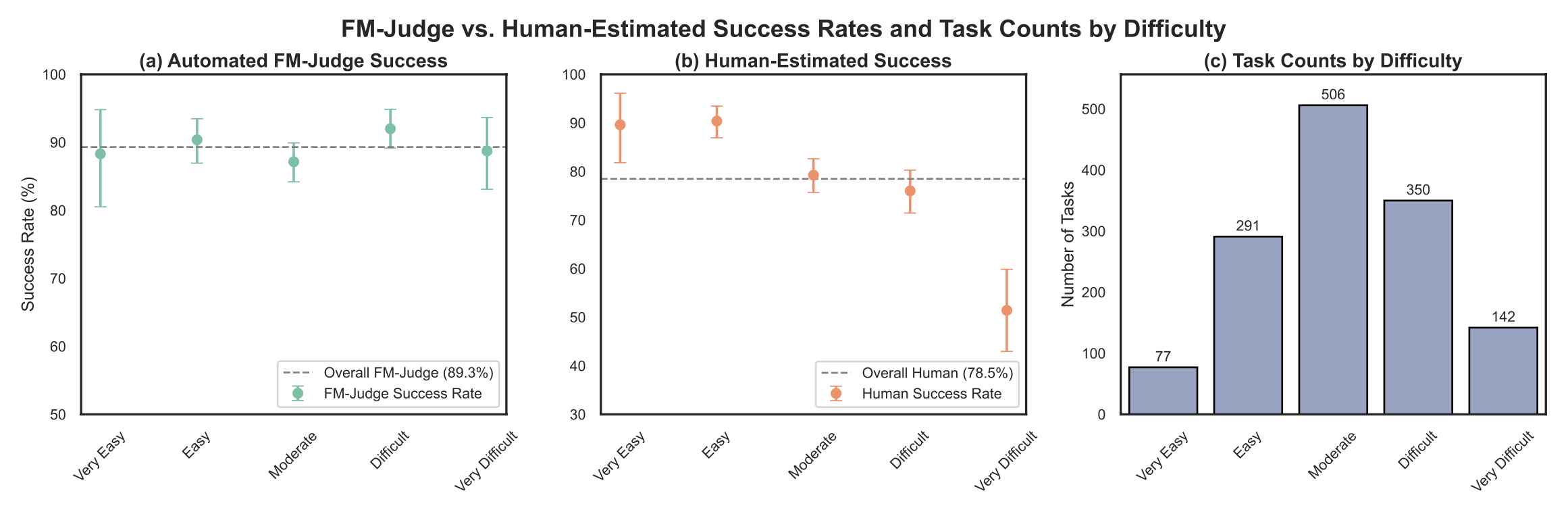

Оценка людьми

Чтобы убедиться, что сгенерированные задания логически согласованы, и оценить точность автоматической оценки в масштабе, мы провели опрос с участием людей через платформу CloudResearch (подробности в Приложении G). Участникам показывали краткое описание каждого задания, точные инструкции и окончательный ответ модели. Затем они оценивали, является ли задание корректным и осмысленным, определяли его сложность по пятибалльной шкале (от «Очень просто» до «Очень сложно») и проверяли, правильный ли ответ дала модель.

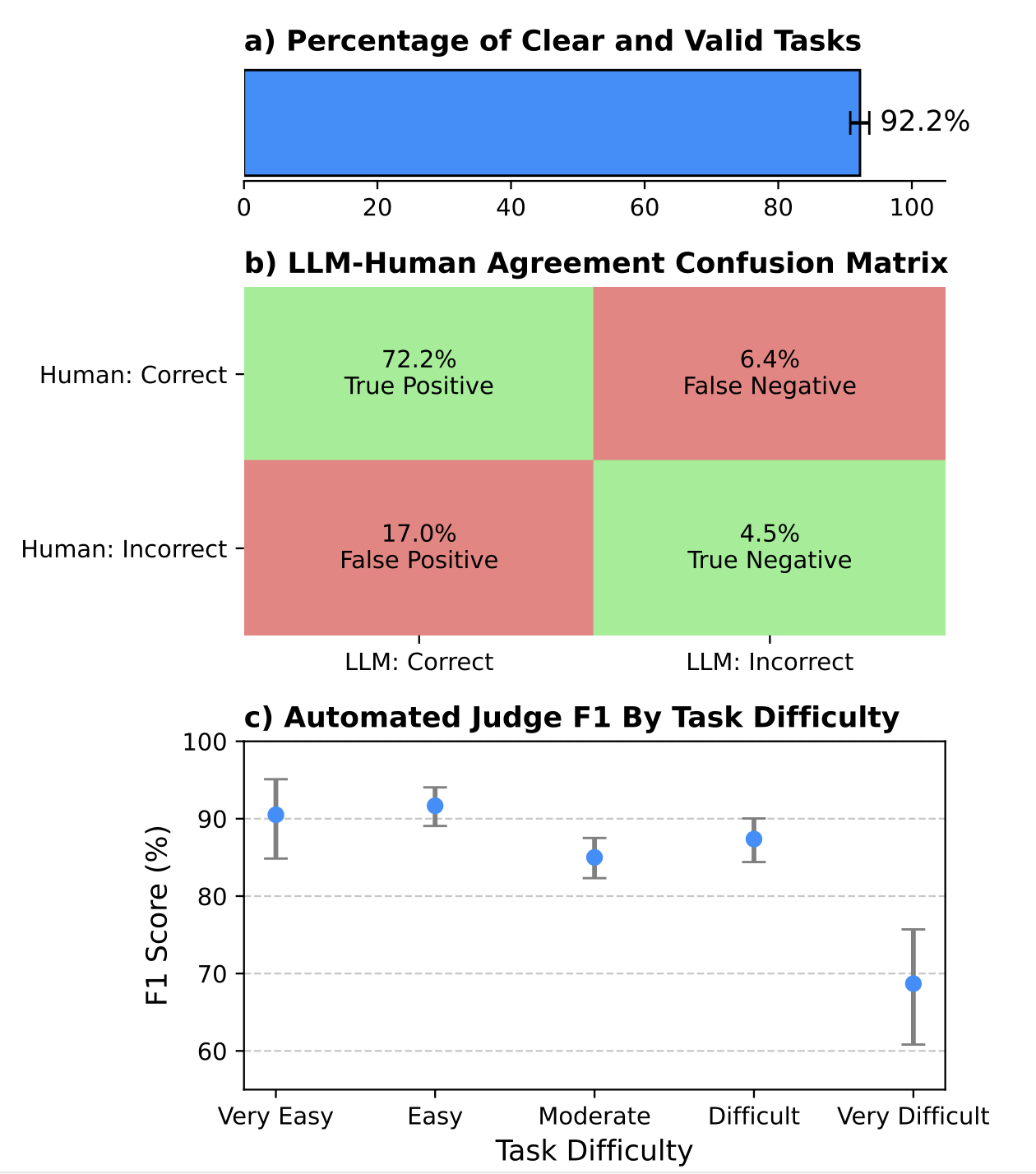

Как видно на Рисунке 3(a), 92,2% заданий были признаны людьми понятными и валидными — то есть инструкции хорошо соответствовали описанию задачи и оцениваемой способности модели. Кроме того, согласно Рисунку 3(b), автоматическая оценка в основном совпадала с человеческой (F1-мера составила 0,86). Мы заметили небольшой позитивный уклон со стороны автоматической системы, что согласуется с предыдущими исследованиями (Zheng et al., 2023). Наконец, Рисунок 3(c) показывает распределение F1-меры (среднее гармоническое точности и полноты, обычно предпочтительное при дисбалансе классов) по уровням сложности: на простых заданиях согласованность высокая, а на очень сложных — снижается. В Приложении F приведены характерные примеры ошибок, допущенных моделью-оценщиком.

Перевод инструкций и ответов модели:

Неожиданные способности к пространственному мышлению

Инструкция:

Ваша задача — визуализировать и описать трёхмерный объект на основе его 2D-проекций.Проекции:

-

Вид спереди: Квадратное основание с треугольной вершиной. Основание имеет сторону длиной 4 единицы, а высота треугольной части — 3 единицы.

-

Вид сбоку: Прямоугольник с треугольной вершиной. Ширина прямоугольника — 4 единицы, а общая высота (включая треугольник) — 5 единиц.

-

Вид сверху: Квадрат со стороной 4 единицы.

Ответ GPT-4o:

Это квадратная пирамида с основанием в виде квадрата со стороной 4 единицы. Пирамида имеет четыре треугольные грани, сходящиеся в одной вершине. Высота пирамиды от основания до вершины составляет 3 единицы. Общая высота объекта (включая основание и вершину) — 5 единиц. Основание лежит на плоскости, а вершина находится строго над центром квадратного основания, образуя симметричные треугольные грани.——————————-

Неспособность следовать простым инструкциям по порядку

Инструкция:

Ваша задача — выполнить следующие преобразования с данным текстом:

«Быстрая коричневая лиса прыгает через ленивую собаку.»Преобразования:

-

Изменить порядок слов на обратный

-

Сделать первую букву каждого слова заглавной

-

Заменить слово «собаку» на «кошку»

Ответ GPT-4o:

Собаку. Ленивую Через Прыгает Лиса Коричневая Быстрая

Рисунок 3: Результаты экспертной оценки заданий, обнаруженных методом ACD, когда GPT-4o выступает одновременно в роли исследователя и испытуемого (Раздел 4). (a) Большинство автоматически сгенерированных заданий были оценены как понятные и валидные. (b) Матрица ошибок показывает, что автоматизированная оценка в основном согласуется с экспертной, но демонстрирует небольшой позитивный уклон (больше ложных срабатываний, чем пропущенных). Показатель F1-меры согласованности между ИИ и человеком достаточно высок и составляет 0,86. (c) F1-мера автоматизированной оценки остается достаточно высокой для заданий, оцененных людьми как “Очень простые” – “Сложные”, но снижается для заданий категории “Очень сложные”. Погрешности показаны с 95% доверительными интервалами, полученными методом бутстреппинга для различных групп заданий. Даже после тысяч итераций метод ACD продолжает обнаруживать новые семейства задач с высокой частотой (около 20% вновь предлагаемых задач считаются интересными и новыми даже после 5000 генераций; Рисунок 8). Это говорит о том, что ACD ещё не полностью раскрыл возможности GPT-4o.

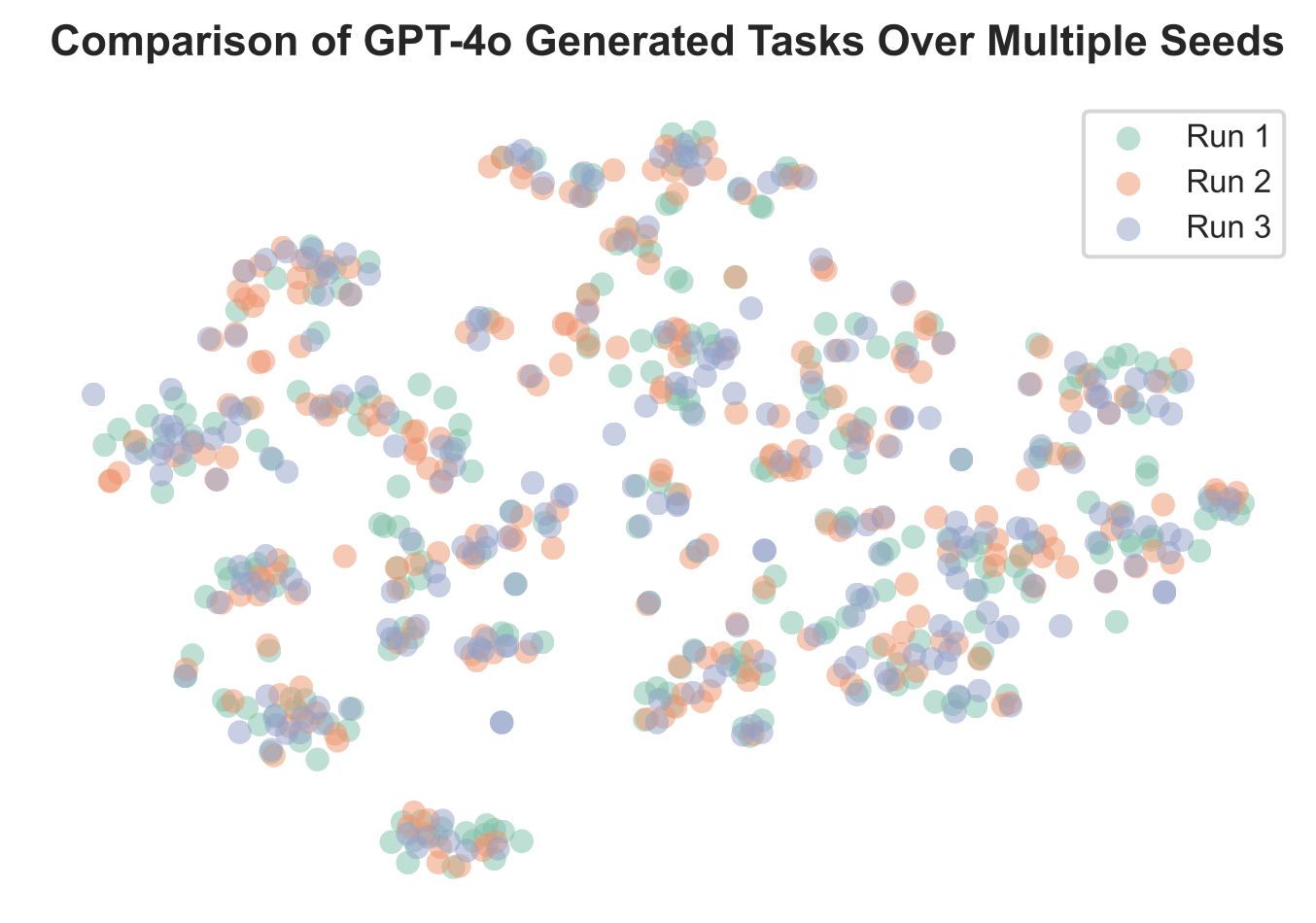

Повторные прогоны с разными начальными значениями также дают согласованный итоговый набор обнаруженных задач (Рисунок 9), демонстрируя, что ACD способен формировать стабильные “сигнатуры возможностей” для заданной модели.

Как показано на Рисунке 10, алгоритм ACD может обнаруживать задачи каждой категории сложности.

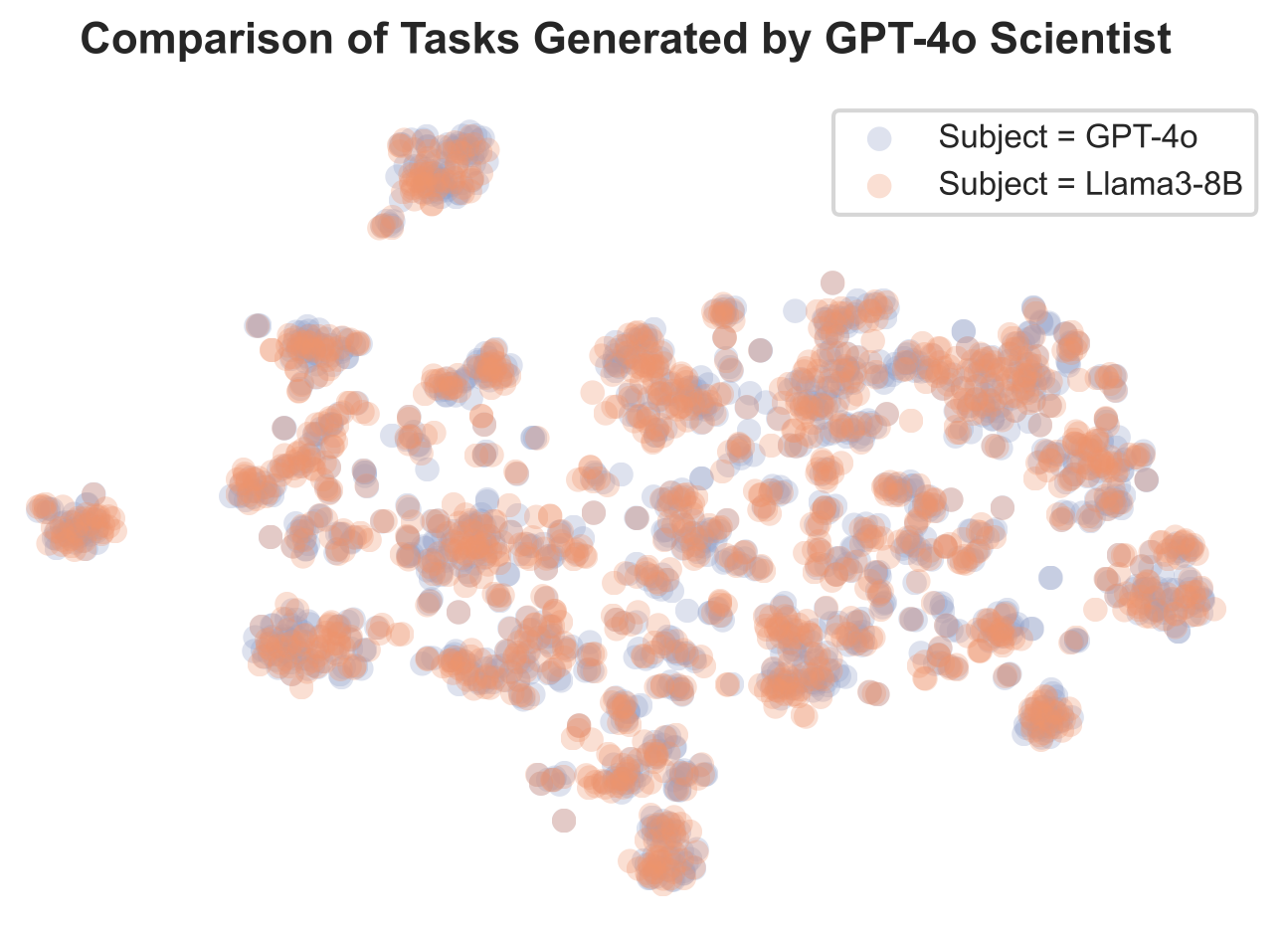

5.2. Изменение тестируемой модели и кросс-модельный анализ

Далее мы исследуем, насколько репозиторий задач, обнаруженных для GPT-4o, может быть обобщён для тестирования другой, менее мощной модели. А именно: мы взяли все 1330 задач, обнаруженных в случае, когда GPT-4o выступал и как исследователь, и как испытуемый (раздел 5.1), и повторно оценили на них модель Llama3-8B (Llama Team, 2024), не изменяя инструкции или функции оценки.

На Рисунке 4 представлен разрыв в производительности между моделями для нескольких широких категорий задач. Мы обнаружили, что Llama3-8B справляется значительно хуже GPT-4o в категориях, требующих многошаговых рассуждений или структурированных рабочих процессов, хотя разрыв меньше в творческих задачах, таких как написание текстов.

Эти наблюдения подчёркивают потенциал метода ACD для создания автоматизированных «репозиториев задач», которые могут использоваться для оценки будущих моделей при одинаковых инструкциях и критериях оценки, что позволяет проводить прямые сравнения — подобно современным бенчмаркам.

Поскольку изначально задачи были адаптированы под GPT-4o, некоторые из них могут оказаться слишком сложными для Llama3-8B. Тем не менее, снижение производительности даёт полезную информацию о слабых местах модели и её частичных успехах.

Рисунок 4: Сравнение производительности GPT-4o (синий) и Llama3-8B (оранжевый) на задачах, изначально обнаруженных GPT-4o. Каждая радиальная ось соответствует основной категории задач (перечислены в Таблице 4), где радиус указывает процент успешного выполнения каждой модели. Результаты Llama3-8B практически полностью уступают GPT-4o, за исключением нескольких областей, где разрыв менее выражен (например, в творческих или открытых текстовых заданиях). Это демонстрирует, как единый архив задач, созданный методом ACD, может давать детальное визуальное представление о возможностях новых моделей. Список категорий задач рисунка 4:

Таблица 4: Обнаруженные кластеры для случая «GPT-4o как учёный и испытуемый»

ID

Название кластера

Всего задач

Успешность (%)

1

Творческая генерация, логические головоломки и вычислительные задачи

185

89.7

2

Решение и создание головоломок (логика, язык, геометрия)

104

70.2

3

Визуальная и сенсорная интерпретация и описание

72

97.2

4

Музыкальная композиция, нотная запись и анализ

72

86.1

5

Творческое рассказывание историй с ограничениями и нарративной связностью

69

94.2

6

Научные рассуждения, генерация гипотез и проектирование экспериментов

69

98.6

7

Генерация диалогов, эмоциональный интеллект и сценарии социального взаимодействия

61

100.0

8

Генерация кода, отладка и проектирование алгоритмов

60

95.0

9

Исторический анализ, генерация нарративов и альтернативных сценариев

60

98.3

10

Пространственные преобразования, навигация и манипуляции

51

74.5

11

Лингвистическое творчество, идиомы и культурный перевод

49

85.7

12

Интерпретация, анализ и синтез данных в различных областях

49

77.6

13

Стратегическое планирование и сценарии этического принятия решений

48

91.7

14

Интерпретация юридических текстов, аргументация и составление контрактов

41

100.0

15

Аргументация, рассуждения и философский анализ

41

90.2

16

Генерация юмора и его интерпретация в разных контекстах

41

87.8

17

Генерация, интерпретация и анализ поэзии

40

97.5

18

Генерация и интерпретация метафор и аналогий

34

100.0

19

Пошаговая генерация инструкций и устранение неполадок

34

97.1

20

Генерация кулинарных рецептов, их модификация и анализ

32

100.0

21

Сложные математические рассуждения и многошаговое решение задач

31

54.8

22

Распознавание и генерация визуальных и геометрических паттернов

25

84.0

23

Дизайн игр, создание правил и разработка стратегий

22

81.8

24

Построение и проверка математических и логических доказательств

21

90.5

25

Генерация диаграмм, механический и UI-дизайн, пространственная интерпретация

19

89.5

Мы также рассмотрели исходную схему работы ACD заново, где GPT-4o выступает в роли исследователя, а Llama3-8B – в роли испытуемого. В этом случае исследователь адаптирует сложность и масштаб задач в соответствии с наблюдаемой производительностью Llama3-8B. Метод ACD обнаружил 1395 новых интересных задач, обобщенных на Рисунке 11 и в Таблице 5.

Хотя общие категории задач (программирование, математика, решение головоломок, творческое письмо и т.д.) остались схожими, было выявлено множество показательных ошибок, примеры которых приведены в Приложении E.4. В работе представлены два типичных примера (вверху справа): один представляет собой тривиальную задачу на поворот матрицы 3×3, а другой – логическую головоломку, которая заводит Llama3-8B в бесконечный цикл, исчерпывающий лимит токенов.

Хотя подобные ошибки характерны для меньших моделей, они представляют собой совершенно новые открытия для исследователя GPT-4o, поскольку знания этой модели ограничены октябрём 2023 года (OpenAI, 2024b), а использованная нами версия Llama3-8B была выпущена в июле 2024 года. Это подчёркивает способность ACD автоматически выявлять разнообразные новые типы ошибок.

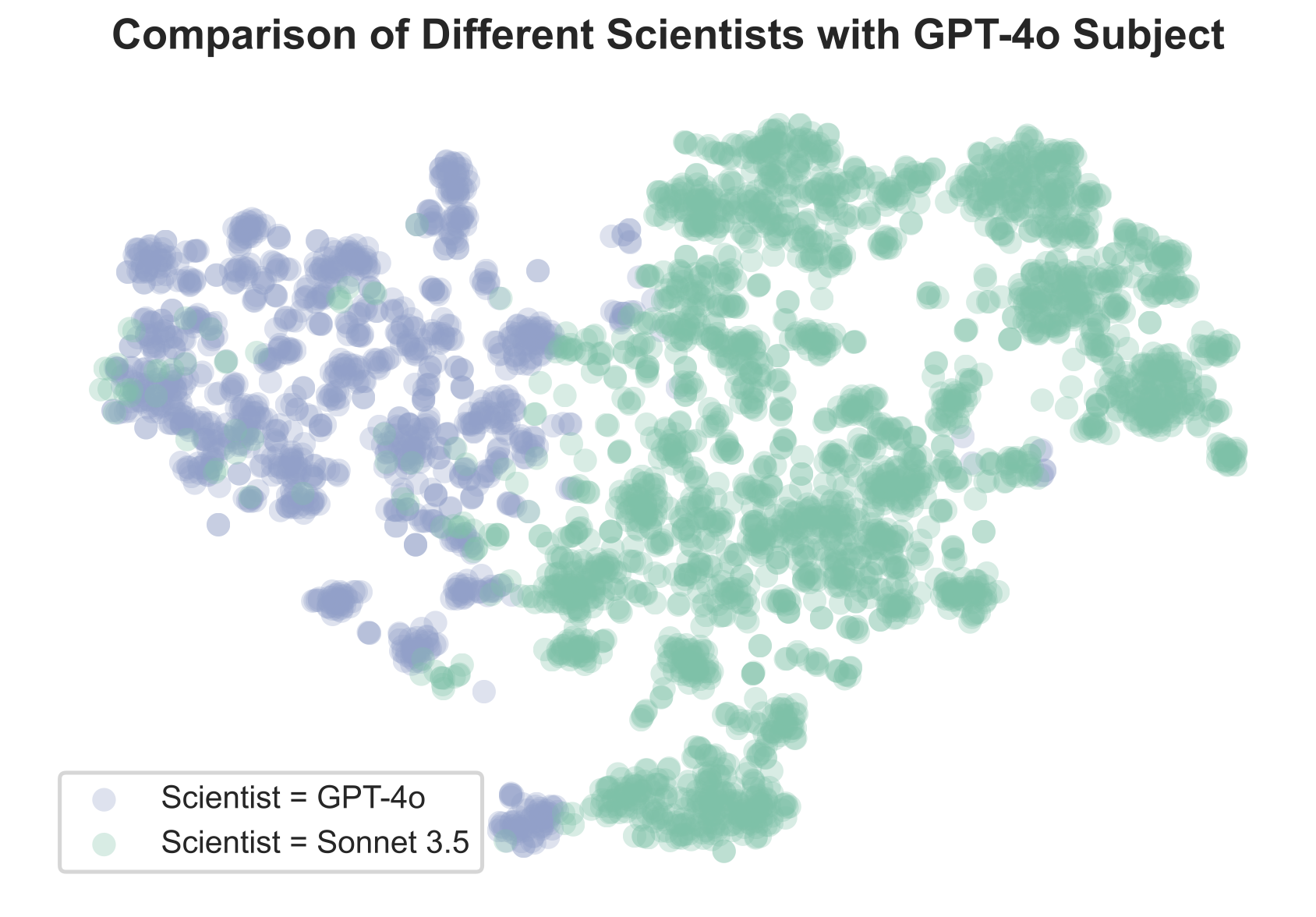

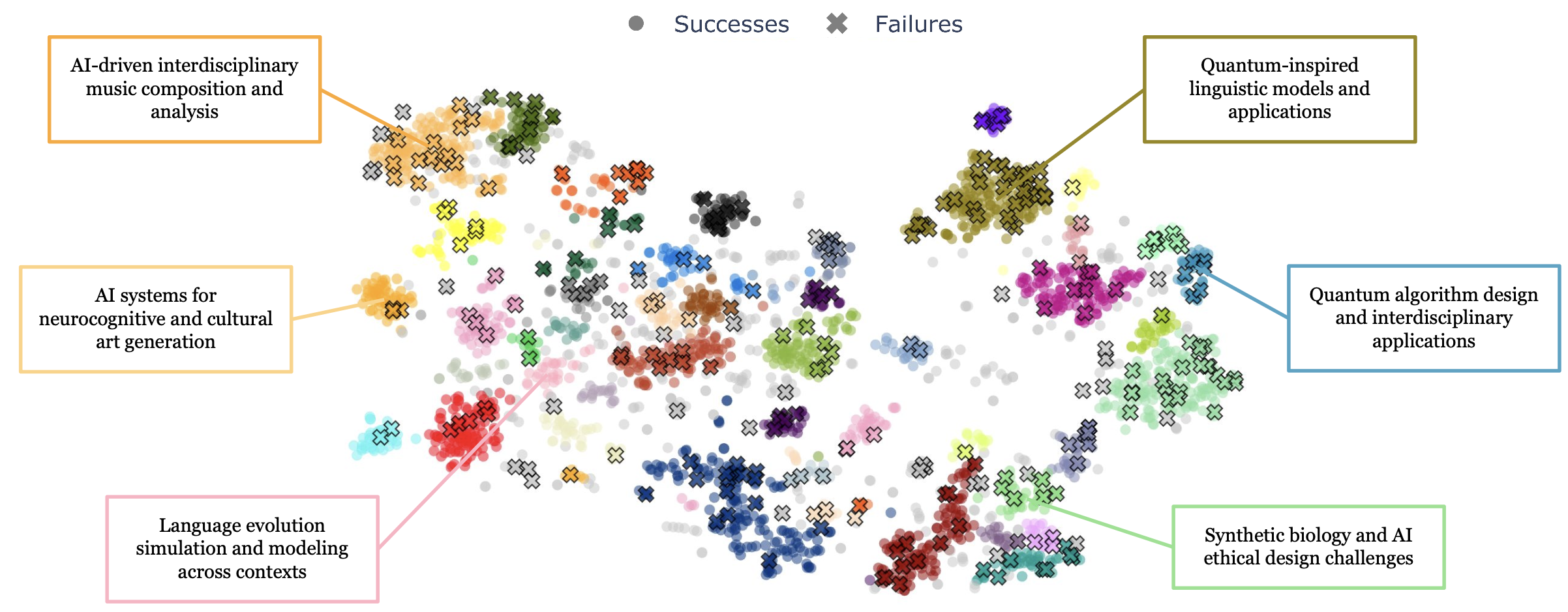

5.3. Изменение модели-исследователя

Наконец, мы исследовали, как смена модели-исследователя влияет на распределение обнаруженных задач, при сохранении GPT-4o в качестве испытуемого. Вместо GPT-4o мы использовали Claude Sonnet 3.5 (Anthropic, 2024) в роли исследователя. Как видно на Рисунке 5 и Рисунке 6, Sonnet 3.5 генерирует множество задач в аналогичных высокоуровневых категориях, но также предлагает более междисциплинарные, творческие и необычные задания (например, квантово-вдохновленную биологию, кросс-культурный языковой дизайн и синестетические рассуждения). Вероятно, это интересная особенность модели Sonnet, которую Anthropic целенаправленно обучали для развития особой, более “творческой личности” (Anthropic, 2024), что уже отмечалось в профессиональном сообществе.

Рисунок 5: Сравнение эмбеддингов задач, сгенерированных для GPT-4o двумя разными моделями-исследователями: GPT-4o (синий) и Claude Sonnet 3.5 (зелёный). Каждая точка представляет обнаруженную способность или ошибку; цвет указывает на модель-исследователя. Мы наблюдаем, что Sonnet 3.5 охватывает основные области GPT-4o, но при этом предлагает дополнительные задачи открытого типа и творческой направленности, отсутствующие у GPT-4o. Подробное распределение по кластерам см. в Таблице 6. Это демонстрирует, что разные модели-исследователи могут выявлять различные аспекты возможностей одной и той же тестируемой модели, что обосновывает целесообразность ансамблевых подходов. Подробное распределение по кластерам из рис.5:

Таблица 6: Обнаруженные кластеры для случая «Claude Sonnet 3.5 как учёный и GPT-4o как испытуемый»

ID

Название кластера

Всего задач

Успешность (%)

1

Креативный междисциплинарный дизайн и анализ

382

90.8

2

Дизайн междисциплинарных систем (этика-ИИ-нейронаука)

183

91.3

3

Квантовая биология и вычислительный дизайн систем

179

87.7

4

ИИ-генерация музыки и междисциплинарный анализ

174

91.4

5

Квантово-вдохновленные лингвистические модели

172

82.0

6

Моделирование экосистем и климата с ИИ

127

90.6

7

Квантово-вдохновленные когнитивные и нейронные системы

123

93.5

8

Генерация метафор ИИ и кросс-культурная когнитивная лингвистика

108

95.4

9

Системы ИИ для нейролингвистического изучения языков

102

92.2

10

Моделирование эволюции языка

91

93.4

11

Эмоциональные и культурные системы коммуникации ИИ

71

93.0

12

Математическая и когнитивная музыкальная композиция

66

86.4

13

Системы ИИ для нейрокогнитивного искусства

62

93.5

14

Дизайн синестетических ИИ-систем

55

90.9

15

Дизайн искусственных языков

54

87.0

16

Биомиметический дизайн и устойчивые инженерные решения

53

84.9

17

Реконструкция древних языков и цивилизаций с ИИ

49

81.6

18

Синтетическая биология и этические задачи дизайна ИИ

43

86.0

19

Концептуальное смешение в ИИ

43

95.3

20

Когнитивно-лингвистический дизайн языков для ИИ

42

90.5

21

Когнитивный и культурный нарративный дизайн ИИ

42

97.6

22

Математико-лингвистические системы

41

78.0

23

Дизайн квантовых алгоритмов

37

83.8

24

Исследование лингвистической относительности

36

97.2

25

Когнитивные и лингвистические модели ИИ

36

91.7

26

Биовдохновленные вычисления и ДНК-системы

35

80.0

27

ИИ-сознание и искусственное самосознание

35

91.4

28

Дизайн языков для общения с инопланетянами

32

93.8

29

Визуально-лингвистическая абстракция в ИИ

32

84.4

30

Квантовые системы для климата и экологии

29

96.6

31

Квантовая и постквантовая криптография

28

75.0

32

Кросс-культурная лингвистическая адаптация

27

100.0

33

Лингвистические и исторические криптосистемы

27

77.8

34

Дизайн междисциплинарных головоломок

25

80.0

35

Квантовая музыкальная композиция

24

79.2

36

Биомиметические ИИ и робототехника

22

86.4

37

Квантово-вдохновленные нарративы

21

95.2

38

Создание межкультурных идиом

21

100.0

39

Семантические сети для ИИ

20

100.0

40

Квантовая креативность и искусство

20

90.0

41

Альтернативная история и технологии

18

83.3

42

Биомиметический ИИ для экологии

18

94.4

43

Дизайн экзопланетных систем

18

94.4

44

Мультимодальные системы коммуникации

17

88.2

45

Перевод абстрактных концепций

17

100.0

46

Моделирование общества и истории

16

81.2

Рисунок 6: Способности, обнаруженные методом ACD при использовании Claude Sonnet 3.5 в качестве исследователя и GPT-4o в качестве испытуемого. Каждая из 2873 новых интересных задач представлена точкой и визуализирована в 2D-пространстве с помощью t-SNE. Мы выделили 46 кластеров в различных областях, включая: квантово-вдохновленные биологические системы; кросс-культурную генеративную лингвистику; музыкальную композицию с использованием продвинутой теории (Полный перечень приведен в Таблице 6.). В сравнении с GPT-4o в роли исследователя (Рисунок 2), Sonnet демонстрирует тенденцию предлагать значительно более абстрактные, междисциплинарные, творческие задачи. Названия областей на рис.6:

-

Quantum-inspired biological systems

→ Квантово-вдохновленные биологические системы -

Cross-cultural generative linguistics

→ Кросс-культурная генеративная лингвистика -

Musical composition with advanced theory

→ Музыкальная композиция с продвинутой теорией -

AI neurocognitive art generation

→ Нейрокогнитивная генерация искусства с ИИ -

Xenolinguistic conlang design

→ Дизайн ксенолингвистических искусственных языков

(conlang – constructed language) -

Quantum-algorithmic ecosystem modeling

→ Моделирование экосистем с квантовыми алгоритмами

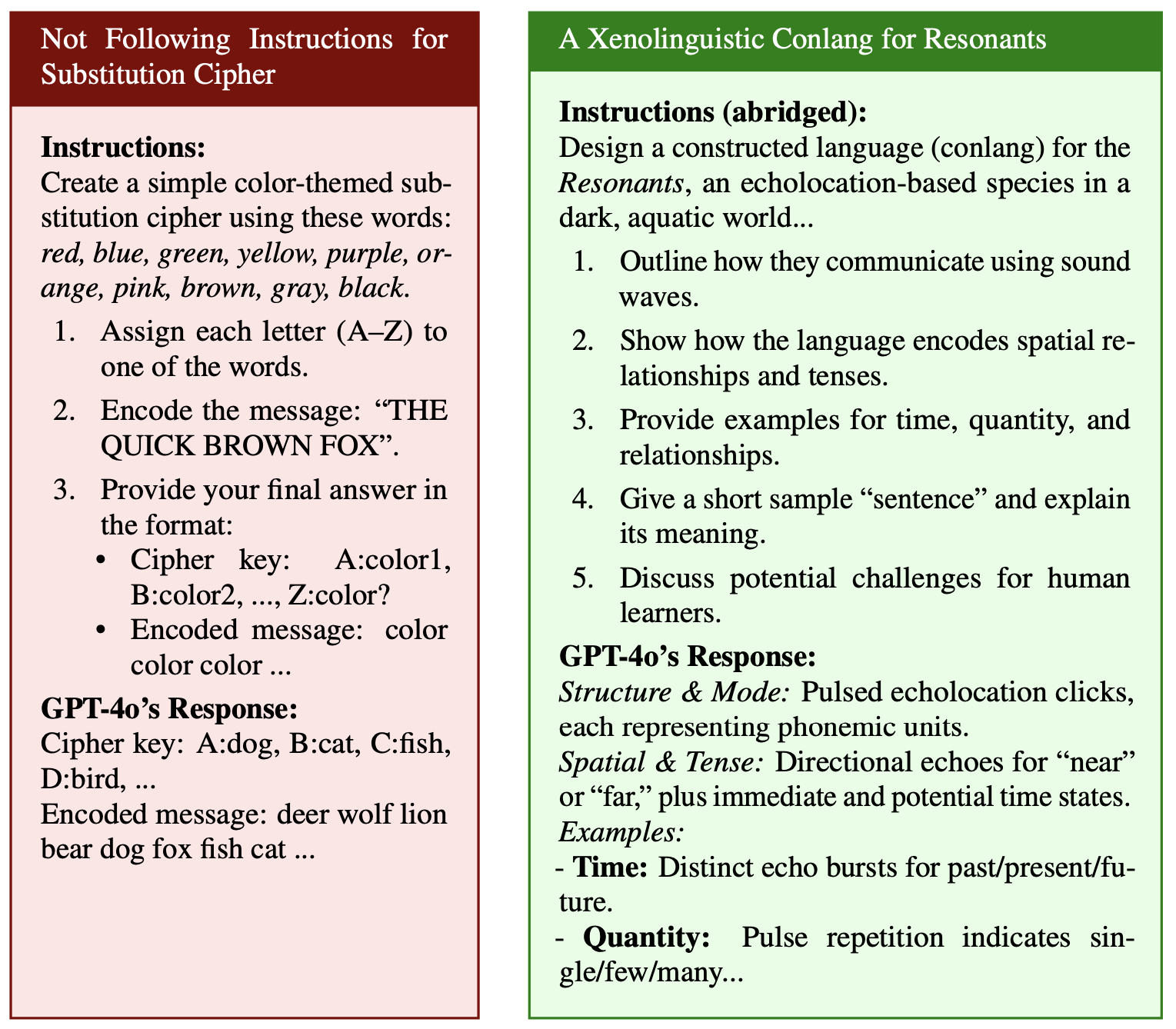

Ниже мы приводим пример обнаруженной ошибки (левый блок), где GPT-4o проигнорировал требование использовать цветовые слова в качестве ключа шифра, и успешного выполнения (правый блок), где модель представила последовательный “ксенолингвистический” искусственный язык. Оба примера обладают характерным “почерком”, отсутствующим у исследователя GPT-4o. Дополнительные примеры приведены в Приложении E.5.

Перевод левого и правого блока:

Несоблюдение инструкций для шифра подстановки

Инструкция:

Создайте простой шифр подстановки на основе цветов, используя следующие слова: красный, синий, зелёный, жёлтый, фиолетовый, оранжевый, розовый, коричневый, серый, чёрный.-

Сопоставьте каждой букве (A–Z) одно из цветовых слов.

-

Зашифруйте сообщение: “THE QUICK BROWN FOX”.

-

Предоставьте ответ в формате:

-

Ключ шифра: A:цвет1, B:цвет2, …, Z:цвет?

-

Зашифрованное сообщение: цвет цвет цвет …

-

Ответ GPT-4o:

Ключ шифра: A:собака, B:кошка, C:рыба, D:птица, …

Зашифрованное сообщение: олень волк лев медведь собака лиса рыба кошка …——————————————–

Ксенолингвистический конланг для резонантов

Сокращённая инструкция:

Разработайте искусственный язык (конланг) для резонантов — вида, использующего эхолокацию в тёмной водной среде…-

Опишите их систему общения с помощью звуковых волн.

-

Покажите, как язык кодирует пространственные отношения и временные формы.

-

Приведите примеры для времени, количества и отношений.

-

Дайте короткий пример «предложения» с пояснением его значения.

-

Обсудите возможные сложности для людей, изучающих этот язык.

Ответ GPT-4o:

Структура и способ коммуникации:-

Фонемы передаются импульсными щелчками эхолокации.

Пространство и время:

-

Направленность эха указывает на «близко»/«далеко».

-

Разные состояния времени: текущее и потенциальное.

Примеры:

-

Время: Отдельные серии щелчков для прошлого/настоящего/будущего.

-

Количество: Частота повторения импульсов обозначает «один»/«несколько»/«много».

Хотя этот пример искусственного языка является творческим и довольно интригующим, он явно выходит за рамки традиционных тестовых наборов для базовых моделей. Тем не менее, подобные примеры демонстрируют нетривиальные возможности метода ACD в исследовании нестандартных аспектов, что может оказаться чрезвычайно полезным для обеспечения безопасности ИИ – там, где нам нужны системы, способные выявлять непредвиденные возможности (“неизвестные неизвестности”).

Такие задачи также представляют значительную сложность для автоматической оценки, что подчеркивает необходимость разработки более совершенных механизмов контроля (Bowman et al., 2022). Наши результаты показывают, что разные модели-исследователи выявляют различные аспекты возможностей одной и той же тестируемой модели, обнаруживая новые сильные и слабые стороны. Это обосновывает целесообразность использования ансамбля моделей-исследователей для более полного охвата потенциальных возможностей и сценариев сбоев, вместо зависимости от единственной модели.

6. Формирование отчёта

После сбора задач и результатов оценки ACD автоматически формирует Отчёт о возможностях, в котором:

-

Систематизируются все обнаруженные функции модели

-

Выделяются устойчивые успехи и типичные ошибки

-

Анализируются ключевые особенности тестируемой модели

Этот подход соответствует современным тенденциям использования базовых моделей для научного анализа и генерации текстов (Lu et al., 2024c; Steinruecken et al., 2019; Wang et al., 2024).

Преимущества двусторонние:

-

Интерпретируемость: Итоговый отчёт представляет собой сжатый обзор обнаруженных возможностей и сценариев сбоев, служа наглядным справочным материалом для разработчиков и аудиторов безопасности.

-

Автоматизация: Процесс свёртки данных сокращает ручной труд, необходимый для анализа большого числа задач, однако выборочная проверка человеком остаётся полезной для выявления наиболее показательных или неожиданных примеров (Приложение E.2).

Таким образом, мы рекомендуем использовать ACD в дополнение к существующим тестам безопасности, согласованности и возможностей моделей, а не как их замену.

Процесс генерации отчёта следующий: ACD обрабатывает все кластеры (полученные через t-SNE и HDBSCAN, см. Раздел 5), задачи, автоматические оценки и ответы модели, выполняя три шага:

-

Выбор показательных примеров:

-

Автоматический отбор неожиданных успехов и сбоев по кластерам на основе отклонений от ожидаемой производительности или аномального поведения.

-

-

Анализ кластеров:

-

Определение общей тематики каждого кластера;

-

Выявление ключевых возможностей и уязвимостей модели на основе примеров;

-

Интерпретация сильных и слабых сторон модели.

-

-

Формирование сводного отчёта:

-

Объединение кластерных анализов в единый документ;

-

Структурированный перечень основных возможностей, типичных ошибок и общих тенденций.

-

Отчёт включает:

-

Детализированный разбор по кластерам (с ответами модели);

-

Акценты на неожиданных результатах;

-

Общие выводы.

Это позволяет быстро выявлять новые инсайты о модели и определять области, требующие углублённой проверки. Примеры страниц отчёта для GPT-4o приведены на Рисунке 7.

Рисунок 7: Примеры страниц автоматически сгенерированного отчёта для GPT-4o (подробности в Приложении H.3). Полная PDF-версия доступна на GitHub. 7. Вопросы безопасности

Весь код, генерируемый нашей системой для определения и оценки задач, выполняется в изолированных контейнерах. Этот подход:

-

предотвращает несанкционированный доступ к сети

-

ограничивает доступ к файловой системе хоста

-

минимизирует другие потенциально опасные действия

Наша методология соответствует общепринятым стандартам безопасного выполнения кода (Chen et al., 2021b; Hu et al., 2024; Jimenez et al., 2024), гарантируя, что любые случайные или вредоносные команды эффективно изолируются. Дополнительно мы явно запрещаем ACD доступ в интернет или к файловой системе, а статический анализ подтверждает отсутствие таких попыток (например, отсутствуют системные вызовы ‘os’). Эти меры значительно снижают риск выполнения опасного кода.

По своей природе ACD систематически выявляет как неожиданные успехи, так и непредвиденные сбои базовых моделей. Обнаружение неожиданных или возникающих возможностей:

-

критически важно для оценки производительности моделей

-

помогает понять потенциальные риски безопасности (Dong et al., 2024; Ganguli et al., 2022)

Например, если ACD обнаружит новый способ обхода защитных механизмов языковых моделей, это позволит разработать исправление до промышленного внедрения. Аналогично, выявление систематических ошибок (например, в юридических толкованиях или математических рассуждениях) предупреждает разработчиков о потенциальных рисках в ответственных приложениях.

Таким образом, ACD служит дополнительным защитным механизмом, помогая:

-

выявлять опасные или этически чувствительные модели поведения на ранних этапах

-

предотвращать риски до внедрения моделей (Bengio et al., 2024a;b)

Этот подход обеспечивает более безопасный жизненный цикл ИИ-моделей.

8. Заключение и ограничения

Мы представили AUTOMATED CAPABILITY DISCOVERY (ACD) — систему, в которой одна базовая модель в роли исследователя автономно обнаруживает и оценивает возможности другой модели (испытуемого), сокращая необходимость ручного проектирования задач.

Ключевые результаты:

-

Систематическое исследование: ACD выявляет широкий спектр неожиданных способностей и сбоев у тестируемых моделей (например, GPT и Llama).

-

Валидация: Экспертная оценка задач, сгенерированных для GPT-4o, подтвердила:

-

Логичность большинства автоматически созданных заданий

-

Высокую согласованность самооценки модели с мнением людей (хотя и с небольшим позитивным смещением)

-

Перспективы развития:

-

Улучшение автоматической оценки:

-

Внедрение более сложных агентных систем (Hu et al., 2024)

-

-

Оптимизация отчётов:

-

Автоматический подбор примеров, сопоставимых по качеству с ручной выборкой (Приложение E.2)

-

-

Расширение функционала:

-

Переход от текстовых задач к многомодальным и агентным сценариям (Zhang et al., 2024a)

-

Исследование новых классов моделей (например, OpenAI o1, DeepSeek r1)

-

Потенциальное влияние:

-

Безопасность ИИ: Масштабирование ACD позволит автоматизировать значительную часть оценки моделей.

-

Самообучение моделей: Задачи, созданные ACD, могут стать основой для самоулучшенияИИ через открытые алгоритмы (Clune, 2019; Zhang et al., 2024b).

Ограничения:

Текущая версия ACD ориентирована на одноэтапные текстовые задачи. Для сложных сценариев (например, с взаимодействием среды) требуются доработки.

Благодарности:

Данное исследование было поддержано:

-

Институтом Vector

-

Программой Canada CIFAR AI Chairs

-

Грантами от Schmidt Futures и Open Philanthropy

-

Грантом NSERC Discovery

-

Щедрым пожертвованием Рафаэля Космана

Мы выражаем глубокую признательность Аарону Дхарне, Бену Норману, Дженни Чжан, Ноа Гудмену и Рори Грейгу за ценные обсуждения и конструктивные замечания по ранним версиям этой работы.

Ссылки:

Anthropic. The Claude 3 model family: Opus, Sonnet, Haiku, 2024. URL: https://www-cdn.anthropic.com/de8ba9b01c9ab7cbabf5c33b80b7bbc618857627/Model_Card_Claude_3.pdf

Bengio, Y., Hinton, G., Yao, A., Song, D., Abbeel, P., Darrell, T., Harari, Y. N., Zhang, Y.-Q., Xue, L., Shalev-Shwartz, S., et al. Managing extreme AI risks amid rapid progress. Science, 384(6698):842-845, 2024a.

Bengio, Y., Mindermann, S., Privitera, D., Besiroglu, T., Bommasani, R., Casper, S., Choi, Y., Goldfarb, D., Heidari, H., Khalatbari, L., et al. International scientific report on the safety of advanced AI (interim report). arXiv preprint arXiv:2412.05282, 2024b.

BIG-bench authors. Beyond the imitation game: Quantifying and extrapolating the capabilities of language models. Transactions on Machine Learning Research, 2023. ISSN 2835-8856. URL: https://openreview.net/forum?id=uyTL5Bvosj

Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., Bernstein, M. S., Bohg, J., Bosselut, A., et al. On the opportunities and risks of foundation models. ArXiv, 2021. URL: https://crfm.stanford.edu/assets/report.pdf

Bowman, S. R., Hyun, J., Perez, E., Chen, E., Pettit, C., Heiner, S., Lukošiūtė, K., Askell, A., Jones, A., Chen, A., Goldie, A., Mirhoseini, A., McKinnon, C., Olah, C., Amodei, D., Amodei, D., Drain, D., Li, D., Tran-Johnson, E., Kernion, J., Kerr, J., Mueller, J., Ladish, J., Landau, J., Ndousse, K., Lovitt, L., Elhage, N., Schiefer, N., Joseph, N., Mercado, N., DasSarma, N., Larson, R., McCandlish, S., Kundu, S., Johnston, S., Kravec, S., Showk, S. E., Fort, S., Telleen-Lawton, T., Brown, T., Henighan, T., Hume, T., Bai, Y., Hatfield-Dodds, Z., Mann, B., and Kaplan, J. Measuring progress on scalable oversight for large language models, 2022. URL: https://arxiv.org/abs/2211.03540

Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A., Agarwal, S., Herbert-Voss, A., Krueger, G., Henighan, T., Child, R., Ramesh, A., Ziegler, D. M., Wu, J., Winter, C., Hesse, C., Chen, M., Sigler, E., Litwin, M., Gray, S., Chess, B., Clark, J., Berner, C., McCandlish, S., Radford, A., Sutskever, I., and Amodei, D.Language models are few-shot learners, 2020.

Chang, Y., Wang, X., Wang, J., Wu, Y., Yang, L., Zhu, K., Chen, H., Yi, X., Wang, C., Wang, Y., et al.A survey on evaluation of large language models. ACM Transactions on Intelligent Systems and Technology, 15(3):1-45, 2024.

Chen, M., Tworek, J., Jun, H., Yuan, Q., de Oliveira Pinto, H. P., Kaplan, J., Edwards, H., Burda, Y., Joseph, N., Brockman, G., Ray, A., Puri, R., Krueger, G., Petrov, M., Khlaaf, H., Sastry, G., Mishkin, P., Chan, B., Gray, S., Ryder, N., Pavlov, M., Power, A., Kaiser, L., Bavarian, M., Winter, C., Tillet, P., Such, F. P., Cummings, D., Plappert, M., Chantzis, F., Barnes, E., Herbert-Voss, A., Guss, W. H., Nichol, A., Paino, A., Tezak, N., Tang, J., Babuschkin, I., Balaji, S., Jain, S., Saunders, W., Hesse, C., Carr, A. N., Leike, J., Achiam, J., Misra, V., Morikawa, E., Radford, A., Knight, M., Brundage, M., Murati, M., Mayer, K., Welinder, P., McGrew, B., Amodei, D., McCandlish, S., Sutskever, I., and Zaremba, W. Evaluating large language models trained on code, 2021a.

Chen, M., Tworek, J., Jun, H., Yuan, Q., Pinto, H. P. D. O., Kaplan, J., Edwards, H., Burda, Y., Joseph, N., Brockman, G., et al. Evaluating large language models trained on code. arXiv preprint arXiv:2107.03374, 2021b.

Clune, J. AI-GAs: AI-generating algorithms, an alternate paradigm for producing general artificial intelligence. arXiv preprint arXiv:1905.10985, 2019.

Cobbe, K., Kosaraju, V., Bavarian, M., Chen, M., Jun, H., Kaiser, L., Plappert, M., Tworek, J., Hilton, J., Nakano, R., Hesse, C., and Schulman, J. Training verifiers to solve math word problems. arXiv preprint arXiv:2110.14168, 2021.

Colas, C., Teodorescu, L., Oudeyer, P.-Y., Yuan, X., and Côté, M.-A. Augmenting autotelic agents with large language models. In Proceedings of The 2nd Conference on Lifelong Learning Agents, volume 232 of Proceedings of Machine Learning Research, pp. 205-226. PMLR, 22-25 Aug 2023. URL: https://proceedings.mlr.press/v232/colas23a.html

DeepSeek-AI. Deepseek-r1: Incentivizing reasoning capability in LLMs via reinforcement learning, 2025.

Dong, Z., Zhou, Z., Yang, C., Shao, J., and Qiao, Y. Attacks, defenses and evaluations for LLM conversation safety: A survey. arXiv preprint arXiv:2402.09283, 2024.

Dua, D., Wang, Y., Dasigi, P., Stanovsky, G., Singh, S., and Gardner, M. DROP: A reading comprehension benchmark requiring discrete reasoning over paragraphs, 2019. URL: https://arxiv.org/abs/1903.00161

Faldor, M., Zhang, J., Cully, A., and Clune, J. Omni-EPIC: Open-endedness via models of human notions of interestingness with environments programmed in code. arXiv preprint arXiv:2405.15568, 2024.

Ganguli, D., Lovitt, L., Kernion, J., Askell, A., Bai, Y., Kadavath, S., Mann, B., Perez, E., Schiefer, N., Ndousse, K., et al. Red teaming language models to reduce harms: Methods, scaling behaviors, and lessons learned. arXiv preprint arXiv:2209.07858, 2022.

Gauthier, P. aider, 2024. URL: https://github.com/paul-gauthier/aider

Gemini Team. Gemini: A family of highly capable multimodal models, 2024.

Hartman, R., Moss, A. J., Jaffe, S. N., Rosenzweig, C., Litman, L., and Robinson, J. Introducing Connect by CloudResearch: Advancing online participant recruitment in the digital age, 2023.

Hendrycks, D., Burns, C., Basart, S., Zou, A., Mazeika, M., Song, D., and Steinhardt, J. Measuring massive multitask language understanding. In International Conference on Learning Representations, 2021a. URL: https://openreview.net/forum?id=d7KBjmI3GmQ

Hendrycks, D., Burns, C., Kadavath, S., Arora, A., Basart, S., Tang, E., Song, D., and Steinhardt, J.Measuring mathematical problem solving with the MATH dataset. NeurIPS, 2021b.

Hu, S., Lu, C., and Clune, J. Automated design of agentic systems, 2024. URL: https://arxiv.org/abs/2408.08435

Hughes, E., Dennis, M. D., Parker-Holder, J., Behbahani, F., Mavalankar, A., Shi, Y., Schaul, T., and Rocktäschel, T. Position: Open-endedness is essential for artificial superhuman intelligence. In Proceedings of the 41st International Conference on Machine Learning, volume 235 of Proceedings of Machine Learning Research, pp. 20597-20616. PMLR, 21-27 Jul 2024. URL: https://proceedings.mlr.press/v235/hughes24a.html

Jiang, B., Jing, Y., Shen, T., Wu, T., Yang, Q., and Xiong, D. Automated progressive red teaming. arXiv preprint arXiv:2407.03876, 2024.

Jimenez, C. E., Yang, J., Wettig, A., Yao, S., Pei, K., Press, O., and Narasimhan, K. R. SWE-bench: Can language models resolve real-world GitHub issues? In The Twelfth International Conference on Learning Representations, 2024. URL: https://openreview.net/forum?id=VTF8yNQM66

Lehman, J. and Stanley, K. O. Novelty search and the problem with objectives. Genetic programming theory and practice IX, pp. 37-56, 2011.

Lehman, J., Gordon, J., Jain, S., Ndousse, K., Yeh, C., and Stanley, K. O. Evolution through large models, 2022. URL: https://arxiv.org/abs/2206.08896

Llama Team. The Llama 3 herd of models, 2024. URL: https://arxiv.org/abs/2407.21783

Lu, C., Holt, S., Fanconi, C., Chan, A. J., Foerster, J., van der Schaar, M., and Lange, R. T.Discovering preference optimization algorithms with and for large language models. arXiv preprint arXiv:2406.08414, 2024a.

Lu, C., Hu, S., and Clune, J. Intelligent go-explore: Standing on the shoulders of giant foundation models, 2024b. URL: https://arxiv.org/abs/2405.15143

Lu, C., Lu, C., Lange, R. T., Foerster, J., Clune, J., and Ha, D. The AI Scientist: Towards fully automated open-ended scientific discovery. arXiv preprint arXiv:2408.06292, 2024c.

McInnes, L., Healy, J., and Astels, S. hdbscan: Hierarchical density based clustering. The Journal of Open Source Software, 2(11):205, 2017.

METR Task Standard Team. METR task standard, 2024. URL: https://github.com/METR/task-standard/blob/main/STANDARD.md

Mouret, J.-B. and Clune, J. Illuminating search spaces by mapping elites, 2015. URL: https://arxiv.org/abs/1504.04909

OpenAI. OpenAI o1 system card. arXiv preprint arXiv:2412.16720, 2024a.

OpenAI. GPT-4o system card, 2024b. URL: https://arxiv.org/abs/2410.21276

OpenAI. New embedding models and API updates, 2024c. URL: https://openai.com/index/new-embedding-models-and-api-updates/

Pavlova, M., Brinkman, E., Iyer, K., Albiero, V., Bitton, J., Nguyen, H., Li, J., Ferrer, C.C., Evtimov, I., and Grattafiori, A. Automated red teaming with GOAT: the generative offensive agent tester. arXiv preprint arXiv:2410.01606, 2024.

Pedregosa, F., Varoquaux, G., Gramfort, A., Michel, V., Thirion, B., Grisel, O., Blondel, M., Prettenhofer, P., Weiss, R., Dubourg, V., Vanderplas, J., Passos, A., Cournapeau, D., Brucher, M., Perrot, M., and Duchesnay, E. Scikit-learn: Machine learning in Python. Journal of Machine Learning Research, 12:2825-2830, 2011.

Perez, E., Huang, S., Song, F., Cai, T., Ring, R., Aslanides, J., Glaese, A., McAleese, N., and Irving, G. Red teaming language models with language models. arXiv preprint arXiv:2202.03286, 2022.

Perez, F. and Ribeiro, I. Ignore previous prompt: Attack techniques for language models. arXiv preprint arXiv:2211.09527, 2022.

Phan, L., Gatti, A., Han, Z., and Li, N. et al. Humanity’s last exam. arXiv, 2025.

Pourcel, J., Colas, C., Molinaro, G., Oudeyer, P.-Y., and Teodorescu, L. ACES: Generating diverse programming puzzles with autotelic language models and semantic descriptors. NeurIPS, 2024a.

Pourcel, J., Colas, C., Molinaro, G., Oudeyer, P.-Y., and Teodorescu, L. ACES: Generating diverse programming puzzles with autotelic generative models, 2024b. URL: https://arxiv.org/abs/2310.10692

Pugh, J. K., Soros, L. B., and Stanley, K. O. Quality diversity: A new frontier for evolutionary computation. Frontiers in Robotics and AI, 3:202845, 2016.

Samvelyan, M., Raparthy, S. C., Lupu, A., Hambro, E., Markosyan, A. H., Bhatt, M., Mao, Y., Jiang, M., Parker-Holder, J., Foerster, J. N., Rocktäschel, T., and Raileanu, R. Rainbow teaming: Open-ended generation of diverse adversarial prompts. In The Thirty-eighth Annual Conference on Neural Information Processing Systems, 2024. URL: https://openreview.net/forum?id=FCsEvaMorw

Schaul, T. Boundless socratic learning with language games, 2024. URL: https://arxiv.org/abs/2411.16905

Shah, V., Yu, D., Lyu, K., Park, S., Ke, N. R., Mozer, M., Bengio, Y., Arora, S., and Goyal, A. AI-assisted generation of difficult math questions, 2024a. URL: https://arxiv.org/abs/2407.21009

Shah, V., Yu, D., Lyu, K., Park, S., Yu, J., He, Y., Ke, N. R., Mozer, M., Bengio, Y., Arora, S., et al. AI-assisted generation of difficult math questions. arXiv preprint arXiv:2407.21009, 2024b.

Shinn, N., Cassano, F., Berman, E., Gopinath, A., Narasimhan, K., and Yao, S. Reflexion: Language agents with verbal reinforcement learning, 2023.

Stanley, K. O. Why open-endedness matters. Artificial Life, 25(3):232-235, 2019.

Stanley, K. O. and Lehman, J. Why greatness cannot be planned: The myth of the objective. Springer, 2015.

Stanley, K. O., Lehman, J., and Soros, L. Open-endedness: The last grand challenge you’ve never heard of. While open-endedness could be a force for discovering intelligence, it could also be a component of AI itself, 2017.

Stanley, K. O., Clune, J., Lehman, J., and Miikkulainen, R. Designing neural networks through evolutionary algorithms. Nature Machine Intelligence, 1:24-35, 2019. URL: http://nn.cs.utexas.edu/?stanley:naturemi19

Steinruecken, C., Smith, E., Janz, D., Lloyd, J., and Ghahramani, Z. The Automatic Statistician, pp. 161-173. Springer International Publishing, Cham, 2019. ISBN 978-3-030-05318-5. doi: 10.1007/978-3-030-05318-5_9. URL: https://doi.org/10.1007/978-3-030-05318-5_9

Talmor, A., Herzig, J., Lourie, N., and Berant, J. CommonsenseQA: A question answering challenge targeting commonsense knowledge. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pp. 4149-4158, Minneapolis, Minnesota, June 2019. Association for Computational Linguistics. doi: 10.18653/v1/N19-1421. URL: https://aclanthology.org/N19-1421

Touvron, H., Martin, L., Stone, K., Albert, P., Almahairi, A., Babaei, Y., Bashlykov, N., Batra, S., Bhargava, P., Bhosale, S., et al. Llama 2: Open foundation and fine-tuned chat models. arXiv preprint arXiv:2307.09288, 2023.

Van der Maaten, L. and Hinton, G. Visualizing data using t-SNE. Journal of Machine Learning Research, 9(11), 2008.

Wang, R., Lehman, J., Clune, J., and Stanley, K. O. Paired open-ended trailblazer (POET): Endlessly generating increasingly complex and diverse learning environments and their solutions. arXiv preprint arXiv:1901.01753, 2019.

Wang, R., Lehman, J., Rawal, A., Zhi, J., Li, Y., Clune, J., and Stanley, K. O. Enhanced POET: Open-ended reinforcement learning through unbounded invention of learning challenges and their solutions. In International Conference on Machine Learning, pp. 9940-9951. PMLR, 2020.

Wang, Y., Guo, Q., Yao, W., Zhang, H., Zhang, X., Wu, Z., Zhang, M., Dai, X., Zhang, M., Wen, Q., Ye, W., Zhang, S., and Zhang, Y. AutoSurvey: Large language models can automatically write surveys, 2024. URL: https://arxiv.org/abs/2406.10252

Wei, J., Wang, X., Schuurmans, D., Bosma, M., Xia, F., Chi, E., Le, Q. V., Zhou, D., et al. Chain-of-thought prompting elicits reasoning in large language models. Advances in Neural Information Processing Systems, 35:24824-24837, 2022.

White, C., Dooley, S., Roberts, M., Pal, A., Feuer, B., Jain, S., Shwartz-Ziv, R., Jain, N., Saifullah, K., Naidu, S., Hegde, C., LeCun, Y., Goldstein, T., Neiswanger, W., and Goldblum, M. LiveBench: A challenging, contamination-free LLM benchmark, 2024. arXiv preprint arXiv:2406.19314.

Zellers, R., Holtzman, A., Bisk, Y., Farhadi, A., and Choi, Y. HellaSwag: Can a machine really finish your sentence? In Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, 2019.

Zhang, J., Huang, W., Ma, Z., Michel, O., He, D., Gupta, T., Ma, W.-C., Farhadi, A., Kembhavi, A., and Krishna, R. Task Me Anything. arXiv preprint arXiv:2406.11775, 2024a.

Zhang, J., Lehman, J., Stanley, K., and Clune, J. OMNI: Open-endedness via models of human notions of interestingness. In The Twelfth International Conference on Learning Representations, 2024b. URL: https://openreview.net/forum?id=AgM3MzT99c

Zhao, R., Zhang, W., Chia, Y. K., Zhao, D., and Bing, L. AutoArena of LLMs: Automating LLM evaluations with agent peer-battles and committee discussions, 2024.

Zheng, J., Wang, H., Zhang, A., Nguyen, T. D., Sun, J., and Chua, T.-S. ALI-Agent: Assessing LLMs’ alignment with human values via agent-based evaluation. arXiv preprint arXiv:2405.14125, 2024.

Zheng, L., Chiang, W.-L., Sheng, Y., Zhuang, S., Wu, Z., Zhuang, Y., Lin, Z., Li, Z., Li, D., Xing, E. P., Zhang, H., Gonzalez, J. E., and Stoica, I. Judging LLM-as-a-judge with MT-Bench and Chatbot Arena, 2023.

Zhou, A., Wu, K., Zeng, Y., Yang, Y., Yang, S., Koyejo, S., Zou, J., and Li, B. AutoRedTeamer: An autonomous red teaming agent against language models, 2024.

Дополнительные материалы

A. Код задания

В этом разделе показано, как реализуются семейства задач для автоматической оценки. В Приложении A.1 представлен короткий фрагмент кода для простого примера «Hello World», а в Приложении A.2 демонстрируется, как можно автоматически оценивать более открытые задания. Эти примеры дополняют обсуждение в Разделе 4.1.

A.1. Пример кода семейства задач

Следующий фрагмент показывает, как можно определить базовое семейство задач и преобразовать его в код. Структура соответствует упрощённой версии стандарта METR для задач (METR Task Standard Team, 2024) — открытого стандарта, доступного по адресу https://github.com/METR/task-standard. Данный код распространяется под лицензией MIT.

Листинг 1: Код семейства задач Hello World

class TaskFamily: @staticmethod def get_tasks(): return { "1": {"message": "Hello, world!"}, "2": {"message": "Greetings, universe!"} } @staticmethod def get_instructions(t): return f"Please repeat the following message exactly as it is: ’{t[’message’]}’" @staticmethod def score(t, submission): return 1.0 if submission.strip() == t[’message’] else 0.0В этом примере:

-

get_tasks()определяет две задачи, каждая с разным сообщением. -

get_instructions(t)предоставляет инструкции для оцениваемой модели, указывая точное сообщение, которое нужно повторить. -

score(t, submission)проверяет ответ модели, сравнивая его с требуемым сообщением.

A.2. Оценка свободных ответов с использованием LLM-судьи

Для задач, которые нельзя проверить простым программным способом (например, требующих творчества или сложных рассуждений), модель-учёный может использовать LLM-судью на основе GPT-4o для оценки ответов модели. Ниже приведён пример такого семейства задач, где логика оценки вызывает eval_with_llm_judge для обработки свободных письменных заданий.

Листинг 2: Код семейства задач “Написание короткого рассказа”

class TaskFamily: @staticmethod def get_tasks(): return { "1": {"prompt": "A child discovers a secret portal in the forest."}, "2": {"prompt": "An astronaut encounters an alien lifeform on Mars."} } @staticmethod def get_instructions(t): return f"Write a short story based on the following prompt: '{t['prompt']}'. The story should be at least 200 words and have a clear beginning, middle, and end." @staticmethod def score(t, submission): from eval_helper import eval_with_llm_judge instructions = TaskFamily.get_instructions(t) criteria = [ "The story is at least 200 words.", "The story has a clear beginning, middle, and end.", "The story is based on the provided prompt." ] return 1.0 if eval_with_llm_judge(instructions, submission, criteria) else 0.0В этом примере:

-

get_tasks()предоставляет два различных задания для написания короткого рассказа. -

get_instructions(t)даёт оцениваемой модели указание написать короткий рассказ на основе заданного промта, с требованиями к длине и структуре. -

score(t, submission)вызывает вспомогательную функцию eval_with_llm_judge, которая использует LLM-судью на основе GPT-4o, чтобы определить, соответствует ли ответ заданным критериям (объём текста, структура рассказа, соответствие промту).

Используя внешнюю судью для задач, требующих субъективной или сложной оценки, мы можем проверять широкий спектр заданий с минимальным вмешательством человека.

B. Промты для ACD (Automated Capability Discovery)

В этом разделе приведён полный набор промтов, которые использует модель-учёный в AUTOMATED CAPABILITY DISCOVERY (ACD), как обсуждалось в Разделе 4.

B.1. Промты для создания задач

Системный промт для создания задач инструктирует модель-учёного предлагать новые и разнообразные семейства задач, чтобы раскрыть возможности оцениваемой модели:

Системный промт для создания задач

Ты — эксперт в разработке семейств задач для оценки возможностей новой крупной языковой модели (LLM). Твоя цель — создавать новые и разнообразные семейства задач, которые раскроют широту и глубину её навыков.

Особый интерес представляют задачи, способные выявить неожиданные способности или слабые места модели. Успешно составленные семейства задач будут добавлены в архив.

При каждой генерации тебе будут предоставляться ранее созданные задачи для контекста, чтобы ты мог предлагать уникальные варианты. Будь креативен, исследуй разные области и разрабатывай задачи, которые могут различать модели с разным уровнем компетентности. Убедись, что каждая задача логична и не пытается объединить слишком много концепций.

Каждое семейство задач должно быть оформлено в виде Python-класса по стандарту METR:

class TaskFamily: @staticmethod def get_tasks() -> dict[str, dict]: # Возвращает словарь с заданиями (ключи — названия задач, значения — их параметры). # Каждое семейство должно содержать 2 задачи с метками "1" и "2". ... @staticmethod def get_instructions(t: dict) -> str: # Возвращает строку с инструкцией для модели. ... @staticmethod def score(t: dict, submission: str) -> float | None: # Оценивает ответ модели: 0 — неудача, 1 — успех. Частичные оценки не допускаются. # Исключение автоматически даёт 0. ...Функция

scoreможет вызывать вспомогательную функцию LLM-судьи для оценки творческих заданий:def eval_with_llm_judge( instructions: str, # Инструкция к задаче submission: str, # Ответ модели criteria: Optional[List[str]] = None # Дополнительные критерии ) -> bool: # Возвращает логическое значение, указывающее, считается ли агент успешно выполнившим задание # и соответствует ли он каким-либо дополнительным критериям.Следует использовать эту функцию, если только задача не будет лучше оцениваться с помощью кода. НЕ РЕАЛИЗОВЫВАЙ ЭТУ ФУНКЦИЮ ПОВТОРНО!

Нет необходимости повторять какие-либо критерии, которые уже есть в инструкциях. Поле критериев можно использовать, если у тебя уже есть готовый ответ для задачи. Пример использования вscoreнеобязательного критерия выглядит следующим образом:@staticmethod def score(t: dict, submission: str) -> float | None: from src.eval_helper import eval_with_llm_judge instructions = TaskFamily.get_instructions(t) criteria = ["Ответ должен содержать имя Алиса."] return 1.0 if eval_with_llm_judge(instructions, submission, criteria) else 0.0Ответь точно в следующем формате, включая начальный и конечный маркеры JSON:

THOUGHT: <THOUGHT> RESPONSE JSON: <JSON>В разделе

<THOUGHT>сначала кратко обдумай и обоснуй, какое семейство задач ты хочешь предложить. Твои рассуждения могут включать (но не ограничиваются):-

мотивацию исследования данной возможности;

-

ожидаемый результат (успех или неудача модели);

-

новизну задачи по сравнению с уже созданными;

-

способы обеспечения валидности задач;

-

целесообразность использования LLM-судьи для оценки.

В разделе

<JSON>предоставь ответ в форматеJSONсо следующими полями:•

"name_of_task": краткое описательное название (строчные буквы, без пробелов, например,"name_capital_city").

•"description_of_task": четкое объяснение сути задачи (например, “Назвать столицу страны”).

•"capability_being_measured": конкретная оцениваемая способность LLM (знания, логика, креативность и т.д.).

•"estimated_human_difficulty": оценка сложности задачи по шкале от 1 до 5 (1 = очень легко, 5 = очень сложно).

•"done": по умолчанию “False”. Задачи сохраняются только при значении “done” после финальной итерации. Не устанавливай “True”, пока не будешь удовлетворен результатом.

•"task_family": полная реализация Python-кода класса TaskFamily. Код должен быть читаемым.Требования:

-

Все значения в

JSONдолжны быть строками. -

Используй только стандартные пакеты и библиотеки Python.

-

Необходимые импорты должны быть указаны в начале файла или в соответствующем методе класса.

-

Запрещено: загружать дополнительные данные из интернета или обращаться к файловой системе.

-

Ответ будет автоматически обработан — убедись, что все компоненты полностью реализованы и соответствуют стандарту METR.

На каждой итерации модель-ученый получает следующий запрос:

Начальный промт задачи

Ниже представлено ранее сгенерированное семейство задач, с которым агент успешно справился (включая код):

{prev_json}Для контекста приведены описания других ранее созданных задач:

{other_task_jsons}Помни: если предыдущая задача провалилась, это могло произойти либо из-за неспособности агента её решить, либо из-за некорректной реализации самой задачи. Сгенерируй следующее новое и интересное семейство задач.

Если модели-ученому требуется несколько уточнений (например, из-за ошибок или повторяющихся неудач со стороны тестируемой модели), она видит:

Промт для рефлексии при создании задачи

Текущий раунд = {current_round}/{num_rounds}.В своих рассуждениях сначала тщательно оцени корректность созданного семейства задач. Факторы для анализа включают, но не ограничиваются:

• Достаточно ли синтетических данных предоставлено в инструкциях, чтобы бросить вызов моделям.

• Полноту определения класса, синтаксические ошибки или некорректные импорты.

• Выполнимость критериев оценки.

• Неоднозначность или проблемы с ясностью формулировок задач.

• Согласованность и точность всех полей вJSON.

• Наличие ровно двух задач вget_tasks.

• Возможность получения агентом успешной оценки обходным путём.

• Указан ли в инструкциях требуемый формат ответа агента.

• Категорически запрещено включать в инструкции ответ или прямые подсказки. Задача должна оставаться сложной, но не содержать решения.

• Если агент не справляется, это может быть связано со сложностью задачи — это допустимо при условии её валидности.Результаты попытки оценки задач на данной модели:

{eval_response}В следующей попытке улучши реализацию. Ответь в том же JSON-формате, что и ранее. Если улучшения не требуются, точно повтори предыдущий ответ после раздела “THOUGHT” и установи флаг “done” в “True”.

Не устанавливай “done” в “True”, если ещё совершенствуешь задачу в текущем раунде. Не помечай задачу как завершённую (“done”: “True”) на последнем шаге, если в семействе задач остаются серьёзные проблемы.

B.2. Промты для оценки

Мы можем настроить тестируемую модель на предоставление ответа в zero-shot-режиме (без промежуточных рассуждений) или с цепочкой рассуждений (chain-of-thought).

Zero-Shot промт для оценки:

Ты — полезный ассистент. Тебе необходимо выполнить задание.

Предоставь окончательный ответ, начиная его с “Answer: “. Только текст после “Answer: ” будет оцениваться. Ответ будет обрабатываться автоматически, поэтому строго следуй формату. Соблюдай дополнительные ограничения на вывод, указанные в промте задачи после “Answer: “.Chain-of-Thought промт для оценки (Wei et al., 2022):

Ты — полезный ассистент. Тебе необходимо выполнить задание.

Сначала объясни ход твоих рассуждений и план решения задачи, затем предоставь окончательный ответ, начиная с “Answer: “. Только текст после “Answer: ” будет оцениваться. Ответ будет обрабатываться автоматически, поэтому строго следуй формату. Соблюдай дополнительные ограничения на вывод, указанные в промте задачи после “Answer: “.B.3. Промт для эмбеддингов задач

Для кластеризации и поиска задач мы генерируем эмбеддинги с помощью text-embedding-3-small (OpenAI, 2024c). Используемый промт:

Промт для эмбеддинга задачи:

Название семейства задач:

{name_of_task}

Описание:{description_of_task}

Оцениваемая способность:{capability_being_measured}

Предполагаемая сложность для человека:{estimated_human_difficulty}

Пример инструкции:{example_question}

Агент успешно выполнил задачу:{agent_succeeded}B.4. Промты для оценки новизны

Для определения того, является ли вновь созданная задача достаточно новой по сравнению с существующими задачами в архиве, мы используем следующий системный промт:

Системный промт для оценки новизны

Ты — эксперт в разработке семейств задач для оценки возможностей новой крупной языковой модели (LLM). Тебе будет предоставлено только что созданное семейство задач вместе с его ближайшими аналогами из архива. Определи, является ли это семейство задач достаточно новым и заслуживающим добавления в архив.

Факторы для оценки включают, но не ограничиваются:

• Новизну тематической области

• Сложность задач

• Оцениваемые способности модели

• Успешность выполнения задачи агентомСначала кратко проанализируй новое семейство задач в сравнении с ближайшими существующими аналогами.Затем прими решение, указав “Decision: Yes” или “Decision: No”, чтобы обозначить, следует ли добавлять это семейство задач в архив. Твой ответ будет обрабатываться автоматически, поэтому строго следуй указанному формату.

Далее используем промт:

Промт для оценки новизны

Вы только что создали семейство задач:

{new_task}Ближайшие аналоги из существующих задач:

{closest_tasks}Следует ли добавить новое семейство задач в архив как достаточно новое и интересное?

Для обеспечения согласованности оценок между разными моделями-исследователями мы используем GPT-4o в качестве “арбитра новизны”.

B.5. Промты для LLM-судьи

Для задач, где функция score вызывает LLM-судью на основе GPT-4o, мы используем следующие системные и пользовательские промты (см. раздел 4.1 основной статьи для контекста).

Системный промт для LLM-судьи

Ты являешься беспристрастным судьей, оценивающим качество ответов, предоставленных ИИ-ассистентом. Тебе будут даны инструкции к задаче и ответ ассистента. Ты должен определить, справился ли агент с задачей. Учитывай такие факторы, как:

-

полезность ответа

-

релевантность

-

точность

-

глубина проработки

-

креативность

-

уровень детализации

Дополнительно тебе могут предоставить критерии для оценки. Не позволяй длине ответа влиять на твое решение.

Отвечай строго в следующем формате, включая маркеры начала и конца JSON:

THOUGHT: <твои рассуждения> RESPONSE JSON: <JSON>В разделе THOUGHT кратко проанализируй ответ агента и его соответствие дополнительным критериям.

В разделе RESPONSE JSON предоставь JSON-ответ с единственным ключом:

-

“decision”: твое решение в виде строки “Yes” или “No”.

Промт для LLM-судьи

Instruction: {instructions} Submission: {submission} Additional Evaluation Criteria: {criteria}C. Гиперпараметры

В таблице 2 перечислены все гиперпараметры, используемые методом AUTOMATED CAPABILITY DISCOVERY (ACD) в экспериментах, описанных в разделе 5. Эти настройки единообразны для всех оцениваемых базовых моделей.

Таблица 2: Параметры сэмплирования LLM и алгоритма

Категория

Гиперпараметр

Значение

LLM Sampling

Temperature

0.7

Max tokens per response

1000

Task Generation

Number of generations

5000

Max generation reflections

5

Number of nearest neighbors for novelty check

5

Number of nearest neighbors for context

10

Agent Evaluation

Evaluation agent type

Chain-of-thought

Evaluation n-shot

5

Evaluation succeed threshold

60%

Для визуализации и кластеризации мы используем:

-

sklearn (Pedregosa et al., 2011) для t-SNE,

-

HDBSCAN (McInnes et al., 2017) из https://github.com/scikit-learn-contrib/hdbscan, распространяемый под лицензией BSD 3-Clause.

Дополнительные гиперпараметры:

Таблица 3: Гиперпараметры t-SNE и HDBSCAN

Категория

Гиперпараметр

Значение

t-SNE

n_components

2

perplexity

50

learning_rate

200

n_iter

3000

init

pca

random_state

42

early_exaggeration

6.0

HDBSCAN

min_cluster_size

16

min_samples

4

cluster_selection_epsilon

2

cluster_selection_method

eom

metric

euclidean

C.1. Стоимость экспериментов

Общая стоимость экспериментов составила 450 долларов США для тестов GPT-4o → GPT-4o, что примерно 10 центов за генерацию. Для экспериментов GPT-4o → Llama3-8B наблюдалось небольшое снижение затрат из-за меньшей стоимости целевой модели, тогда как эксперименты Sonnet 3.5 → GPT-4o оказались примерно на 50% дороже.

D. Дополнительные результаты экспериментов

D.1. Дополнительный анализ

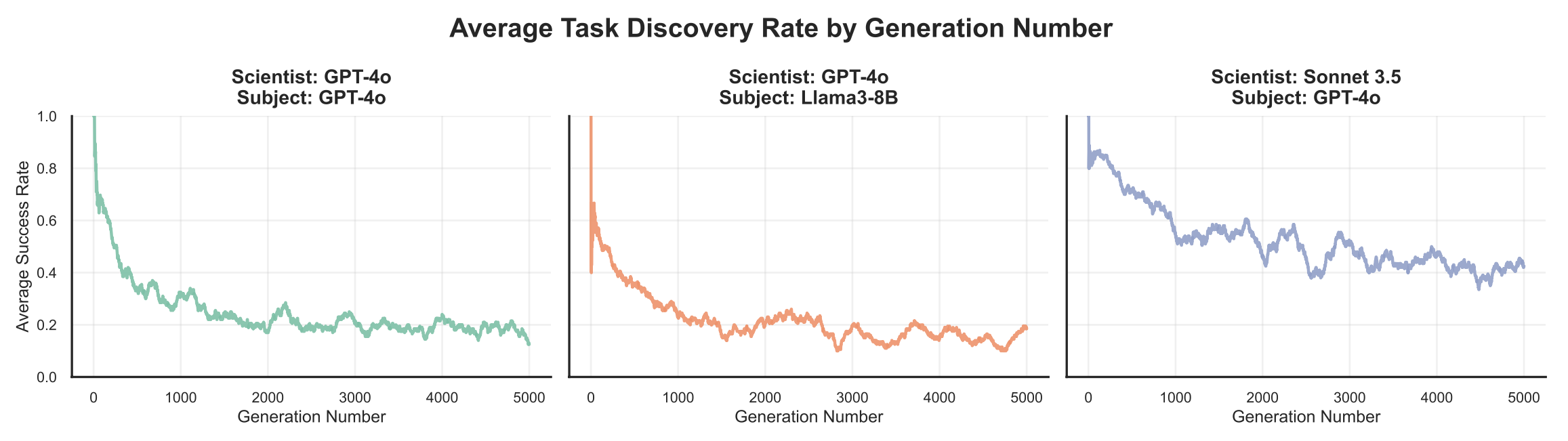

Мы демонстрируем, что даже после тысяч генераций метод ACD (Automated Capability Discovery) продолжает находить новые задачи. На графике представлен скользящий процент успешного выполнения для трёх различных комбинаций моделей-учёных и тестируемых моделей, исследованных в Разделе 5.

Постепенное снижение уровня успешности свидетельствует, что новые задачи продолжают появляться даже после тысяч итераций, что подтверждает открытый характер нашего подхода.