В последние годы исследования по моделированию экономического поведения с использованием искусственного интеллекта (ИИ) набирают обороты. Особенно интересен вопрос: насколько большие языковые модели (LLM) способны имитировать поведение людей в классических экономических экспериментах. В данной статье анализируется, как современные LLM решают задачу кейнсианского конкурса красоты и как их результаты отличаются от экспериментов с реальными людьми в работах Nagel (1995) и Grosskopf & Nagel (2008).

Почему это важно?

Эксперименты типа «кейнсианского конкурса красоты» являются краеугольным камнем для анализа поведения агентов в условиях неопределённости. Классическая постановка задачи предполагает, что участники должны выбрать число, стараясь предугадать, какое число окажется ближе всего к определённой функции от выборов всех участников (например, к двум третям среднего). Поведение игроков демонстрирует не только их рациональные ожидания, но и степень итеративного рассуждения – то есть, насколько глубоко они пытаются предугадать мысли своих оппонентов.

Несмотря на то, что эксперименты с участием людей уже проводились (Nagel, 1995); Grosskopf & Nagel, 2008)), вопросы когнитивного соответствия LLM остаются открытыми. Могут ли современные языковые модели не только принимать решения, похожие на человеческие, но и демонстрировать особенности итеративного рассуждения, характерного для участников таких игр?

Кейнсианский конкурс красоты: постановка задачи и примеры

Что такое кейнсианский конкурс красоты?

Это эксперимент, в котором участникам предлагают выбрать число, зачастую в диапазоне от 0 до 100. Победителем становится тот, чьё число оказывается ближе всего к заранее определённой доле (например, 2/3) от среднего выбора всех участников. Такая игра иллюстрирует, как участники пытаются предугадать не только поведение других, но и их предположения о поведении остальных.

Пример игры:

Представьте, что 10 участников выбирают число. Если среднее арифметическое равно 60, то выигрышное число будет 2/3 × 60= 40. Выигрывает тот, кто выбрал число, наиболее близкое к 40.

При этом возникает вопрос: какие стратегии выгодны?

Классический вывод заключается в том, что рациональный игрок должен выбрать число, которое в идеале стремится к нулю. Однако эмпирические исследования показывают, что люди не следуют строго этой логике, демонстрируя «среднее» поведение – их выбор оказывается ближе к экспериментально наблюдаемым средним значениям, чем к теоретическому равновесию.

Обзор эмпирических исследований

Ряд работ посвящён анализу поведения участников в подобных экспериментах. Например, Nagel (1995) и Grosskopf & Nagel (2008) провели эксперименты с участием студентов и специалистов, результаты можно свести в таблицу:

|

Статья |

Участники игры |

Средний ответ |

|---|---|---|

|

Grosskopf & Nagel (2008) |

Студенты 1 курса бакалавриата |

35.57 |

|

Grosskopf & Nagel (2008) |

Участники конференций по экономике и психологии принятия решений |

21.73 |

|

Grosskopf & Nagel (2008) |

Студенты 1 курса бакалавриата |

29.31 |

|

Grosskopf & Nagel (2008) |

Участники конференций по теории игр |

18.98 |

|

Nagel (1995) |

Студенты бакалавриата |

27.05 |

|

Nagel (1995) |

Студенты бакалавриата |

36.73 |

Эти результаты демонстрируют, что человеческие участники в среднем выбирают числа, значительно отличающиеся от равновесия (0).

Эксперимент: репликация задачи с использованием LLM

Идея этого эксперимента заключается в том, чтобы проверить, насколько LLM способны имитировать решения экономических агентов в условиях кейнсианского конкурса красоты. В частности, мы реплицируем задание, предложенное участникам в классических экспериментах, и анализируем ответы, полученные от различных моделей. У нас с коллегами есть препринт с другой версией работы, в которой проведено сравнение других моделей с результатами большего числа эмпирических исследований.

Выбранные модели

Для этого поста были протестированы следующие модели:

-

meta-llama/llama-3.1-405b-instruct -

meta-llama/llama-3.3-70b-instruct -

meta-llama/llama-3.2-3b-instruct -

meta-llama/llama-3-8b-instruct -

deepseek/deepseek-r1-distill-llama-70b -

deepseek/deepseek-r1 -

google/gemini-2.0-flash-001 -

openai/gpt-4 -

openai/o3-mini-high -

anthropic/claude-3.7-sonnet -

mistralai/mistral-large-2411

Я выбрал модели разных размеров и от различных провайдеров, чтобы оценить, как размер и архитектурные особенности моделей влияют на их способность имитировать поведение реальных экономических агентов. Выбирались модели, доступные на OpenRouter. К каждой модели делалось 5 запросов (хорошо бы по 50-100), каждый запрос был сделан с нуля, без передачи предыщей истории в контексте, чтобы избежать эффекта обучения.

Основные метрики

В таблице ниже приведены результаты эксперимента: Для оценки ответов моделей были рассчитаны две метрики:

-

MM (model mean) – среднее значение, выбранное моделью.

-

MM_PM (model mean – paper mean) – разница между средним, полученным от модели, и экспериментальными результатами, полученными в работах Nagel (1995) и Grosskopf & Nagel (2008).

|

Модель |

MM_PM (*) |

MM |

|---|---|---|

|

openai/o3-mini-high |

-26.1 |

2.13 |

|

deepseek/deepseek-r1-distill-llama-70b |

-22.0 |

6.27 |

|

meta-llama/llama-3.3-70b-instruct |

-21.7 |

6.5 |

|

deepseek/deepseek-r1 |

-20.3 |

7.93 |

|

openai/gpt-4 |

-17.5 |

10.7 |

|

mistralai/mistral-large-2411 |

-16.9 |

11.4 |

|

google/gemini-2.0-flash-001 |

-14.3 |

13.9 |

|

anthropic/claude-3.7-sonnet |

-13.9 |

14.4 |

|

meta-llama/llama-3.1-405b-instruct |

-4.83 |

23.4 |

|

meta-llama/llama-3.2-3b-instruct |

10.1 |

38.3 |

|

meta-llama/llama-3-8b-instruct |

17.7 |

45.9 |

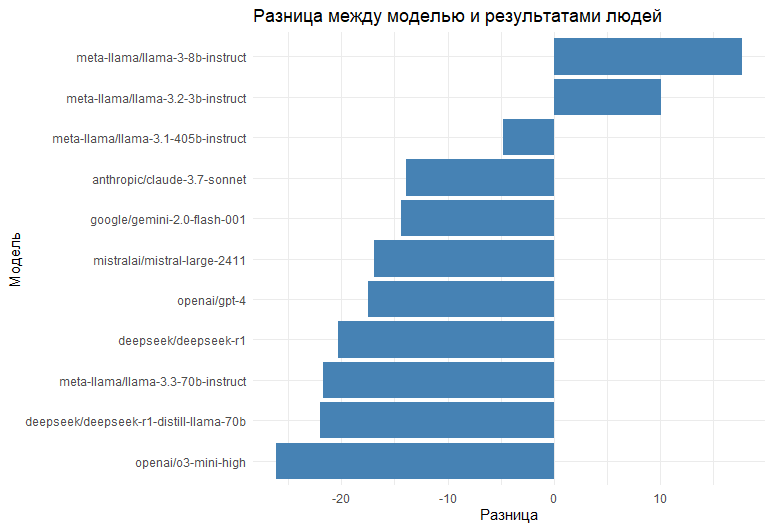

Талица отсортирована по MM_PM. Вот эта же метрика в виде графика:

-

В экспериментах модель meta-llama/llama-3.1-405b-instruct показала наименьшее отклонение (–4.83) от результатов классических экспериментов , что говорит о её близости к выборкам реальных участников. Другими словами, её среднее значение (23.4) соответствует поведению людей, демонстрируя, как человеческие решения отклоняются от теоретически рационального в пользу «среднего» решения.

-

С другой стороны, модель openai/o3-mini-high выдала средний ответ всего 2.13, что практически совпадает с теоретическим равновесием – нулём.

Выводы

Этот эксперимент продемонстрировал, что современные LLM способны имитировать поведение экономических агентов в условиях кейнсианского конкурса красоты. Модели демонстрируют итеративное рассуждение, приближаясь к средним результатам, наблюдаемым в экспериментах с участием людей. Интересно, что модели, ориентированные на reasoning, демонстрируют результаты, близкие к нулю – теоретически оптимальному решению.

Буду рад комментариям!

Автор: pparshakov