HUNYUAN-T1. Tencent наносит ответный удар

Когда-нибудь задумывались, почему большинство моделей ИИ либо умные, ЛИБО быстрые, но никогда не сочетают оба качества? Над этим подумали в Tencent.

Tencent только что перевернул эту парадигму с Hunyuan-T1 [1] – ПЕРВОЙ в мире ультра-супер-сверхбольшой моделью, использующей гибридную архитектуру Transformer + Mamba MoE [2].

Tencent – это огромный китайский конгломерат, подмявший индустрию разработки видеоигр и кучу всего еще (социальные сети, мессенджеры, финтех, инвестиции…). Tencent предпочитает лишний раз не светиться. Вы наверняка играли в какие-то игры, курируемые в Tencent, и даже не знаете об этом. Короче, эти ребята могут потянуть очень дорогие и жесткие проекты.

Давайте перейдем к технике.

Mamba заменяет квадратичную сложность масштабирования классических трансформерных архитектур на линейную сложность, зависящую от длины ввода. Вычисления фокусируются только на релевантных кусках входящей последовательности, используя контекстно-зависимые переходы между состояниями. В случае T1, это дает двухкратное ускорение и обработку контекстов длиной 256 тысяч токенов без падения производительности и сообразительности.

256 тысяч позволяет обрабатывать документы масштаба “Войны и Мир” Льва Толстого (587 287 слов). Наконец-то мы узнаем смысл дихотомии, почему Болконский, при смерти на Аустерлице, видит бесконечное небо, а Пьер Безухов находит просветление в плену среди простых солдат.

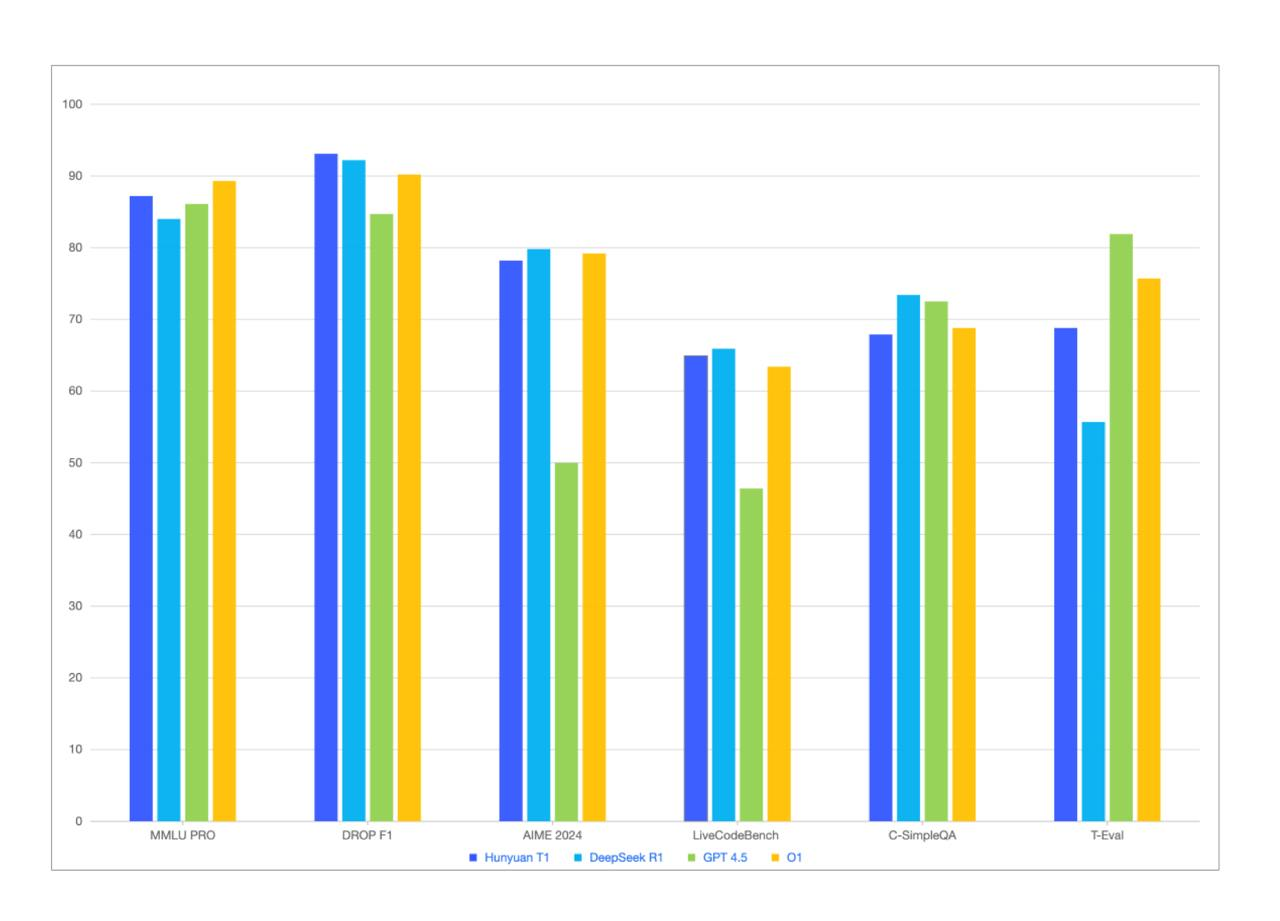

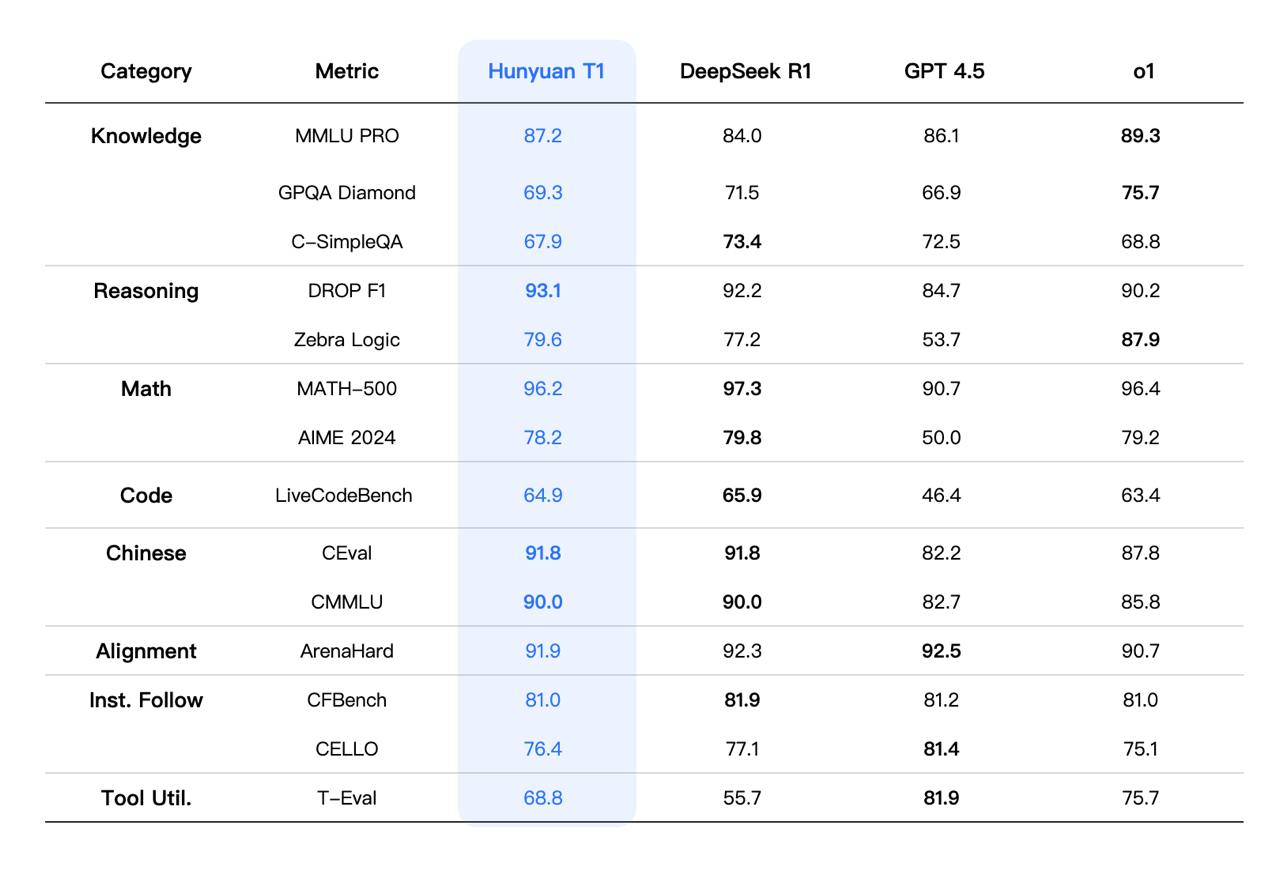

Это не просто очередной запуск ИИ. T1 буквально пристыдил другие модели по ключевым показателям – набрав 87.2 в тесте MMLU-Pro [3] и чудовищные 96.2 в MATH-500 [4].

На всякий случай, MMLU-Pro – это тест на понимание, ризонинг, многоэтапные рассуждения, в котором кроме математики [5] есть еще всякое разное. MATH-500 – это про то, насколько крут школьник старших классов – алгебра, геометрия, вычисления.

Tencent направили 96.7% своих вычислительных мощностей на обучение [6] с подкреплением [7]. Пока все остальные спорят о методах предтрейна, Tencent сосредоточились на том, что действительно важно – улучшении способности модели мыслить.

Результаты? Первый символ ответа через ОДНУ СЕКУНДУ. Скорость обработки 60-80 токенов в секунду. Это В ДВА РАЗА быстрее предыдущих моделей при тех же вычислительных ресурсах.

Минусы? Засилие китайского языка в ответах, и очень старая база знаний (какие-то куски точно не обновлялись с 2023 года). Самый простой способ “бороться” с китайским языком – начиная с первого же промпта явно указать, какой язык для тебя основной. Например, “переводи все ответы на английский язык”.

Цены? Всего 1 юань за миллион входных токенов и 4 юаня за миллион выходных токенов. Это достаточно символическая стоимость – ВСЕГО 1 ЮАНЬ. Иначе говоря, это 11,57 рубля за миллион входа и 46.3 рублей за миллион выхода.

Это практически совпадает с DeepSeek R1, но значительно превосходит его по производительности. То есть, это все еще в 273 раза дешевле, чем ChatGPT.

(Если докопаться, то у R1 есть крутые скидки в “непопулярное” время суток, а здесь про такие скидки пока ничего нет. Но надеюсь, будет. Китайцы умеют конкурировать.)

Это не просто обновление – это демонстрация всей индустрии ИИ того, что рассуждающие модели – не забавная игрушка, это ПРОМЫШЛЕННОЕ РЕШЕНИЕ.

Гонка вооружений в сфере ИИ только что стала интереснее.

Telegram: @1red2black [8]

Автор: olegchir

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13550

URLs in this post:

[1] Hunyuan-T1: https://llm.hunyuan.tencent.com/#/blog/hy-t1?lang=en

[2] Mamba MoE: https://arxiv.org/abs/2401.04081

[3] MMLU-Pro: https://github.com/TIGER-AI-Lab/MMLU-Pro

[4] MATH-500: https://huggingface.co/datasets/HuggingFaceH4/MATH-500

[5] математики: http://www.braintools.ru/article/7620

[6] обучение: http://www.braintools.ru/article/5125

[7] подкреплением: http://www.braintools.ru/article/5528

[8] @1red2black: https://t.me/tg_1red2black

[9] Источник: https://habr.com/ru/companies/bar/articles/894370/?utm_campaign=894370&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.