Как дистилляция меняет индустрию искусственного интеллекта

Всем привет! Меня зовут Миша, я руковожу центром R&D Big Data в МТС Диджитал. В прошлый раз делился с вами подборкой книг по базам данных [1]. Сегодня хочу обсудить, как дистилляция влияет на индустрию ИИ.

Крупнейшие компании в области ИИ, включая OpenAI, Microsoft и Meta, используют технологию дистилляции — это позволяет им задействовать меньше ресурсов для разработки мощных языковых моделей. Конечно, дистилляция не новинка. Но игроки ИИ-отрасли особенно заинтересовались ею, как только китайская компания DeepSeek создала с ее помощью производительные модели на основе открытых решений конкурентов.

Последствия проявились сразу. После анонса DeepSeek R1 фондовый рынок США потерял [2] за несколько дней свыше 1 трлн $. О причинах тут уже писали [3] — китайцы заявили, что на обучение [4] ушло всего 5,6 млн $. Потом стали известны нюансы, и эту цифру поставили под сомнение. Но в любом случае успех DeepSeek привел к внимательному изучению технологий, используемых китайской компанией, игроками отрасли. Обо всем этом и поговорим в посте.

Что такое дистилляция и как она работает

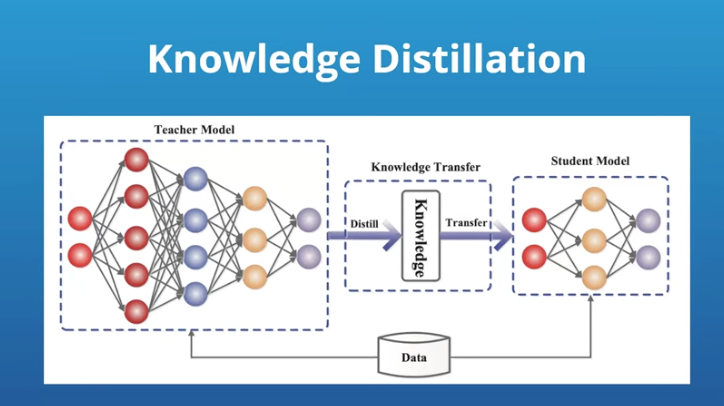

На Хабре уже не раз и не два описывалась [5] эта технология, поэтому кратко. Суть в том, что уже готовая большая языковая модель (Large Language Model, LLM), называемая «учителем» (teacher model), используется [6] для обучения более компактной модели — «студента» (student model). Во время этого процесса учительская модель генерирует выходные данные (например, вероятностные распределения слов, скрытые представления или логиты), которые потом используются для обучения студенческой модели. Цель в том, чтобы «студент» научился воспроизводить предсказания учителя, но при этом работал с меньшими вычислительными затратами, сохраняя приемлемый уровень точности. Конечно, все очень упрощенно.

Метод позволяет разработчикам создавать компактные модели, которые требуют меньше вычислительных мощностей, дешевле в разработке и поддержке, но при этом сохраняют ключевые возможности «предков».

DeepSeek: китайский вызов для OpenAI, Microsoft и Meta

Яркий пример успешного создания ИИ-моделей посредством дистилляции — проекты китайской компании DeepSeek, которая взяла [8] за основу открытые решения Meta и Alibaba. Оценки стоимости развертывания инфраструктуры и обучения R1 разнятся. Но это дела не меняет, ведь в итоге не слишком известный стартап внезапно стал одним из лидеров гонки ИИ-технологий. Глядя на этот успешный успех, они задумались о более масштабном использовании дистилляции и OpenAI, Microsoft вместе с Meta. И это правильно, ведь, как я уже писал выше, технология позволяет снизить затраты на разработку и повысить доступность ИИ для бизнеса и пользователей.

Для корпораций, какими бы богатыми они ни были, экономия — один из ключевых вопросов. Разработка и поддержка больших языковых моделей вроде GPT-4, Gemini или Llama требуют огромных объемов данных и вычислительных мощностей. Хотя компании не раскрывают точные затраты на обучение таких моделей, по оценкам экспертов [9], это сотни миллионов $.

А вот благодаря дистилляции компании могут разрабатывать мощные и продвинутые модели уже за миллионы $, а не десятки или сотни. Доступ к таким моделям обойдется конечному пользователю в гораздо меньшую цену, чем в случае того же ChatGPT. Это открывает путь для небольших стартапов и разработчиков приложений, которые могут встраивать искусственный интеллект [10] в свои продукты без необходимости тратить миллионы $ на вычисления.

Крупный бизнес постепенно осознает преимущества такого подхода. Microsoft активно использует этот метод: ее инвестиции в OpenAI позволили создать линейку малых языковых моделей Phi [11], дистиллированных из GPT-4. Сейчас дистилляция уже не просто экспериментальная технология, а часть коммерческой стратегии крупнейших игроков индустрии.

Дистилляция не панацея

Несмотря на все преимущества, у технологии есть и недостатки. Компактные модели обычно специализируются на конкретных задачах и не обладают универсальностью своих «учителей». Например, малая модель может отлично справляться с резюмированием писем, при этом будет значительно хуже в решении сложных математических или логических задач. У обычных LLM такой проблемы нет — они хороши буквально во всем.

Как отмечает [8] Ахмед Авадалла из Microsoft Research, уменьшение размера модели неизбежно приводит к сужению ее возможностей. Так создается ситуация, когда разработчикам приходится выбирать между желанием сэкономить и универсальностью модели. Крупные компании стараются снизить стоимость доступа к своим сервисам, ведь, если пользователи начнут отдавать предпочтение дистиллированным версиям, хотя и узкоспециализированным, это уменьшит общий уровень прибыли корпораций.

Сейчас идет тренд на разделение «рынка труда» для больших и малых моделей. По мнению [8] Оливье Годемана из OpenAI, LLM будут оставаться востребованными в тех случаях, когда нужна высокая точность и надежность. К тому же именно большие модели позволяют открывать новые возможности, которые могут быть дистиллированы в более компактные узкоспециализированные версии.

Есть и еще одна проблема с дистилляцией. Вероятно, разработчики малых языковых моделей тренируют их на готовых данных LLM корпораций. Та же OpenAI обвинила [12] DeepSeek в том, что китайцы применяли ее данные для дистилляции, а это нарушает условия использования. Пока что DeepSeek не дает официальных комментариев по этому поводу.

OpenAI отслеживает использование своих ИИ-систем и может блокировать аккаунты, замеченные в сборе большого объема данных для обучения конкурирующих моделей. Именно такие ограничения, по словам OpenAI [13], были применены к ряду аккаунтов, связанных с DeepSeek. Но эти меры часто принимаются постфактум, когда ущерб уже нанесен.

То есть возникла серьезная угроза для бизнеса лидеров рынка — корпорации, которые инвестируют миллиарды в разработку передовых моделей, сталкиваются с конкурентами, взявшими за основу своих проектов чужие технологии.

Открытые модели и влияние дистилляции на индустрию

Дистилляция стимулирует развитие движения за открытость технологий искусственного интеллекта. Та же DeepSeek сделала свои последние модели доступными для разработчиков. Проекты компании могут свободно использоваться [14] и дорабатываться в соответствии с лицензией MIT, хотя данные для обучения не предоставляются. Этот тренд поддерживают игроки отрасли. Главный научный [15] сотрудник Meta по ИИ Янн Лекун отметил [16], что дистилляция отлично вписывается в концепцию Open Source: «Вы получаете выгоду от работы всех, если процессы остаются открытыми».

Одновременно возникла проблема оправданности вложений миллиардов $ в масштабные проекты. Как отмечает [8] Дэвид Кокс из IBM, современная индустрия ИИ движется с невероятной скоростью: можно вложить огромные суммы в развитие модели, а затем обнаружить, что конкуренты готовы предложить аналогичный продукт, потратив на порядок меньше.

Что в итоге? Технология хороша, она позволяет разрабатывать отличные модели за относительно небольшие деньги. Но в то же время создает вызовы для ведущих игроков рынка, ставя под угрозу их бизнес-модели. Гонка за превосходство в сфере ИИ становится еще более жесткой, и крупнейшим компаниям придется искать новые способы защиты разработок и удержания лидерства [17].

А что вы думаете о технологии дистилляции? Используете ли ее в своей собственной работе и считаете ли ее опасной для бизнеса? Пишите в комментариях.

Автор: Michail_Stepnov

Источник [18]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13523

URLs in this post:

[1] подборкой книг по базам данных: https://habr.com/ru/companies/ru_mts/articles/884678/

[2] потерял: https://rg.ru/2025/01/27/akcii-tehnogigantov-v-ssha-upali-na-trillion-dollarov-iz-za-kitajskogo-startapa.html

[3] писали: https://habr.com/ru/companies/ru_mts/articles/879954/

[4] обучение: http://www.braintools.ru/article/5125

[5] описывалась: https://habr.com/ru/articles/755644/

[6] используется: https://jina.ai/ru/news/when-ai-makes-ai-synthetic-data-model-distillation-and-model-collapse/

[7] источник: https://dev.to/hakeem/how-to-use-knowledge-distillation-to-create-smaller-faster-llms-1np6

[8] взяла: https://arstechnica.com/ai/2025/03/ai-firms-follow-deepseeks-lead-create-cheaper-models-with-distillation/

[9] по оценкам экспертов: https://overclockers.ru/blog/kosmos_news/show/152795/Zatraty-na-obuchenie-modelej-iskusstvennogo-intellekta-priblizhajutsya-k-200-mln

[10] интеллект: http://www.braintools.ru/article/7605

[11] линейку малых языковых моделей Phi: https://azure.microsoft.com/ru-ru/products/phi/

[12] Источник: https://devby.io/news/openai-nashla-svidetelstva-chto-deepseek-obuchal-svoi-ii-na-eyo-modelyah

[13] по словам OpenAI: https://www.vedomosti.ru/technology/news/2025/01/29/1088916-openai-zapodozrila-deepseek

[14] могут свободно использоваться: https://ru.wikipedia.org/wiki/DeepSeek

[15] научный: http://www.braintools.ru/article/7634

[16] отметил: https://www.afr.com/technology/ai-companies-race-to-use-distillation-to-produce-cheaper-models-20250303-p5lgji

[17] лидерства: http://www.braintools.ru/article/1165

[18] Источник: https://habr.com/ru/companies/ru_mts/articles/894168/?utm_campaign=894168&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.