На сколько Ollama готова для Production?

Некоторое время назад я был в восторге от Ollama: простое скачивание моделей одной консольной командой, наличие SDK для NodeJS и Python, OpenAI-подобное API. Однако, так как отрасль рынка активно развивается, инструмент с каждым днем становится менее конкурентноспособным

Проблемы Ollama

Пункты ниже заставят вас задуматься рассмотреть другой инструмент запуска GGUF, например: LMStudio [1], LocalAI [2], KoboldCPP [3], vLLM [4] или llama-server [5]

-

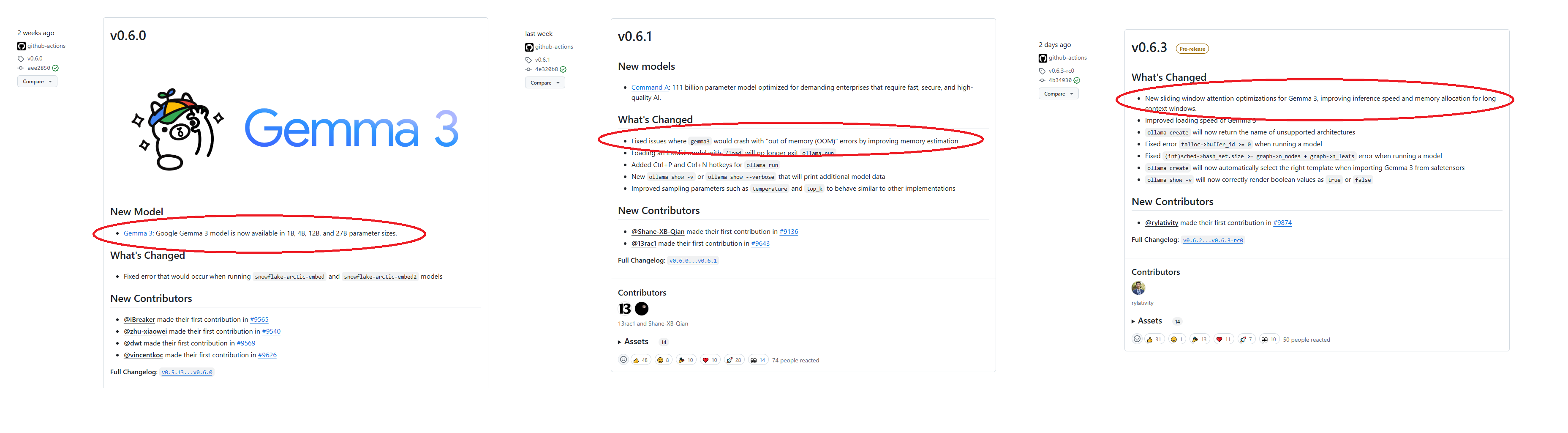

Три релиза подряд Gemma3 падает из-за нестабильного планировщика памяти [6]

Fixed issues where gemma3 would crash with “out of memory (OOM)” errors by improving memory estimation Для пользователей мобильного интернета, крайне неудобная особенность: чтобы оперативно запустить поддержку Gemma, Ollama три недели подряд заливала спамящие нестабильные релизы. Каждый релиз весит от 600МБ до 1ГБ

-

Поддержка инструментов всеми моделями библиотеки Ollama нестабильна

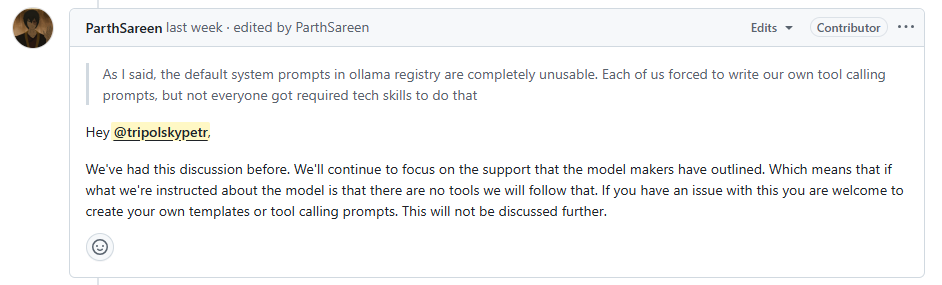

Если в модели не работают tool calling – это ваша проблема У Ollama свой язык для объявления system prompt для моделей: Modelfile [7]. На текущий момент он не стабилен. Как следствие, у моделей nemotron-mini и qwen2 [8]шилдик tools есть, а инструменты не работают. Там, где после патча Modelfile инструменты таки заработали, они работают раз от раза [9]

-

Открытый обман в официальных заявлениях

Посмотрите внимательно на архитектуру модели В репо Ollama есть

Deepseek-R1. Однако, это вовсе не DeepSeek, а обычная LLama 3.1, обученная на его дистиляции. Была использована эта модель из HuggingFace [10]. Как следствие, если запрос на русском к модели содержит англицизм, например,Расскажи мне о work-life balance для программистов при выгорании, модель частично пишет ответ на русском, частично на английском [11] -

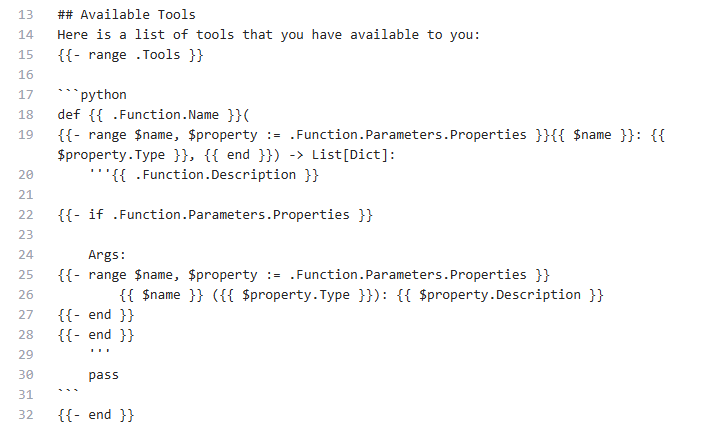

Некорректные Modelfile, которые пишет сама Ollama

Перечисление списка инструментов через python скрипт в Modelfile просто не работает. Совсем. Некоторое время назад попытался скачать CommandR [12] из репо Ollama. Модель весит 19ГБ, со слов производителя, специально заточена под вызов инструментов. На момент публикации Modelfile не умел давать модели список инструментов, в итоге CommandR не командует(. Новые модели вообще публикуют без поддержки tool calls вовсе

-

Модели-шизофреники c тысячами загрузок

В рейтинге Berkeley Function-Calling Leaderboard [14] модель watt-ai/watt-tool [15] это топ по вызову инструментов, который обходит даже OpenAI. Что залито в репо Ollama не понятно, не вывозит даже слова “Привет”, одну тысячу человек развели на 5ГБ трафика. К слову, генерация зациклилась: модель будет нести бред до посинения, пока вы сами не нажмете

Ctrl + C

Спасибо за внимание!

Предлагаю обсудить изложенные выше пункты в комментариях на предмет предвзятости автора

Автор: tripolskypetr

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13464

URLs in this post:

[1] LMStudio: https://lmstudio.ai/

[2] LocalAI: https://localai.io/

[3] KoboldCPP: https://github.com/LostRuins/koboldcpp

[4] vLLM: https://pypi.org/project/vllm/

[5] llama-server: https://github.com/ggml-org/llama.cpp/issues/9291

[6] памяти: http://www.braintools.ru/article/4140

[7] Modelfile: https://github.com/ollama/ollama/blob/b901a712c6b0afe88aef7e5318f193d5b889cf34/docs/modelfile.md

[8] у моделей nemotron-mini и qwen2 : https://github.com/ollama/ollama/issues/8287

[9] они работают раз от раза: https://github.com/ollama/ollama/issues/9680#issuecomment-2746103757

[10] эта модель из HuggingFace: https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Llama-8B

[11] частично пишет ответ на русском, частично на английском: https://habr.com/ru/articles/892468/

[12] CommandR: https://ollama.com/library/command-r/blobs/922095537bc1

[13] https://ollama.com/hengwen/watt-tool-8B: https://ollama.com/hengwen/watt-tool-8B

[14] Berkeley Function-Calling Leaderboard: https://gorilla.cs.berkeley.edu/leaderboard.html?ref=cohere-ai.ghost.io

[15] watt-ai/watt-tool: https://huggingface.co/watt-ai/watt-tool-70B

[16] Источник: https://habr.com/ru/articles/893624/?utm_source=habrahabr&utm_medium=rss&utm_campaign=893624

Нажмите здесь для печати.