Open-Sora 2.0: новая система в видео-AI снижает стоимость обучения при сохранении качества

Компания HPC-AI Tech разработала новую систему видео искусственного интеллекта [1], которая позволяет достичь качества коммерческого уровня примерно за одну десятую от типичной стоимости обучения [2] за счет использования новых методов сжатия.

Хотя языковые модели становятся все более эффективными [3], видео AI по-прежнему требует значительных ресурсов GPU. Open-Sora 2.0 использует другой подход, жертвуя некоторым разрешением ради значительно меньших вычислительных потребностей [4].

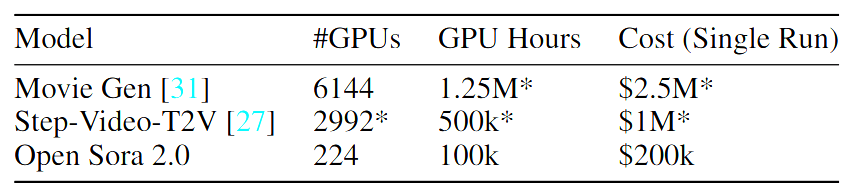

В исследовательской работе [5] указаны затраты на обучение в размере около 200 000 долларов — примерно одна десятая того, что требуется таким системам, как Movie Gen или Step-Video-T2V. Тестирование показывает качество, сопоставимое с коммерческими системами, такими как Runway Gen-3 Alpha и HunyuanVideo. Для обучения команда использовала 224 графических процессора Nvidia H200.

Сравнение стоимости обучения: Open-Sora 2.0 требует около $200 000 по сравнению с $2,5 млн для Movie Gen и $1 млн для Step-Video-T2V.

Система достигает своей эффективности через три фазы обучения: начиная с видео низкого разрешения, специализируясь на преобразовании изображений в видео и, наконец, тонкая настройка для более высокого разрешения. Команда дополнительно оптимизировала ресурсы, включив предварительно обученные модели изображений, такие как Flux.

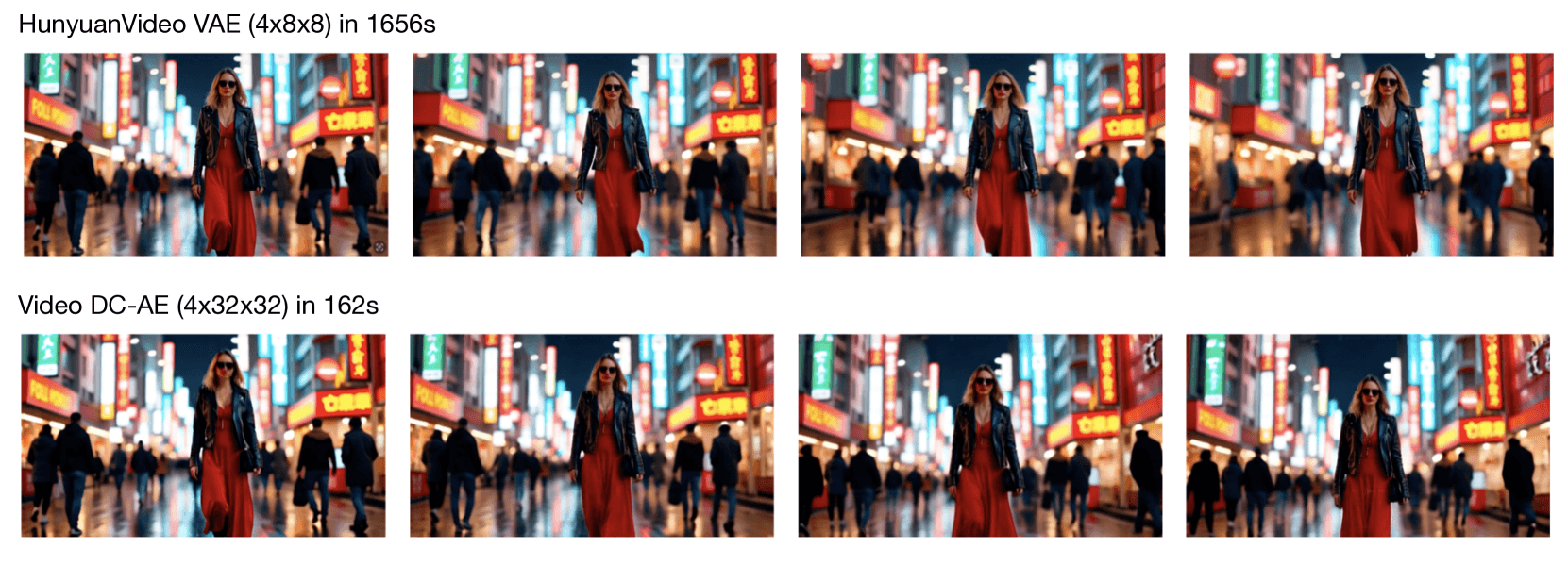

Центральным элементом системы является автоэнкодер Video DC-AE, который обеспечивает превосходные показатели сжатия по сравнению с существующими методами. Это нововведение ускоряет обучение в 5,2 раза, одновременно повышая скорость генерации видео более чем в десять раз.

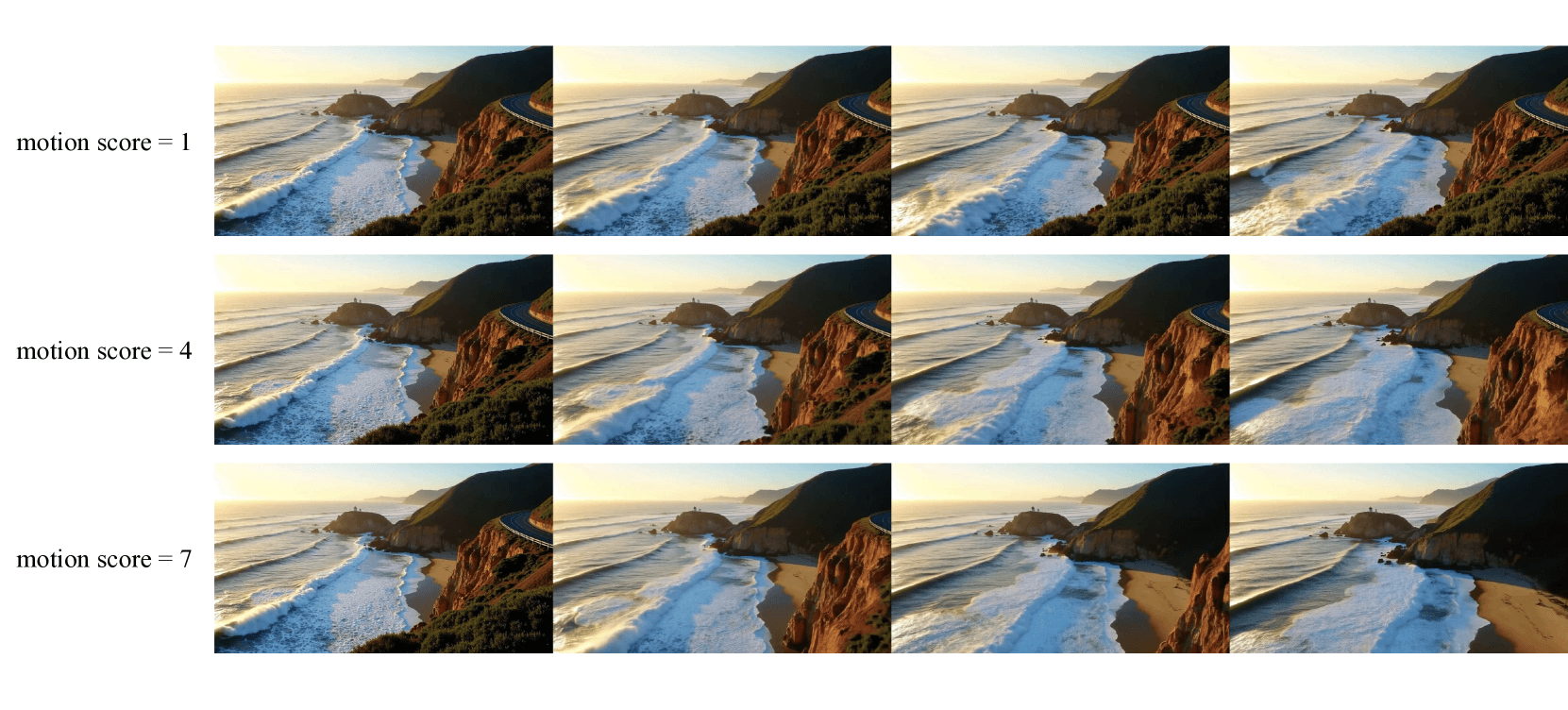

Open-Sora 2.0 может генерировать видео как из текстовых описаний, так и из отдельных изображений. Он включает функцию оценки движения, которая позволяет пользователям контролировать интенсивность движения в сгенерированных клипах.

Система имеет заметные ограничения. Видео может достигать разрешения только 768×768 пикселей и длиться максимум пять секунд (128 кадров). Для сравнения, Sora от OpenAI [6], которая разделяет с этим проектом только название, может генерировать видео 1080p длительностью до 20 секунд.

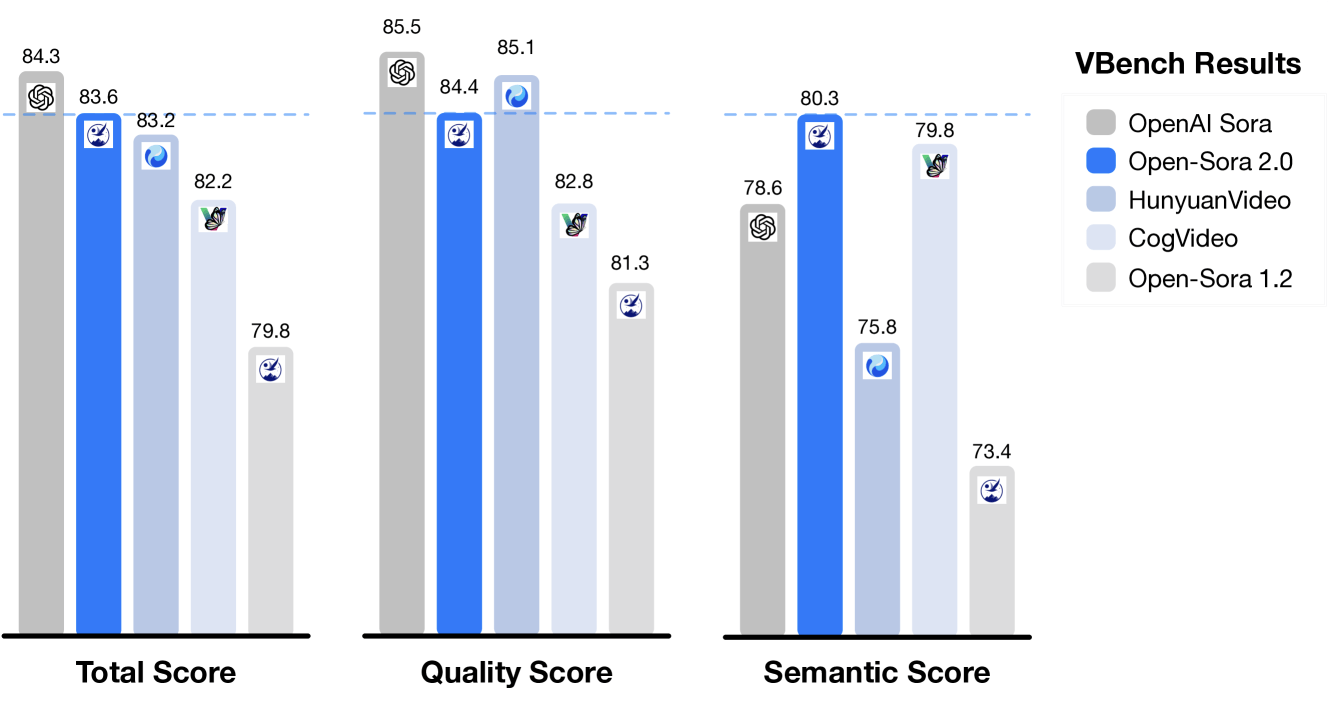

Тестирование показывает, что система работает на уровне, близком к коммерческому, по ключевым показателям, включая визуальное качество, точность и обработку движения. В частности, оценка Open-Sora 2.0 VBench теперь всего на 0,69% отстает от Sora от OpenAI, что существенно сокращает разрыв в 4,52%, наблюдавшийся в предыдущей версии.

Open-Sora теперь доступна как открытый исходный код на GitHub [7] . Как и другие модели видео AI, она по-прежнему сталкивается с проблемами, связанными с периодическими артефактами и движениями, бросающими вызов физике [8]. Вы можете посмотреть больше примеров на официальной странице проекта [9].

Генерация видео с помощью AI становится все более конкурентной областью, причем китайские компании лидируют в разработке. Новые системы запускаются почти еженедельно, включая проекты с открытым исходным кодом, такие как Genmo Mochi 1 [10] и MiniMax Video-01 [11]. Хотя эти модели часто показывают скромные улучшения в тестах, ни одна из них не достигла серьезного прорыва в общем качестве видео.

Стратегии эффективности затрат Open-Sora 2.0 отражают аспекты «момент Deepseek» в языковых моделях [3], когда улучшенные методы обучения помогли системам с открытым исходным кодом достичь производительности коммерческого уровня при сниженных затратах. Это может повлиять на ценообразование во всем секторе видео AI, где такие сервисы, как последняя модель Google, в настоящее время требуют 0,50 цента в секунду [12] из-за интенсивных вычислительных потребностей.

Однако разрыв в производительности между открытым исходным кодом и коммерческим видеоискусственным интеллектом остается более значительным, чем в языковых моделях, поскольку дажелидеры отрасли продолжают работать над решением фундаментальных технических проблем [13].

Источник [14]

Автор: dilnaz_04

Источник [15]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/13344

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] обучения: http://www.braintools.ru/article/5125

[3] языковые модели становятся все более эффективными: https://the-decoder.com/deepseeks-5-6m-chinese-llm-wonder-shakes-up-the-ai-elite/

[4] потребностей: http://www.braintools.ru/article/9534

[5] исследовательской работе: https://arxiv.org/abs/2503.09642v1

[6] Sora от OpenAI: https://the-decoder.com/openai-brings-sora-video-generator-to-uk-and-eu/

[7] GitHub: https://github.com/hpcaitech/Open-Sora

[8] периодическими артефактами и движениями, бросающими вызов физике: https://the-decoder.com/ai-video-generators-like-openais-sora-dont-grasp-basic-physics-study-finds/

[9] странице проекта: https://hpcaitech.github.io/Open-Sora/

[10] Genmo Mochi 1: https://the-decoder.com/genmo-mochi-1-a-new-benchmark-for-open-ai-video-models/

[11] MiniMax Video-01: https://the-decoder.com/video-01-ai-video-generator-from-minimax-is-the-latest-sora-challenger-from-china/

[12] 0,50 цента в секунду: https://the-decoder.com/google-deepmind-has-revealed-the-cost-structure-for-its-veo-2-video-generation-model-available-through-its-cloud-api-platform/

[13] лидеры отрасли продолжают работать над решением фундаментальных технических проблем: https://the-decoder.com/openai-launches-sora-video-generator-for-chatgpt-subscribers/

[14] Источник: https://the-decoder.com/open-sora-2-0-achieves-competitive-ai-video-quality-at-one-tenth-the-training-cost-of-commercial-models/

[15] Источник: https://habr.com/ru/companies/bothub/news/892652/?utm_source=habrahabr&utm_medium=rss&utm_campaign=892652

Нажмите здесь для печати.