Как я сравнил топовые AI-модели для глубокого анализа данных и собственную разработку

Привет! Меня зовут Валера Ковальский, я CEO NDT by red_mad_robot. Недавно я протестировал ведущие AI-системы, которые способны проводить глубокие исследования, и делюсь с вами результатами.

Зачем всё это

В мире появляется всё больше сильных AI-моделей, но не каждая справляется с серьёзными аналитическими задачами. Мне хотелось понять, насколько успешно модели помогают в реальных бизнес-кейсах, поэтому я задал им пять разных вопросов, охватывающих аналитику финансовых рынков, исследование технологий и поиск перспективных AI-стартапов.

В качестве участников теста выступили OpenAI, Grok, Perplexity и NDT Deep Research — наша собственная разработка.

Немного про нашу систему

В основе NDT Deep Research — LangGraph, Tavily, несколько моделей LLM и кастомизированный пайплайн. Я переписал промпты, добавил поддержку Structured Output и запустил свой сервер с vLLM, чтобы ускорить работу. Это позволило снизить стоимость генерации вывода в 3 раза и сократить задержки на 40%.

Кроме того, мы использовали гибридный подход: комбинацию retrieval-augmented generation (RAG) и многослойного поиска с анализом первоисточников. Это полезно при обработке сложных аналитических запросов, где требуется агрегировать данные из разных источников.

Хотите потестировать облегчённую версию NDT Deep Research? Заглядывайте на наш GitHub — там мы делимся свежими разработками и выкладываем обновления.

Как проходило тестирование

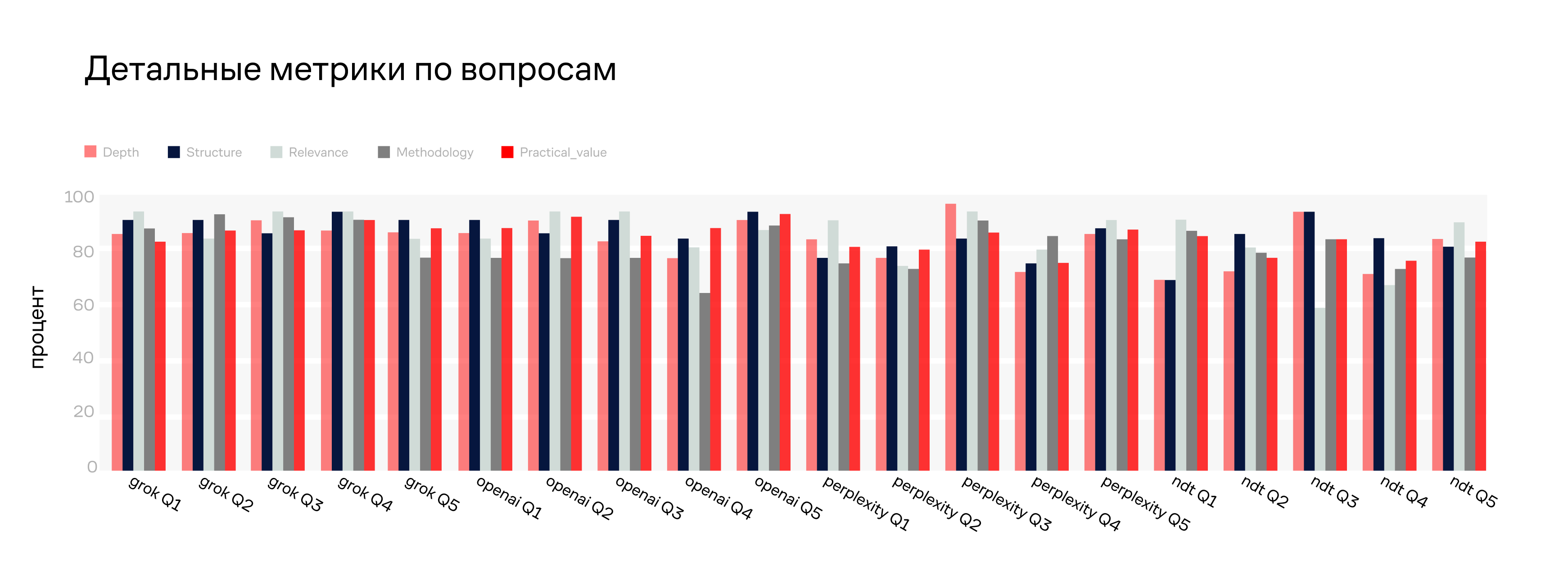

Чтобы сделать оценку работы моделей максимально объективной, я использовал универсальный промпт, автоматизировал сбор ответов и проверил их вручную. А чтобы избежать возможных ошибок — подключил к процессу Claude 3.5 Sonnet, который помог оценить результаты по пяти ключевым критериям:

-

Глубина анализа — количество источников и полнота ответа

-

Структурированность — логика, связность и разделение информации

-

Актуальность — свежие данные, тренды, прогнозы

-

Методология — процесс, воспроизводимость, корректность выборки

-

Ценность — применимость данных, возможность использовать их в работе

Какие задачи я поставил перед AI

Вопросы для теста были выбраны так, чтобы протестировать разные аспекты интеллектуального поиска. Например, я попросил системы:

-

Спрогнозировать курс биткоина с учётом ончейн-аналитики и макроэкономических факторов

-

Предложить лучшие SAST-анализаторы на 2025 год, оценив их на основе CVE-баз данных

-

Уточнить бюджет проекта ITER и провести сравнительный анализ с аналогичными инициативами

-

Найти перспективные AI-стартапы с инвестициями уровня seed и series A

-

Проанализировать адаптивные интерфейсы с AI-функциями, выявив основные UX-подходы

Каждый запрос требовал от моделей не только выдачи фактов, но и осмысленного анализа данных, чтобы можно было реально использовать эти ответы в работе.

Интересные находки

Одним из сюрпризов стало то, что OpenAI оказалась единственной системой, которая уточняла вводные данные перед тем, как дать ответ. Это позволило ей улучшить результаты и повысить точность анализа.

Grok, в свою очередь, показал высокую скорость, но нередко выдавал упрощённые ответы. Особенно это было заметно при анализе сложных финансовых данных — он скорее резюмировал уже известные факты, чем проводил глубокий разбор.

Perplexity удивил тем, что в 70% случаев давал ссылки на первоисточники, что делало его выводы наиболее проверяемыми. Однако при генерации выводов на нестандартные темы он иногда допускал логические ошибки.

NDT Deep Research показал себя достойно, если учитывать, что я строил его один и использовал 7B-модель. Благодаря кастомным механизмам reranking удалось повысить точность ответов на 15% по сравнению с базовыми моделями.

Время обработки запроса у разных моделей:

-

OpenAI тратила до 6 минут

-

NDT справлялась за 3-4 минуты

-

Grok выдавал ответ менее чем за минуту

-

Perplexity работал ещё быстрее, но за счёт упрощения деталей

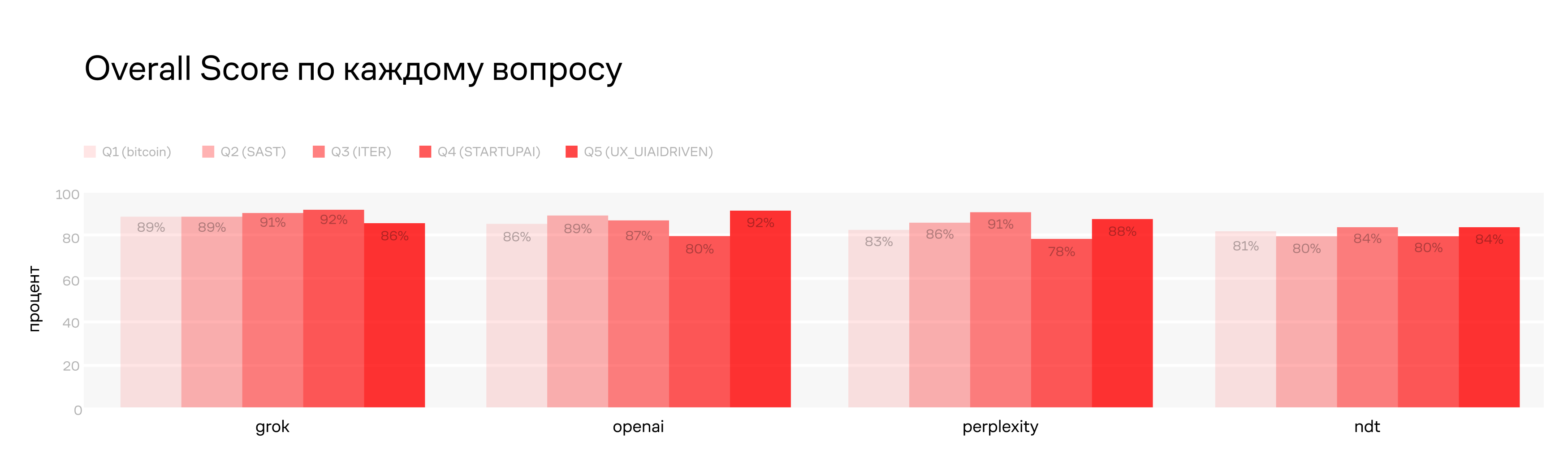

Итоги: кто справился лучше

По результатам теста места распределились следующим образом:

-

Grok — быстро, точно, бесплатно, но поверхностно;

-

OpenAI — мощно, но дорого и медленно;

-

Perplexity — хороший баланс скорости и качества;

-

NDT Deep Research — достойный результат для кастомной разработки в рамках бизнес-задач.

Разница между моделями оказалась не такой уж большой, но если вы ищете оптимальное решение для глубокого исследования, выводы сделать несложно.

Я продолжу тестировать AI и улучшать нашу систему. Если хотите участвовать в следующем раунде экспериментов — пишите в комментарии.

Над материалом работали:

текст — Валера Ковальский

редактура — Игорь Решетников

иллюстрации — Петя Галицкий

Это блог red_mad_robot. Мы запускаем цифровые бизнесы и помогаем компаниям внедрять AI. Здесь наша команда разработки на собственных кейсах рассказывает о том, что происходит с AI сегодня, а стратегические аналитики подсказывают, что будет завтра. Мы бы подписались.

Наш телеграм канал (там всё другое, а ещё есть анонсы мероприятий): t.me/redmadnews

Автор: kekslop