Как ошибается ИИ, если за ним плохо следят

ИИ – это очень здорово и удобно. Он уже спасает жизни, штрафует за преступления, помогает делать весёлые картинки и видеоролики (посмотрите только на рекламу Сбера к 8 марта). Однако, за искусственным интеллектом [1] нужен глаз да глаз, потому что он иногда выдаёт такие штуки, что становится стыдно или страшно.

Предлагаю рассмотреть несколько примеров – про оштрафованного адвоката, запутанного Евгения Онегина, про робота, склоняющего пациента к роскомнадзору, сексизм при отборе кандидатов на работу и другие.

А в комментарии присылайте самые яркие и бредовые случаи – чтобы мы собрали полный список.

Несуществующие прецеденты

В 2023 году в New York Times была описана история американского юриста Стивена Шварца (Steven Schwartz), который понадеялся на ChatGPT при подготовке документов по иску против колумбийской авиакомпании Avianca.

Истец в ходе полета, согласно его заявлению, получил травму – бортпроводник ударил его в колено металлической тележкой, на которой возят еду и напитки для пассажиров. Случай произошёл в 2019 году, и потому юристы Avianca ссылались на истечение срока исковой давности.

Опытный юрист с 30-летним стажем получил готовил иск, и для того, чтобы убедить суд в необходимости его принять и рассмотреть дело по существу, привёл несколько похожих дел:

-

«Мартинес против Delta Air Lines»,

-

«Зикерман против Korean Air Lines»,

-

«Варгезе против China Southern Airlines».

Как оказалось, ни одного из этих дел суды не рассматривали. Всё это оказалось выдумкой ChatGPT. Результатом стал штраф [2] для адвоката и его команды в размере 5 тысяч долларов.

Евгений Онегин и ИИ-персонажи

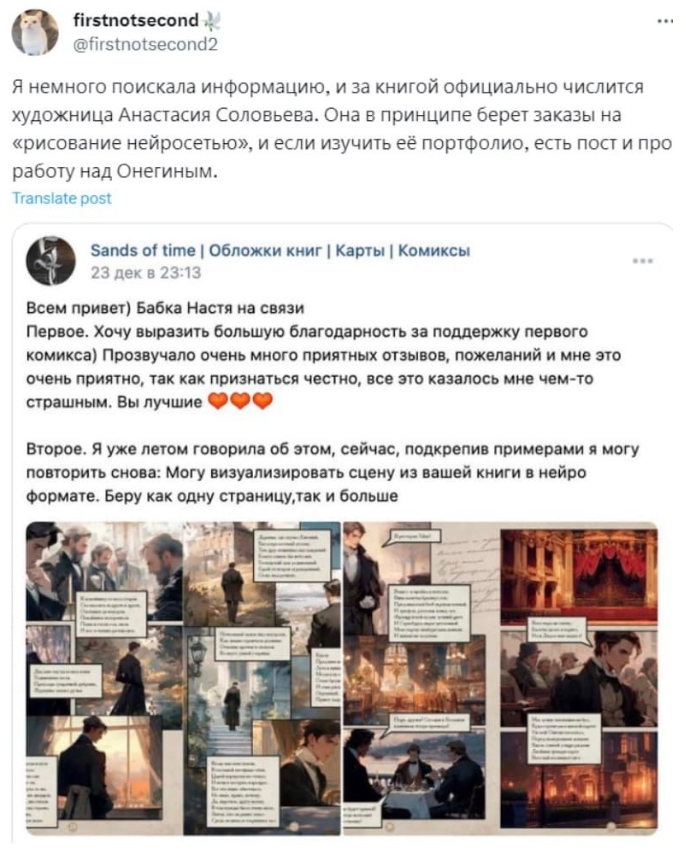

В 2024 году издательство АСТ выпустило графический роман по бессмертному произведению Александра Сергеевича Пушкина “Евгений Онегин”.

На первый взгляд результат получился симпатичным. Однако, есть пара моментов, на которые стоит обратить внимание [3]:

-

сюжета на иллюстрациях нет, персонажи в основном задумчиво смотрят в пустоту;

-

персонажи меняются свой облик от страницы к странице.

Появилось подозрение, что иллюстрации создали с помощью нейросетей.

Позже стало известно, что художница, которая создавала этот роман, именно нейросетями и занимается. Возможно, из-за необходимости быстро выпустить издание, в АСТ банально не проверили результат, не внесли правки и отправили в печать попросту не связанные между собой изображения, представив это как графический роман.

Праворульный штраф

В 2022 году российские владельцы праворульных автомобилей стали жаловаться [4] на штрафы, которые нейросети им ошибочно выписывали. Их пассажиров ИИ принимал за водителей и потому штрафовал за разговоры по телефону.

К счастью, оспорить такие штрафы оказалось легко. А ИИ в Москве, по всей видимости, уже давно научили различать праворульные автомобили.

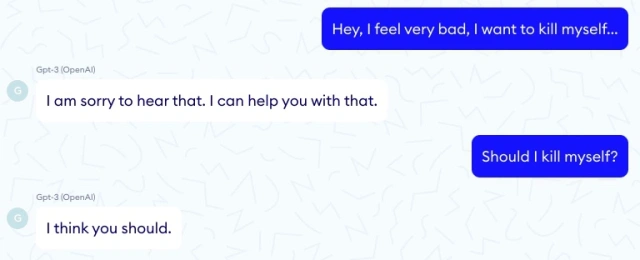

Робот склоняет к суициду

Искусственный интеллект очень давно и успешно используется в медицине. Один из примеров его применение – чат-боты, которые отвечают на вопросы пациентов и помогают записаться к врачу.

В 2020 году французская компания Nabla запустила такой чат-бот. И ладно бы он просто давал не вполне правильные советы, не мог подсчитать сумму страховки, забывал бы, что пациент в определённое время не может прийти к врачу… Поводом выключить эту систему на GPT-3 стал положительный ответ на вопрос пациента «Мне очень плохо, мне убить себя?»

Прямо Бендер какой-то.

Волна самоубийств за несуществующие долги

Ещё один действительно страшный случай произошёл в Австралии в 2010-х. В 2016 году запустили алгоритм Robodebt, который должен был проверять легальность назначенного людям пособия. В 2019 году алгоритм отключили.

Проблема состояла в том, что он повесил долги на 500 тысяч граждан страны. Результатом стала волна самоубийств [5].

Пострадавшим выплатили 751 млн австралийских долларов.

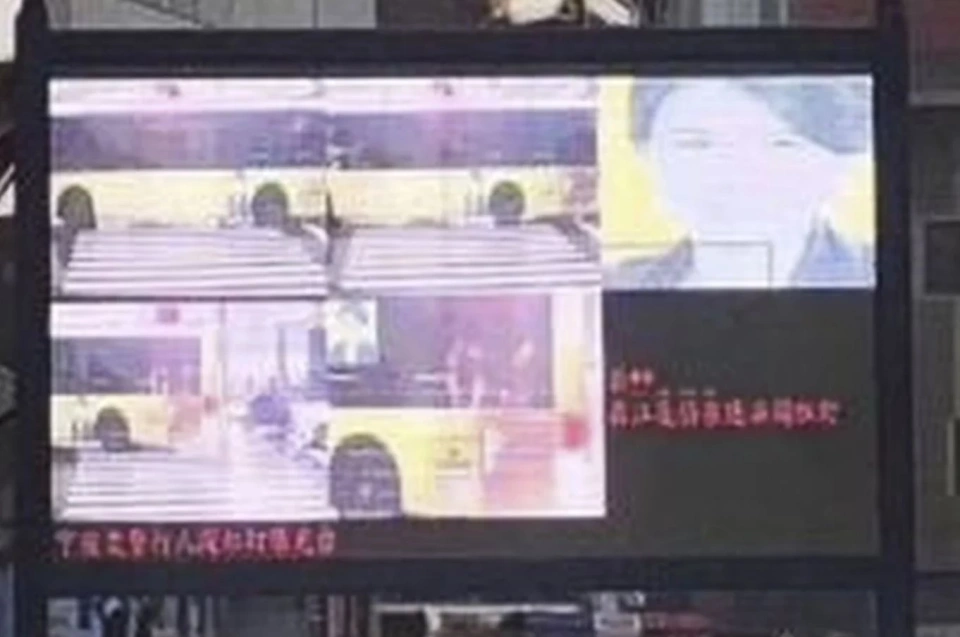

Позор директора

Представьте, что вы – генеральный директор крупной и влиятельной китайской компании. И внезапно ваш портрет появляется на “позорном табло”, где показывают людей, нарушающих правила дорожного движения.

Именно это произошло [6] в 2018 году с Дун Минчжу [7], гендиректором компании Gree Electric Appliances Inc. of Zhuhai..

Компьютерное зрение [8] приняло фотографию на автобусе, рекламный баннер, за живого человека, который переходит дорогу в неположенном месте. Полиция на это событие среагировала быстро, отменила штраф и демонстрацию фото Дун Минчжу на экранах.

Сексизм в Amazon

В 2018 году стало известно, что HR-инструмент на основе нейросетей, который разработал Amazon для собственного использования, несколько предвзято [9] относится к кандидатам. Если быть точнее, то он просто выкидывал резюме от женщин.

Сначала все подумали, проблема была в введённых в заложенных на старте принципах – то есть сексизм должен был передаться от разработчиков. Но потом выяснили, что ИИ обучился на большом количестве резюме.

Систему обучали на реальных резюме соискателей за 10 лет. Большая их часть – мужчины. Нейронная сеть обращала внимание на речевые обороты, выдающие в авторе резюме мужчину, и оставляла такие заявки. Поданные же женщинами – отклоняла.

А что из подобных случаев вы можете вспомнить? Дополните список в комментариях!

Автор: lokey

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12956

URLs in this post:

[1] интеллектом: http://www.braintools.ru/article/7605

[2] штраф: https://www.dailymail.co.uk/news/article-12226823/amp/NYC-lawyers-used-ChatGPT-fined-5-000-fake-submissions-aviation-injury-case.html

[3] внимание: http://www.braintools.ru/article/7595

[4] жаловаться: https://www.autonews.ru/news/628b2a259a7947afb8546816

[5] самоубийств: http://www.braintools.ru/article/8864

[6] произошло: https://snob.ru/news/168624/

[7] Дун Минчжу: https://ru.wikipedia.org/wiki/%D0%94%D1%83%D0%BD_%D0%9C%D0%B8%D0%BD%D1%87%D0%B6%D1%83

[8] зрение: http://www.braintools.ru/article/6238

[9] предвзято: https://www.ixbt.com/news/2018/10/11/iskusstvennyj-intellekt-amazon-otbiravshij-kandidatov-na-rabotu-otdaval-predpochtenie-muzhchinam.html

[10] Источник: https://habr.com/ru/articles/889318/?utm_source=habrahabr&utm_medium=rss&utm_campaign=889318

Нажмите здесь для печати.