Deep Research компании OpenAI создан для меня, но я не могу им пользоваться. Это ещё одно потрясающее демо, увы, поломанное. Но ломается оно очень интересным образом.

По большей мере я зарабатываю на жизнь исследованиями и анализом. Я думаю о данных, которые хочу увидеть, и ищу их; собираю и сопоставляю их, создаю графики, решаю, что они скучные, и пробую снова, нахожу новые способы и новые данные для понимания и объяснения проблемы, пишу текст и составляю графики, пытаясь выразить то, что я думаю. А потом я разговариваю об этом с людьми.

При этом часто требуется большой объём ручного труда: под каждым графиком скрывается айсберг. И похоже, Deep Research предназначен именно для меня. Подходит ли он под мои задачи?

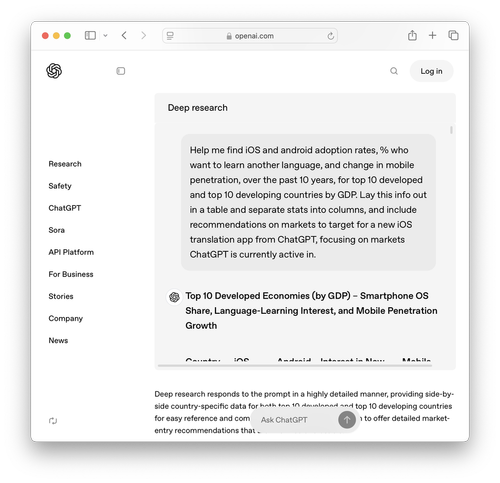

Я могу протестировать его на новой задаче, но прежде чем тратить время и кредиты, к счастью, можно воспользоваться образцом отчёта со страницы OpenAI. Этот отчёт посвящён тому, что я достаточно хорошо изучил — смартфонам. Давайте исследуем его.

Таблица выглядит замечательно — все труды по сбору данных, на которые бы мне понадобились часы, машина выполнила за меня. Однако прежде чем отдавать отчёт клиенту, давайте кое-что проверим. Во-первых, откуда взяты данные?

Ой.

У нас есть два источника: Statista и Statcounter. Данные Statcounter — это спорная метрика adoption (величина трафика), а как мы знаем, устройства используются по-разному. Мощные устройства используют чаще, а iPhone перекошены в сторону верхней ценовой категории, то есть создают перекос в сторону более активного использования. Я бы я объяснил стажёру, что в нашем анализе такую метрику применять нельзя (а я часто сравниваю ИИ со стражёрами). Statista выполняет агрегацию данных других людей, обеспечивает свой высокое положение в SEO, а затем пытается заставить пользователей зарегистрироваться или заплатить, чтобы увидеть результат. Я считаю, что Google должна полностью забанить эту компанию в своём индексе, но даже если вы с этим не согласны, называть подобное «источником» — это то же самое, что и называть источником поисковую выдачу Google. И это тоже ошибка стажёрского уровня.

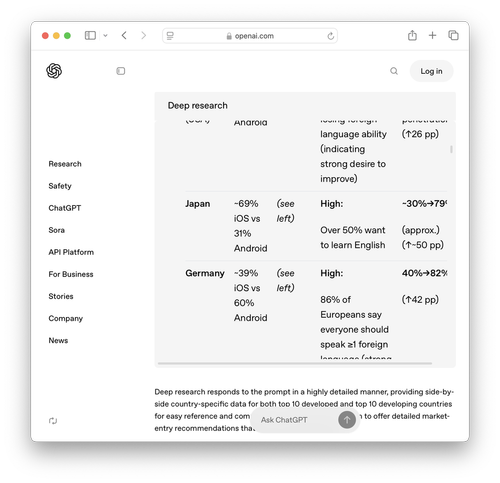

Впрочем, отложим это в сторону и покопаем немного глубже. Взглянем на один показатель — по Японии. Deep Research утверждает, что японский рынок смартфонов делят iOS с 69% и Android с 31%. Это вызывает два вопроса: действительно ли об этом говорят источники и правы ли они? Это два очень разных вопроса.

Во-первых, Statcounter, несмотря на то, что придаёт слишком большой вес iPhone, нигде не говорит о 69% и таких показателей на нём не было больше года. Хм-м-м.

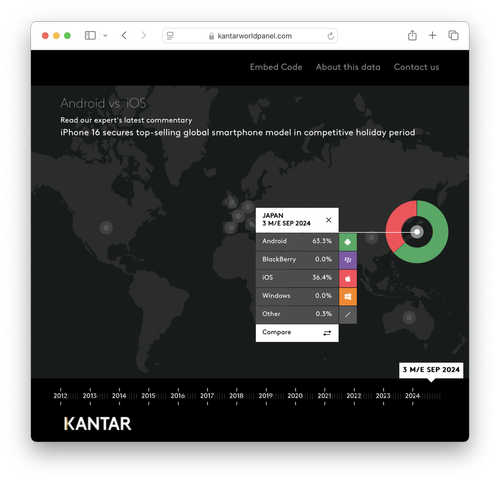

Если обратиться к Statista, нам придётся помучиться, преодолевая препятствия, но в результате мы выясним, что истинный источник — это исследовательская фирма Kantar Worldpanel, и что представленные ею числа почти полностью противоположны утверждению Deep Research — 63% у Android и 36% у iOS. Ой.

Мы можем продолжить анализ. Показатели Kantar колеблются от месяца к месяцу в пределах 20 процентных пунктов; аппаратные платформы обычно ведут себя иначе, поэтому я не совсем понимаю, что же на самом деле отслеживала эта фирма. Мы можем проверить и некоторые другие числа, но если мне придётся проверять каждое число в таблице, то это никак не сэкономит мне времени, с тем же успехом я мог бы сделать всё сам. И хотите верьте, хотите нет, но регулирующие госорганы Японии выпустили данные опросов (страница 25), в которых говорится, что доля рынка составляет примерно 53% для Android и 47% для iOS. Ой.

Что нам думать об этом?

LLM — это не базы данных: они не занимаются получением точных, детерминированных, предсказуемых данных, и не стоит даже тестировать их так, как будто они на это способны. Но мы стремимся не совсем к этому — скорее, мы проводим более комплексный и интересный тест.

Во-первых, в примере OpenAI используется неточный вопрос: в нём говорится об adoption, но что это значит? Мы спрашиваем о количестве проданных устройств, об установленной базе, доле в общем количестве используемых устройств или, может, о доле трат на приложения? Всё это различается. Что именно мы хотим узнать? Во-вторых, ответ на любой из этих вопросов тоже оказывается неточным — нет ни одного источника, к которому можно обратиться, и для выбора источника нужны рассуждения или опыт — взять ли нам данные Statcounter, Statistica, самой Kantar или кого-то ещё?

То есть ни одна из этих задач не имеет вид запроса к базе данных — OpenAI задаёт модели вероятностный, а не детерминированный вопрос. Но ответ на этот вопрос детерминирован — разобравшись в том, что вам нужно, и какой ответ выбрать, вы хотите получить реальное число. Мы ожидаем детерминированного ответа на вероятностный вопрос и похоже, что модель действительно сама по себе не справляется. На мой взгляд и исходя из моего опыта, она не должна была использовать Statcounter или Statistica, но если и должна была, то нужно было взять из них правильное число.

Это напомнило мне наблюдение, сделанное несколько лет назад: LLM хорошо справляются с тем, с чем плохо справляются компьютеры, и плохи в том, в чём компьютеры хороши. OpenAI пытается заставить свою модель выполнять работу, для которой она, вероятно, предназначена (компьютеры плохи в ней, а LLM хороши), и потом заставить модель выполнять извлечение очень конкретной информации (компьютеры в этом хороши, а LLM плохи). И получается не очень здорово. Помните, что это не мой тест, а собственная страница продукта OpenAI. OpenAI обещает, что её продукт способен на то, чего он не может делать; по крайней мере, он справляется с задачей не полностью, и это продемонстрировал его собственный маркетинг.

Очевидно, здесь можно ответить, что модели совершенствуются, но при этом мы упустим главное. Вы говорите мне, что сегодняшняя модель составляет таблицу правильно на 85%, а следующая версия достигнет 85,5 или 91%? Это мне не поможет. Если в таблице есть ошибки, то не важно, сколько их там конкретно — я не могу доверять ей. С другой стороны, если же вы считаете, что эти модели когда-то будут точными на 100%, то это изменит всё; но это и станет двоичным изменением в природе этих систем, а не процентным изменением, и мы даже не знаем, возможно ли это.

Я сделал упор на одном числе, потому что его легко проверить и протестировать, но концептуально та же проблема актуальна и для десятков страниц текста: Deep Research так же будет по большей мере права, но только по большей мере.

Когда я пишу это, то испытываю двойственное чувство: я лишь иногда могу сказать, что эти системы великолепны, но постоянно путаются в том, что важно, поэтому пока их лучше всего использовать в случаях, когда частота ошибок не важна или когда их легко увидеть. Было бы гораздо проще сказать, что модели прекрасны и постоянно совершенствуются, и на этом закончить, или заявить, что из-за частоты их ошибок это самая глупая трата времени и денег со времён NFT. Но гораздо интереснее будет исследовать эту двойственность.

Да, эти модели полезны. Если вас попросили написать 20-страничный отчёт о теме, в которой вы обладаете глубокими знаниями, а этого отчёта в готовом виде у вас нет, то модели могут превратить труд пары дней в задачу на пару часов. После чего вы можете исправить все ошибки. Я всегда называю ИИ «вечными стажёрами»: с ними возникает очень много моментов, похожих на ситуации при обучении стажёров; но надо помнить и цитату Стива Джобса о том, что «компьютер — это велосипед для мозга»: он позволяет двигаться дальше и быстрее гораздо меньшими усилиями, но сам по себе он никуда не уедет.

Если снова сделать один шаг назад, можно выделить здесь две фундаментальные проблемы. Во-первых, повторюсь, мы не знаем, пропадут ли полностью ошибки, поэтому не знаем, должны ли мы создавать продукты, исходя из предположения о том, что модели иногда будут ошибаться, или спустя год-два мы будем создавать продукты, предполагая, что можем полагаться на саму модель. Это сильно отличается от ограничений других важных технологий, от PC до веба и смартфонов, в которых мы знаем принципы, которые могут и не могут меняться. Будут ли решены проблемы Deep Research, о которых я говорил выше? От ответа на этот вопрос зависит то, какой из двух типов продуктов мы будем создавать.

Во-вторых, OpenAI и все остальные лаборатории по разработке базовых моделей не имеют никаких возможностей защитить свои технологии, за исключением необходимости большого капитала для их разработок, у них нет рыночной ниши за исключением кодинга и маркетинга, да и реальных продуктов, лишь поля для ввода текста, а также API, на основе которых свои продукты создают другие компании. Deep Research — это одна из множества попыток создать имеющий спрос продукт, а также реализовать его сценарий использования. Но, с одной стороны, Perplexity спустя несколько дней заявила о выпуске такого же продукта, с другой стороны, наилучший способ работы с частотой ошибок сегодня — это абстрагирование LLM в виде вызова API внутри ПО, которое и будет обрабатывать ошибки; само собой, это ещё больше повышает спрос на сами базовые модели. Такой ли в конечном итоге окажется ситуация? Лично я понятия не имею.

Автор: PatientZero