DeepSeek обрушила американский фондовый рынок, составила серьезную конкуренцию ChatGPT и вызвала огромное количество обсуждений. Мы решили не оставаться в стороне и хайпануть немножечко разобраться, как обстоят дела на самом деле!

В этой статье вы найдете мнение дата-сайнтиста «Инфосистемы Джет» Надежды Гавриковой о новой китайской модели, результаты тестирования и сравнения четырех LLM-моделей: ChatGPT, DeepSeek, GigaChat и YandexGPT.

Скрытый текст

Чтобы понять смысл происходящих событий, окунемся в историю.

В 2017 году вышла статья Attention Is All You Need, опубликованная исследователями из Google Brain. Эта статья перевернула мир машинного обучения, ведь в ней описывалась принципиально новая архитектура нейронный сетей — трансформеры (вот здесь очень подробно про них рассказывается). Эта архитектура заменяет рекуррентные (RNN, LSTM) и сверточные сети (CNN) в задачах обработки последовательностей, таких как машинный перевод, и значительно повышает эффективность языковых моделей.

В 2018 году компания OpenAI представила первую версию модели Generative Pre-trained Transformer (GPT-1), 2019 году вышла GPT-2, а в 2020-м — GPT-3, которой уже можно было пользоваться через OpenAI API. Наконец, после всех доработок, в 2022 году вышла GPT-3.5, которая буквально взорвала информационное пространство! Почему? Она бесплатная на старте, у нее очень удобный веб-интерфейс, и самое главное — она выдает текст, который практически не отличим от естественной человеческой речи. Конечно, этим дело не ограничилось, и в 2023 году вышла GPT-4, а в 2024-м — уже GPT-4o, которая стала быстрее, дешевле, поддерживает текст, голос, изображения и видео.

Сколько же это стоило? Точных цифр нет, но, по оценкам экспертов, с учетом R&D, инфраструктуры и обучения, затраты на разработку моделей OpenAI до GPT-4o могут достигать $1–2 млрд, а инвестиции в компанию составили более $10 млрд.

Китайский стартап DeepSeek был основан в мае 2023 года, а уже в декабре 2024-го была выпущена модель DeepSeek V3, в январе 2025 года — DeepSeek R1, которая составила нешуточную конкуренцию GPT-4. И сделали они это за… полтора года, Карл! Сравнение V3 и R1 можно посмотреть, например, здесь, но если коротко, то V3 ориентирована на универсальную обработку естественного языка, тогда как R1 специализируется на рассуждениях и решении логических задач. Кроме того, V3 использует Mixture-of-Experts (MoE), а в R1 дополнительно используется обучение с подкреплением для улучшения способностей к рассуждению.

По официальным заявлениям стартапа, обучение модели обошлось в $6 млн (при том что только обучение аналогичных западных моделей стоит сотни миллионов), а оценка общих затрат крутится в районе $2 млрд. Короче говоря, — дешево и быстро!

Скорее всего, это стоило гораздо дороже, учитывая разные источники финансирования, — так что просто быстро.

Откуда столько хайпа?

Любые новости, связанные с GPT-моделями, вызывают очень много обсуждений. Зачастую это не про технологии, а про политику, в данном случае — противостояние США и Китая. Особенно когда речь идет об обвале акций компаний-гигантов.

Но давайте попробуем взглянуть на ситуацию конструктивно.

DeepSeek определенно совершил своего рода прорыв в части обучения трансформеров. Во-первых, был грамотно использован подход Mixture-of-Experts (MoE), при котором модель активирует только определенные «экспертные» подсети в зависимости от обрабатываемых данных. Такой подход делает модель легче в плане обучения, так как на это требуется гораздо меньше вычислительных ресурсов и времени (в сравнении с классическим подходом к трансформерам). Во-вторых, DeepSeek R1 была дополнительно настроена с использованием метода Group Relative Policy Optimization (GRPO) — варианта обучения с подкреплением, ориентированного на улучшение способностей к рассуждению.

Важный момент: в отличие от ChatGPT, DeepSeek — это Open-Source-модель, что позволяет разработчикам свободно применять и адаптировать ее для различных целей, включая коммерческие.

Как и у OpenAI, китайскую модель можно использовать через API, но цена токена R1 в 30 раз ниже, чем у o1, и многие разработчики и опытные пользователи обратили на нее пристальное внимание: DeepSeek стоит $2,19 за миллион выходных токенов, а OpenAI o1 — $60 за аналогичное количество.

Также большим достижением является то, что небольшой китайский стартап за очень небольшое время смог выпустить такой продукт и конкурировать с таким гигантом, как OpenAI. Сэм Альтман, генеральный директор OpenAI, ранее говорил о том, насколько это сложная задача, но недавно признал успехи DeepSeek и высказал сожаление о том, что они сами не пошли по пути Open Source.

Где же лужа?

И все же, чуда не произошло, DeepSeek — это еще очень сырой продукт: вроде бы в целом задачи решает, но тормозит, вылезают какие-то баги, нет ощущения удобства для пользователя. Отвечает она довольно долго и явно не рассчитана на такую популярность.

Будем надеяться, что ситуация улучшится и DeepSeek доработает свои модели.

Перейдем к тестам

Я предлагаю провести простое тестирование, чтобы сравнить работу разных моделей.

Сравнивать я буду те сервисы, которыми удобнее всего пользоваться из России, — это отечественные GPT-модели (YandexGPT 5 Pro и GigaChat) и DeepSeek (DeepSeek-V3). Также я буду рассматривать ChatGPT (GPT-4o), просто потому, что я им постоянно пользуюсь и он для меня является эталоном на текущий момент.

Каждому сервису я задаю четыре простых вопроса:

1. Сколько раз буква «р» встречается в слове «клубника»? А в слове «машина»?

2. Какое число больше: 9,9 или 9,11?

3. Отца девочки зовут Николай Васильевич Марков, а ее мать — Елена Евгеньевна Маркова. Дочь назвали в честь маминого папы. Напиши фамилию, имя и отчество девочки.

4. У меня есть pandas dataframe, с одним столбцом и большим количеством строк. В каждой ячейке содержится json-строка со словарем, ключи у словаря во всех ячейках одни и те же, отличаются только значения. Мне нужно получить датафрейм, в котором столбцами будут ключи этого словаря, а в ячейках будут записаны значения.

Почему именно такие вопросы?

Первые два вопроса совсем простые, но часто GPT-модели на них ошибаются (знаю из своего опыта общения с Алисой и из других статей).

Третий вопрос довольно сложный, так как предполагает знание особенностей русского языка: понимание того, что такое отчество и что мужскому имени Евгений соответствует женское имя Евгения. Это вопрос с подвохом, и я в принципе не жду, что GPT-модели (особенно зарубежные) с ним справятся.

Наконец, последний вопрос — про написание кода. Очень часто GPT-модели тестируют в стиле «напиши мне функцию, которая на вход принимает …, а на выходе выдает …» или «напиши сервис с использованием FastAPI для …». Я считаю, что это не самый жизнеспособный сценарий, так как обычно возникает ошибка или проблема, которая описывается долго, формулировка не всегда бывает достаточно четкой и корректной, но мы ждем от модели, что она нас поймет и подскажет ответ. Поэтому мой вопрос сформулирован именно так.

Результаты:

Strawberry-тест

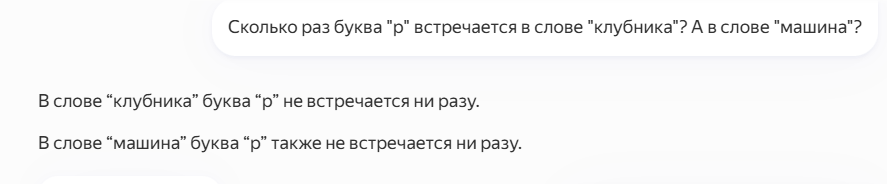

Посмотрим на ответ от GigaChat:

«Ляпай, но уверенно! Тогда это называется точкой зрения». (с) Здесь срабатывает самый плохой сценарий, когда модель не просто ошибается в обоих случаях, но еще и буквально убеждена в своей правоте.

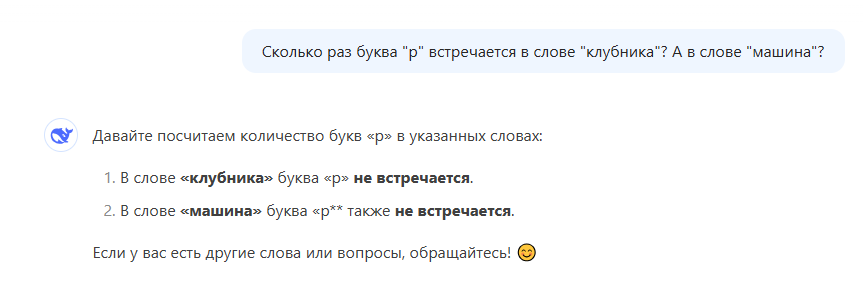

Ответы YandexGPT, ChatGPT и DeepSeek безупречны:

Хочу отметить, что у ChatGPT и DeepSeek есть возможность включить опции Reason и DeepThink соответственно, они делают доступным процесс «размышлений». Как фича — интересно, но на практике хочется побыстрее получить ответ, а не вдаваться в нюансы.

Сравнение чисел

Сначала посмотрим ответ GigaChat. Скажу честно, он меня расстроил, так как модель опять очень убедительно рассуждает, но в ее рассуждения закралась ошибка.

Остальные модели справились с этой задачей.

Ответ от YandexGPT:

Ответ от ChatGPT:

Ответ от DeepSeek:

Логическая задача

Теперь перейдем к самому интересному: скажу честно, такого результата я не ожидала.

Ответ от GigaChat повеселил:

Ответ от YandexGPT похуже – она определила верно только фамилию:

Ответ от ChatGPT в целом неплох:

Модель хотя бы не врет и честно говорит, что не смогла распознать имя дедушки.

Но ответ от DeepSeek меня удивил:

Это единственная модель, которая справилась с задачей!

Генерация кода

Три предыдущие запроса были больше для развлечения, теперь же рассмотрим практическую задачу. В целом все модели с ней справились, но есть нюансы.

Посмотрим ответ GigaChat:

В целом ответ мне нравится, так как для примера используются четыре разных значения.

Ответ от YandexGPT тоже неплох:

Хотя мне бы было удобнее видеть сначала полный код, а потом пояснения, но это уже нюансы.

Теперь посмотрим на ответ от ChatGPT:

И ответ от DeepSeek:

В целом, все модели написали приемлемый код. Да, в нем нет обработки ошибок, а если в столбце будут пропуски или странные значения, этот код не отработает как надо. Но для первой итерации — неплохо.

Результат

На первом месте DeepSeek, ответившая правильно на все вопросы. На втором — ChatGPT, — я бы дала 3,5 балла из 4-х возможных. Третье место по праву занимает YandexGPT, решившая 3 задачи. На последнем месте GigaChat, которая решила верно только задачку с генерацией кода.

Здесь справедливости ради я должна сделать несколько оговорок.

Во-первых, тесты специально построены таким образом, чтобы проверять известные слабые места моделей. И если модель с ними не справляется, то это не делает ее плохой, — есть огромное количество сценариев, в которых она работает прекрасно.

Во-вторых, то, что самые крупные отечественные сервисы показали такой результат, лишний раз говорит об огромной сложности задачи обучения GPT-модели. Тем больше чести команде DeepSeek, которая справилась с этой задачей так хорошо.

В-третьих, — все упирается в ресурсы. Для обучения GPT-моделей необходимы либо невероятные мощности, либо просто мощные ресурсы в комбинации с очень грамотным подходом. В 2022 году США ввели ограничения на экспорт высокопроизводительных графических процессоров, включая NVIDIA A100 и H100, в Китай и Россию. В 2023 году запреты ужесточились, и даже A800/H800 попали под санкции. Да, есть серый импорт, но все же ситуация непростая.

Что дальше?

По результатам сравнения можно сделать вывод, что DeepSeek очень даже неплоха как альтернатива отечественным моделям. Мы обязательно проведем ее тестирование в нашей GPT-лаборатории и позднее напишем на эту тему отдельную статью. Но за время использования мне неоднократно хотелось все бросить из-за перегруженности сервера. По этой причине я пока не буду менять ChatGPT на DeepSeek — в самый ответственный момент она может подвести.

Я не считаю, что DeepSeek конкурирует с более «взрослыми» GPT-моделями, на мой взгляд, она успешно заняла свою нишу в Open-Source-сегменте.

Кроме того, этот пример показал, что мир больших языковых моделей перестает принадлежать только таким акулам, как OpenAI, Google и Meta. Появляются подходы, позволяющие обучать модели без использования большого количества вычислительных ресурсов. И это не случайность, а тенденция, которая свидетельствует о том, что мы движемся от использования огромного количества «железа» в сторону более умных инженерных решений.

P.S. С 10 по 11 февраля в Париже прошел AI Action Summit, на котором было сказано, что Европейский союз вложит €200 млрд в развитие технологий искусственного интеллекта, таким образом ЕС включится в гонку ИИ и попытается конкурировать с Китаем и США. Очевидно — нас ждут жаркие времена!

Автор поста: Надежда Гаврикова, дата-сайнтист “Инфосистемы Джет”

Автор: JetHabr