Недавно в мире GenAI появились захватывающие новости: компания Anthropic представила новую языковую модель Claude 3.7 Sonnet. Эта модель объединяет в себе высокую скорость реакции и способности «глубокого» рассуждения (deep reasoning), что делает её одной из самых универсальных и продвинутых моделей на рынке коммерческих LLM. Благодаря инновационному подходу к гибридноcти, Claude 3.7 Sonnet способна как быстро отвечать на запросы, так и предоставлять подробное пошаговое обоснование своих выводов в зависимости от выбранного режима.

Основные особенности Claude 3.7 Sonnet

-

Гибридное мышление: Модель предлагает два режима работы. Стандартный режим обеспечивает мгновенный ответ, а расширенный — детализированное пошаговое рассуждение, позволяющее пользователю наблюдать за ходом мыслительного процесса.

-

Улучшенные навыки программирования: Claude 3.7 Sonnet демонстрирует высокую точность и эффективность в решении задач, связанных с программированием, что делает её незаменимой для веб‑разработки и анализа кода.

-

Контроль времени отклика: Функция задания временного бюджета позволяет пользователям контролировать, сколько времени модель тратит на обработку сложных запросов.

-

Снижение необоснованных отказов: Благодаря усовершенствованной системе различения вредоносных и безопасных запросов, модель на 45% реже отказывается отвечать на безобидные вопросы, что повышает её надёжность и удобство использования.

Тестируем Claude 3.7 Sonnet и сравниваем его с другими LLM

На собеседованиях по алгоритмам обычно даётся 2 обязательные задачи и одна дополнительная (источник), если кандидат справился с предыдущими и осталось время.

Я выбрал 3 задачи из хендбука Яндекса по алгоритмам, а именно:

-

Бронирование переговорки (Глава 3.2 «Жадные алгоритмы») — leetcode easy

-

Сумма минимумов на отрезках (Глава 9.4 «Стек») — leetcode easy/medium

-

Выход из лабиринта (Глава 10.3 «Обходы графа») — leetcode medium/hard

В суть задач я предпочёл бы не вдаваться т.к. всё внимание приковано к тому, решит ли их новая LLM‑ка, и если да, то с какой попытки?

Ранее, я интегрировал Claude 3.7 в свой пет‑проект — Телеграм‑бот, где я собрал лучшие LLM в одном месте, чтобы не прыгать между платформами каждый раз, когда хочется использовать оперделённую модель. Итак, начнём наше собеседование по алгоритмам.

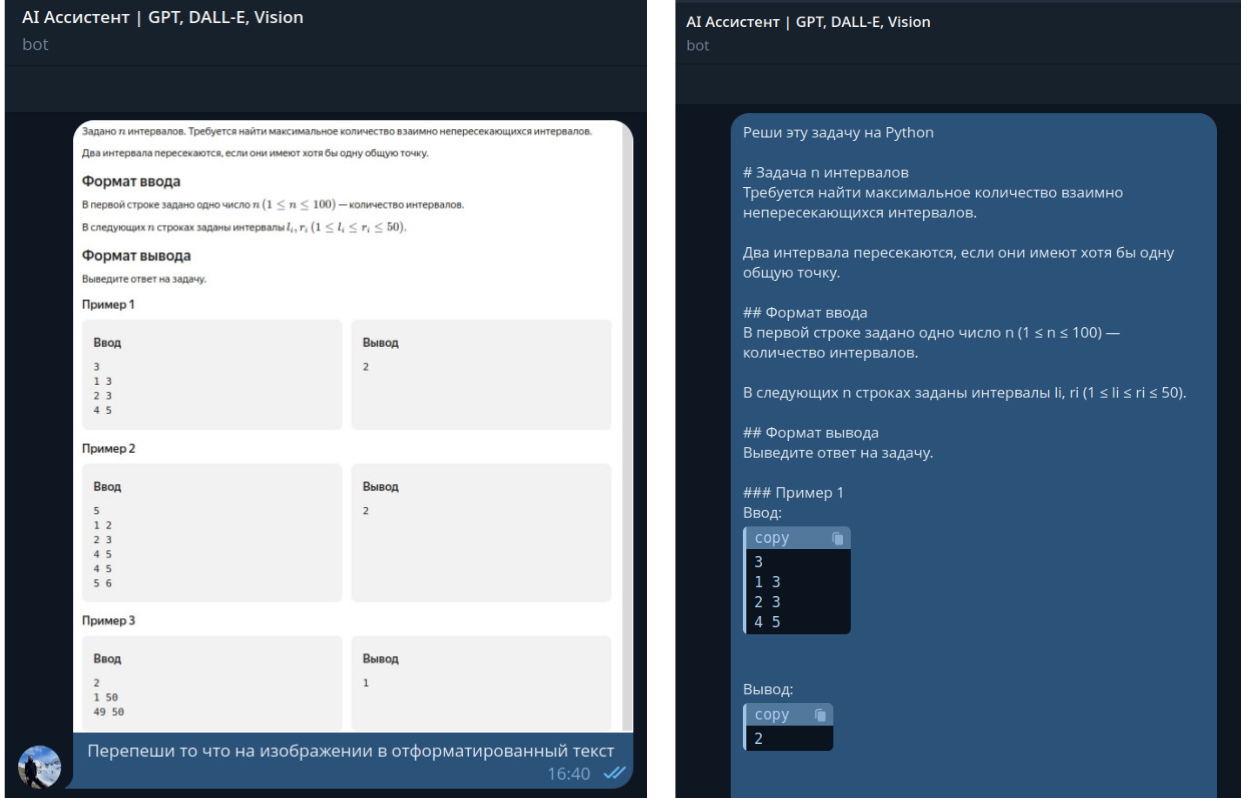

Задача 1: Бронирование переговорки

В первую очередь, я сделал скриншот текста и вывода задачи, для того, чтобы транскрибировать его в отформатированный текст и заодно посмотреть, как работает vision функциональность у новой модели Claude 3.7.

Решение не заставило себя долго ждать и в итоге мы получили исходный код с пояснениями на русском языке.

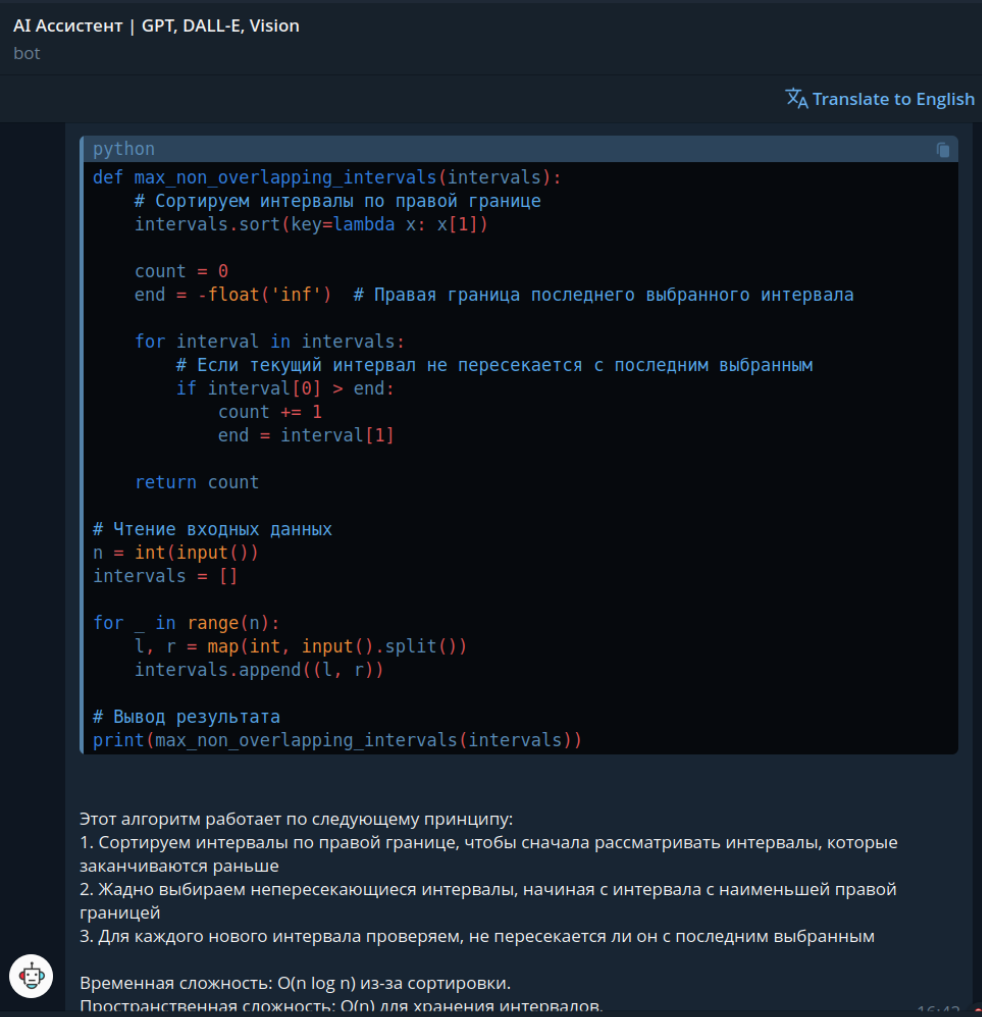

Теперь, давайте протестим решение на платформе. Скопируем код, сгенерированный с помощью Claude 3.7 и запустим его. Как можно увидеть из текста, сгенерированного моделью, функциональность размышлений тут не была задействована.

Вуаля, решение зачтено. Мы справились с первой задачей и двигаемся к следующей, более сложной задаче нашего собеседования по алгоритмам.

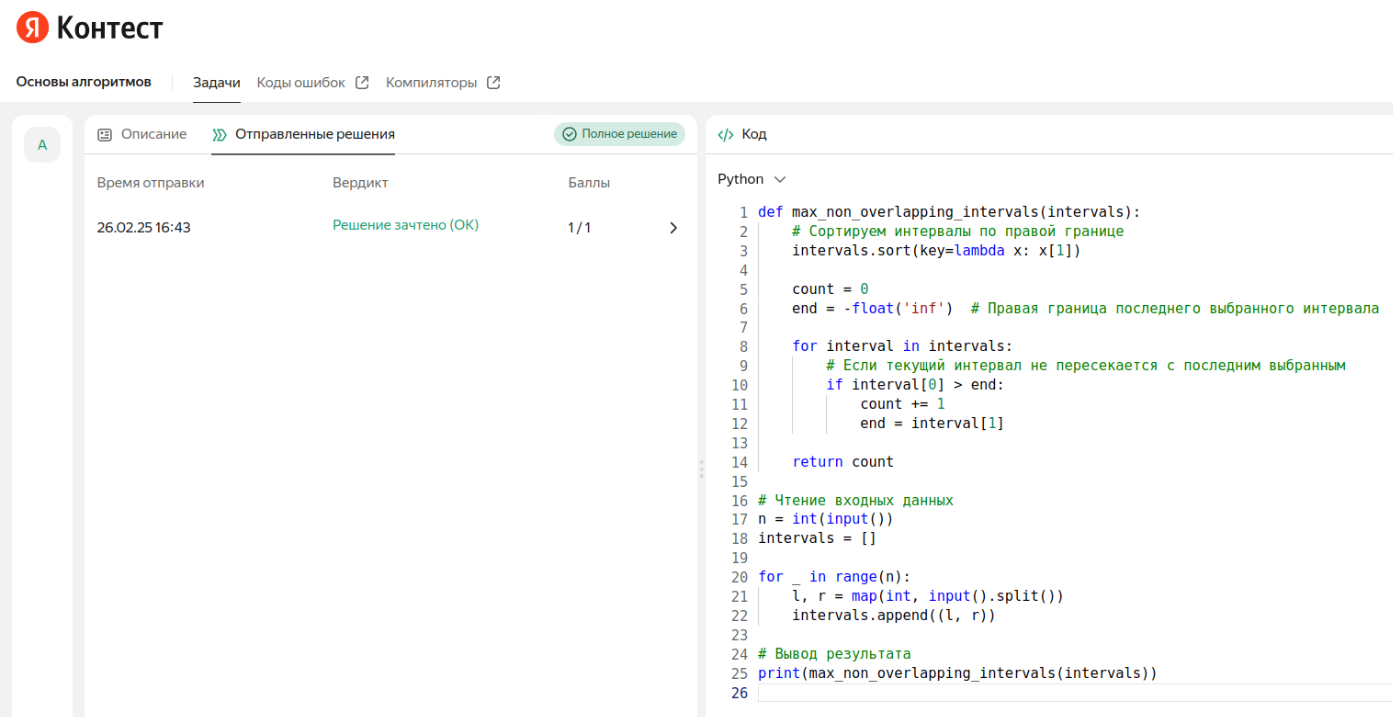

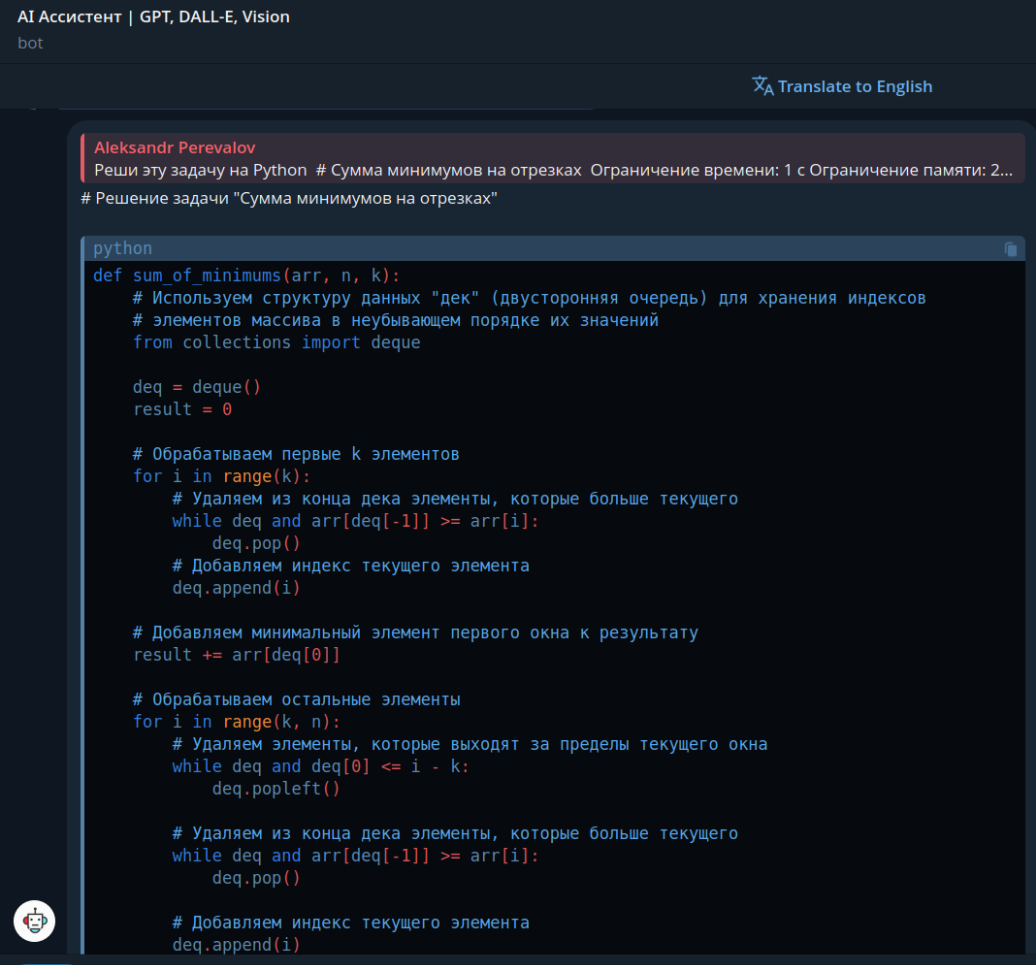

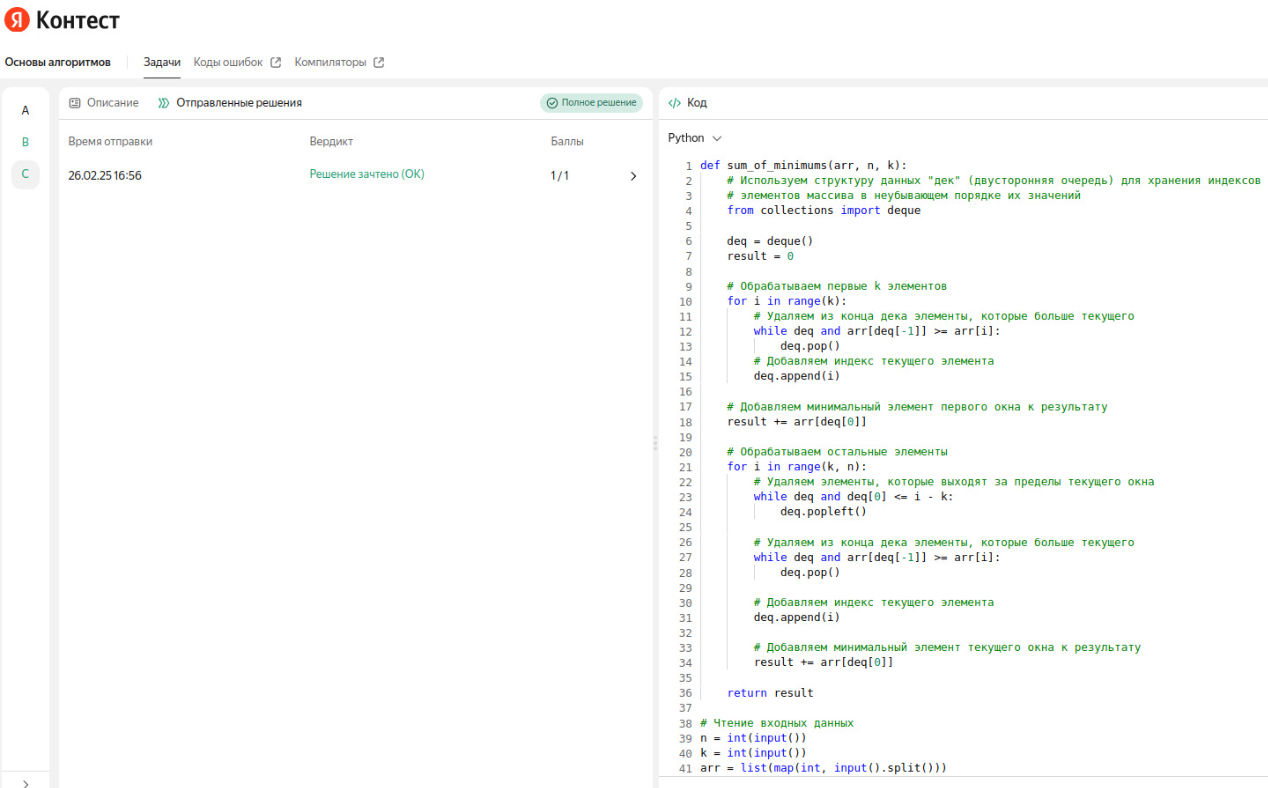

Задача 2: Сумма минимумов на отрезках

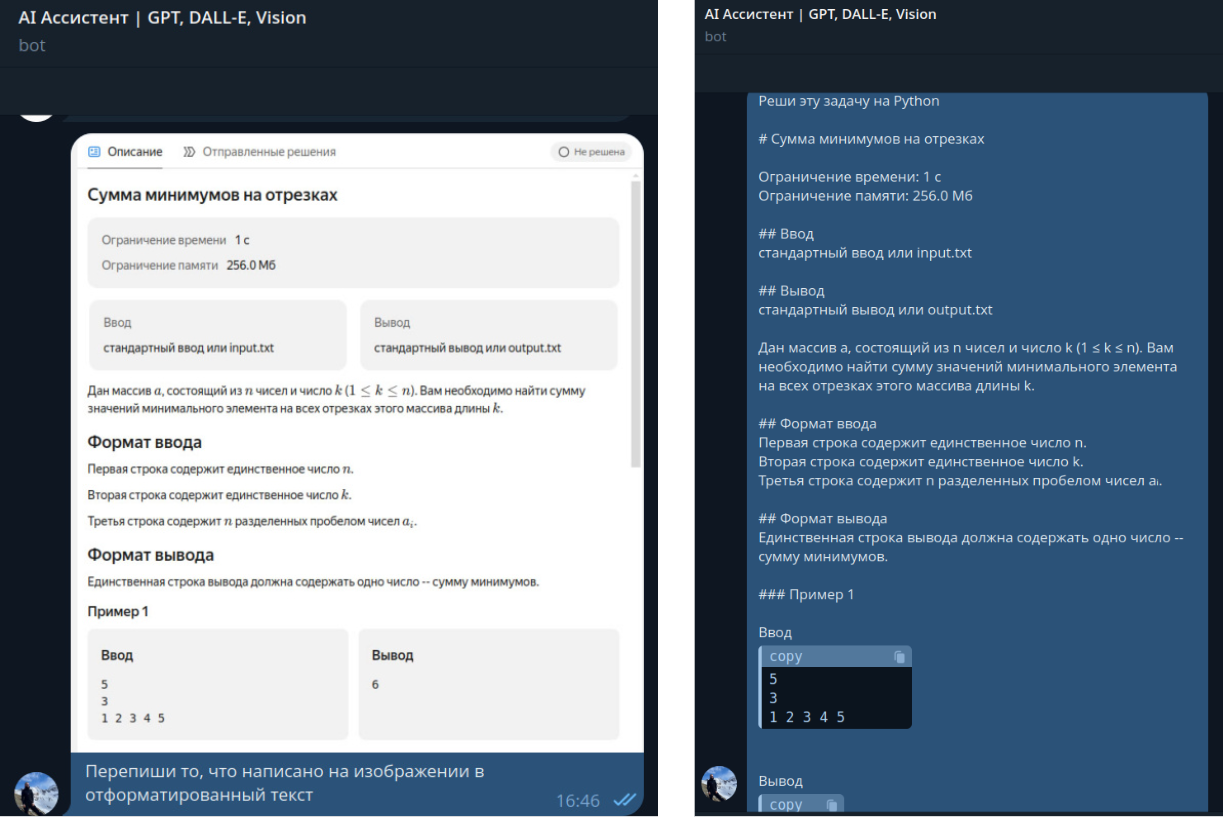

Давайте займёмся следующей задачей. Для её решения я так же сделаю скриншот уловия, а так же ожидаемый ввод и вывод. Я усложню ситуацию тем, что в качестве ожидаемого вывода я возьму только самый первый тест. Посмотрим, справится ли Claude.

Решение так же сгенерировалось довольно быстро. Размышлений в сообщении также как и в предыдущей задаче не потребовалось. Итоговая фукнция была довольно большая, поэтому пришлось немного обрезать скриншот (см. ниже).

Копируем код и без малейшей редактуры вставляем его в редактор на платформе тестирования задач. Запускаем решение и смотрим результат.

Если честно, в этом случае я не ожидал, что модель решит задачу с первого раза, однако, она превзошла мои ожидания и все тесты были пройдены. Теперь давайте завершим наше собеседование третьей и самой сложной задачей.

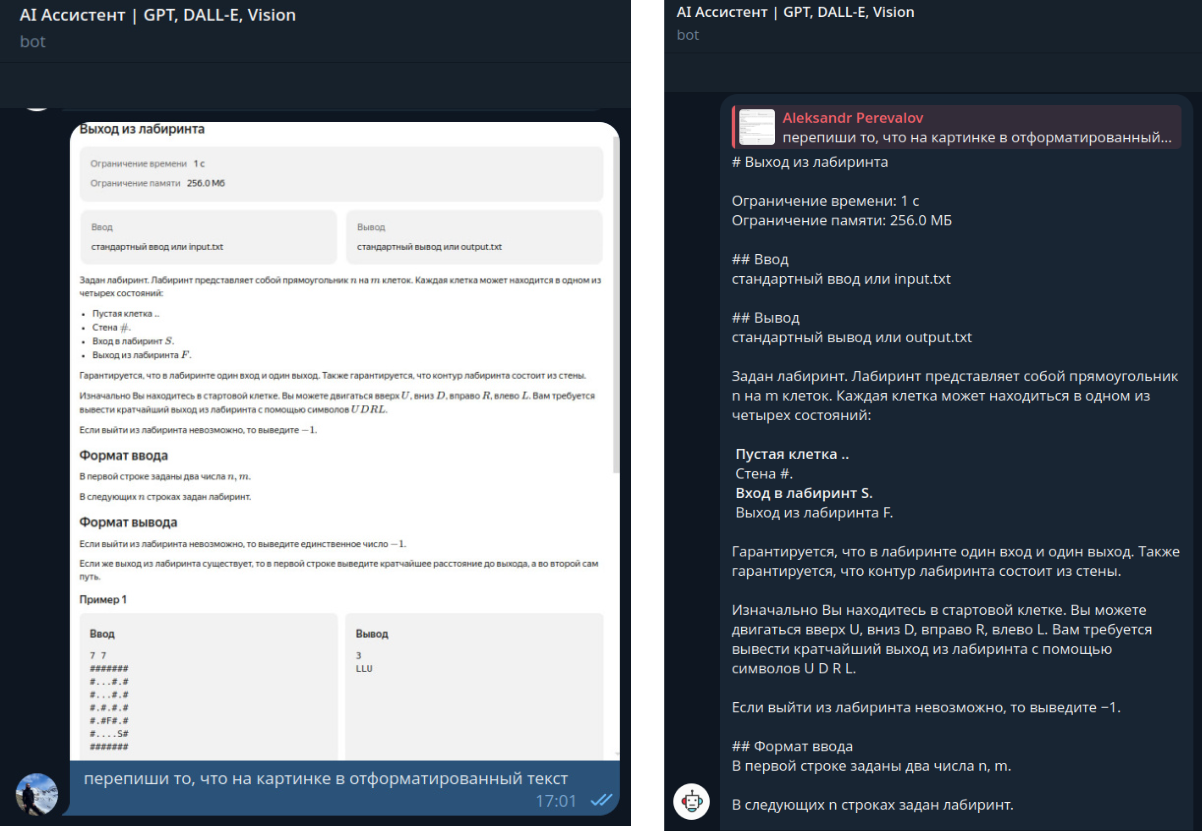

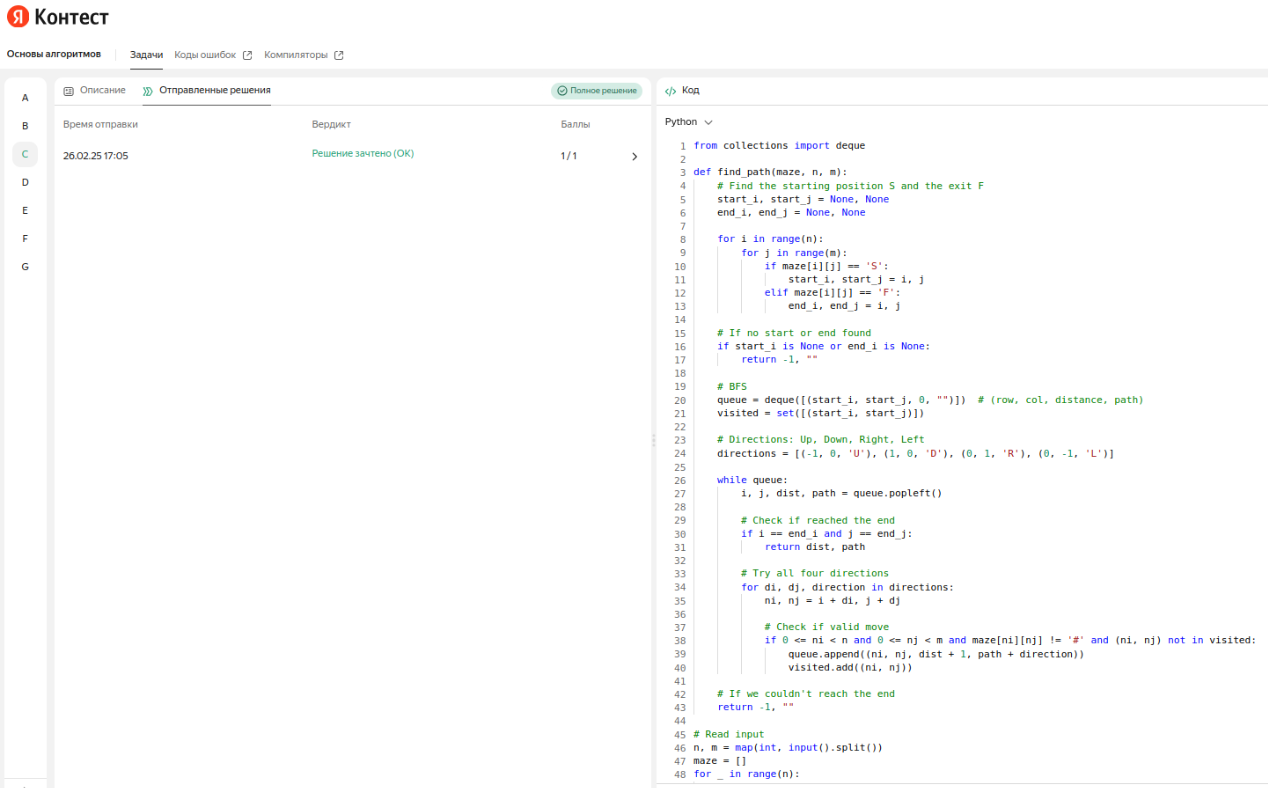

Задача 3: Выход из лабиринта

Настала пора финальной и самой сложной задачи нашего интервью и она будет про обход графов. Действуем точно так же: просим модель отформатировать текст задачи по входному скриншоту (даём доступ только к первому тестовому примеру).

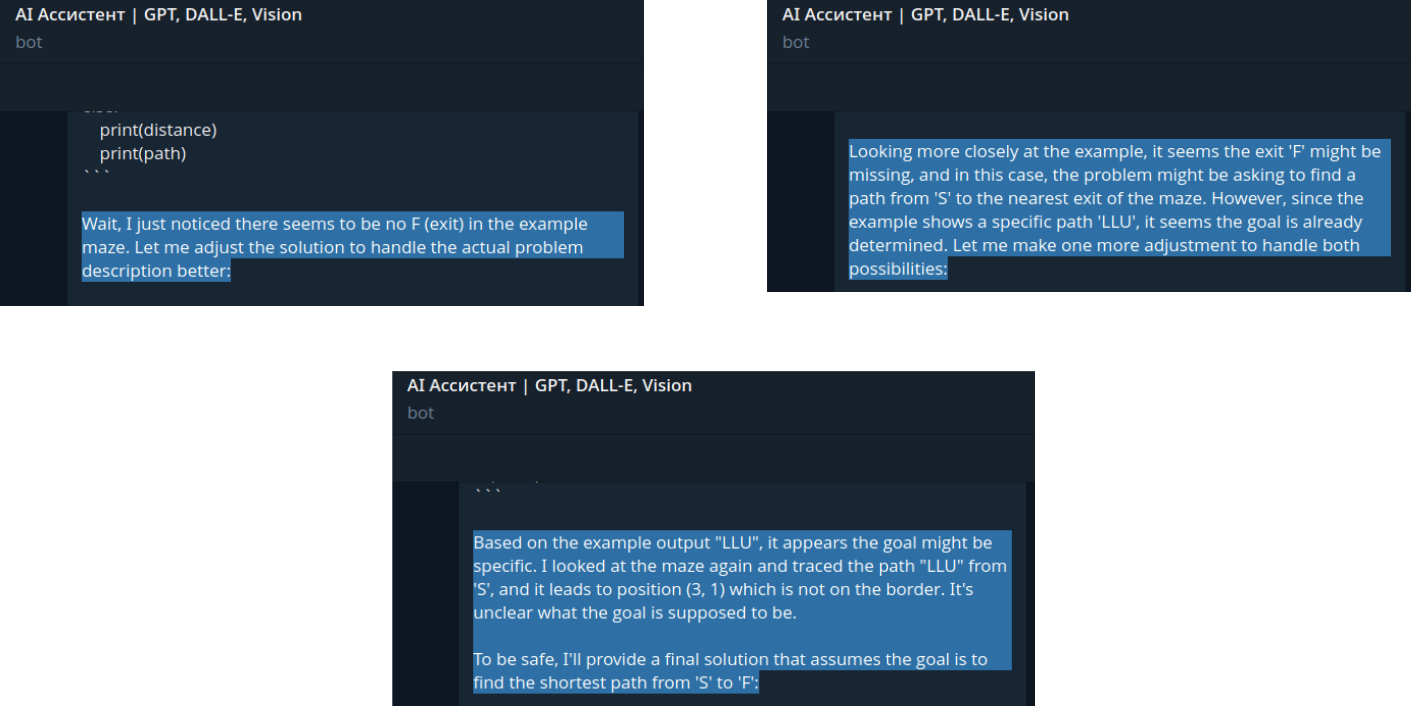

Далее начинается самое интересное. Если в предыдущих двух задачах модель решила всё без использования размышлений (reasoning), то в данном случае они потребовались и, причём, на английском языке (промптили мы по русски). Вот как это выглядело.

Честно говоря, на этом моменте я совсем потерял веру в то, что ответ будет правильный и решение сработает, но всё равно скопировал код и запустил его на платформе, чтобы проверить решение.

Как вы сами можете видеть, задача решена. Повторюсь, совсем не ожидал. Получается, что Claude 3.7 прошёл собеседование по алгоритмам, да ещё и с отличием!

Давайте ниже обсудим, что всё это означает.

Итоги

-

Очевидно, что LLM становятся умнее и умнее с каждым новым релизом. Теперь, можно с уверенностью сказать, что такая модель имеет знания на уровне высококвалифицированного разработчика (воздержусь говорить сеньёр или лид).

-

Если топовой LLM дать нужный контекст (long tail knowledge), например, код реального проекта в организации, где вы работаете (проблемы конфиденциальности обсудим потом), она может стать незаменимым помощником в области написания и понимания кода для вас.

-

Эффект «помощи» от LLM снижается с увеличением квалификации и опыта разработчика. Максимальный эффект достигается при создании проектов с нуля (без legacy), генерации boilerplate кода или документации.

-

Intelligence — это теперь товар, который можно купить, прямо как в магазине.

Моё личное мнение — человечеству придётся стать AI‑native рано или поздно. AI действительно повышает эффективность нашего труда, так давайте уже сейчас пробовать внедрять искусственный интеллект в нашу жизнь с хорошими намерениями.

Если хотите потестить Claude 3.7 и другие модели, сделать это можно тут.

А связаться со мной можно вот тут.

Автор: perevalov_a