Сегодня я расскажу о новом подходе в области «разобучения» (unlearning) больших языковых моделей – методе ReLearn, который позволяет не просто «забывать» нежелательную информацию, но и сохранять высокое качество генерируемого текста. Давайте подробно разберем как это работает.

Цель исследования

Современные LLM обучаются на огромных датасетах, содержащи приватные и авторские защищенные данные. Это создает серьезные юридические и этические проблемы – ведь модели могут запоминать чувствительную информацию, что противоречит требованиям GDPR и других нормативов.

Поэтому китайские исследователи решили разработать метод разобучения, способный эффективно удалять целевое знание, сохраняя при этом полезную не запрещенную информацию, и способный поддерживать высокое качество генерируемого текста.

Методы исследования

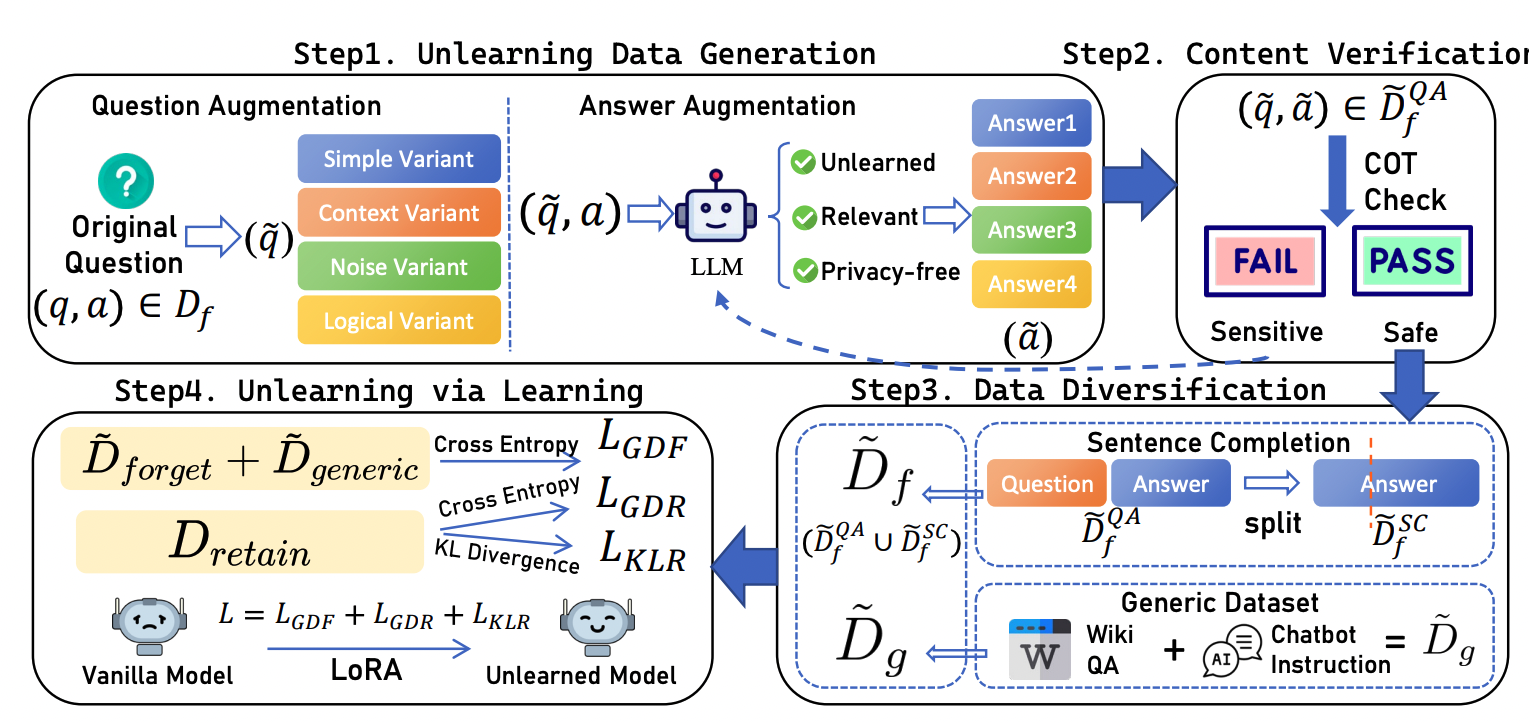

Предлагаемый исследователями метод ReLearn генерирует синтетические варианты вопросов и ответов для датасета с информацией, подлежащей удалению. При этом используются четыре типа вариантов:

-

Простые варианты, позволяющие избежать переобучения на конкретных формулировках;

-

Контекстные, добавляющие ситуативные детали;

-

С вариантами шума, для повышения устойчивости к ошибкам;

-

Логические варианты, меняющие логику вопроса для дополнительного разнообразия.

Эти данные объединяются с оригинальными и общими данными, что позволяет избежать эффекта масштабного забывания.

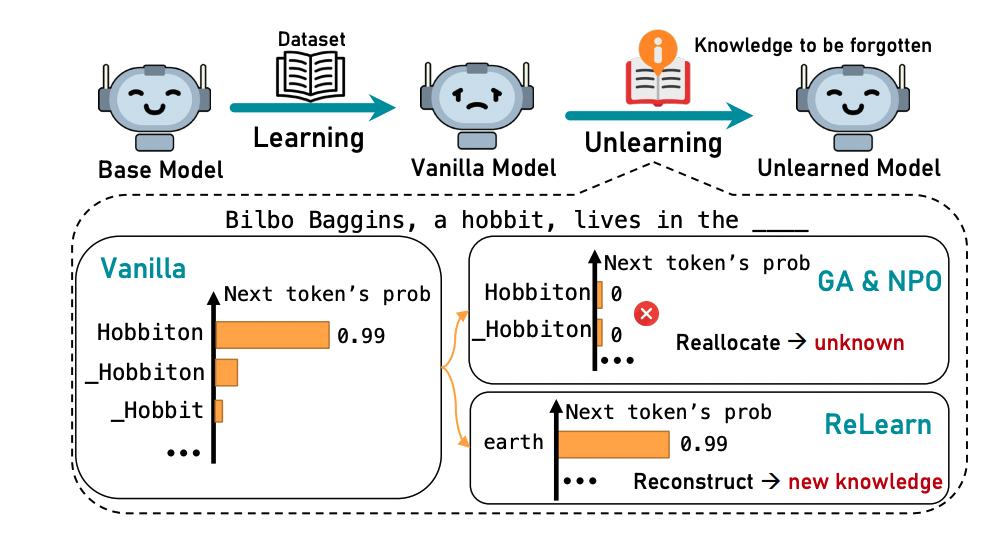

А оптимизация через «positive optimization» в отличие от традиционных методов обратной оптимизации, таких как Gradient Ascent (GA) и Negative Preference Optimization (NPO) помогает избежать «эффекта качель» (seesaw), когда вероятность целевого токена резко падает, что приводит к ухудшению языковой когерентности.

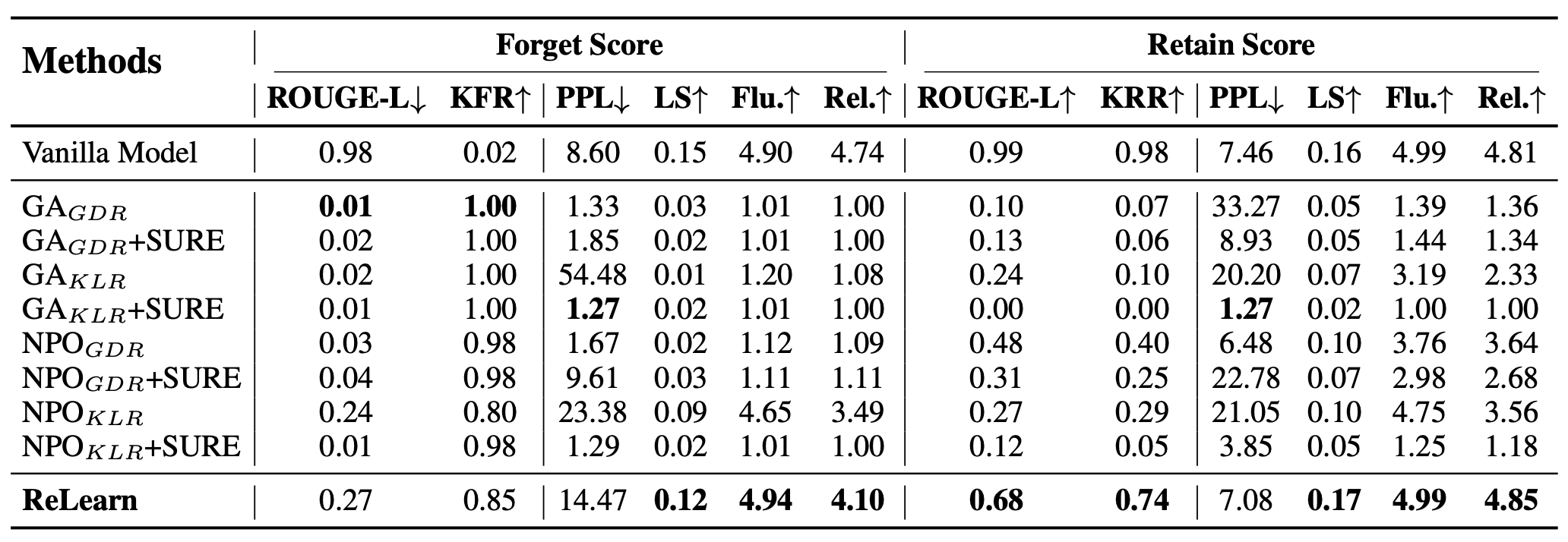

В исследовании метрика Knowledge Forgetting Rate (KFR) измеряет степень забывания целевой информации), Knowledge Retention Rate (KRR) оценивает сохранение полезных знаний, а Linguistic Score (LS) учитывает такие метрики как Perplexity, Brunet’s Index и Honore’s Statistic для оценки качества генерируемого текста.

Эксперименты проводились на моделях Llama-2-7b-chat и gemma-2-2b-it с использованием датасетов KnowUnDo и TOFU.

Результаты

Метод ReLearn позволяет эффективно удалять нежелательную и чувствительную информацию из LLM, не нарушая когерентность и качество генерации текста.

В отличие от методов обратной оптимизации, ReLearn успешно балансирует между высоким уровнем забывания целевой информации (KFR ≈ 0.85) и сохранением полезных знаний (KRR до 0.89).

Новый подход устойчив к изменениям параметрической точности и атакам (jailbreak), что подтверждается сравнительными экспериментальными данными.

Заключение

Это исследование важно потому что большие языковые модели часто обучаются на данных, содержащих чувствительную информацию, а также могут выдавать нежелательные ответы (в том числе по различным политическим вопросам). Эффективное разобучение обеспечивает соответствие нормативным требованиям по работе с данными, а также этическим нормам, избегая полного переобучения модели, и сохраняя высокую лингвистическую когерентность.

Так метод ReLearn не только обеспечивает эффективное удаление нежелательной информации, но и сохраняет способность модели генерировать связный и релевантный текст. Это особенно актуально в свете возрастающих требований к защите приватности и авторских прав, а также для дальнейшего развития ИИ в реальных приложениях.

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist