Hugging Face выпускает небольшую языковую модель, которая в большинстве случаев превосходит Qwen и Llama

Исследовательская группа Hugging Face представила SmolLM2, свою новейшую языковую модель. Несмотря на то, что она не открывает новых горизонтов, она является ценным дополнением к портфолио AI-технологий компании.

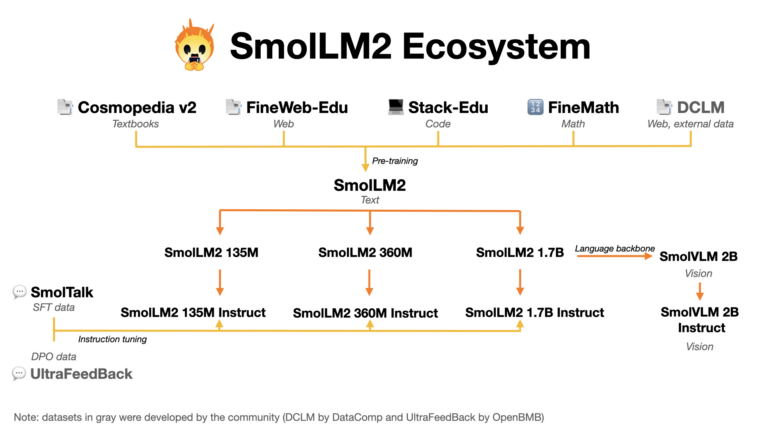

Эффективность модели обусловлена тщательным объединением различных источников для набора данных из 11 триллионов токенов и методичным подходом к обучению [1]. Команда начала со сбалансированного сочетания веб-контента и примеров программирования, а затем добавила специализированные наборы данных для математических задач и программирования.

Исследователи оценивали эффективность модели после каждого этапа обучения, чтобы выявить недостатки, а затем соответствующим образом корректировали обучающие данные. Они создали собственные наборы данных, в том числе FineMath для сложных математических задач, Stack-Edu для хорошо документированного кода и SmolTalk для задач, связанных с общением.

После первоначального обучения команда доработала SmolLM2 с помощью тонкой настройки инструкций и обучения на примерах, чтобы улучшить понимание задач. Они использовали обучение с подкреплением [2], чтобы помочь модели генерировать более подходящие для пользователя ответы.

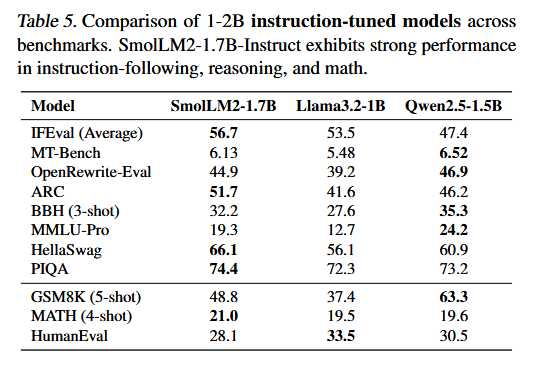

В тестах на знания и понимание SmolLM2 показывает лучшие результаты, чем модели схожего размера, такие как Qwen2.5-1.5B [3] и Llama3.2-1B [4], в нескольких областях, но не во всех.

Помимо основной версии с 1,7 миллиарда параметров, команда разработала две версии поменьше с 360 и 135 миллионами параметров, которые показали хорошие результаты для своего размера.

Hugging Face стал неотъемлемой частью разработки AI с открытым исходным кодом благодаря своему обширному хранилищу весов моделей [5]. Компания стремится активно продвигать исследования, а не просто хранить данные для других.

Компания, поддерживаемая Google [6], недавно выпустила библиотеку AI-агентов [7] и создала альтернативу с открытым исходным кодом [8] для Deep Research от OpenAI [9]. SmolLM2 использует проверенные подходы для создания эффективных языковых моделей благодаря высококачественному набору данных и многоэтапному обучению. Хотя он соответствует аналогичным моделям от Meta* и Qwen, его практическая ценность, вероятно, заключается в выполнении небольших задач на устройствах с ограниченной вычислительной мощностью, таких как смартфоны.

Такое развитие событий кажется естественным шагом для Hugging Face как крупного игрока на рынке AI. В отличие от Meta и Qwen, которые делятся только весами моделей, Hugging Face придерживается полного подхода с открытым исходным кодом, делая свои данные для обучения доступными [10] для всех.

*Meta и её продукты (Instagram, Facebook) запрещены на территории Российской Федерации

Источник [11]

Автор: mefdayy

Источник [12]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12073

URLs in this post:

[1] обучению: http://www.braintools.ru/article/5125

[2] подкреплением: http://www.braintools.ru/article/5528

[3] Qwen2.5-1.5B: https://the-decoder.com/qwen-2-5-alibabas-new-ai-models-challenge-the-competition/

[4] Llama3.2-1B: https://the-decoder.com/metas-new-llama-3-2-brings-tiny-models-to-mobile-devices-and-adds-image-understanding/

[5] благодаря своему обширному хранилищу весов моделей: https://the-decoder.com/hugging-face-is-growing-fast-with-users-creating-new-ai-repositories-every-10-seconds/

[6] Google: https://the-decoder.com/google-cloud-and-hugging-face-join-forces-to-advance-open-source-ai/

[7] библиотеку AI-агентов: https://the-decoder.com/hugging-faces-smolagents-framework-simplifies-building-ai-agents-with-just-a-few-lines-of-code/

[8] альтернативу с открытым исходным кодом: https://the-decoder.com/hugging-face-works-to-replicate-openais-deep-research-capabilities-with-open-source-ai-agent/

[9] Deep Research от OpenAI: https://the-decoder.com/openais-deep-research-aims-to-compress-hours-of-online-research-into-minutes/

[10] данные для обучения доступными: https://huggingface.co/HuggingFaceTB

[11] Источник: https://the-decoder.com/hugging-face-releases-small-language-model-that-beats-qwen-and-llama-most-of-the-time/

[12] Источник: https://habr.com/ru/companies/bothub/news/881230/?utm_source=habrahabr&utm_medium=rss&utm_campaign=881230

Нажмите здесь для печати.