Тесты помогают быстрее и дешевле учить ИИ писать код. Новая работа китайских ученых: TDD для обучения ИИ

Сегодня в HuggingFace Daily papers ачивку “#3 daily paper” завоевала работа китайских исследователей из TigerLab [1]. Мне она показалась настолько логичной и классной, что захотелось побольше рассказать об этой новости.

Итак, при классическом обучении [2] моделей есть этап Supervised Fine-Tuning, на котором люди вручную подготавливают датасет с примерами качественных ответов для ИИ. Собственно, эти примеры используются для до-обучения модели.

Проблема в том, что подготовка таких датасетов — их разметка, проверка и прочие этапы — требует участия человека, а это самый дорогой и ресурсоемкий процесс в обучении искусственного интеллекта [3].

В последнее время мы наблюдаем, что модели, обучаемые без ручной разметки, оказываются дешевле и обучаются быстрее, при таком же уровне качества. Прекрасный пример — DeepSeek R1-Zero, который был обучен исключительно на синтетических данных с использованием механизмов Reinforcement Learning [4], и обошелся в 25 раз дешевле, чем модели с аналогичным качеством.

В чем суть работы

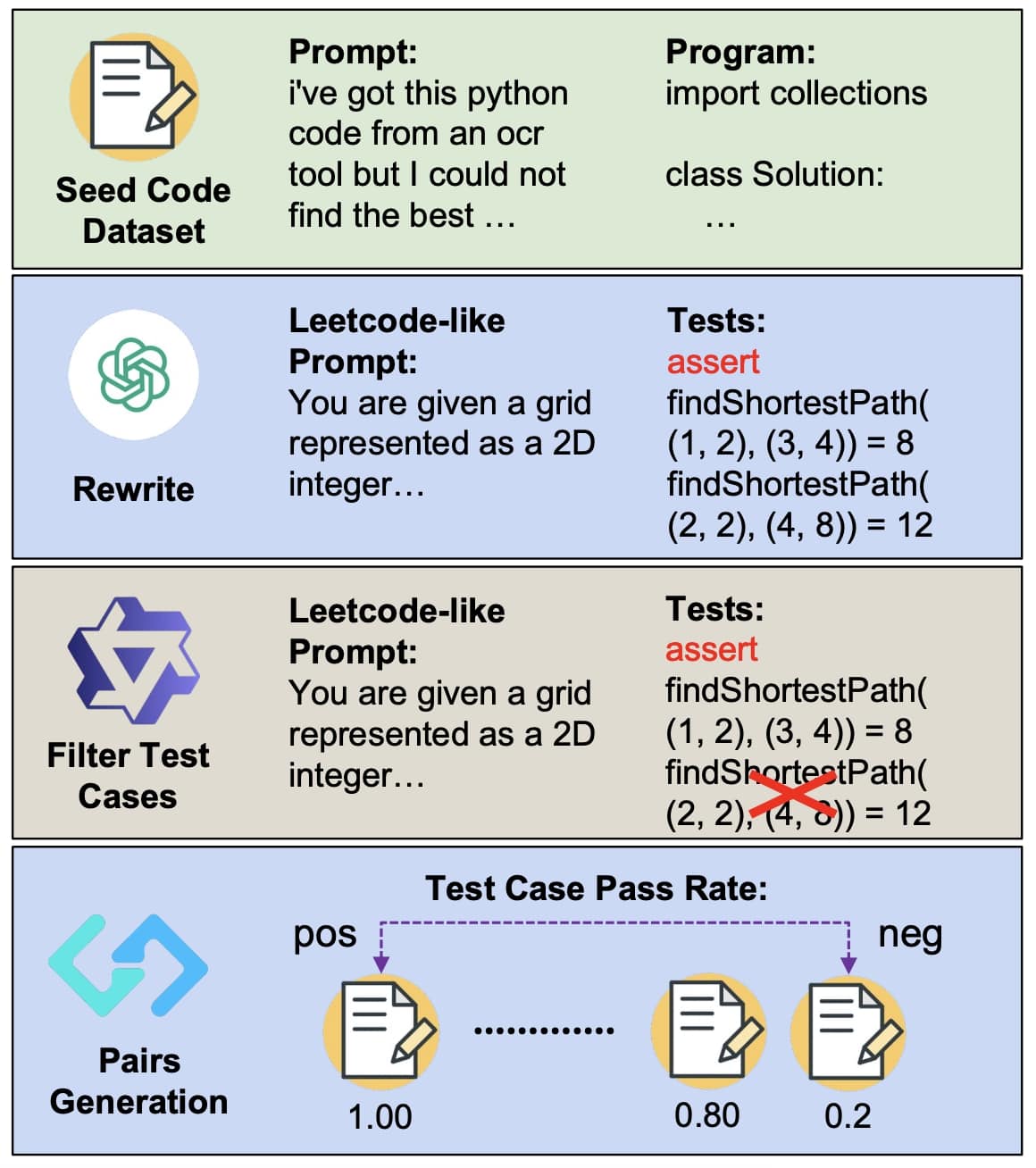

Исследователи использовали ИИ для создания коллекции пар “[задача] + [тесты для её проверки]”. Эта работа не требует больших интеллектуальных способностей ИИ, для написания тестов подходят даже простенькие модели.

Скажем, тест может использовать “наивный” алгоритм с полным перебором, и при этом качественно проверять правильные ли ответы выдает “основной” код.

В частности, используемая авторами методика привела к росту на 10 процентных пунктов производительности модели Llama-3.1-8B-Ins и росту на 5 процентных пунктов Qwen2.5-Coder-7B-Ins, сравняв ее по качеству с гораздо более крупной DeepSeek-V2.5 (236B параметров).

Ещё раз: модель в 7 миллиардов параметров стала выдавать качество модели в 236 миллиардов, в 33 раза большей (справедливости ради, DeepSeek V2.5 – это модель с архитектурой Mixture of Expers [5], и в работе участвует только 21 миллиард параметров, то есть фактический рост в 3 раза).

Кроме того, обучение с подкреплением [6], основанное как на модели вознаграждения, так и на тест-кейсах, позволило добиться повышения точности программирования в нескольких ключевых бенчмарках, таких как HumanEval, MBPP, BigCodeBench и LiveCodeBench. Применение RL привело к улучшению результатов на HumanEval-plus на 25% и MBPP-plus на 6% всего за 80 шагов оптимизации (!), что демонстрирует невероятный потенциал RL в обучении моделей программированию.

Авторы подчеркивают, что их методология позволяет заменить дорогостоящий ручной труд автоматизированными процессами.

Заключение

Я уже много раз в своих статьях, и у себя в канале писал: DeepSeek открыли ящик Пандоры своей R1-Zero, теперь все кинутся искать Reinforcement Learning [7] подходы без участия человека, и, кажется, мы увидим ещё не одну и не две новости на эту тему в 2025 году. Что и прекрасно, я искренне верю, что масштабирование обучения моделей – это сейчас один из главных барьеров на пути к более качественному ИИ.

—-

P.S. Все громкие новости про ИИ, которые попадают в заголовки медиа обычно вырастают из таких “тихих” революционных исследований. Чтобы узнавать о них раньше всех надо регулярно мониторить HuggingFace Daily papers [8]/arXiv recents [9]/GitHub Trending [10]/прочие исследовательские площадки.

Я делаю это на ежедневной основе, и если нахожу такие алмазы – пишу про них у себя в Телеграм канале [11], вместе с глубокой аналитикой по тому, как это всё влияет на бизнес.

Автор: ElKornacio

Источник [12]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11905

URLs in this post:

[1] работа китайских исследователей из TigerLab: https://huggingface.co/papers/2502.01718

[2] обучении: http://www.braintools.ru/article/5125

[3] интеллекта: http://www.braintools.ru/article/7605

[4] Reinforcement Learning: http://elkornacio.com/ru/ai/rl

[5] Mixture of Expers: https://elkornacio.com/ru/ai/moe

[6] подкреплением: http://www.braintools.ru/article/5528

[7] Reinforcement Learning: https://elkornacio.com/ru/ai/rl

[8] HuggingFace Daily papers: https://huggingface.co/papers

[9] arXiv recents: https://arxiv.org/list/cs/recent

[10] GitHub Trending: https://github.com/trending

[11] у себя в Телеграм канале: https://t.me/+D3rczrDV9w40N2Zi

[12] Источник: https://habr.com/ru/news/879826/?utm_source=habrahabr&utm_medium=rss&utm_campaign=879826

Нажмите здесь для печати.