Мануал по запуску полной модели DeepSeek-R1 локально (бюджет ~6k$)

Давеча наткнулся в экс-Твиттере на интересный тред (https://x.com/carrigmat/status/1884244369907278106?s=52 [1]) о том, как запустить самую мощную (на сегодня) ИИ reasoning модель DeepSeek-R1 прямо у себя под столом.

DeepSeek-R1 — это одна из топовых моделей (из Китая), наделавших много шума (и не только), для задач логики, математики [2] и программирования. Она настолько умная, что может (с некоторыми оговорками) “конкурировать” с решениями от OpenAI, но при этом её можно запустить локально, без интернета, без смс и полностью контролировать весь процесс.

Почему это круто?

* все данные остаются с вами, никакие сторонние сервисы не получат доступ к вашим запросам.

* запуск на своём железе избавляет от затрат на облачные сервисы.

* модель способна решать сложные задачи и выдавать результаты на уровне профессионалов.

В статье я расскажу:

* какое оборудование нужно для запуска DeepSeek-R1.

* чем локальный запуск отличается от серверного.

* какие возможности открывает эта модель и как она может быть полезна.

* как сохранить безопасность и приватность при работе с ИИ.

В этом мануале описано, как настроить локальный запуск модели DeepSeek-R1 Q8, сохраняя максимальное качество и производительность без дистилляции или уменьшенной квантизации. Общая стоимость сборки составит около ~$6,000, и ниже приведены все необходимые ссылки на компоненты и инструкции.

Требования к оборудованию

Для запуска DeepSeek-R1 (размер модели — 650 ГБ) с Q8 квантизацией система должна быть ориентирована на объем памяти [3], пропускную способность и возможности процессора.

Ссылки взяты так же с треда, аналоги думаю можно поискать на сайтах дэнээсов, ситилинков.

Вот подробный список:

1. Материнская плата

-

Модель: Gigabyte MZ73-LM0 или MZ73-LM1

-

Причина: Эти материнские платы поддерживают два сокета AMD EPYC, что позволяет использовать 24 канала DDR5 памяти, максимально увеличивая объем и пропускную способность.

🔗 Материнская плата Gigabyte MZ73-LM0 или MZ73-LM1 [4]

2. Процессоры (CPU)

AMD EPYC 5th Gen 9005 Series (Sixteen-Core) 16 Core – Model 9115 AMD – EPYC – Processor / Number: 9115 – Processor / Clock Speed: 2.6 – Total Threads: 32 – Socket SP5 – L3 Cache – 64MB Memory – OEM

-

Модель: 2x AMD EPYC 9004 или 9005 (например, EPYC 9115 или 9015 для экономии).

-

Почему: Инференс больших языковых моделей (LLM) ограничен пропускной способностью памяти, а не мощностью процессора. Бюджетные модели, такие как 9115 или 9015, вполне подходят для этой задачи.

🔗 AMD EPYC 9115 CPU [5]

3. Оперативная память (RAM)

-

Требование: Всего 768 ГБ через 24 канала DDR5 RDIMM.

-

Конфигурация: Используйте 24 модуля по 32 ГБ DDR5 RDIMM для максимальной пропускной способности памяти.

-

Примеры:

4. Корпус

-

Модель: Enthoo Pro 2 Server Edition (или аналогичный).

-

Почему: Убедитесь, что корпус совместим с серверными материнскими платами и предоставляет достаточно места для охлаждения.

🔗 Корпус Phanteks Enthoo Pro 2 Server Edition [8]

5. Блок питания (PSU)

-

Модель: Corsair HX1000i (1000Вт, полностью модульный).

-

Почему: Этот блок питания обеспечивает достаточную мощность для двух процессоров и включает все необходимые кабели питания.

🔗 Corsair HX1000i PSU [9]

6. Система охлаждения

-

Модель: Совместимый с сокетом SP5 кулер для AMD EPYC.

-

Рекомендация:

-

Дополнительные вентиляторы: Замените вентиляторы кулера на Noctua NF-A12x25 PWM для более тихой работы.

🔗 Noctua NF-A12x25 PWM Fans [11]

7. SSD

-

Требование: 1 ТБ (или больше) NVMe SSD.

-

Почему: Быстрые накопители необходимы для загрузки 700 ГБ весов модели в оперативную память.

🔗 Примеры SSD [12]

Настройка ПО

После сборки оборудования нужно настроить программное обеспечение для локального запуска DeepSeek-R1 Q8.

1. Установка llama.cpp

llama.cpp — это фреймворк для инференса LLM, таких как DeepSeek-R1, локально.

-

Инструкция: Следуйте руководству в репозитории GitHub.

-

🔗 llama.cpp GitHub [13]

2. Скачивание модели DeepSeek-R1

-

Размер модели: 650 ГБ (Q8 квантизация).

-

Источник: Hugging Face.

-

Скачивание: Скачайте все файлы из папки Q8_0.

-

🔗 DeepSeek-R1 GGUF Model Files [14]

3. Запуск модели

Используйте следующую команду для тестирования:

llama-cli -m ./DeepSeek-R1.Q8_0-00001-of-00015.gguf --temp 0.6 -no-cnv -c 16384 -p "<|User|>How many Rs are there in strawberry?<|Assistant|>"

-

Ожидаемый результат: Ответ модели в режиме реального времени, демонстрирующий её возможности.

Производительность и улучшения

Производительность

-

Скорость генерации: 6-8 токенов в секунду в зависимости от процессора и скорости памяти.

-

Длина контекста: При 768 ГБ ОЗУ можно достичь 100,000 токенов длины контекста.

Использование GPU (опционально)

-

Для ускорения генерации можно использовать GPU. Однако:

-

Q8 квантизация: Требуется 700 ГБ видеопамяти, что стоит ~$100,000.

-

Частичная загрузка: Можно загрузить часть модели (например, 300 ГБ) на GPU для ускорения инференса, всё что ниже 300 гб, не даст особого буста по отношению к кпу сетапу.

-

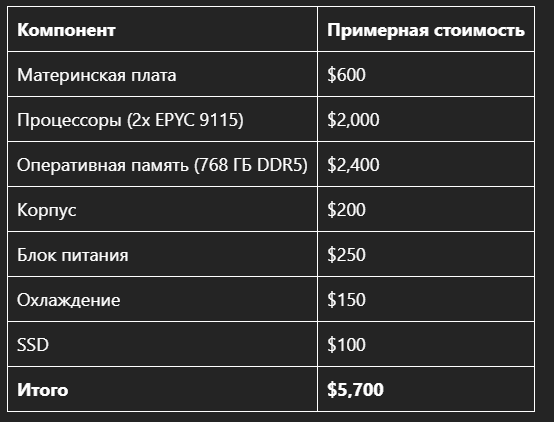

Итоговая стоимость

itog

С этой сборкой вы сможете запускать DeepSeek-R1 Q8 локально, достигая передовой производительности LLM без использования внешних серверов или GPU. Система оптимизирована для пропускной способности памяти и объёма, что гарантирует плавную и эффективную работу даже с самыми крупными моделями.

И по классике мой канал [15]в тгшечке, для тех, кому интересно.

Автор: took_the_lead

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11683

URLs in this post:

[1] https://x.com/carrigmat/status/1884244369907278106?s=52: https://x.com/carrigmat/status/1884244369907278106?s=52

[2] математики: http://www.braintools.ru/article/7620

[3] памяти: http://www.braintools.ru/article/4140

[4] Материнская плата Gigabyte MZ73-LM0 или MZ73-LM1: https://www.gigabyte.com/

[5] AMD EPYC 9115 CPU: https://www.newegg.com/p/N82E16819113865

[6] Nemix 384GB DDR5 RDIMM Kit: https://www.newegg.com/nemix-ram-384gb/p/1X5-003Z-01FM7

[7] v-color DDR5 ECC RDIMM Modules (32GB): https://v-color.net/products/ddr5-ecc-rdimm-servermemory?variant=44758742794407

[8] Корпус Phanteks Enthoo Pro 2 Server Edition: https://www.newegg.com/black-phanteks-enthoo-pro-2-server-edition-full-tower/p/N82E16811854127

[9] Corsair HX1000i PSU: https://www.corsair.com/us/en/p/psu/cp-9020259-na/hx1000i-fully-modular-ultra-low-noise-platinum-atx-1000-watt-pc-power-supply-cp-9020259-na

[10] AMD SP5 CPU Heat Sink 4U H13SSL: https://www.ebay.com/itm/226499280220

[11] Noctua NF-A12x25 PWM Fans: https://www.newegg.com/noctua-nf-a12x25-pwm-case-fan/p/1YF-000T-000K7

[12] Примеры SSD: https://www.newegg.com/

[13] llama.cpp GitHub: https://github.com/ggerganov/llama.cpp

[14] DeepSeek-R1 GGUF Model Files: https://huggingface.co/unsloth/DeepSeek-R1-GGUF/tree/main

[15] канал : https://t.me/hardupgrade

[16] Источник: https://habr.com/ru/articles/877832/?utm_source=habrahabr&utm_medium=rss&utm_campaign=877832

Нажмите здесь для печати.