Насколько RTX 2080 Ti подходит для ML-задач? Изучаем бенчмарки

Когда NVIDIA представила видеокарты [1] семейства GeForce® RTX™ 20 в 2018 году, стало ясно, что новые чипы с архитектурой NVIDIA Turing™ кардинально изменят подход к вычислениям. Благодаря множеству нововведений, новые видеокарты стали значительно производительнее предыдущего поколения. При этом GPU 20 серии поддерживают и работу новых технологий, которые анонсировали с выходом GeForce® RTX™ 30. Разберемся, какие видеокарты будут оптимальным выбором для ML-задач. Под катом — реальные примеры и результаты бенчмарков.

Используйте навигацию, если не хотите читать текст полностью:

→ Почему выбор пал на RTX™ 2080 Ti [2]

→ Может, сэкономить и купить GTX™ 1080? [3]

→ RTX™ 2080 Ti для ML-моделей: пример с Whisper [4]

→ Тестирование на реальных задачах [5]

→ Эффективность работы GPU с различными настройками [6]

→ RTX™ 2080 Ti дешевле GTX™ 1080? [7]

→ Заключение [8]

Почему выбор пал на RTX™ 2080 Ti

RTX™ 2080 Ti — флагман 20 поколения, который выделяется на фоне остальных моделей линейки. Благодаря высокой производительности она подходит для инференса моделей, обработки больших объемов данных и решения профессиональных графических задач, таких как рендеринг или конвертация видео.

Сердце GeForce® RTX™ 2080 Ti — мощный графический процессор с 4352 ядрами CUDA и возможностью повышения частоты до 1635 МГц. В числе других особенностей модели:

- архитектура NVIDIA Turing™,

- 544 тензорных ядра,

- 11 ГБ памяти [9] GDDR6 с шириной шины 352 бит.

NVIDIA GeForce® RTX™ 2080 Ti. Источник [10].

Что касается флагманских видеокарт 30 поколения, они, безусловно, более производительны, однако их цена по-прежнему остается высокой. Стоимость на RTX™ 2080 Ti заметно уменьшилась с выходом новых поколений, что делает карту одним из лучших вариантов по соотношению цена/качество.

Может, сэкономить и купить GTX™ 1080?

Если вы ищете бюджетное решение, GTX™ 1080 по-прежнему справляется с базовыми задачами в ML, особенно с небольшими моделями и объемами данных. Мы подробно рассказывали о ней и изучали бенчмарки в отдельном обзоре [11].

Сравнение 1080 и 2080

- GTX™ 1080 построена на архитектуре Pascal, в то время как RTX™ 2080 Ti — на архитектуре Turing™. Помимо прочего, последняя отличается поддержкой технологии трассировки и искусственного интеллекта [12].

- У GeForce® RTX™ 2080 Ti больше ядер CUDA, выше частоты памяти и ядра, что обеспечивает лучшую производительность по сравнению с GTX™ 1080.

- RTX™ 2080 Ti обладает большим объемом видеопамяти GDDR6, чем GTX™ 1080.

- RTX™ 2080 Ti — более дорогой вариант по сравнению GTX™ 1080.

- У GTX™ 1080 ниже энергопотребление.

Проведем тестирование

Возьмем три конфигурации облачных серверов [13] с разными видеокартами и прогоним через GeekBench и AI-Benchmark.

Конфигурации облачных серверов для тестирования.

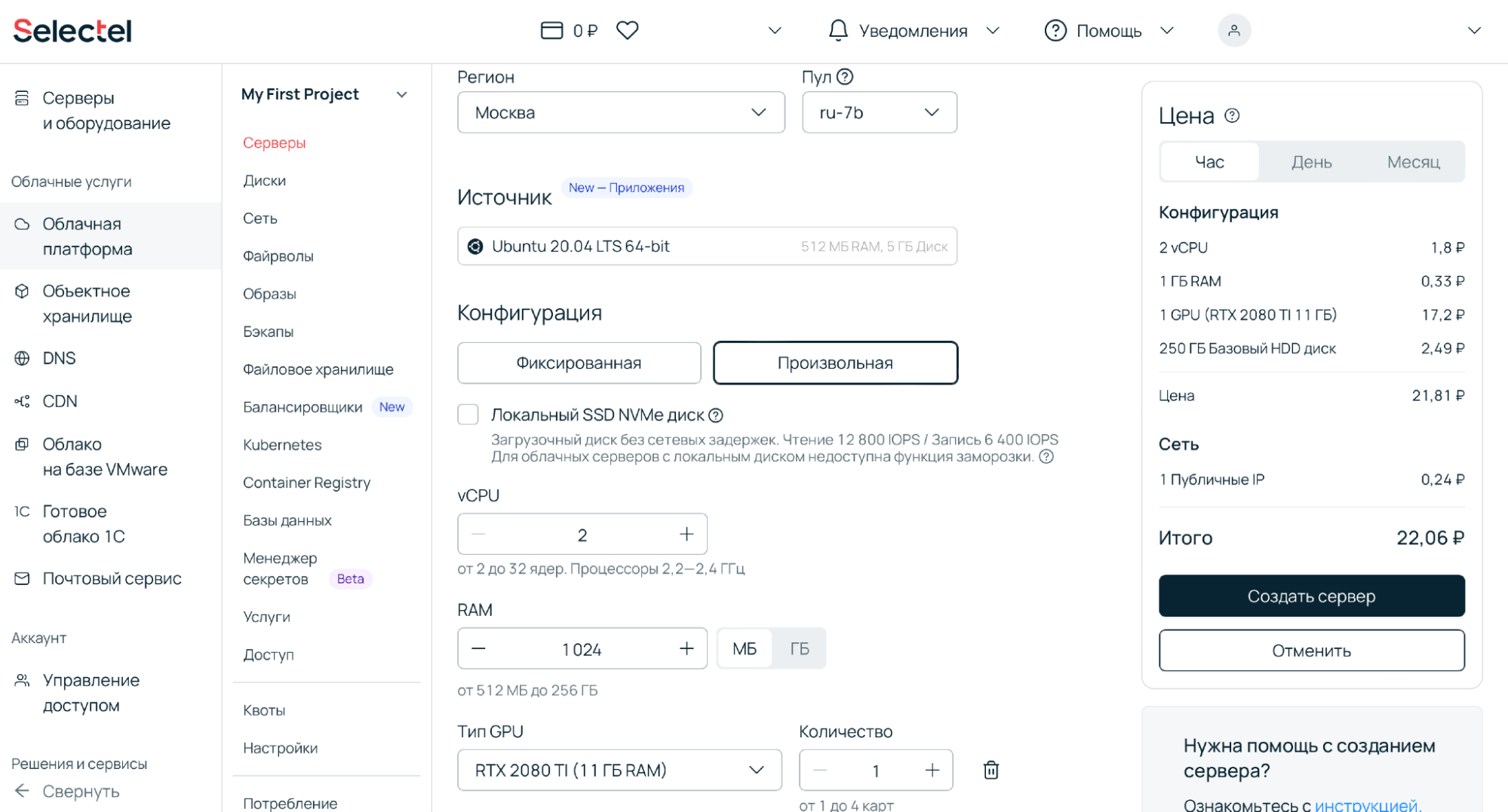

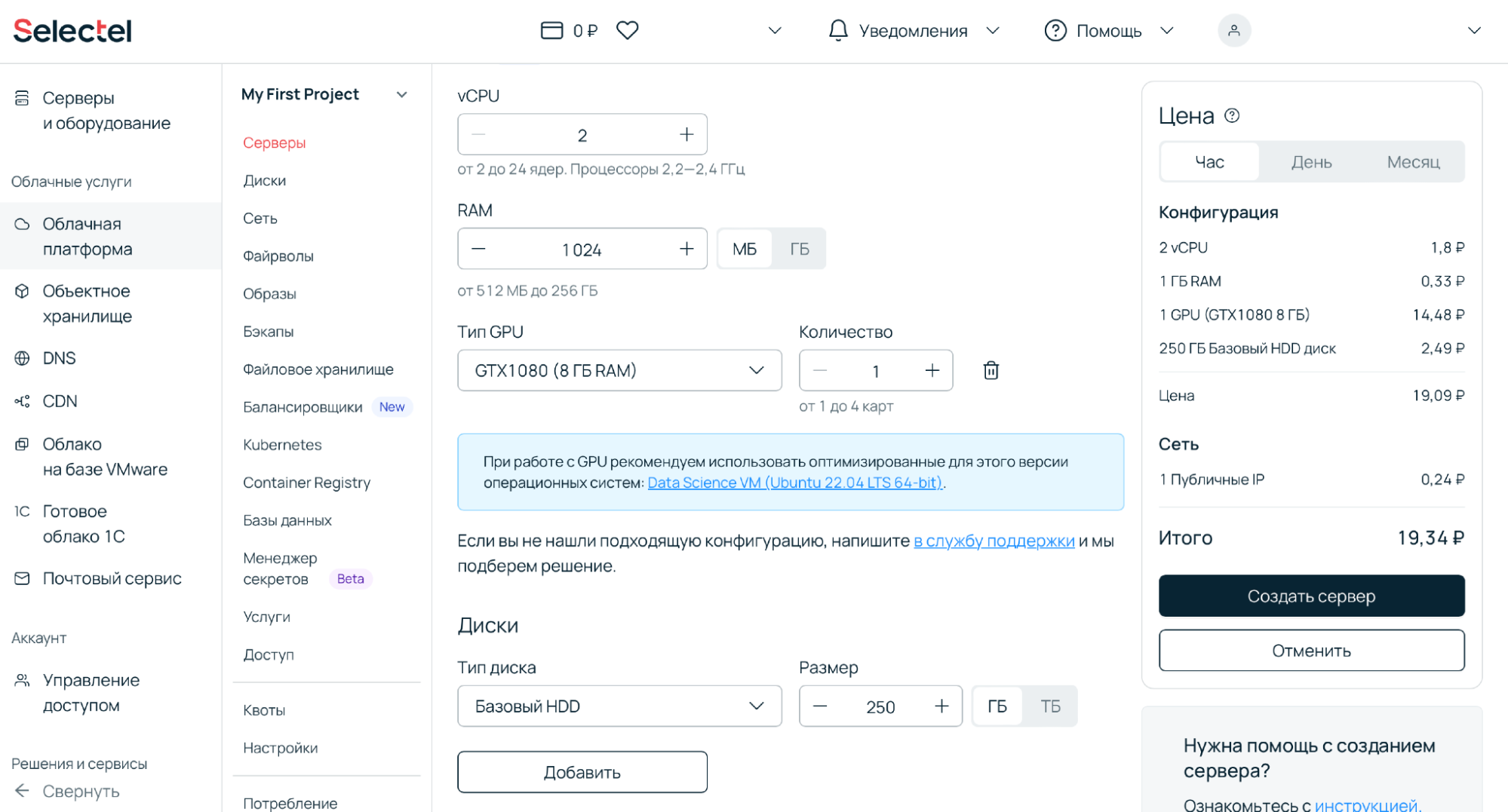

1. В панели управления [14] переходим в раздел Облачная платформа, нажимаем Создать сервер.

2. Выбираем конфигурацию в пуле ru-7b: RTX™ 2080 Ti 8 ГБ, RAM 24 ГБ, 8 vCPU. Для примера: такая конфигурация будет стоить всего около 22 ₽/час. Точную стоимость можно узнать в конфигураторе [15] облачных серверов.

3. Аналогично с предыдущим шагом, создаем сервер с A2000. По стоимости это ближайший конкурент

4. Создаем третий сервер — с GTX™ 1080 на борту.

5. Устанавливаем GeekBench [16] и AI-Benchmark [17], запускаем тестирование. О том, как это сделать, можно узнать в документации Primate Labs [18] и описании в PyPi [19].

Анализируем бенчмарки

AI-Benchmark

Рассмотрим ключевые результаты в AI-Benchmark.

| GPU | GTX™ 1080 | A2000 | RTX™ 2080 Ti |

| Device Inference Score | 8506 | 9236 | 13916 |

| Device Training Score | 8114 | 9948 | 14306 |

| Device AI Score | 16620 | 19184 | 28222 |

Результаты сравнения конфигураций, AI-Benchmark.

Как и ожидалось, наиболее высокие показатели у RTX™ 2080 Ti. Далее — A2000 и GTX™ 1080. Рассмотрим результаты конфигураций покажут видеокарты в других задачах.

GeekBench

Отбираем значения и собираем в сводную таблицу:

| GPU | GTX™ 1080 | A2000 | RTX™ 2080 Ti |

| Background Blur | 41779 | 36117 | — |

| Face Detection | 23845 | 24411 | 35729 |

| Gaussian Blur | 109727 | 85383 | 173454 |

Подробнее с результатами можно ознакомиться в онлайн-выгрузках: RTX™ 2080 Ti [20], GTX™ 1080 [21] и A2000 [22]. Описания параметров можно найти в документации GeekBench [23].

GTX™ 1080 — действительно хорошая бюджетная видеокарта, однако стоит учитывать, что она уступает по характеристикам более дорогим оппонентам. Однако такой вывод мы можем сделать лишь по характеристикам и бенчмаркам, без опоры на реальные задачи. На практике аренда GTX™ 1080 может быть менее выгодной, чем, например, RTX™ 2080 Ti. Как и почему так может случиться — разберем на конкретном кейсе.

RTX™ 2080 Ti для ML-моделей: пример с Whisper

Whisper — популярная ML-модель с открытым исходным кодом, которая хорошо справляется с задачами распознавания речи. Однако важно учитывать, что ее производительность больше зависит от вычислительных возможностей GPU (выражается в tflops), чем от объема памяти. Это значит, что более дорогая видеокарта с большим количеством видеопамяти может не оправдать свою стоимость, если ее пропускная способность не будет полностью задействована.

Для оценки производительности можно использовать подход на основе стоимости одной минуты распознанного аудио. Например, вы тестируете модель на эталонном файле с известными характеристиками, а затем рассчитываете, сколько стоит обработка одного часа записи. Однако, чтобы получить более точные результаты, лучше использовать набор из реальных аудиофайлов с разным уровнем шума, длиной, количеством тишины и т. д. Такой метод позволяет учесть сценарии реального использования и прогнозировать затраты на обработку данных в долгосрочной перспективе.

Тонкости работы с Whisper

Одна из сложностей использования Whisper — настройка параметра batch, который влияет на производительность и скорость обработки. Его оптимальный размер приходится подбирать вручную, поскольку он зависит от объема доступной памяти GPU и особенностей модели. WhisperX, модификация Whisper, частично решает эту проблему, предлагая более удобные функции гибкой настройки параметров.

Тестирование на реальных задачах

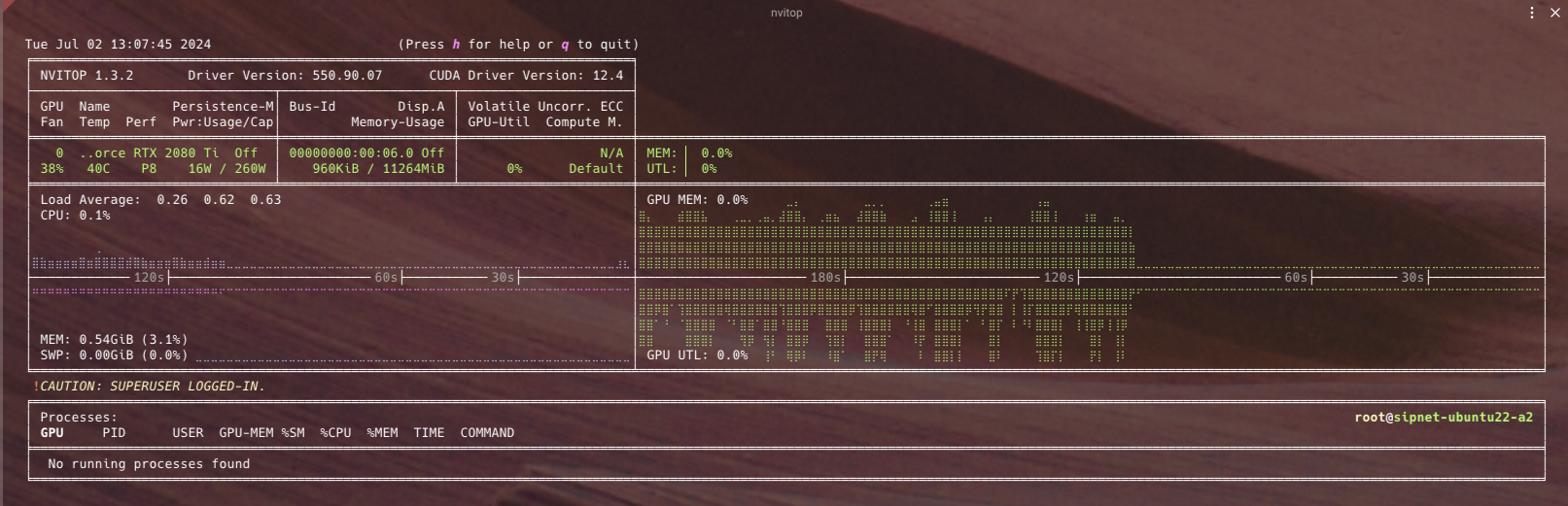

Для проведения тестов выбрали инструмент nvitop [24]. Среди плюсов последнего — информативный интерфейс, возможность мониторинга ресурсов, множество функций, API для разработки новых инструментов, а также встроенный инструмент CUDA Visible Devices Selection Tool [25] для DL-исследований.

Тестирование решили проводить на задаче обработки аудиофайлов для автоматической транскрипции и сегментации с использованием библиотеки pyannote.audio. Задача включала:

- загрузку аудиофайлов длиной 1-20 минут,

- предобработку данных,

- применение модели Wav2Vec2 для расшифровки аудио,

- построение временной сегментации.

Тесты выполняли в контейнере с CUDA 11.8 и предустановленными инструментами для работы с моделями глубокого обучения [26]. Видеокарты выбрали под разный бюджет: A100 (40 ГБ), A5000, Tesla® T4, GTX™ 1080 и RTX™ 2080 Ti.

Арендуйте профессиональные видеокарты [27] со скидкой: −29% на NVIDIA A100 (40 ГБ) и −44% на NVIDIA A30. Подойдут для обучения нейросетей, решения сложных AI-вычислений, ускорения рабочих нагрузок и инференса.

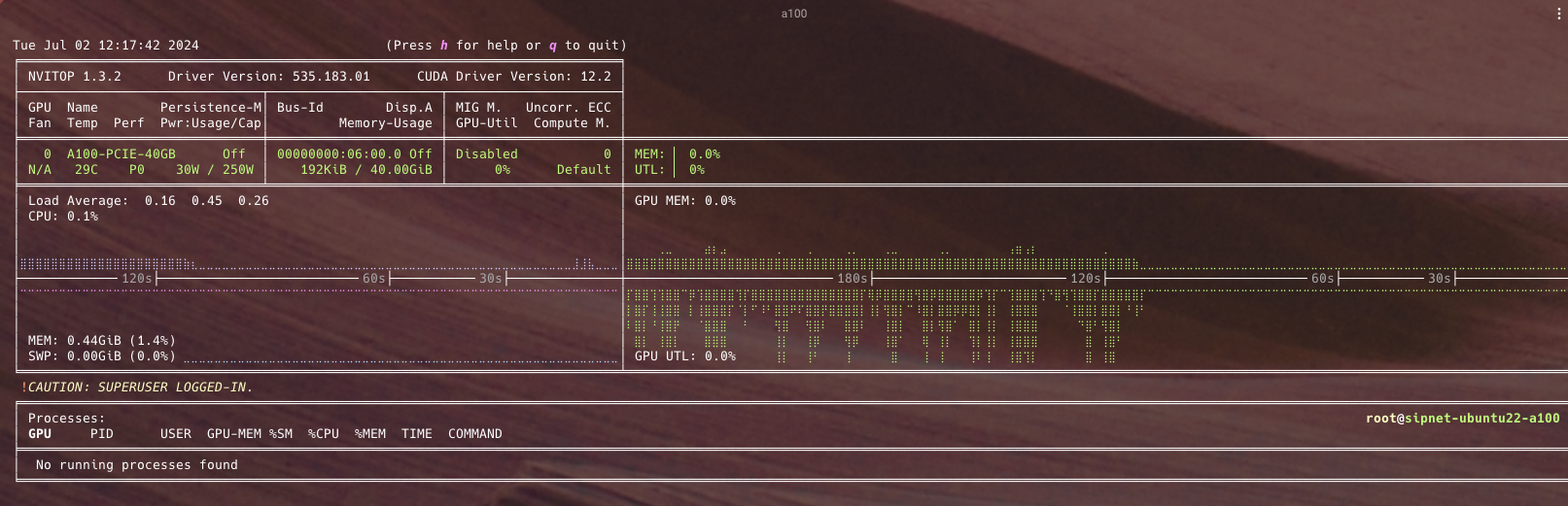

A100 (40 ГБ)

Время выполнения: 4 мин., 31.083 сек.

Вывод nvitop:

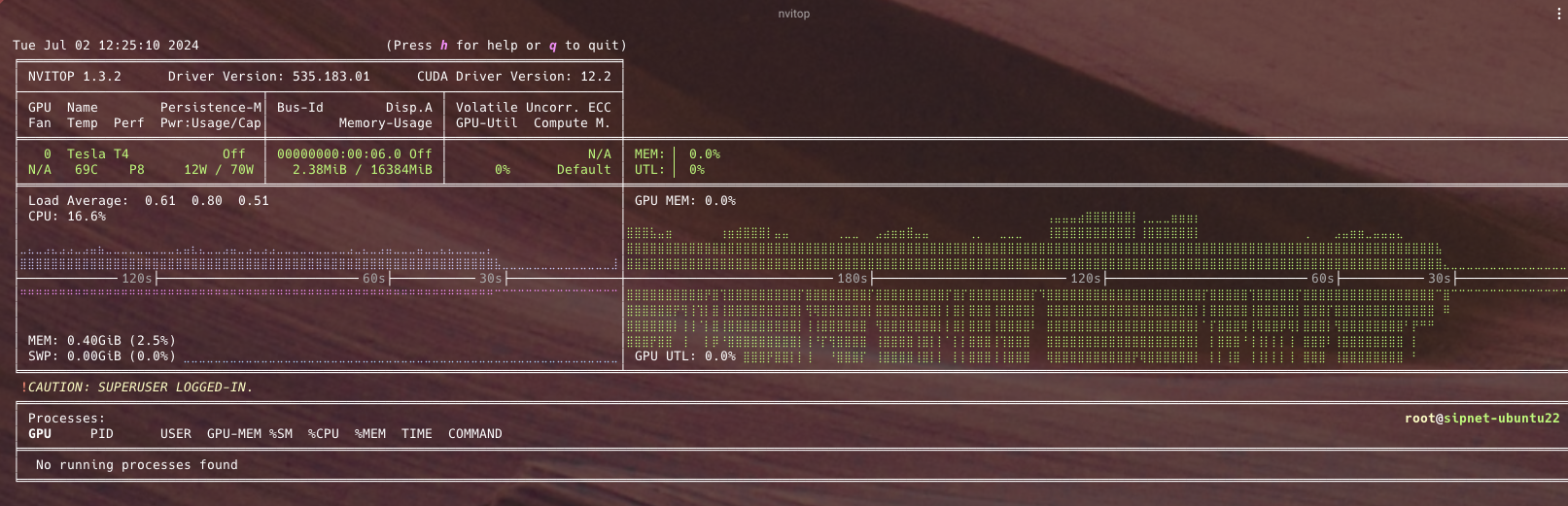

Tesla® T4

Время выполнения: 10 мин., 9.154 сек.

Вывод nvitop:

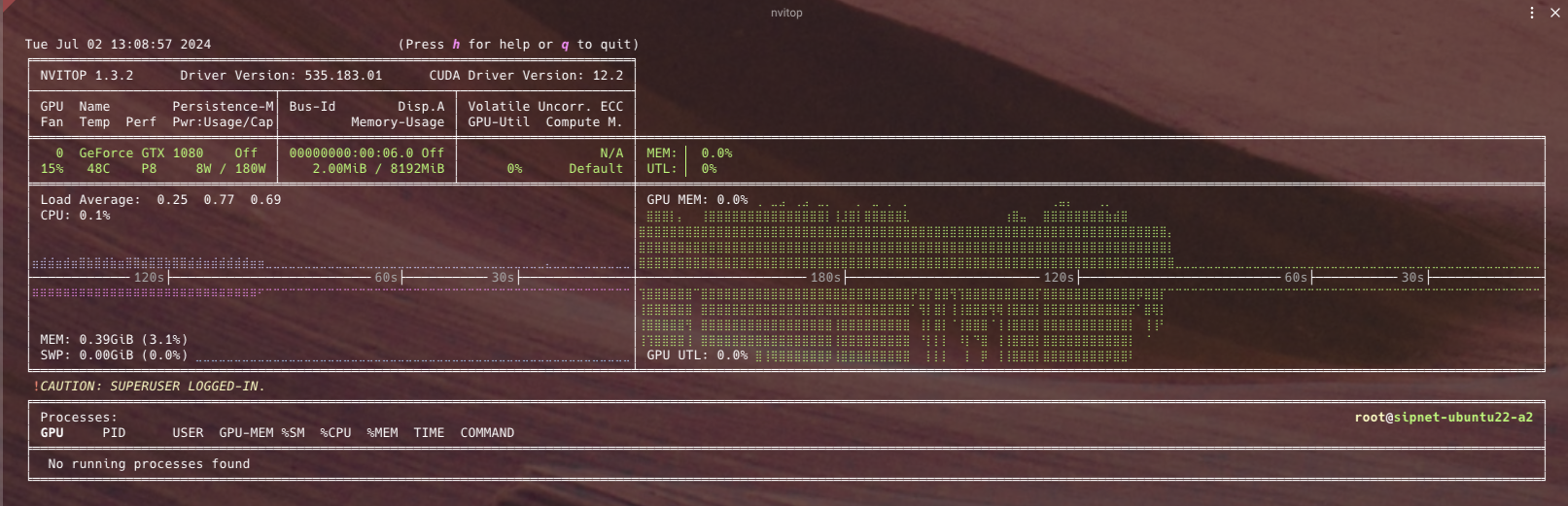

GTX™ 1080

Для запуска стандартного теста памяти было недостаточно, поэтому пришлось уменьшить параметр batch до 4. Это ограничение влияло на максимальную длительность обработанного файла.

Время выполнения: 13 мин., 30.536 сек.

Вывод nvitop:

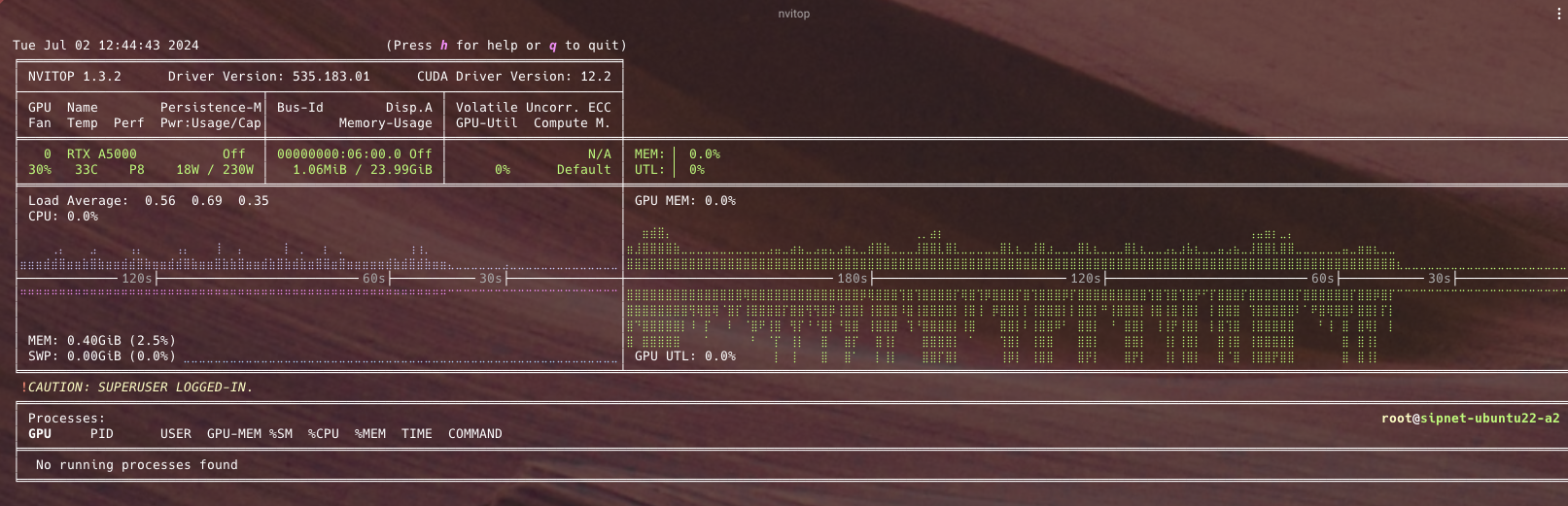

A5000

Время выполнения: 5 мин., 24.209 сек.

Вывод nvitop:

RTX™ 2080 Ti — лучшие результаты

Время выполнения: 4 мин., 30.674 сек.

Вывод nvitop:

Эффективность работы GPU с различными настройками

Batch size

- Увеличение параметра batch на более мощных GPU не дает значительного ускорения. Вероятная причина — упор в вычислительную мощность карты (compute capacity). Для точного определения потребуется анализ с помощью профайлеров.

- Уменьшение batch позволяет обрабатывать более длинные аудиофайлы на менее мощных видеокартах. Например, параметр 4 — позволяет обрабатывать аудио на GTX™ 1080, а параметр 16 — на RTX™ 2080 Ti.

Тип вычислений (compute type)

- Использование различных типов данных (int8, float16, float32) влияет на время транскрибации и точность.

- Основные работы осуществляли в формате float32 для достижения баланса.

- На GTX™ 1080 использовали int8 из-за ограничений производительности.

Использование Triton Inference Platform с TensorRT

- Асинхронная обработка запросов, увеличение общей производительности.

- Ускорение последовательной обработки на картах уровня дата-центра (A5000, RTX™ 4090) примерно втрое.

- Обработка нескольких потоков одновременно, но это требует значительных объемов видеопамяти (на RTX™ 2080 Ti доступно не более двух потоков).

Организация тестирования

Для быстрого тестирования производительности рекомендуем следующий подход:

- Создать Docker-образ с необходимым окружением.

- Настроить тесты для скачивания моделей и данных в общую папку.

- Выполнить снепшот диска с установленным окружением.

- Запускать тесты на разных конфигурациях GPU, используя снепшот.

Однако у сценария будут ограничения, если GPU распределены по разным зонам, что потребует ручной настройки виртуалок.

RTX™ 2080 Ti дешевле GTX™ 1080?

Приведем таблицу сравнительных характеристик.

| GPU | Время выполнения теста | Время выполнения транскрибации (мин) | Стоимость флейвора ₽/мин. | Стоимость GPU ₽/час | Стоимость транскрибации | Количество минут аудио, которое распознается за минуту работы модели | Количество минут, за которое можно транскрибировать миллион минут аудио | Стоимость аренды ВМ для распознавания миллиона минут |

| Tesla® T4 | 10m9.154s | 8,5 | 1,01 | 38,4 | 513 ₽ | 10,8 | 92 838 | 93 581 ₽ |

| RTX™ 2080 Ti | 5m16.781s | 3,6 | 0,71 | 17,2 | 155 ₽ | 25,3 | 39 507 | 28 234 ₽ |

| GTX™ 1080 | 13m30.536s | 11,8 | 0,63 | 14,48 | 444 ₽ | 7,7 | 129 572 | 81 069 ₽ |

| A5000 | 5m24.209s | 3,7 | 1,57 | 68,5 | 352 ₽ | 24,5 | 40 862 | 64 139 ₽ |

| A100 (40 ГБ) | 4m31.083s | 2,8 | 5,08 | 262,77 | 868 ₽ | 32,1 | 31 171 | 158 244 ₽ |

RTX™ 2080 Ti — наиболее выгодный выбор. Видеокарта позволяет эффективно обрабатывать аудиофайлы средней длительности с batch size до 16. При этом стоимость обработки в пересчете на миллион минут аудио значительно ниже, чем у GTX™ 1080, и карта обеспечивает лучшую производительность.

GTX™ 1080 ограничена в обработке длительных файлов (памяти недостаточно для больших батчей). Критичный недостаток — высокие затраты на миллион минут аудио из-за низкой скорости. Если сэкономить и взять эту карту, то мы переплатим более чем вдвое.

Tesla® T4, A100 (40 ГБ), A5000 отличаются высокой скоростью, но их стоимость делает их менее выгодными для массовой обработки аудио, за исключением специализированных задач.

Заключение

Для массовой обработки аудио советуем выбирать RTX™ 2080 Ti: она обеспечивает оптимальное сочетание производительности и стоимости. Более мощные карты, такие как A5000 или A100 (40 ГБ), целесообразно использовать в задачах, требующих обработки больших объемов данных в кратчайшие сроки. Мы в Selectel предоставляем широкий выбор [1] видеокарт в наличии [1] для 3D-моделирования, рендеринга, машинного обучения, сложной аналитики и других задач.

Что вы думаете насчет 2080 Ti? Поделитесь опытом [28] и мнением в комментариях!

Автор: DimDimDimDimDim

Источник [29]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11385

URLs in this post:

[1] видеокарты: https://selectel.ru/services/gpu/?utm_source=habr.com&utm_medium=referral&utm_campaign=dedicated_article_2080-ml_210125_content

[2] Почему выбор пал на RTX™ 2080 Ti: #1

[3] Может, сэкономить и купить GTX™ 1080? : #2

[4] RTX™ 2080 Ti для ML-моделей: пример с Whisper: #3

[5] Тестирование на реальных задачах: #4

[6] Эффективность работы GPU с различными настройками: #5

[7] RTX™ 2080 Ti дешевле GTX™ 1080? : #6

[8] Заключение: #7

[9] памяти: http://www.braintools.ru/article/4140

[10] Источник: https://3dnews.ru/975636/obzor-videokarti-geforce-rtx-2080-ti-chast-2-rezultati-testirovaniya/page-1.html

[11] в отдельном обзоре: https://selectel.ru/blog/gtx1080-relevance/?utm_source=habr.com&utm_medium=referral&utm_campaign=academy_article_2080-ml_210125_academy

[12] интеллекта: http://www.braintools.ru/article/7605

[13] облачных серверов: https://selectel.ru/services/cloud/servers/?utm_source=habr.com&utm_medium=referral&utm_campaign=cloud_article_2080-ml_210125_content

[14] В панели управления: https://my.selectel.ru/?utm_source=habr.com&utm_medium=referral&utm_campaign=cloud_article_2080-ml_210125_content

[15] в конфигураторе: https://selectel.ru/services/cloud/servers/gpu/?utm_source=habr.com&utm_medium=referral&utm_campaign=cloud_article_2080-ml_210125_content

[16] GeekBench: https://cdn.geekbench.com/Geekbench-6.2.2-Linux.tar.gz

[17] AI-Benchmark: https://ai-benchmark.com/

[18] в документации Primate Labs: http://support.primatelabs.com/kb/geekbench/geekbench-6-command-line-tool

[19] описании в PyPi: https://pypi.org/project/ai-benchmark/

[20] RTX™ 2080 Ti: https://browser.geekbench.com/v5/compute/3037174

[21] GTX™ 1080: https://browser.geekbench.com/v6/compute/1391857

[22] A2000: https://browser.geekbench.com/v6/compute/1391858

[23] в документации GeekBench: https://www.geekbench.com/doc/geekbench6-gpu-compute-workloads.pdf

[24] nvitop: https://github.com/XuehaiPan/nvitop

[25] инструмент CUDA Visible Devices Selection Tool: https://github.com/XuehaiPan/nvitop%23cuda-visible-devices-selection-tool

[26] обучения: http://www.braintools.ru/article/5125

[27] профессиональные видеокарты: https://selectel.ru/services/gpu/?section=cloud/?utm_source=habr.com&utm_medium=referral&utm_campaign=dedicated_article_2080-ml_210125_content

[28] опытом: http://www.braintools.ru/article/6952

[29] Источник: https://habr.com/ru/companies/selectel/articles/875078/?utm_campaign=875078&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.