Новая методика оптимизации LLM сокращает затраты памяти до 75%

Исследователи токийского стартапа Sakana AI разработали новую технологию, которая позволяет языковым моделям более эффективно использовать память [1]. Это позволит предприятиям сократить расходы на создание приложений на основе больших языковых моделей (LLM) и других моделей на основе Transformer.

Метод называется « универсальной памятью трансформеров [2]». Он использует специальные нейронные сети для оптимизации LLM с целью сохранения важных фрагментов информации и исключения избыточных деталей из контекста.

Оптимизация памяти трансформера

Ответы моделей Transformer, основы LLM, зависят от содержимого их «контекстного окна [3] », то есть того, что они получают в качестве входных данных от пользователей.

Окно контекста можно считать рабочей памятью модели. Тонкая настройка содержимого контекстного окна может оказать огромное влияние на производительность модели. Это привело к появлению целой области «инженерия подсказок [4]».

Текущие модели поддерживают очень длинные контекстные окна [5] с сотнями тысяч или даже миллионами токенов (числовых представлений слов, частей слов, фраз, понятий и чисел, вводимых пользователями в своих подсказках).

Это позволяет пользователям втиснуть больше информации в свои подсказки. Однако более длинные подсказки могут привести к более высоким вычислительным затратам и к снижению производительности. Оптимизация подсказок для удаления ненужных токенов при сохранении важной информации может снизить затраты и увеличить скорость.

Современные методы оптимизации подсказок требуют больших ресурсов или вынуждают пользователей вручную тестировать различные конфигурации, чтобы уменьшить размер подсказок.

Модели памяти с нейронным вниманием

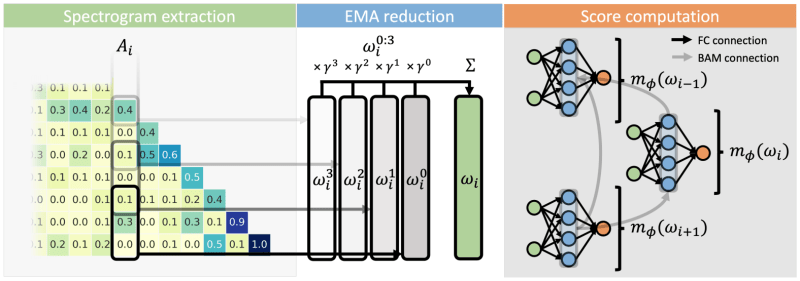

Универсальная память трансформеров оптимизирует подсказки с помощью модели памяти с нейронным внимание [6] (NAMM), простых нейронных сетей, которые решают, «запоминать» или «забывать» каждый заданный токен, хранящийся в памяти LLM.

Эта новая возможность позволяет трансформерам отбрасывать бесполезные или избыточные детали и сосредотачиваться на самой важной информации.

NAMM обучаются отдельно от LLM и объединяются с предварительно обученной моделью во время вывода, что делает их гибкими и простыми в развертывании. Однако им нужен доступ к внутренним функциям активации модели, что означает, что их можно применять только к моделям с открытым исходным кодом.

Как и другие методы, разработанные Sakana AI, NAMM обучаются с помощью эволюционных алгоритмов [7] вместо методов оптимизации на основе градиента. Путем итеративной мутации и выбора наиболее эффективных моделей методом проб и ошибок эволюционные алгоритмы оптимизируют NAMM в сторону эффективности и производительности. Это особенно важно, поскольку NAMM пытаются достичь недифференцируемой цели: сохранения или отбрасывания токенов.

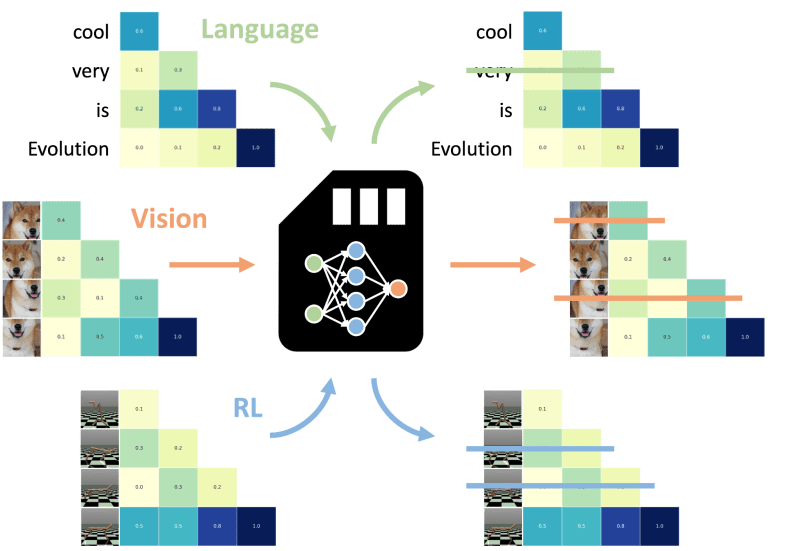

NAMM работают на уровнях внимания LLM, одном из ключевых компонентов архитектуры Transformer, который определяет отношения и важность каждого токена в окне контекста модели. Основываясь на значениях внимания, NAMM определяют, какие токены следует сохранить, а какие можно отбросить из окна контекста LLM. Этот механизм позволяет использовать обученный NAMM на различных моделях без дальнейшей модификации. Например, NAMM, обученный только на текстовых данных, может применяться к моделям зрения [8] или многомодальным моделям без дополнительного обучения [9].

Универсальная память в действии

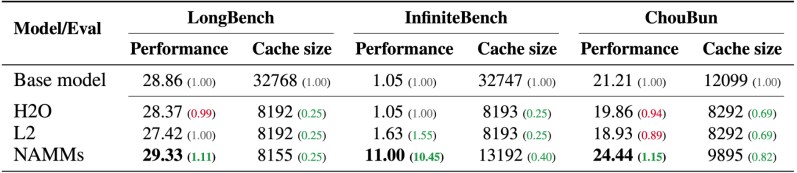

Чтобы протестировать концепцию универсальной памяти трансформатора в действии, исследователи обучили NAMM поверх модели Meta Llama 3-8B [10] с открытым исходным кодом . Их эксперименты показывают, что с NAMM модели на основе Transformer лучше работают с проблемами естественного языка и кодирования на очень длинных последовательностях. Между тем, отбрасывая ненужные токены, NAMM позволил модели LLM сэкономить до 75% своей кэш-памяти при выполнении задач.

Они также протестировали модель на версии Llama 70B и на моделях Transformer, разработанных для других модальностей и задач, таких как Llava [11] (компьютерное зрение) и Decision Transformer (обучение с подкреплением [12]).

Даже в этих условиях отсутствия распространения NAMM сохраняют свои преимущества, отбрасывая такие маркеры, как избыточные видеокадры и неоптимальные действия, позволяя своим новым базовым моделям сосредоточиться на наиболее релевантной информации для повышения производительности.

Поведение, зависящее от задачи

Еще одним интересным открытием стало то, что NAMM автоматически корректируют свое поведение [13] в зависимости от задачи.

Например, для задач кодирования модель отбрасывает смежные фрагменты токенов, соответствующие комментариям и пробелам, которые не влияют на выполнение кода.

С другой стороны, в задачах на естественном языке модель отбрасывает токены, которые представляют собой грамматическую избыточность и не влияют на смысл последовательности.

Исследователи выпустили код для создания собственных NAMM [14] . Такие методы могут быть очень полезны для корпоративных приложений, обрабатывающих миллионы токенов, где повышение скорости и снижение затрат ведут к прибыли. Возможность повторного использования обученного NAMM также делает его универсальным инструментом для использования в различных приложениях на предприятии.

В будущем исследователи предлагают использовать более продвинутые методы, такие как использование NAMM во время обучения LLM, чтобы еще больше расширить возможности их памяти.

Автор: Cloud4Y

Источник [15]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/10681

URLs in this post:

[1] память: http://www.braintools.ru/article/4140

[2] универсальной памятью трансформеров: https://sakana.ai/namm/

[3] контекстного окна: https://venturebeat.com/ai/googles-new-technique-gives-llms-infinite-context/

[4] инженерия подсказок: https://venturebeat.com/ai/why-prompt-engineering-is-one-of-the-most-valuable-skills-today/

[5] очень длинные контекстные окна: https://venturebeat.com/ai/google-unveils-gemini-1-5-a-next-gen-ai-model-with-million-token-context-window/

[6] внимание: http://www.braintools.ru/article/7595

[7] эволюционных алгоритмов: https://en.wikipedia.org/wiki/Evolutionary_algorithm

[8] зрения: http://www.braintools.ru/article/6238

[9] обучения: http://www.braintools.ru/article/5125

[10] модели Meta Llama 3-8B: https://venturebeat.com/ai/llama-3-launches-alongside-new-stand-alone-meta-ai-chatbot/

[11] Llava: https://venturebeat.com/ai/the-open-source-alternatives-to-gpt-4-vision-are-coming/

[12] подкреплением: http://www.braintools.ru/article/5528

[13] поведение: http://www.braintools.ru/article/9372

[14] код для создания собственных NAMM: https://github.com/SakanaAI/evo-memory

[15] Источник: https://habr.com/ru/companies/cloud4y/news/868462/?utm_source=habrahabr&utm_medium=rss&utm_campaign=868462

Нажмите здесь для печати.