Чтобы эффективно осваивать вложенные в покупку или аренду GPU ресурсы, важно использовать весь потенциал видеокарт. Первые сложности возникают при настройке оборудования в контексте его потенциальных возможностей. С одной стороны — недостаточная утилизация ресурсов, с другой — бесконечное горизонтальное масштабирование и кратное удорожание ИТ-инфраструктуры.

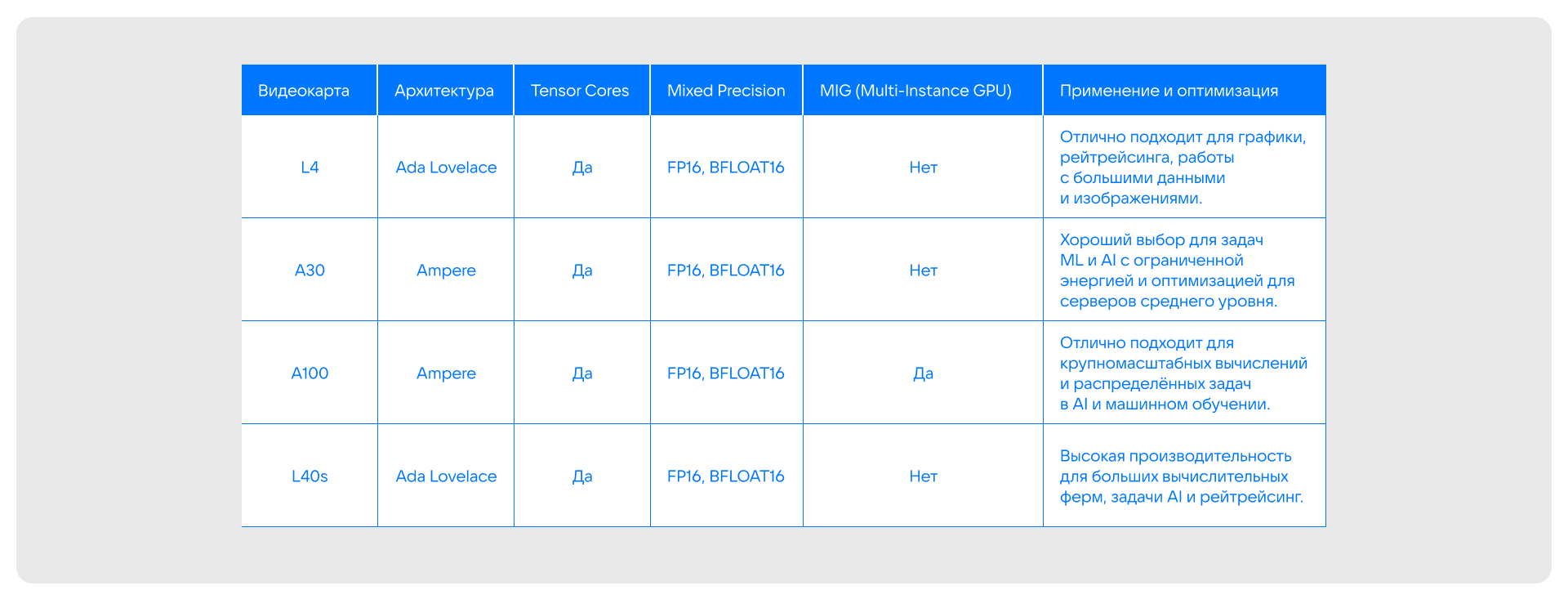

В этой статье мы разберем базовые принципы и настройки оптимизации проверенных моделей GPU, чтобы эффективнее справляться с задачами машинного обучения. Посмотрим, как настраивать драйверы и библиотеки, управлять памятью, активировать Tensor Cores для ускорения вычислений, использовать технологию MIG для распределения задач и проводить разгон GPU для получения максимальной производительности. Следуя этим рекомендациям, вы сможете ускорить вычислительные процессы и сократить затраты на оборудование, увеличив эффективность работы с большими данными. Разбираться будем на примерах популярных моделей NVIDIA: A30, A100, L40s и L4.

Одна из самых распространенных сложностей — это управление ресурсами GPU. Например, не всегда очевидно, как эффективно использовать технологию Multi-Instance GPU (MIG), которая позволяет разделить вычислительную мощность GPU на несколько виртуальных экземпляров для параллельного выполнения задач. Также могут возникать вопросы с разгоном видеокарт и настройкой энергопотребления, что напрямую влияет на производительность и стабильность работы. Кроме того, выбор размера батчей и управление памятью часто требует тонкой настройки, чтобы избежать переполнения и замедления обучения.

Технические особенности видеокарт A30, A100, L40s, L4

NVIDIA A30

NVIDIA A30 — это графическая карта, предназначенная для решения задач в области искусственного интеллекта и научных вычислений. Основанная на архитектуре Ampere, она предлагает отличное соотношение производительности и стоимости. A30 поддерживает FP16, BFLOAT16 и Tensor Core для ускорения вычислений в ML.

Основные параметры:

-

CUDA Cores: 3584

-

Tensor Cores: 112

-

Память: 24 ГБ GDDR6

-

Пропускная способность памяти: 933 ГБ/с

Это решение подходит для задач, требующих высокой вычислительной мощности при умеренных затратах на аппаратное обеспечение.

NVIDIA A100

NVIDIA A100 — один из самых мощных GPU в своем классе, предназначенных для вычислений в области AI и научных расчетов. С архитектурой Ampere и поддержкой технологии Multi-Instance GPU (MIG) A100 обеспечивает гибкость при распределении вычислительных ресурсов между различными задачами.

Основные параметры:

-

CUDA Cores: 6912

-

Tensor Cores: 432

-

Память: 80 ГБ HBM2

-

Пропускная способность памяти: 1555 ГБ/с

A100 подходит для использования в крупных центрах обработки данных, где важна высокая производительность и работа в режиме многозадачности.

NVIDIA L40s

NVIDIA L40s — более новая видеокарта, оптимизированная для задач глубокого обучения и высокопроизводительных вычислений. Основанная на архитектуре Hopper, она превосходит предыдущие модели по энергоэффективности и скорости обработки данных.

Основные параметры:

-

CUDA Cores: 8704

-

Tensor Cores: 512

-

Память: 48 ГБ GDDR6

-

Пропускная способность памяти: 1000 ГБ/с

Эта видеокарта предоставляет отличные возможности для распределенных вычислений и значительно улучшает производительность в задачах, связанных с обработкой больших объемов данных.

NVIDIA L4

NVIDIA L4 — это графическая карта, предназначенная для обработки задач в области искусственного интеллекта, машинного обучения и рендеринга. Основанная на архитектуре Ada Lovelace, L4 сочетает в себе высокую производительность и энергоэффективность, подходит для использования в рабочих станциях и серверных фермах. L4 поддерживает ускорение вычислений с помощью Tensor Cores и технологии Mixed Precision, что позволяет значительно повысить скорость обучения и вывода моделей.

Основные параметры:

-

CUDA Cores: 7680

-

Tensor Cores: 240

-

Память: 24 ГБ GDDR6

-

Пропускная способность памяти: 600 ГБ/с

Она является отличным решением для задач, требующих высокой вычислительной мощности и эффективности в работе с большими данными и AI, предлагая отличное соотношение производительности и стоимости. L4 в среднем дешевле в 2 раза относительной той же А100.

Сводная таблица

Примеры использования GPU в сфере машинного обучения

Глубокое обучение

На GPU A100 можно эффективно обучать большие модели, такие как GPT или ResNet, за счет высокой вычислительной мощности и большого объема памяти.

Также L4 предлагает отличную производительность в обучении нейросетей, особенно при работе с менее масштабными моделями или более гибкими задачами, где важна комбинация графических и вычислительных нагрузок. Благодаря поддержке Tensor Cores и Mixed Precision (FP16) L4 позволяет ускорить обучение при меньших затратах по сравнению с более мощными решениями, такими как A100.

Обработка изображений

При использовании L40s для обработки изображений или видео в реальном времени вы получаете невероятно высокую производительность, что важно для задач компьютерного зрения в реальных условиях. L4 также отлично подходит для таких задач, предлагая поддержку рейтрейсинга и ускорения AI-вычислений для обработки изображений и видео.

Прогнозирование

В больших центрах данных с использованием A30 и A100 можно запускать задачи по обработке больших объемов данных (например, в сфере здравоохранения или финансов), сокращая время обработки и повышая точность предсказаний. L4 также подходит для обработки больших данных, особенно в приложениях, где требуется быстрая передача данных между GPU и памятью.

Настройка и оптимизация GPU

Теперь разберем, как оптимизировать настройку видеокарт для различных задач в ML и AI. Мы затронем такие аспекты, как драйверы, настройки CUDA, управление памятью, использование Tensor Cores и технологии Multi-Instance GPU (MIG), а также примеры команд и конфигураций.

Драйверы и библиотеки: основы оптимизации

Для начала убедитесь, что установлены последние версии драйверов NVIDIA, а также CUDA и cuDNN, так как они являются основой для работы с GPU в машинном обучении. Эти библиотеки оптимизированы для работы с различными фреймворками, такими как TensorFlow, PyTorch и другими.

Для установки драйверов NVIDIA и CUDA на вашу систему используйте следующие команды (для Linux):

1. Установите драйверы NVIDIA:

bash

sudo apt-get update

sudo apt-get install nvidia-driver-4602. Установите CUDA:

bash

sudo apt-get install nvidia-cuda-toolkit-

Установите cuDNN — скачайте cuDNN с официального сайта NVIDIA и установите его (пример названия пакета):

bash

sudo dpkg -i libcudnn8_8.1.1.33-1+cuda11.2_amd64.debПосле установки убедитесь, что драйверы и CUDA настроены правильно, запустив команду:

bash

nvidia-smiЭта команда выведет информацию о вашем GPU, включая версию драйвера и использование видеопамяти.

Использование nvidia-smi для мониторинга и настройки

Nvidia-smi — это мощный инструмент для мониторинга GPU и управления его параметрами. Он позволяет контролировать использование GPU, температуру, а также настраивать энергопотребление и производительность.

Основные команды nvidia-smi:

1. Мониторинг состояния GPU:

bash

nvidia-smiЭта команда выводит полную информацию о видеокарте, включая температуру, использование памяти и загрузку GPU.

2. Настройка энергопотребления. Чтобы ограничить потребление энергии и предотвратить перегрев, используйте команду:

bash

nvidia-smi -pl 300 # Ограничение потребляемой мощности до 300 Вт3. Режим энергосбережения. Для включения энергосбережения можно использовать следующий режим:

bash

nvidia-smi -pm 1 # Включить режим энергосбережения4. Мониторинг использования памяти. Чтобы следить за использованием видеопамяти в реальном времени, можно использовать:

bash

nvidia-smi --query-gpu=memory.used,memory.free --format=csvОптимизация работы с памятью GPU

Одна из ключевых задач при настройке GPU — это эффективное использование видеопамяти. В зависимости от модели видеокарты (A30, A100 или L40s), объем видеопамяти может варьироваться, и важно правильно настроить размер батчей и параметры для работы с данными.

Подбор оптимального размер батча влияет на скорость обучения. Слишком маленькие батчи могут замедлить процесс, поэтому для PyTorch вы можете настроить размер батча следующим образом:

python

from torch.utils.data import DataLoader

batch_size = 32 # Выберите размер батча, который ваш GPU может обрабатывать

train_loader = DataLoader(train_data, batch_size=batch_size, shuffle=True)Для предотвращения переполнения памяти можно использовать функцию torch.cuda.empty_cache() для очистки неиспользуемой памяти:

python

import torch

torch.cuda.empty_cache()Это поможет освободить память, если после итераций осталась неиспользуемая память.

Использование Tensor Cores для ускорения вычислений

Tensor Cores — это специализированные вычислительные блоки GPU, которые ускоряют операции с матрицами, позволяя проводить сразу набор действий одновременно (за один такт), а не по очереди. Они активируются при использовании формата FP16 или BFLOAT16.

Чтобы активировать Tensor Cores в PyTorch, необходимо использовать тип данных float16 для ускоренных вычислений:

python

# Использование автоматического смешанного точности (AMP) для активации Tensor Cores

from torch.cuda.amp import autocast

model = model.cuda()

# Использование автокастинга для операций с FP16

with autocast():

output = model(input_data)

loss = loss_fn(output, target)Пример настройки обучения с Tensor Cores:

python

from torch.cuda.amp import GradScaler, autocast

scaler = GradScaler()

for data, target in train_loader:

data, target = data.cuda(), target.cuda()

optimizer.zero_grad()

with autocast()

output = model(data)

loss = loss_fn(output, target)

# Масштабирование градиентов

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()Этот код автоматически включает использование Tensor Cores, что значительно ускоряет обучение моделей.

Использование Multi-Instance GPU (MIG)

MIG (Multi-Instance GPU) позволяет разделить GPU на несколько виртуальных экземпляров, что особенно полезно для выполнения нескольких задач одновременно — например, обучения нескольких моделей. Это возможно только на некоторых GPU, таких как A100.

Чтобы активировать MIG на GPU A100, используйте команду:

bash

nvidia-smi mig -cgi 19,0,0 -C # Разделить GPU на несколько виртуальных экземпляровЗатем можно использовать каждый виртуальный экземпляр GPU для разных задач, что позволяет эффективно распределять вычислительные ресурсы.

Разгон GPU: возможности, преимущества и риски

Разгон GPU (увеличение тактовой частоты и вольтажа) может дать заметный прирост производительности, но также связан с определенными рисками, общими для всех видеокарт:

-

выход из строя в результате перегрева;

-

появление артефактов и сбоев в системе;

-

повышенная нагрузка на питание;

-

снижение срока службы.

Для тех, кто готов к этим рискам, рассмотрим возможности разгона видеокарт NVIDIA A30, A100 и L40s.

NVIDIA A30

Возможности разгона:

-

A30 не предназначена для экстремального разгона, но на ней можно немного увеличить тактовую частоту ядра и память.

-

В большинстве случаев разгон будет ограничен энергопотреблением и охлаждением.

Преимущества разгона:

-

Увеличение тактовой частоты на 5–10% может повысить общую производительность в некоторых задачах.

-

Разгон видеопамяти может улучшить пропускную способность памяти, что полезно при работе с большими данными.

Пример команд разгона для A30

Для разгона A30 с использованием инструментов nvidia-smi и nvidia-settings:

1. Увеличение частоты ядра:

bash

sudo nvidia-smi -ac 2005,875Здесь 2005 — это новая частота GPU, а 875 — частота видеопамяти в МГц.

2. Мониторинг и управление энергопотреблением:

bash

nvidia-smi -pl 250Ограничьте мощность до 250 Вт, чтобы избежать перегрева.

NVIDIA A100

Возможности разгона:

-

A100 позволяет разгонять как ядро, так и видеопамять.

-

Видеокарта имеет большой запас мощности и охлаждения, что дает более широкие возможности для безопасного разгона.

Преимущества разгона:

-

Существенное повышение производительности для сложных задач ML и AI.

-

Увеличение частоты памяти может повысить пропускную способность для обработки больших наборов данных и ускорить обучение моделей.

Пример команд разгона для A100

1. Увеличение частоты ядра и памяти:

bash

sudo nvidia-smi -ac 2100,11002100 — это частота ядра в МГц, а 1100 — частота памяти.

2. Управление энергопотреблением для стабильной работы:

bash

sudo nvidia-smi -pl 400Устанавливаем лимит мощности на 400 Вт для стабильности.

3. Мониторинг производительности:

bash

nvidia-smi dmon -s u # Мониторинг использования GPUNVIDIA L40s

Возможности разгона:

-

L40s поддерживает разгон, но, как и в случае с A100, разгон будет ограничен энергопотреблением и системой охлаждения.

-

Эта видеокарта обладает значительным запасом мощности и может выдерживать более агрессивные настройки разгона.

Преимущества разгона:

-

Разгон может дать значительный прирост производительности в специфичных задачах, таких как глубокое обучение с использованием моделей с большим количеством параметров.

-

Для задач, требующих высокой пропускной способности памяти, увеличение тактовой частоты видеопамяти будет полезным.

Пример команд разгона для L40s

1. Разгон ядра и памяти:

bash

sudo nvidia-smi -ac 2500,1400Устанавливаем тактовую частоту ядра на 2500 МГц и видеопамяти на 1400 МГц.

2. Управление температурой и энергопотреблением:

bash

sudo nvidia-smi -pl 600Ограничиваем мощность на 600 Вт для предотвращения перегрева.

3. Мониторинг и тестирование после разгона:

bash

nvidia-smi -q -d PERFORMANCEВыводит подробную информацию о производительности и температуре видеокарты в реальном времени.

NVIDIA L4

Возможности разгона:

-

Частота ядра — разгон L4 позволяет увеличить частоту графического процессора, что повышает производительность в задачах, требующих интенсивных вычислений, таких как обработка изображений и обучение моделей AI.

-

Частота памяти — увеличение частоты видеопамяти также может помочь в повышении пропускной способности памяти, что критично для задач с большими данными и сложными вычислениями.

-

Поддержка программных инструментов — для разгона NVIDIA L4 можно использовать такие утилиты, как NVIDIA Control Panel, MSI Afterburner, EVGA Precision X1, которые позволяют гибко настраивать частоты и напряжения.

Пример команд и настроек разгона L4

1. Изменение частоты ядра:

bash

nvidia-smi -i 0 -ac 2505,875Эта команда устанавливает частоту ядра в 2505 МГц и частоту памяти в 875 МГц.

2. Разгон через утилиту MSI Afterburner:

-

Установите MSI Afterburner, откройте программу и найдите ползунки для изменения частоты ядра и памяти.

-

Увеличьте частоту ядра и памяти на небольшие значения (например, на 10–15%), чтобы избежать перегрева.

3. Мониторинг температуры и потребляемой мощности: используйте nvidia-smi для мониторинга текущих температур и энергопотребления:

bash

nvidia-smi --query-gpu=temperature.gpu,power.draw --format=csvКак еще можно оптимизировать вычисления на GPU

Существует такое понятие, как такт кванта — это процесс оптимизации вычислений, где данные преобразуются в меньший формат (например, FP16 вместо FP32) для ускорения выполнения задач и уменьшения использования памяти.

В ML применяется метод Mixed Precision (FP16). Использование меньшей точности данных ускоряет обучение моделей, так как операции с FP16 занимают меньше времени и требуют меньше памяти. Это особенно полезно при обучении больших нейросетей, например, в TensorFlow или PyTorch.

python

model = model.half() # Перевод модели в FP16Эффективность Mixed Precision на разных картах:

-

A30 — поддерживает Mixed Precision, но с ограничениями по памяти. Подходит для малых и средних ML-задач.

-

A100 — оптимизирован для работы с большими моделями. Использование FP16 значительно ускоряет вычисления.

-

L40s — высокая производительность при обработке данных в реальном времени. Особенно эффективна для приложений с низкими задержками и графикой.

-

L4 — хорошо справляется с маломасштабными задачами. FP16 и разгон повышают производительность, но для крупных моделей уступает A100.

Выводы

Правильная настройка видеокарт для задач машинного обучения и искусственного интеллекта — это ключевой аспект для получения максимальной производительности. Использование таких инструментов, как nvidia-smi, настройка памяти, активация Tensor Cores и управление энергопотреблением, позволяют существенно улучшить вычислительные процессы.

Вы также можете попробовать GPU в VK Cloud. У нас есть NVIDIA® Tesla® L4, L40S, A30, A100, V100 и наши эксперты помогают быстро развертывать инфраструктуру в облаке и начать обучать ML-модели.

Stay tuned.

Присоединяйтесь к телеграм-каналам «Вокруг Kubernetes» и «Данные на стероидах», чтобы быть в курсе новостей из мира K8s, DevOps, AI, ML и работы с данными. Мы собираем регулярные дайджесты, публикуем ссылки на полезные статьи, а также делаем анонсы конференций и вебинаров.

Автор: GRADDATA