Университет Джонса Хопкинса совместно с компанией AMD создали Agent Laboratory – открытую платформу, которая объединяет креативность человека с рабочими процессами на базе AI.

В отличие от других AI-инструментов, которые самостоятельно генерируют исследовательские идеи, Agent Laboratory помогает учёным проводить исследования более продуктивно.

«Мы надеемся, что Agent Laboratory позволит исследователям сосредоточиться на творческих идеях, а не на рутинном программировании и написании текстов, что, в конечном итоге, ускорит научные открытия», — отмечают разработчики.

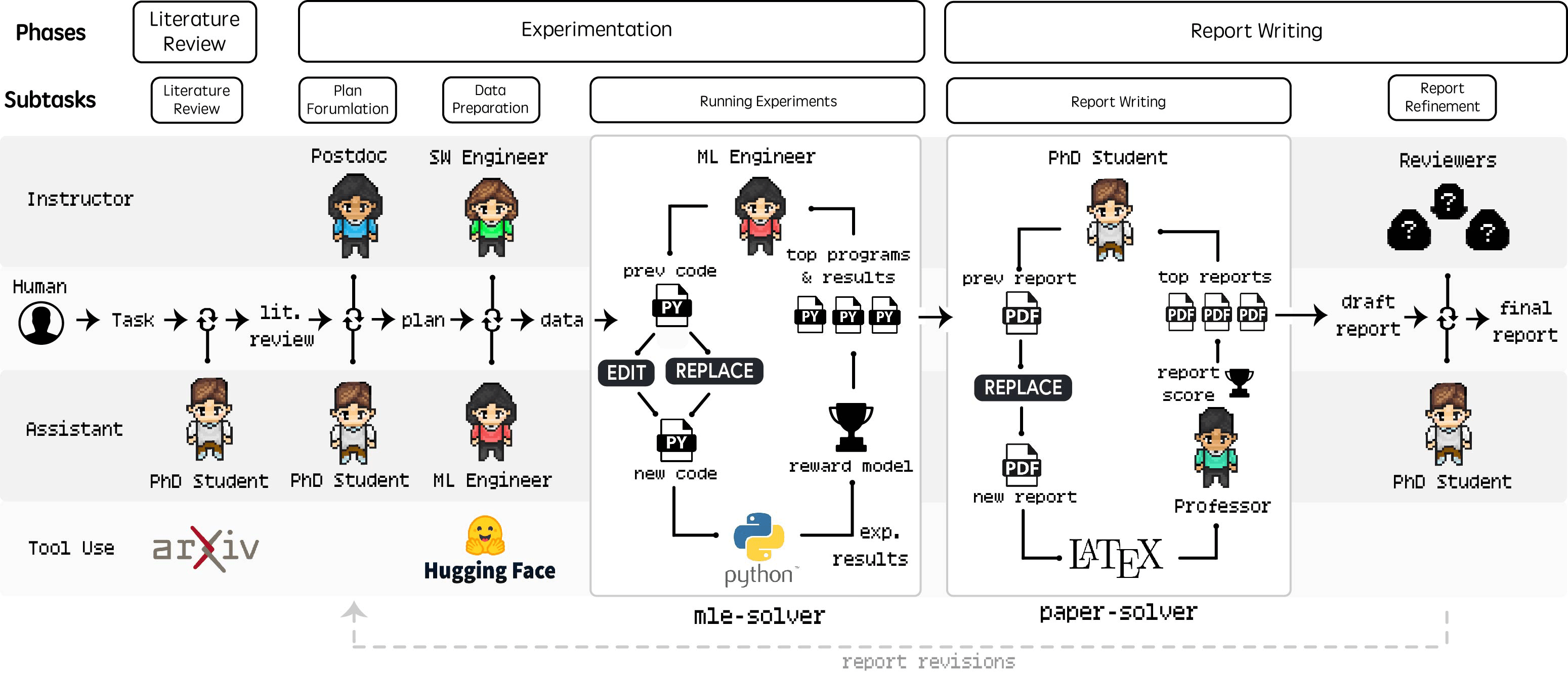

Деятельность виртуальной лаборатории организована в соответствии с общепринятыми академическими принципами. В основе её работы лежит анализ научных публикаций, которые собираются и структурируются с помощью API arXiv. Затем аспиранты и докторанты создают команду для детального планирования исследования, основываясь на изученной литературе. В ходе обсуждений определяют, что необходимо для проверки идей. Далее агент, специализирующийся на машинном обучении, выполняет технические задачи, используя инструмент mle-solver для разработки и настройки кода.

Процесс включает три этапа: изучение литературы, проведение экспериментов и написание отчётов, с использованием AI-агентов и распределением ролей.

После завершения экспериментов аспиранты и профессора составляют отчёт. С помощью Paper-solver они создают и редактируют научный отчёт, чтобы он стал доступным для понимания.

Исследователи опубликовали пример дипломной работы и описали все конкретные подсказки, использовавшиеся в процессе исследования, в приложении к своей статье

Рецензенты предпочитают o1-предварительный просмотр При оценке статей, созданных Agent Laboratory, рецензенты заметили, что разные модели AI дают различные результаты. Модель o1-preview от OpenAI показала лучшие результаты в плане ясности и достоверности, а o1-mini получила высокие оценки за качество эксперимента.

Человеческие и AI-рецензенты оценивали работы по-разному, причём AI оценивает на 2,3 балла выше, чем люди, особенно в аспектах ясности и представления.

Две таблицы показывают критерии оценки NeurIPS для сравнения автоматизированных и человеческих оценок качества научных работ.

Система также позволяет исследователям работать с AI в режиме соавтора. Такой подход часто даёт более высокие оценки, но иногда за счёт качества эксперимента.

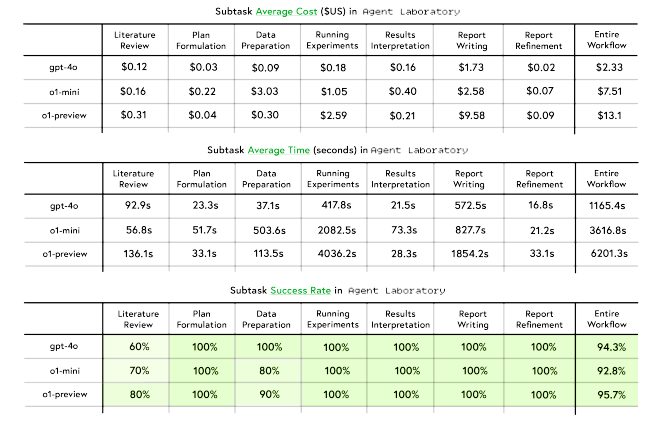

Исследователи выяснили, что Agent Laboratory может создавать статьи недорого – всего за 2,33 доллара за статью с использованием GPT-4o. Среди протестированных моделей GPT-4o обеспечила лучший баланс между производительностью и стоимостью, в то время как o1-preview обеспечивала аналогичный успех, но занимала больше времени и была дороже.

Три таблицы сравнивают затраты, время и процент успешных внедрений AI-моделей в Agent Laboratory на различных этапах.

Команда признаёт ряд ограничений: склонность AI переоценивать свои результаты, ограничения автоматизированных исследований и риск получения неверной информации.

Хотя прогресс в развитии мощных языковых моделей, кажется, замедлился, исследователи и компании переключают внимание на создание агентских фреймворков, объединяющих несколько языковых моделей и инструментов, отражающих структуру человеческих организаций, будь то проведение фокус-групп или перевод длинных документов.

Автор: mefdayy